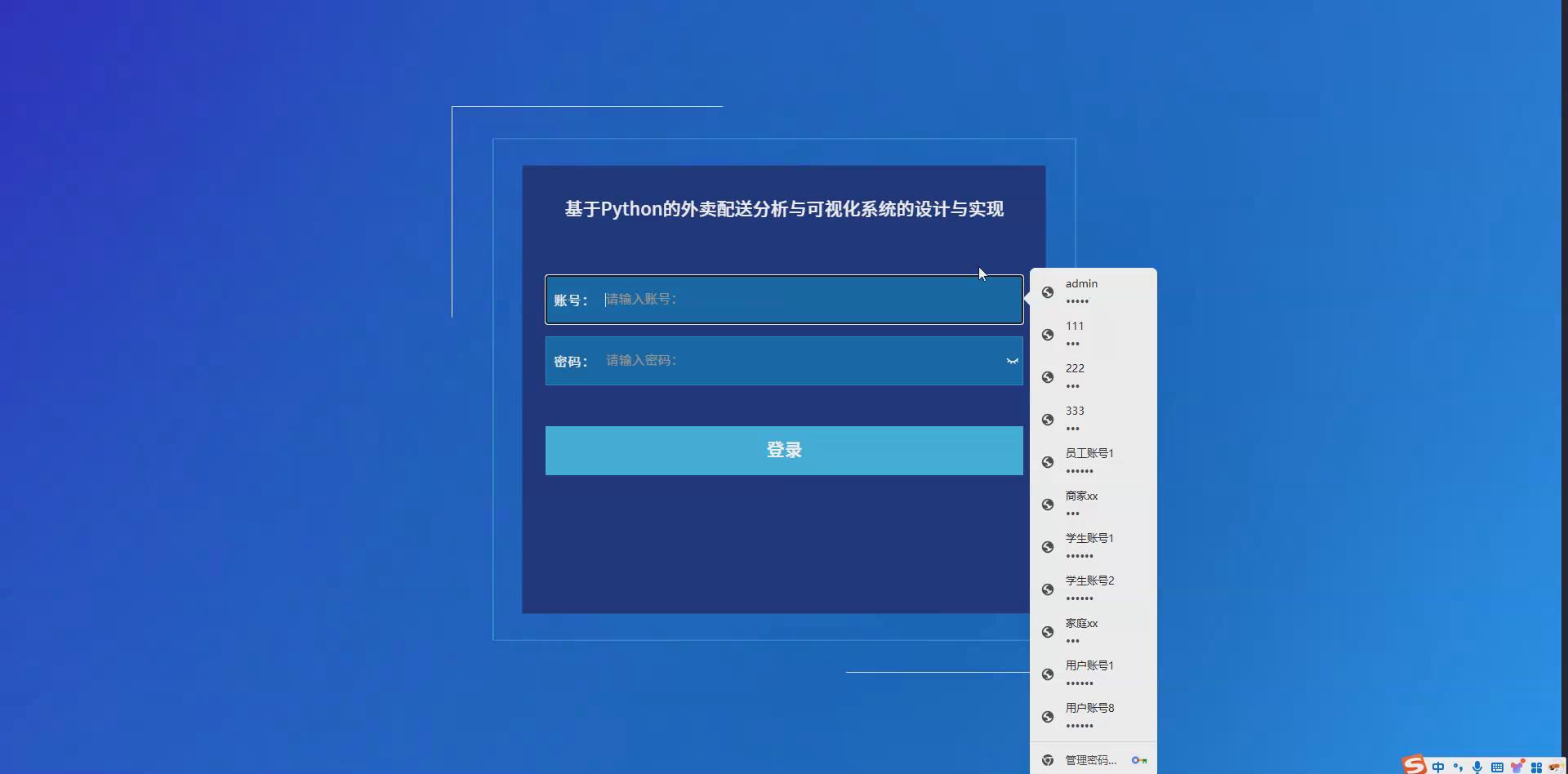

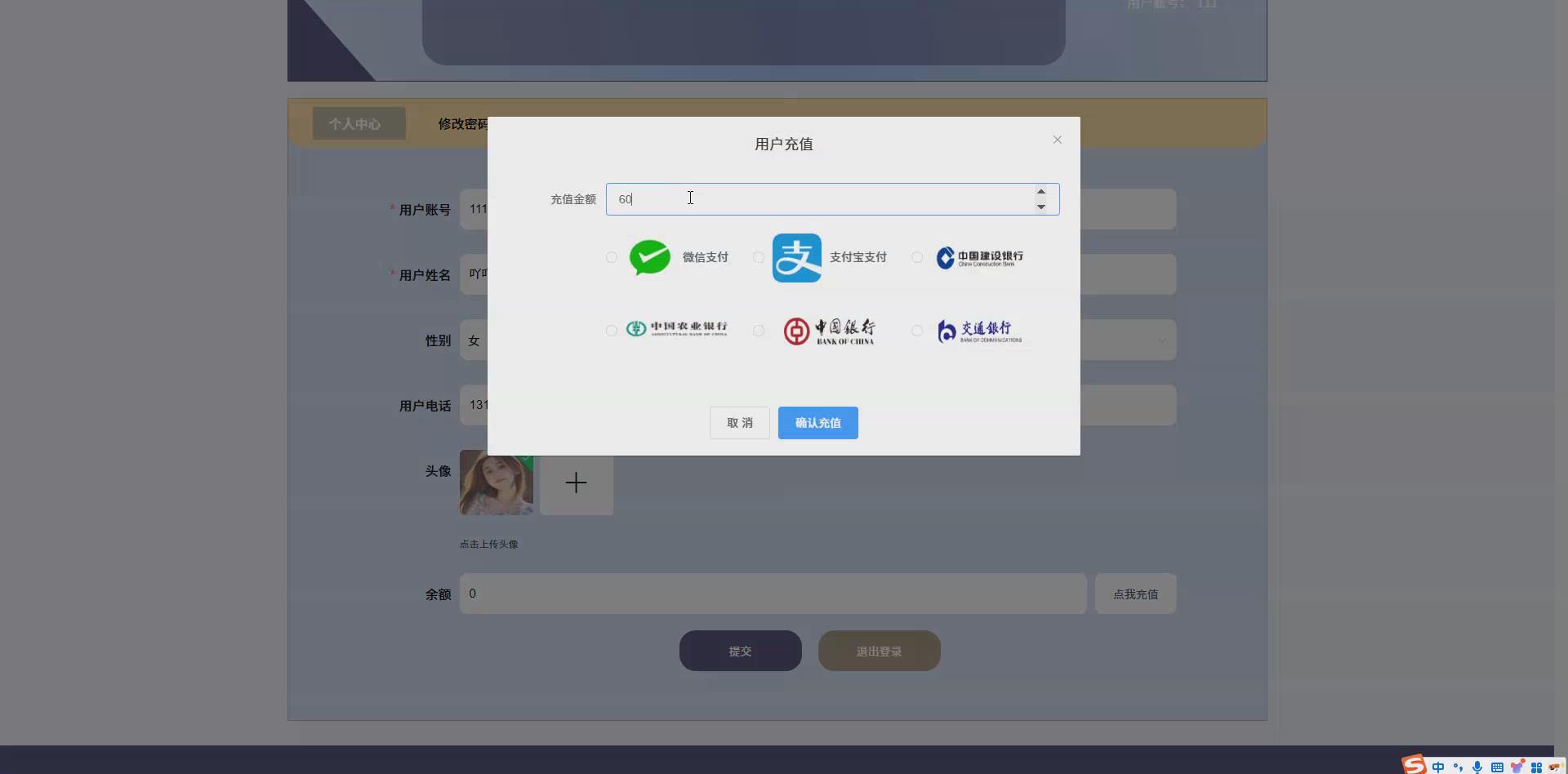

系统截图

基于Python的外卖配送分析与可视化系统的设计与实现_35k9z86f–论文

项目简介

本次研究将达到的毕业课程设计系统主要有以下主要流程:

数据收集:使用Python语言,现成的爬虫框架和工具包降低了使用门槛,具体使用时配合正则表达式的运用,使得数据抓取工作变得更加简单。因此采用Python语言来实现网络爬虫功能,通过下载器爬取数据,通过解析器将HTML文本或者JSON数据进行解析,然后把解析出来的数据保存在MySQL数据库中。

1、数据的爬取 2、数据清洗和预处理 3、数据分析 4、数据可视化

同时分为以下几个功能:

(1)数据爬取功能:通过python爬虫的技术,爬取从而获取数据,并将数据转换成可储存的数据类型,保存到本地。

(2)数据清洗和预处理模块:将保存到本地的数据集进行格式转化,将数据噪音清除,数据格式处理成目标数据。

(3)数据分析模块:通过python对处理好的数据进行分析,再将得到数据存储到mysql数据库中。

(4)数据可视化模块:数据可视化模块主要采用Echarts可视化软件对数据分析结果进行可视化图表和图像展示。

(1)数据采集与清洗

数据采集与清洗是毕业课程设计系统的首要环节。通过Spider爬虫技术使用requests、BeautifulSoup等库,从各大网站平台等渠道自动抓取海量的相关数据随后,利用Pandas等数据处理库对采集到的数据进行清洗,去除重复、无效或错误的数据,确保数据的质量和准确性,为后续分析提供可靠的基础。

(2)数据存储与管理

完成数据清洗后,进入数据存储与管理阶段。采用MySQL关系型数据库,利用Python的数据库连接库如PyMySQL、SQLAlchemy等,将清洗后的数据有序存储。通过设计合理的数据库表结构,实现数据的高效查询、更新和管理。同时,确保数据的安全性和稳定性,为系统的长期运行提供保障。

(3)数据处理与分析

数据处理与分析是系统的核心环节。利用Python的强大数据处理能力,通过Numpy、Scipy等科学计算库对存储的数据进行统计分析、数学建模和机器学习等操作。通过聚类分析、回归分析等方法挖掘数据背后的规律和趋势,为考生提供个性化的报考建议、学习规划和成绩预测等服务。这一阶段将数据转化为有价值的信息,为决策提供支持。

(4)可视化与展示

最后,进入可视化与展示阶段。利用Python的可视化库如Matplotlib、Seaborn、Plotly等,将复杂的数据分析结果以直观、易懂的图表形式展示出来。通过设计交互式仪表盘,使用户能够轻松筛选、对比和分析数据。同时,结合Web开发技术Django等,将可视化结果嵌入到Web页面中,供考生、教育机构和研究者随时随地访问和使用。可视化与展示环节使数据变得生动易懂,提升了用户体验和系统的实用性。Python版本:python3.7+

前端:vue.js+elementui

框架:django/flask都有,都支持

后端:python

数据库:mysql

数据库工具:Navicat

开发软件:PyCharm

大数据系统开发流程

Scrapy作为高性能的网络爬虫框架,负责从各类目标网站上抓取数据,为系统提供丰富的数据源。Pandas则用于数据的清洗、整理和分析,它能够处理复杂的数据操作,确保数据的准确性和可靠性。在数据可视化方面,Echarts和Vue.js发挥重要作用。Echarts提供直观、生动、可交互的数据可视化图表,帮助用户更好地理解数据背后的价值;Vue.js作为一种流行的前端开发框架,为数据可视化提供了强大的支持,使界面更加友好和易用。Flask框架和django框架用于搭建系统的后端服务,提供基本的路由、模板和静态文件服务功能。MySQL数据库则用于存储和管理从爬虫获取的数据、用户信息以及分析结果等,为系统提供高效的数据存储和查询能力。

爬虫原理

基本上所有Python爬虫初学者都会接触到两个工具库,requests和BeautifulSoup,这二者作为最为常见的基础库,其使用方式也截然不同,其中request工具库主要是用来获取网页的源代码,其需要向服务器发送url请求指令;而beautifulsoup则主要用来对网页的源语言,包括且不限于HTML\xml进行读取和解析,提取重要信息。这两个库模拟了人们访问网页、阅读网页以及复制粘贴相应信息的过程,可以批量快速抓取数据。

数据清洗

数据清洗技术主要是通过使用python语言中的正则表达式技术,通过其大量收集目标数据,并进一步进行提取。2、数据转换技术主要是通过加载法,将源数据中收集到的字符串按照相应的规则和序列转换成字典。3、数据去重即用unique方法,返回没有重复元素的数组或列表。 预处理后保存到CSV文件中。

数据挖掘

数据挖掘主要是通过运用设计好的算法对已有的数据进行分析和汇总,并按照数据的特征进行情感分析。统计数据过程中多使用snownlp类库来实现这一基本的情感分析的操作,通过计算弹幕的数据值,来分析其中的倾向性。情感分析中长用sentiment来指明实际的情感值。其中,数据一旦越靠近1则越表明其正面属性,越接近0越负面,相关的结果数据可以作为情感分析的基础数据而得到。

数据可视化大屏分析

数据可视化模块主要采用饼图、词云和折线图等手段来实现最终的数据可视化。并通过matplotlib库等技术来进一步地研究和分析数据的特点,最终通过图表的模式来展示数据的深层含义。可视化模块包括各时段视频播放量比例图、热词统计图、每周不同时间视频播放量线图、情绪比例图等可视化图形。

主要运用技术介绍

Python语言

Python 是一个高层次的结合了解释性、编译性、互动性和面向对象的脚本语言,其设计具有很强的可读性,相比其他语言经常使用英文关键字,其他语言的一些标点符号,它具有比其他语言更有特色语法结构。

Flask框架

Flask 是一个轻量级的 Web 框架,使用 Python 语言编写,较其他同类型框架更为灵活、轻便且容易上手,小型团队在短时间内就可以完成功能丰富的中小型网站或 Web 服务的实现。

Flask 具有很强的定制性,用户可以根据自己的需求来添加相应的功能,在保持核心功能简单的同时实现功能的丰富与扩展,其强大的插件库可以让用户实现个性化的网站定制,开发出功能强大的网站。

Djiango框架

MVC是众所周知的模式,即:将应用程序分解成三个组成部分:model(模型),view(视图),和 controller(控制 器)。其中:

M——管理应用程序的状态(通常存储到数据库中),并约束改变状态的行为(或者叫做“业务规则”)。

C——接受外部用户的操作,根据操作访问模型获取数据,并调用“视图”显示这些数据。控制器是将“模型”和“视图”隔离,并成为二者之间的联系纽带。

V——负责把数据格式化后呈现给用户。

B/S框架

b/s 是browser/server指浏览器和服务器端,在客户机端不用装专门的软件,只要一个浏览器即可.B/S最大的优点:客户可以在任何地方进行操作而不用安装任何专门的软件。只要有一台能上网的电脑就能使用,客户端零维护。

前台框架Vue.js

主要采用Vue技术:这是基于整个Python体系设计开发Web的技术,我们利用这一技术可以建立的动态网站是安全、先进并能跨平台

爬虫核心代码展示

import scrapy

import pymysql

import pymssql

from ..items import xiangmuItem

import time

import re

import random

import platform

import json

import os

from urllib.parse import urlparse

import requests

import emoji

class xiangmuSpider(scrapy.Spider):

name = 'xiangmuSpider'

spiderUrl = 'https://url网址'

start_urls = spiderUrl.split(";")

protocol = ''

hostname = ''

def __init__(self, *args, **kwargs):

super().__init__(*args, **kwargs)

# 列表解析

def parse(self, response):

_url = urlparse(self.spiderUrl)

self.protocol = _url.scheme

self.hostname = _url.netloc

plat = platform.system().lower()

if plat == 'windows_bak':

pass

elif plat == 'linux' or plat == 'windows':

connect = self.db_connect()

cursor = connect.cursor()

if self.table_exists(cursor, 'xiangmu') == 1:

cursor.close()

connect.close()

self.temp_data()

return

list = response.css('ul.subject-list li.subject-item')

for item in list:

fields = xiangmuItem()

fields["laiyuan"] = self.remove_html(item.css('div.pic a.nbg::attr(href)').extract_first())

if fields["laiyuan"].startswith('//'):

fields["laiyuan"] = self.protocol + ':' + fields["laiyuan"]

elif fields["laiyuan"].startswith('/'):

fields["laiyuan"] = self.protocol + '://' + self.hostname + fields["laiyuan"]

fields["fengmian"] = self.remove_html(item.css('div.pic a.nbg img::attr(src)').extract_first())

fields["xiaoshuoming"] = self.remove_html(item.css('div.info h2 a::attr(title)').extract_first())

detailUrlRule = item.css('div.pic a.nbg::attr(href)').extract_first()

if self.protocol in detailUrlRule:

pass

elif detailUrlRule.startswith('//'):

detailUrlRule = self.protocol + ':' + detailUrlRule

else:

detailUrlRule = self.protocol + '://' + self.hostname + detailUrlRule

fields["laiyuan"] = detailUrlRule

yield scrapy.Request(url=detailUrlRule, meta={'fields': fields}, callback=self.detail_parse)

# 详情解析

def detail_parse(self, response):

fields = response.meta['fields']

try:

if '(.*?)' in '''div#info span a::text''':

fields["zuozhe"] = re.findall(r'''div#info span a::text''', response.text, re.S)[0].strip()

else:

if 'zuozhe' != 'xiangqing' and 'zuozhe' != 'detail' and 'zuozhe' != 'pinglun' and 'zuozhe' != 'zuofa':

fields["zuozhe"] = self.remove_html(response.css('''div#info span a::text''').extract_first())

else:

fields["zuozhe"] = emoji.demojize(response.css('''div#info span a::text''').extract_first())

except:

pass

# 去除多余html标签

def remove_html(self, html):

if html == None:

return ''

pattern = re.compile(r'<[^>]+>', re.S)

return pattern.sub('', html).strip()

# 数据库连接

def db_connect(self):

type = self.settings.get('TYPE', 'mysql')

host = self.settings.get('HOST', 'localhost')

port = int(self.settings.get('PORT', 3306))

user = self.settings.get('USER', 'root')

password = self.settings.get('PASSWORD', '123456')

try:

database = self.databaseName

except:

database = self.settings.get('DATABASE', '')

if type == 'mysql':

connect = pymysql.connect(host=host, port=port, db=database, user=user, passwd=password, charset='utf8')

else:

connect = pymssql.connect(host=host, user=user, password=password, database=database)

return connect

结论

通过代码审查和自动化工具扫描,对系统的源代码进行了白盒测试。测试主要关注代码的逻辑结构、循环和条件分支等,确保代码质量高,没有逻辑错误或冗余代码。测试结果表明代码结构合理,注释充分,维护性好。对系统的关键组件和数据库操作进行了性能测试,评估了系统在高并发情况下的表现。测试发现数据库访问在并发量极高时存在瓶颈,通过优化SQL查询和增加缓存机制后,性能得到显著提升。

系统测试在毕业课程设计系统中起着至关重要的作用。通过使用功能测试、性能测试和稳定性测试等方法,可以确保基于顾客偏好的唯品会个性化商品推荐系统的程序代码能够正常运行,并提供良好的用户体验。同时,采用适当的测试技术和工具可以提高测试效率和准确性,从而有效地验证系统的功能、性能和稳定性。

源码文档获取定制开发/同行可拿货,招校园代理 :文章底部获取博主联系方式!

需要成品或者定制,加我们的时候,不满意的可以定制

文章最下方名片联系我即可~ 所有项目都经过测试完善,本系统包修改时间和标题,包安装部署运行调试

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?