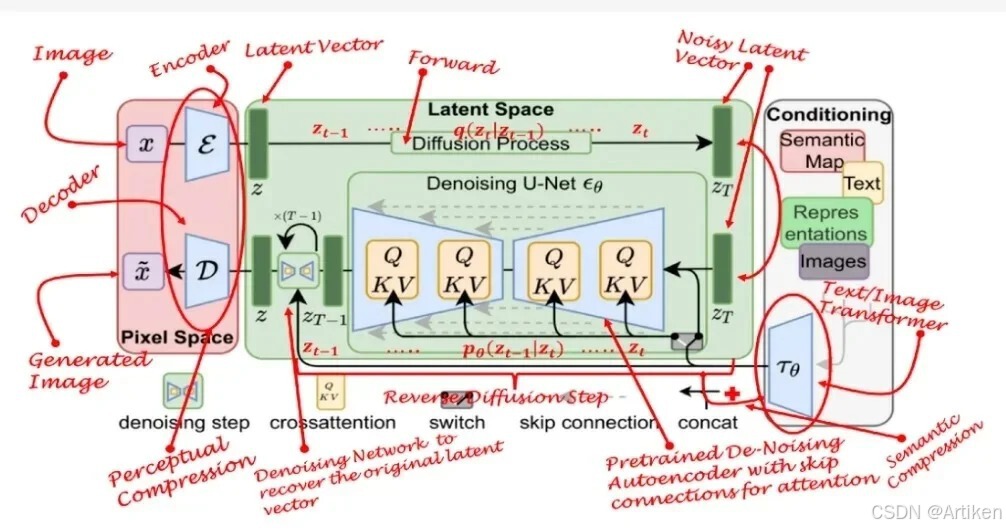

(1)增强的生成能力

当扩散模型与 Transformer 相结合后,在生成图像、音频和文本等内容方面展现出了非凡的能力。

- 创新点:扩散模型原本就具备强大的生成能力,可逐步构建复杂的数据分布。而与 Transformer 结合时,其生成能力进一步强化。Transformer 的自注意力机制能够高效捕捉长距离依赖关系,从而使生成过程中的每一步都能充分顾及整个序列的上下文信息。这种融合为生成高质量、高度一致的内容提供了一种极具威力的途径。

- 应用:在生成艺术图像、高保真音乐或复杂文本内容等领域,这种结合方式已彰显出卓越的性能,尤其在保持长期一致性和复杂样式方面表现突出。

(2)改进的序列到序列模型

扩散模型与 Transformer 的结合为序列到序列(Seq2Seq)任务,如机器翻译、文本摘要等,开辟了新的可能性。

- 创新点:在二者的结合中,Transformer 负责捕捉序列之间的复杂关系,扩散模型则负责逐步构建目标序列。这种模式使模型能够更出色地应对复杂的序列转换任务,并且在转换过程中能更有效地保障内容的连贯性和准确性。

- 应用:在机器翻译、自动文本生成、语音识别后处理等任务中,结合了扩散模型的 Transformer 表现优异,特别是在处理长序列和维持高质量输出方面展现出强大的优势。

(3)提高模型的泛化能力

这种结合方式在处理多样化且复杂的数据集时,展现出了更出色的泛化能力。

- 创新点:扩散模型的生成过程能够对数据分布的不同区域进行探索,而 Transformer 则能够对这些区域进行有效的编码。这种结合让模型不仅在训练数据上有良好的表现,在面对未见过的数据或少见样本时,也能展现出良好的泛化能力。

- 应用:在图像超分辨率、风格迁移、数据增强等领域,这种结合的模型能够处理更广泛的输入,进而生成更多样化且高质量的输出。

(4)提升效率和准确性

结合了扩散模型和 Transformer 的模型在提升效率和准确性方面也取得了显著的进展。

- 创新点:通过精心设计训练策略和优化算法,这种结合的模型能够在保持高效运行的同时,提高准确性。

- 应用:在需要处理大规模数据集或执行高效率推理的任务中,如在线内容生成和实时图像处理,这种结合的模型充分展现出了其实用价值。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?