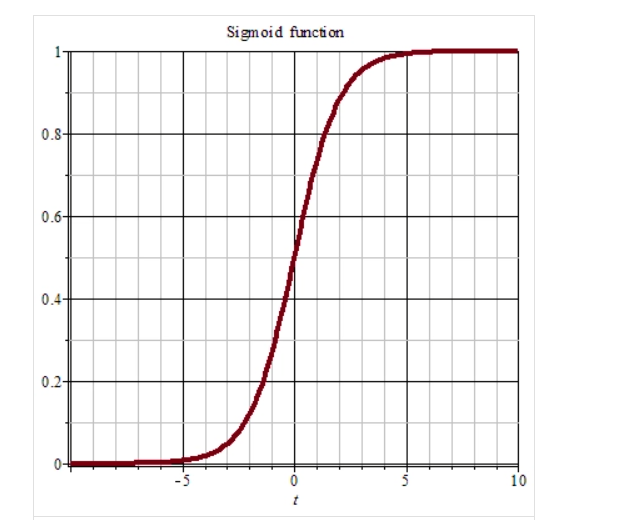

sigmoid函数

表达式:

图像:

取值范围:(0,1)

优点:平滑。

缺点:1、激活函数计算量大,反向传播求误差梯度时,求导涉及除法;

2、反向传播时,很容易就会出现梯度消失的情况,从而无法完成深层网络的训练。

3、(没搞懂)输出不以零为中心并且输出恒正,导致权重更新容易出现锯齿形收敛路径(zig-zag收敛路径),这样降低了更新效率,它通常不适合隐藏层,多用于输出层。

Tanh函数

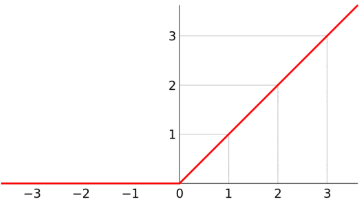

ReLU激活函数(又称线性整流函数)

介绍:它有很多变体,比如带泄露线性整流函数和噪声线性整流函数。

表达式:max(0,x)

图像:

取值范围:[0,+∞]

优点:1、更符合生物神经网络的特性。

2.更加有效率的梯度下降以及反向传播:避免了梯度爆炸和梯度消失问题。

3.简化计算过程:没有了其他复杂激活函数中诸如指数函数的影响;同时活跃度的分散性使得神经网络整体计算成本下降。

缺点:

7178

7178

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?