目录

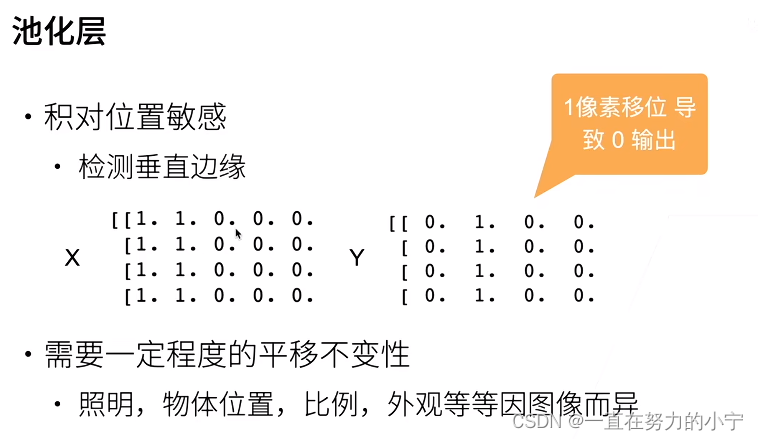

1 池化层

:物体稍微变动,结果不会变化太多

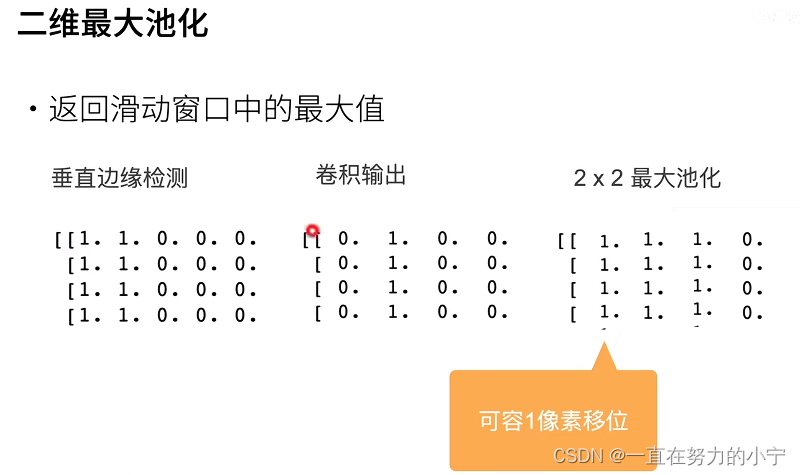

2x2最大池化写错了,更正如下 (因为是从卷积输出作用过来的)

| 1 | 1 | 0 | 0 |

| 1 | 1 | 0 | 0 |

| 1 | 1 | 0 | 0 |

| 1 | 1 | 0 | 0 |

2 实现

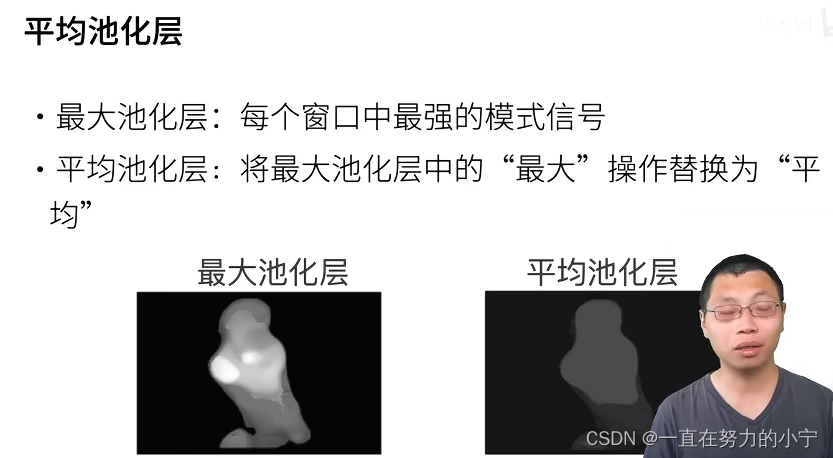

2.1 最大池化层和平均池化层

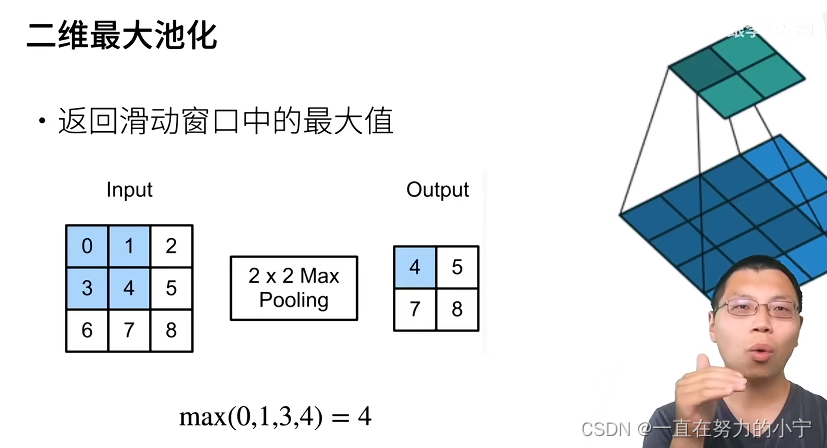

在下面的代码中的pool2d函数,我们实现汇聚层的前向传播。 这类似于 6.2节中的corr2d函数。 然而,这里我们没有卷积核,输出为输入中每个区域的最大值或平均值。

import torch

from torch import nn

from d2l import torch as d2l

def pool2d(X, pool_size, mode='max'):

p_h, p_w = pool_size

Y = torch.zeros((X.shape[0] - p_h + 1, X.shape[1] - p_w + 1))

for i in range(Y.shape[0]):

for j in range(Y.shape[1]):

if mode == 'max':

Y[i, j] = X[i: i + p_h, j: j + p_w].max()

elif mode == 'avg':

Y[i, j] = X[i: i + p_h, j: j + p_w].mean()

return Y我们可以构建 图6.5.1中的输入张量X,验证二维最大汇聚层的输出。

X = torch.tensor([[0.0, 1.0, 2.0], [3.0, 4.0, 5.0], [6.0, 7.0, 8.0]])

pool2d(X, (2, 2))

tensor([[4., 5.],

[7., 8.]])

此外,我们还可以验证平均汇聚层。

pool2d(X, (2, 2), 'avg')

tensor([[2., 3.],

[5., 6.]])

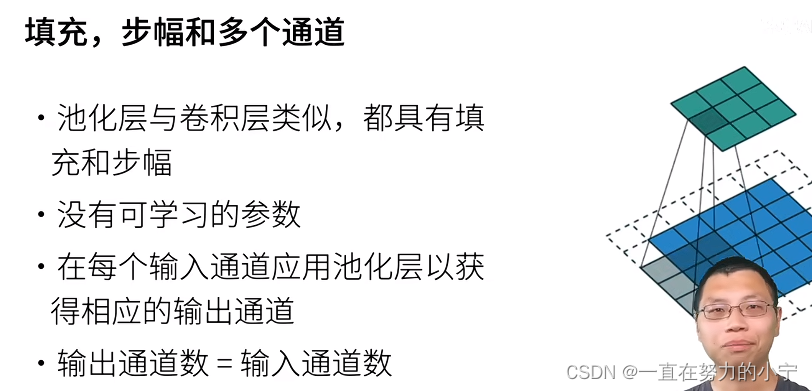

2.2 填充和步幅

与卷积层一样,汇聚层也可以改变输出形状。和以前一样,我们可以通过填充和步幅以获得所需的输出形状。 下面,我们用深度学习框架中内置的二维最大汇聚层,来演示汇聚层中填充和步幅的使用。 我们首先构造了一个输入张量X,它有四个维度,其中样本数和通道数都是1。

X = torch.arange(16, dtype=torch.float32).reshape((1, 1, 4, 4))

X

tensor([[[[ 0., 1., 2., 3.],

[ 4., 5., 6., 7.],

[ 8., 9., 10., 11.],

[12., 13., 14., 15.]]]])

默认情况下,深度学习框架中的步幅与汇聚窗口的大小相同。 因此,如果我们使用形状为(3, 3)的汇聚窗口,那么默认情况下,我们得到的步幅形状为(3, 3)。

pool2d = nn.MaxPool2d(3)

pool2d(X)tensor([[[[10.]]]])

填充和步幅可以手动设定。

pool2d = nn.MaxPool2d(3, padding=1, stride=2)

pool2d(X)当然,我们可以设定一个任意大小的矩形汇聚窗口,并分别设定填充和步幅的高度和宽度。

pool2d = nn.MaxPool2d((2, 3), stride=(2, 3), padding=(0, 1))

pool2d(X)2.3 多个通道

在处理多通道输入数据时,汇聚层在每个输入通道上单独运算,而不是像卷积层一样在通道上对输入进行汇总。 这意味着汇聚层的输出通道数与输入通道数相同。 下面,我们将在通道维度上连结张量X和X + 1,以构建具有2个通道的输入。

X = torch.cat((X, X + 1), 1)

X

tensor([[[[ 0., 1., 2., 3.],

[ 4., 5., 6., 7.],

[ 8., 9., 10., 11.],

[12., 13., 14., 15.]],

[[ 1., 2., 3., 4.],

[ 5., 6., 7., 8.],

[ 9., 10., 11., 12.],

[13., 14., 15., 16.]]]])

如下所示,汇聚后输出通道的数量仍然是2。

pool2d = nn.MaxPool2d(3, padding=1, stride=2)

pool2d(X)

tensor([[[[ 5., 7.],

[13., 15.]],

[[ 6., 8.],

[14., 16.]]]])

2.4 小结

-

对于给定输入元素,最大汇聚层会输出该窗口内的最大值,平均汇聚层会输出该窗口内的平均值。

-

汇聚层的主要优点之一是减轻卷积层对位置的过度敏感。

-

我们可以指定汇聚层的填充和步幅。

-

使用最大汇聚层以及大于1的步幅,可减少空间维度(如高度和宽度)。

-

汇聚层的输出通道数与输入通道数相同。

本文阐述了池化层在深度学习中的关键作用,涉及最大池化、平均池化操作,以及填充和步幅对输出形状的影响。

本文阐述了池化层在深度学习中的关键作用,涉及最大池化、平均池化操作,以及填充和步幅对输出形状的影响。

757

757

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?