3分钟部署自己独享的Gemini

在前面的几篇文章中,分别介绍了Gemini Pro的发布和Gemini Pro API的详细申请步骤,那么今天给大家分享的是如何快速搭建一个属于自己的Gemini 。

1️⃣ 准备工作

- 科学网络环境

- Github账号和Vercel账号

- Gemini Pro API Key(申请步骤详情参考我往期文章)

- 域名(可选,有网络环境可忽略)

2️⃣ Gemini Pro Chat 项目地址

项目地址:https://github.com/babaohuang/GeminiProChat

目前此项目已有1.5k⭐

3️⃣ Gemini Pro Chat 项目部署步骤

1. 部署项目到Vercel

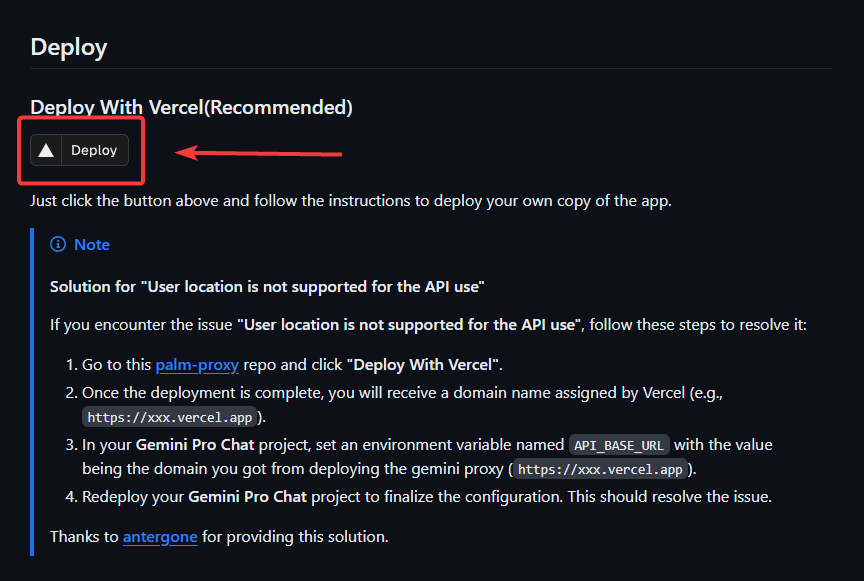

打开项目地址,往下翻找到**Deploy**快捷部署按钮,点击部署

2. 创建Git仓库

项目部署至Vercel时,会同步创建一个 Git 仓库,仓库名可命名为你喜欢的。

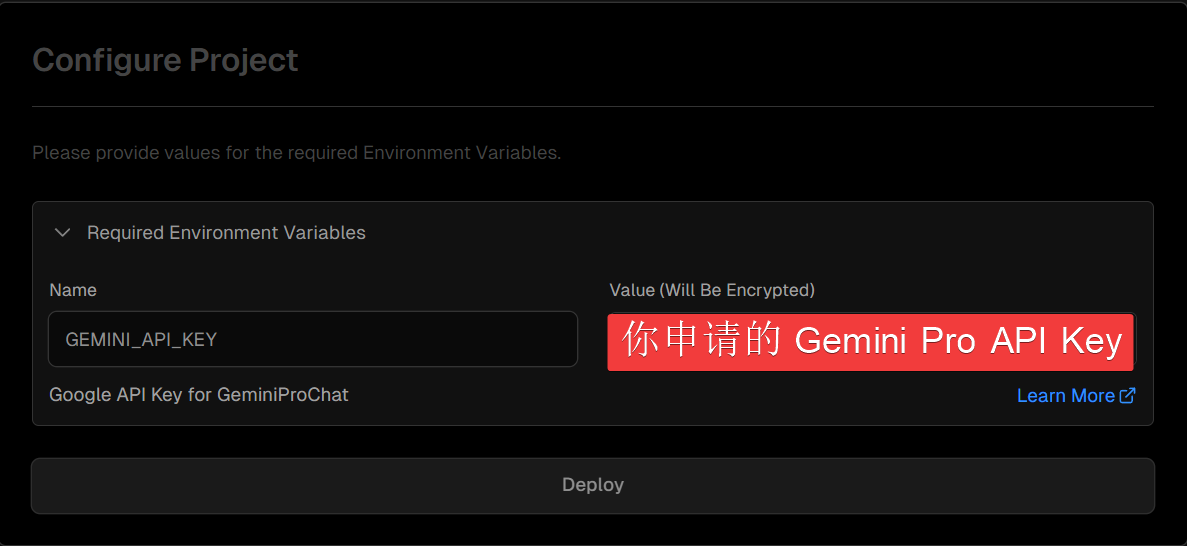

3. 设置环境变量

进入地址:https://makersuite.google.com/app/apikey 获取你的 API Key

在下方推荐环境变量处输入你的API Key,然后点击Deploy部署即可

| Name | Value |

|---|---|

| GEMINI_API_KEY | 你申请的 Gemini Pro API Key |

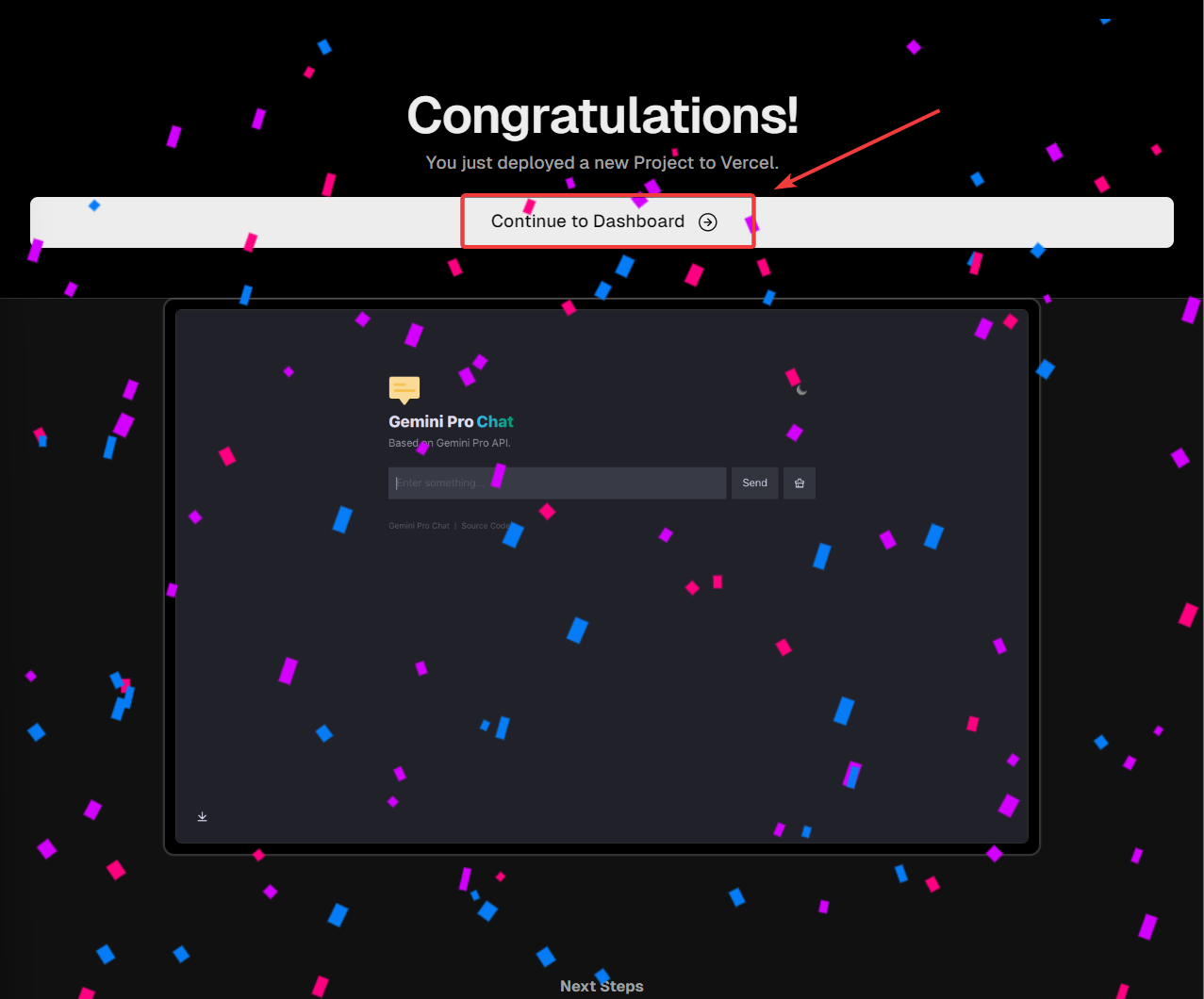

稍等几分钟,我们就能看到已经成功部署了,有撒花特效

4. 访问项目

点击Continue to Dashboard访问进入仪表盘,点击Visit即可访问部署好的项目

5. 域名绑定

由于某些原因Vecel在国内直接访问受限制,所以我们可以购买一个域名进行绑定实现国内访问。

依次点击Setting→Domains→输入域名→Add

在域名商处添加DNS记录进行解析,等待DNS解析完成即可通过域名直接访问项目。

已经自己有域名的推荐使用二级域名,例如我的是:gemini + xxxxx.com

以上就是全部部署步骤,赶快部署一个你自己的Gemini吧!!!

4️⃣ Gemini Pro Chat 使用

- 通过Gemini Pro Chat 项目的Vercel域名或者自己绑定的域名进行访问

- 聊天框输入文本后

Send即可立即使用,支持32k上下文 - 免费用户有每分钟60条的限制

5️⃣ 参考文章

以上就是通过Gemini Pro Chat项目部署属于自己的Gemini的详细部署步骤。如果您觉得这篇文章对您有所帮助,欢迎收藏转发和分享。

如果您有任何想法和建议,请随时在评论区留言。您的反馈对我来说非常重要,我会认真倾听并不断改进我的文章内容。

同时,如果您想第一时间获取我的最新文章和动态,您还可以搜索关注我的博客或公众号。

再次感谢您的支持和关注,期待与您在未来的文章中再次相遇!

1292

1292

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?