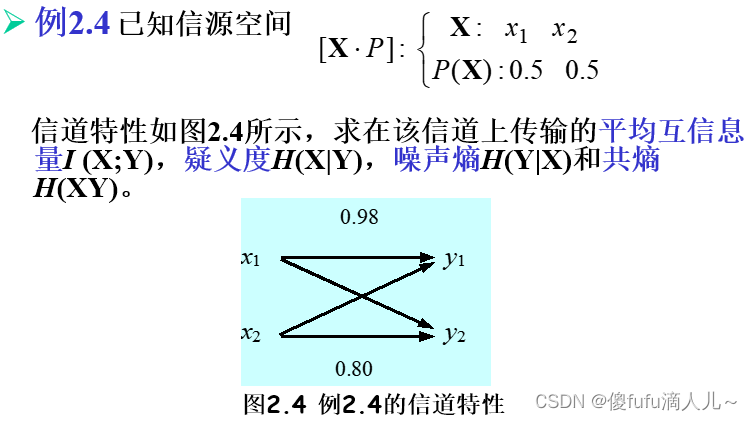

【信息论与编码 沈连丰】第二章:信息的度量

2.1 度量信息的基本思路

-

单符号离散信源:如果信源发出的消息是离散的、有限或无限可列的符号或数字,且一个符号代表一条完整的消息,则称这种信源为单符号离散信源。

-

信源空间:若信源的输出是随机事件X,其出现概率为P(X),则它们所构成的集合,称为信源的概率空间或简称为信源空间。信源空间必定是一个完备集,即 ∑ i = 0 n p ( x i ) = 1 \sum\limits_{i=0}^np(x_i)=1 i=0∑np(xi)=1

-

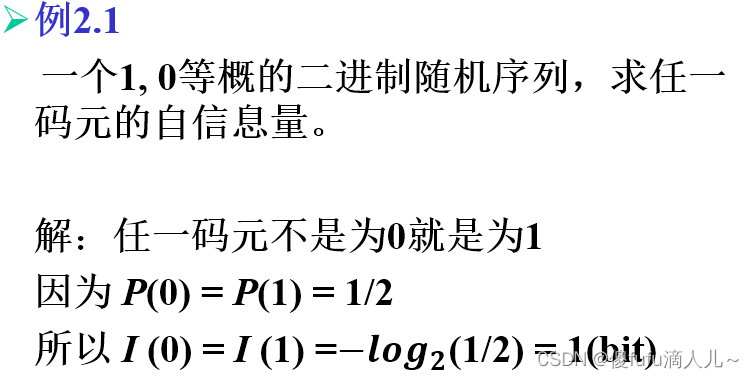

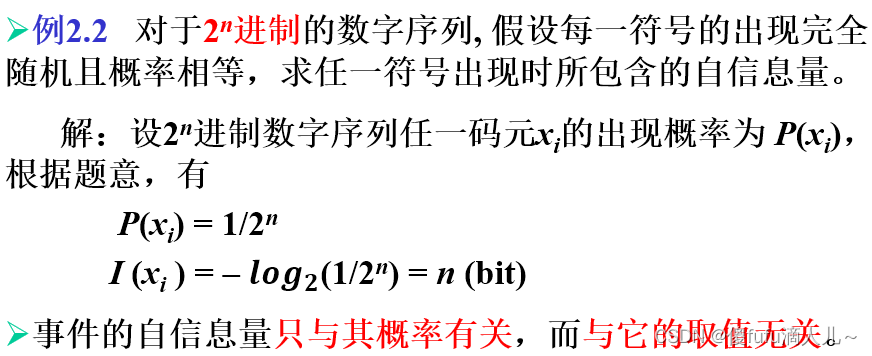

若信源中事件 x i x_i xi的出现所带来的信息量用 I ( x i ) I(x_i) I(xi)来表示并称之为事件 x i x_i xi的自信息量,则概率为 p ( x i ) p(x_i) p(xi)的信源输出 x i x_i xi所包含的信息量 I ( x i ) I(x_i) I(xi)必须满足以下几个条件:

- 信源输出 x i x_i xi所包含的信息量仅依赖于它的概率,而与它的取值无关

- I ( x i ) I(x_i) I(xi)是 p ( x i ) p(x_i) p(xi)的连续函数

- I ( x i ) I(x_i) I(xi)是 p ( x i ) p(x_i) p(xi)的减函数,即如果 p ( x i ) > p ( x j ) , I ( x i ) < I ( x j ) p(x_i)>p(x_j),I(x_i)<I(x_j) p(xi)>p(xj),I(xi)<I(xj);极限情况:若 p ( x ) = 0 , I ( x i ) → ∞ p(x)=0,I(x_i)\rightarrow\infty p(x)=0,I(xi)→∞;若 p ( x ) = 1 , I ( x i ) = 0 p(x)=1,I(x_i)=0 p(x)=1,I(xi)=0

- 若两个单符号离散信源(符号集合X,Y)统计独立,则X中出现 x i x_i xi,Y中出现 y i y_i yi的联合信息量 I ( x i , y i ) = I ( x i ) + I ( y i ) I(x_i,y_i)=I(x_i)+I(y_i) I(xi,yi)=I(xi)+I(yi)

只有对数函数能够同时满足以上4个条件。

-

自信息量: x i x_i xi的自信息量是指 x i x_i xi具备的不确定性,或者说收到符号 x i x_i xi后获得的信息量。

I ( x i ) = l o g ( 1 p ( x i ) ) = − l o g ( p ( x i ) ) I(x_i)=log(\frac{1}{p(x_i)})=-log(p(x_i)) I(xi)=log(p(xi)1)=−log(p(xi))

I ( x i ) I(x_i) I(xi)实质上是无量纲的,为了研究方便,根据对数的底数来定义信息量的量纲:底数取2,信息量单位为比特(bit);取自然对数e,信息量单位为奈特(nat);取10,单位为哈特(Hart);由换底公式可得, 1 n a t ≈ 1.44 b i t ; 1 H a r t ≈ 3.32 b i 1nat\approx1.44bit;\quad1Hart\approx3.32bi 1nat≈1.44bit;1Hart≈3.32bi

-

自信息量和不确定度的关系:自信息量是针对随机事件发生时所带来的信息量,只有随机事件发生时才产生,不发生没有,它是一个动态概念;不确定度只与事件的概率有关,是一个统计量,在静态状态下也存在。

-

注意自信息量 I ( x i ) I(x_i) I(xi)只能表示信源发出的某一具体符号 x i x_i xi的自信息量,而信源空间具有多个符号且概率不一定相等,因此 I ( x i ) I(x_i) I(xi)不能作为整个信源的总体信息测度。因此作为信源总体信息测度的量应该是信源各个不同符号的自信息量的统计平均值。

2.2 信源熵和条件熵

-

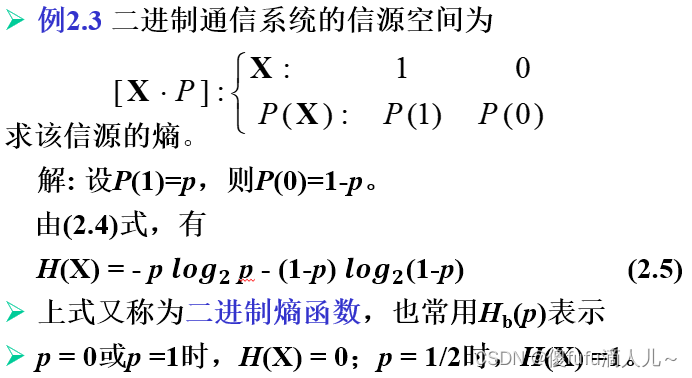

信源熵:若信源符号 x i x_i xi的出现概率为 p ( x i ) p(x_i) p(xi),自信息量为 I ( x i ) ( i = 1 , 2 , ⋯ , N ) I(x_i)(i=1,2,\cdots,N) I(xi)(i=1,2,⋯,N),则 H ( X ) = ∑ i = 1 N p ( x i ) I ( x i ) = ∑ X p ( x i ) I ( x i ) = − ∑ X p ( x i ) log p ( x i ) H(X)=\sum\limits_{i=1}^Np(x_i)I(x_i)=\sum\limits_Xp(x_i)I(x_i)=-\sum\limits_Xp(x_i)\log p(x_i) H(X)=i=1∑Np(xi)I(xi)=X∑p(xi)I(xi)=−X∑p(xi)logp(xi),称为信源的信息熵,即信源熵,定义 0 log 0 = 0 0\log 0=0 0log0=0

-

信源熵只与信源符号的概率分布有关,是一种先验熵;对于单符号离散信源,信源熵是信源每发一个符号所提供的平均信息量,量纲为 信息单位/信源符号;对于任何给定概率分布的信源,H(X)是一个确定数,其大小代表了信源每发出一个符号给出的平均信息量。

-

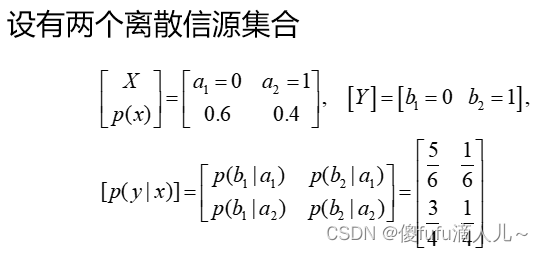

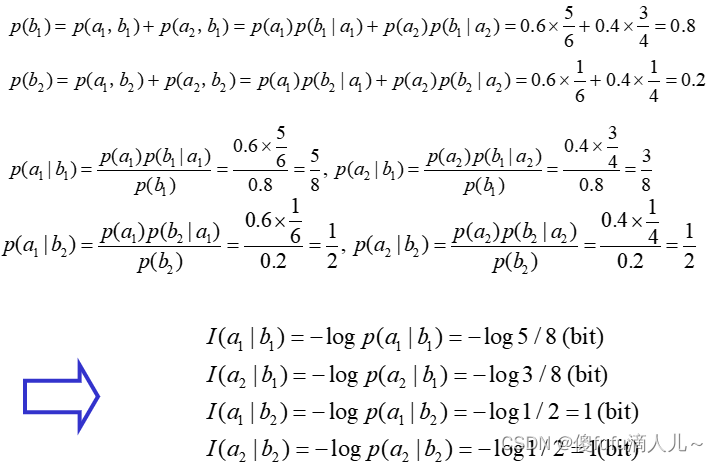

条件自信息量:设在 y i y_i yi条件下,随机事件 x i x_i xi的条件概率为 p ( x i ∣ y i ) p(x_i|y_i) p(xi∣yi),则 x i x_i xi出现带来的信息量称为它的条件自信息量,记为 I ( x i ∣ y i ) = − log p ( x i ∣ y i ) I(x_i|y_i)=-\log p(x_i|y_i) I(xi∣yi)=−logp(xi∣yi)

-

条件熵:在给定y条件下X集合的总体信息量度,即为给定y条件下X的条件熵,记为 H ( X ∣ y ) = ∑ X p ( x ∣ y ) I ( x ∣ y ) = − ∑ X p ( x ∣ y ) log p ( x ∣ y ) H(X|y)=\sum\limits_Xp(x|y)I(x|y)=-\sum\limits_Xp(x|y)\log p(x|y) H(X∣y)=X∑p(x∣y)I(x∣y)=−X∑p(x∣y)logp(x∣y)

考虑到整个Y集合,则

H ( X ∣ Y ) = ∑ Y p ( y ) H ( X ∣ y ) = − ∑ X Y p ( y ) p ( x ∣ y ) log p ( x ∣ y ) = − ∑ X Y p ( x y ) log p ( x ∣ y ) H(X|Y)=\sum\limits_Yp(y)H(X|y)=-\sum\limits_{XY}p(y)p(x|y)\log p(x|y)=-\sum\limits_{XY}p(xy)\log p(x|y) H(X∣Y)=Y∑p(y)H(X∣y)=−XY∑p(y)p(x∣y)logp(x∣y)=−XY∑p(xy)logp(x∣y)

2.3 互信息量和平均互信息量

-

互信息量:对两个离散随机事件集合X和Y,事件 y i y_i yi的出现给出关于事件 x i x_i xi的信息量,定义为事件 x i , y i x_i,y_i xi,yi的互信息量,用 I ( x i ; y i ) I(x_i;y_i) I(xi;yi)表示

-

假设X是信源发出的消息集合,Y是X经过信道后信宿收到的消息集合

- 在信道没有干扰情况下,即信源信息通过信道全部流向信宿,有 I ( x i ; y j ) = I ( x i ) I(x_i;y_j)=I(x_i) I(xi;yj)=I(xi)

- 当信道存在干扰时,信宿收到的信息就掺杂了信道的一些信息,因此 I ( x i ; y j ) = I ( x i ) − I ( x i ∣ y j ) I(x_i;y_j)=I(x_i)-I(x_i|y_j) I(xi;yj)=I(xi)−I(xi∣yj),则 I ( x i ; y j ) = log p ( x i ∣ y j ) p ( x i ) I(x_i;y_j)=\log \frac{p(x_i|y_j)}{p(x_i)} I(xi;yj)=logp(xi)p(xi∣yj)

-

互信息量的性质:

- 对称性: I ( x i ; y j ) = I ( y j ; x i ) I(x_i;y_j)=I(y_j;x_i) I(xi;yj)=I(yj;xi)

- 值域为实数:互信息量的值可为正数、负数或零,取决于后验概率和先验概率的比值

- p ( x i ∣ y j ) = 1 , I ( x i ; y j ) = I ( x i ) p(x_i|y_j)=1,I(x_i;y_j)=I(x_i) p(xi∣yj)=1,I(xi;yj)=I(xi),说明收到 y j y_j yj后可以完全消除对信源是否发 x i x_i xi的不确定度,物理含义是信宿收到了信源发出的全部信息量,也即信道没有干扰

- p ( x i ) < p ( x i ∣ y j ) < 1 , I ( x i ; y j ) > 0 , I ( x i ) > I ( x i ∣ y j ) p(x_i)<p(x_i|y_j)<1,I(x_i;y_j)>0,I(x_i)>I(x_i|y_j) p(xi)<p(xi∣yj)<1,I(xi;yj)>0,I(xi)>I(xi∣yj),说明收到 y j y_j yj可以消除一些对信源是否发 x i x_i xi的不确定度

- p ( x i ) = p ( x i ∣ y j ) , I ( x i ; y j ) = 0 , I ( x i ) = I ( x i ∣ y j ) p(x_i)=p(x_i|y_j),I(x_i;y_j)=0,I(x_i)=I(x_i|y_j) p(xi)=p(xi∣yj),I(xi;yj)=0,I(xi)=I(xi∣yj),说明收到 y j y_j yj一点也不能消除对信源是否发 x i x_i xi的不确定度

- 0 < p ( x i ∣ y j ) < p ( x i ) , I ( x i ; y j ) < 0 , I ( x i ) < I ( x i ∣ y j ) 0<p(x_i|y_j)<p(x_i),I(x_i;y_j)<0,I(x_i)<I(x_i|y_j) 0<p(xi∣yj)<p(xi),I(xi;yj)<0,I(xi)<I(xi∣yj),说明收到 y j y_j yj后对信源是否发 x i x_i xi的不确定度比 x i x_i xi在信源空间的概率还小,说明在信息流通过程中流通的不是关于 x i x_i xi的信息量,而是 x i x_i xi以外的事件的信息量

- I ( x i ; y j ) ≤ m i n { I ( x i ) , I ( y j ) } I(x_i;y_j)\leq min\{I(x_i),I(y_j)\} I(xi;yj)≤min{I(xi),I(yj)},这条性质说明互信息量是描述信息流通特征的物理量,流通量的数值当然要比任一事件的自信息量要小。

-

条件互信息量: I ( x i ; y j ∣ z k ) I(x_i;y_j|z_k) I(xi;yj∣zk)是指在给定 z k z_k zk条件下,事件 y j y_j yj的出现所提供的有关 x i x_i xi的信息量;或者说给定 z k z_k zk条件下, x i 和 y j x_i和y_j xi和yj的互信息量。

I ( x i ; y j ∣ z k ) = log p ( x i ∣ y j z k ) p ( x i ∣ z k ) I(x_i;y_j|z_k)=\log\frac{p(x_i|y_jz_k)}{p(x_i|z_k)} I(xi;yj∣zk)=logp(xi∣zk)p(xi∣yjzk)

I ( x i ; y j ∣ z k ) = log p ( x i ∣ y j z k ) p ( x i ∣ z k ) = log 1 p ( x i ∣ z k ) − log 1 p ( x i ∣ y j z k ) = I ( x i ∣ z k ) − I ( x i ∣ y j z k ) I(x_i;y_j|z_k)=\log\frac{p(x_i|y_jz_k)}{p(x_i|z_k)}=\log\frac{1}{p(x_i|z_k)}-\log\frac{1}{p(x_i|y_jz_k)}=I(x_i|z_k)-I(x_i|y_jz_k) I(xi;yj∣zk)=logp(xi∣zk)p(xi∣yjzk)=logp(xi∣zk)1−logp(xi∣yjzk)1=I(xi∣zk)−I(xi∣yjzk),即条件互信息量可以用条件信息量来表示

-

平均互信息量:两个离散随机事件集合X和Y,若其任意两事件间的互信息量为 I ( x i ; y j ) I(x_i;y_j) I(xi;yj),则其联合概率加权的统计平均值,称为两集合的平均互信息量,用 I ( X ; Y ) I(X;Y) I(X;Y)表示。

当信宿收到某一个具有符号 y j 后,从 y j 中获取关于输入符号的平均信息量,应该等于在条件概率空间中的统计平均,用 I ( X ; y j ) 表示 即: I ( X ; y j ) = ∑ i = 1 N p ( x i ∣ y j ) I ( x i ; y j ) = ∑ X p ( x ∣ y j ) I ( x ; y j ) 再对其在集合 Y 中取统计平均,即 I ( X ; Y ) = ∑ j = 1 M p ( y j ) I ( X ; y j ) = ∑ i = 1 N ∑ j = 1 M p ( y j ) p ( x i ∣ y j ) I ( x i y j ) = ∑ X Y p ( x y ) p ( x ∣ y ) p ( x ) = ∑ X Y p ( x y ) I ( x ; y ) 当信宿收到某一个具有符号y_j后,从y_j中获取关于输入符号的平均信息量,应该等于在条件概率空间中的统计平均,用I(X;y_j)表示\\ 即:I(X;y_j)=\sum\limits_{i=1}^Np(x_i|y_j)I(x_i;y_j)=\sum_{X}p(x|y_j)I(x;y_j)\\ 再对其在集合Y中取统计平均,即\\ I(X;Y)=\sum\limits_{j=1}^Mp(y_j)I(X;y_j)=\sum\limits_{i=1}^N\sum\limits_{j=1}^Mp(y_j)p(x_i|y_j)I(x_iy_j)=\sum\limits_{XY}p(xy)\frac{p(x|y)}{p(x)}=\sum_{XY}p(xy)I(x;y) 当信宿收到某一个具有符号yj后,从yj中获取关于输入符号的平均信息量,应该等于在条件概率空间中的统计平均,用I(X;yj)表示即:I(X;yj)=i=1∑Np(xi∣yj)I(xi;yj)=X∑p(x∣yj)I(x;yj)再对其在集合Y中取统计平均,即I(X;Y)=j=1∑Mp(yj)I(X;yj)=i=1∑Nj=1∑Mp(yj)p(xi∣yj)I(xiyj)=XY∑p(xy)p(x)p(x∣y)=XY∑p(xy)I(x;y) -

平均互信息量的性质:

-

对称性: I ( X ; Y ) = I ( Y ; X ) I(X;Y)=I(Y;X) I(X;Y)=I(Y;X)

-

结论:

-

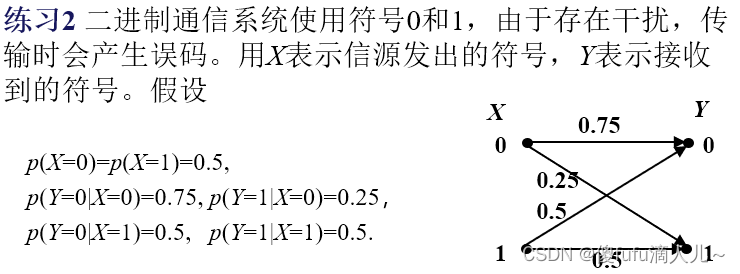

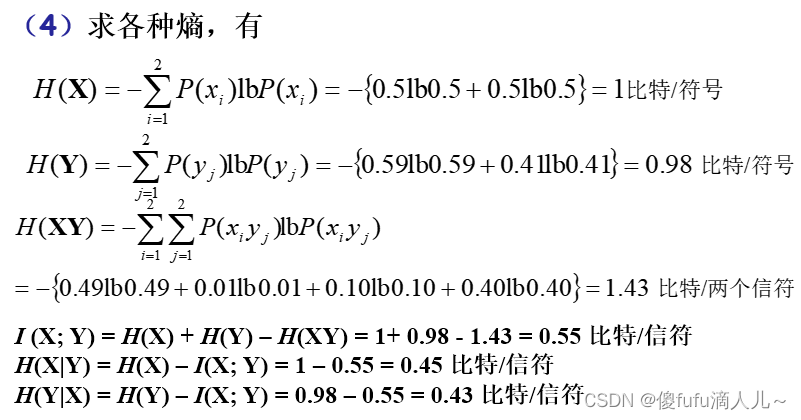

I ( X ; Y ) = H ( X ) − H ( X ∣ Y ) I(X;Y)=H(X)-H(X|Y) I(X;Y)=H(X)−H(X∣Y):表明信道存在干扰和噪声时,到达接收端的平均信息量等于信源熵减去一个条件熵,这个条件熵表征了对接收的每一个符号的正确性所产生的怀疑程度,即称条件熵 H ( X ∣ Y ) H(X|Y) H(X∣Y)为疑义度。

-

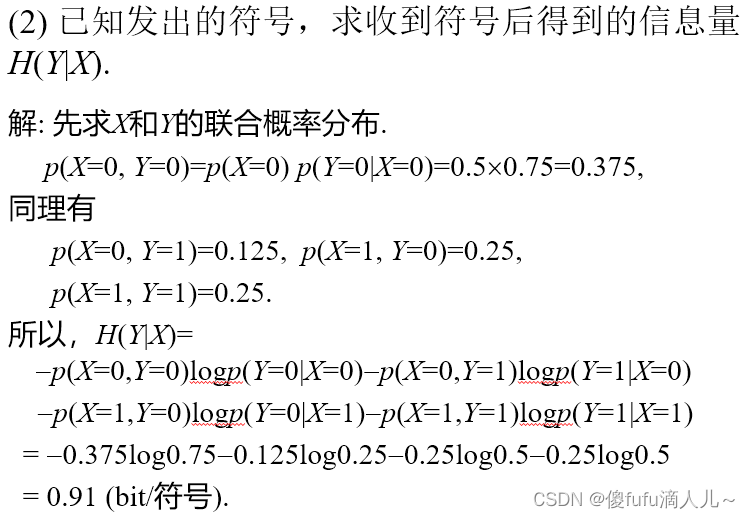

I ( Y ; X ) = H ( Y ) − H ( Y ∣ X ) I(Y;X)=H(Y)-H(Y|X) I(Y;X)=H(Y)−H(Y∣X):表明信道存在干扰和噪声时,到达接收端的平均信息量等于信宿熵减去一个条件熵,这个条件熵是信道给出的,是唯一地能确定信道噪声和干扰所需的平均信息量,即 H ( Y ∣ X ) H(Y|X) H(Y∣X)称为噪声熵,也称散布度。

-

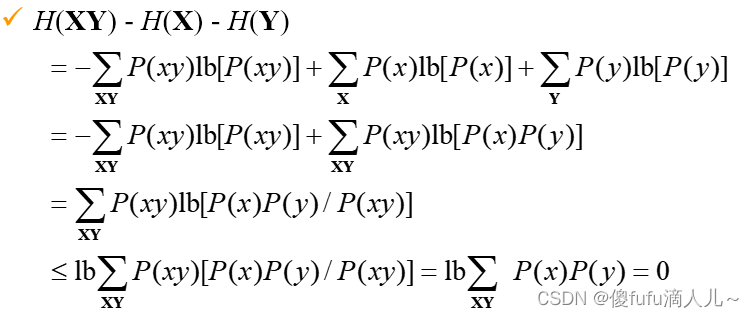

I ( X ; Y ) = H ( X ) + H ( Y ) − H ( X , Y ) I(X;Y)=H(X)+H(Y)-H(X,Y) I(X;Y)=H(X)+H(Y)−H(X,Y);H(X,Y)表示X和Y的联合熵: H ( X , Y ) = ∑ X Y p ( x y ) I ( x y ) H(X,Y)=\sum_{XY}p(xy)I(xy) H(X,Y)=∑XYp(xy)I(xy)

-

H ( X , Y ) = H ( X ) + H ( Y ∣ X ) H(X,Y)=H(X)+H(Y|X) H(X,Y)=H(X)+H(Y∣X)

-

H ( X , Y ) = H ( Y ) + H ( X ∣ Y ) H(X,Y)=H(Y)+H(X|Y) H(X,Y)=H(Y)+H(X∣Y)

-

平均互信息量是一个非负数

-

-

-

Jensen不等式:如果 f 是上凸函数,即二阶导数为负,X为随机变量,则有 E [ f ( x ) ] ≤ f [ E ( x ) ] E[f(x)]\leq f[E(x)] E[f(x)]≤f[E(x)]

-

相对熵:若x有两种分布 p ( x ) , q ( x ) p(x),q(x) p(x),q(x),则 D ( p ∣ ∣ q ) = ∑ X p ( x ) log p ( x ) − ∑ X p ( x ) log q ( x ) = ∑ X p ( x ) log p ( x ) q ( x ) D(p||q)=\sum\limits_{X}p(x)\log p(x)-\sum\limits_{X}p(x)\log q(x)=\sum\limits_{X}p(x)\log \frac{p(x)}{q(x)} D(p∣∣q)=X∑p(x)logp(x)−X∑p(x)logq(x)=X∑p(x)logq(x)p(x),也称为两种分布的KL散度,或者KL距离。

-

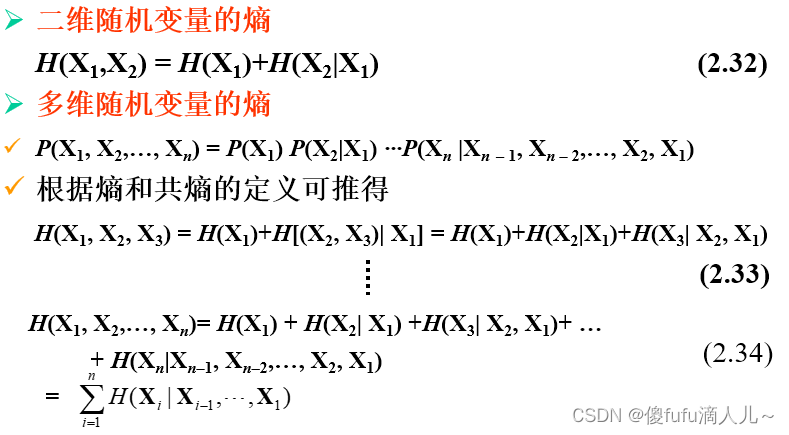

熵的链式法则:

-

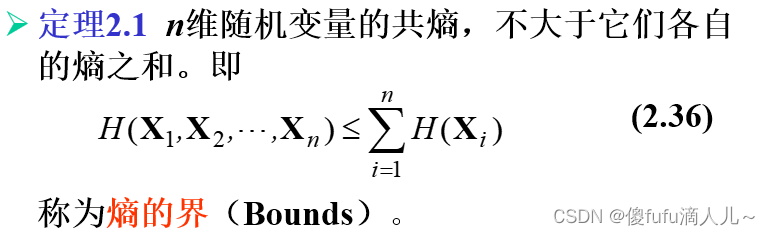

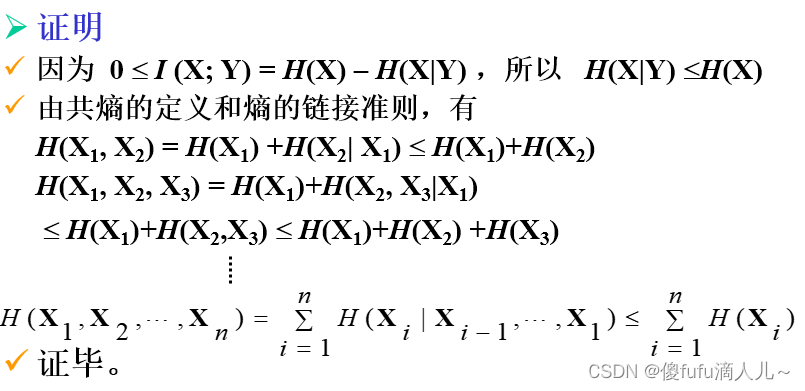

熵的边界:

-

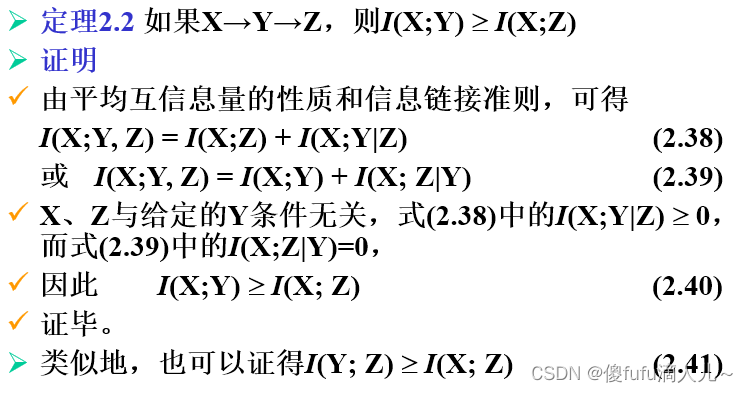

马尔科夫链:对于3个随机变量空间X,Y,Z,如果Z的条件分布仅仅取决于Y而与X的条件无关,那么称随机变量X,Y,Z构成了马尔科夫链,即 p ( x , y , z ) = p ( x ) p ( y ∣ x ) p ( z ∣ y ) p(x,y,z)=p(x)p(y|x)p(z|y) p(x,y,z)=p(x)p(y∣x)p(z∣y),用 X → Y → Z X\rightarrow Y\rightarrow Z X→Y→Z表示。

-

马尔科夫链性质:

本文介绍了信息论中的核心概念,包括自信息量、信源熵、条件熵、互信息量及平均互信息量等内容。详细解释了如何度量信息及其统计特性,并探讨了这些度量在通信系统中的应用。

本文介绍了信息论中的核心概念,包括自信息量、信源熵、条件熵、互信息量及平均互信息量等内容。详细解释了如何度量信息及其统计特性,并探讨了这些度量在通信系统中的应用。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?