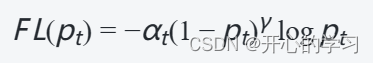

Focal Loss 是一种在处理不平衡数据时常用的损失函数,它主要通过对模型误差较大的样本进行放大,以便更好地学习这些样本。其数学表达式如下:

其中,Pt表示模型预测的概率,at是一个可调节的因子(通常为0.25或者0.5)。y用于调节损失函数的形状,通常取2。当y=0时,退化为交叉熵损失函数,当y>0时主要关注难分类的样本。

代码

class FocalLoss(nn.Module):

'''

gamma:用于调整损失函数的形状

alpha:比例因子,调节不同类别的权重

size_average:用于控制损失函数是否对batch中的每个进行平均

'''

def __init__(self, gamma=0, alpha=None, size_average=True):

super(FocalLoss, self).__init__()

self.gamma = gamma

self.alpha = alpha

if isinstance(alpha, (float, int)):

# 其中 object 表示要判断的对象,classinfo 可以是一个类对象或由多个类对象组成的元组 tuple。

# 如果 object 是 classinfo 的实例,或者 object 所属的类(或其子类)是 classinfo 中的任何一个类,

# 则返回 True,否则返回 False。

self.alpha = torch.Tensor([alpha, 1-alpha])

if isinstance(alpha, list):

self.alpha = torch.Tensor(alpha)

self.size_average = size_average

def forward(self, input, target):

if input.dim() > 2:

# N,C,H,W => N,C,H*W

input = input.view(input.size(0), input.size(1), -1)

# N,C,H*W => N,H*W,C

input = input.transpose(1, 2)

# N,H*W,C => N*H*W,C

input = input.contiguous().view(-1, input.size(2))

target = target.view(-1, 1)

logpt = F.log_softmax(input)

logpt = logpt.gather(1, target)

logpt = logpt.view(-1)

pt = Variable(logpt.data.exp())

if self.alpha is not None:

if self.alpha.type() != input.data.type():

self.alpha = self.alpha.type_as(input.data)

at = self.alpha.gather(0, target.data.view(-1))

logpt = logpt * Variable(at)

loss = -1 * (1-pt)**self.gamma * logpt

if self.size_average:

return loss.mean()

else:

return loss.sum()

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?