参考博客:https://www.cnblogs.com/pyedu/p/12461819.html

参考视频:01 celery的工作机制_哔哩哔哩_bilibili

官方文档:First steps with Django — Celery 5.4.0rc1 documentation

目录

定义

简单灵活、处理大量消息的分布式系统,专注于实时处理异步队列,支持任务调度

主要架构

- 消息中间件:message broker 可以集成第三方消息中间件如Redis、RabbitMQ

- 任务执行单元:worker 是celery提供的执行的任务执行的单元,并发分布在分布式的系统节点中

- 任务执行结果存储:task result store来存储执行任务的结果,支持方式 redis、AMQP

同步请求和异步请求

同步请求: 顺序进行IO操作等待阻塞进程依次执行

异步请求:异步进行,当IO操作阻塞时放到执行单元中完成放到数据库中而不影响其他单元的执行,当主进程需要阻塞的进程结果时会向是数据库中取出该数据(即将耗时操作放到异步队列中不影响主进程的执行),继续向下进行

使用场景

- 异步任务:将耗时操作任务提交到celery异步执行,如:发送短信、消息推送、音视频处理

- 定时任务:定时执行某件事情,如:每日数据统计

主要优点

- 简单:使用和维护不要配置文件,只需添加基本信息的配置

- 高可用:在work和client网络连接丢失或失败时会自动进行重试

- 快速:单个celery进程可每分钟处理百万级任务,只需要毫秒级的往返延迟

- 灵活:可以扩展使用,自定义池的实现、序列化、日志记录、消费者、broker消息传输

Celery 分布式任务队列

情景:用户发起 request,并等待 response 返回。在本些 views 中,可能需要执行一段耗时的程序,那么用户就会等待很长时间,造成不好的用户体验,比如发送邮件、手机验证码等。

解决 :将多个耗时的任务添加到队列 queue 中,也就是用 redis 实现 broker 中间人,然后用多个 worker 去监听队列里的任务去执行。

组成:

任务 task:就是一个 Python 函数。 worker:在一个新进程中,负责执行队列中的任务,也就是执行单元。 broker:负责调度,在布置环境中使用Redis,并且负责worker和服务器之间的信息传递。 backend:存储消息以及celery执行结果。

谈谈对Celery的理解

Celery是由Python开发、简单、灵活、可靠的分布式任务队列,其本质是生产者消费者模型,生产者发送任务到消息队列,消费者负责处理任务。

Celery侧重于实时操作,但对调度支持也很好,其每天可以处理数以百万计的任务。

特点

简单:熟悉celery的工作流程后,配置使用简单 高可用:当任务执行失败或执行过程中发生连接中断,celery会自动尝试重新执行任务 快速:一个单进程的celery每分钟可处理上百万个任务 灵活:几乎celery的各组件都可以被扩展及自定制

工作原理

Celery由以下三部分构成:消息中间件(Broker)、任务执行单元Worker、结果存储(Backend)

工作原理:任务模块Task包含异步任务和定时任务。 其中,异步任务通常在业务逻辑中被触发并发往消息队列,而定时任务由Celery Beat进程周期性地将任务发往消息队列; 任务执行单元Worker实时监视消息队列获取队列中的任务执行; Woker执行完任务后将结果保存在Backend中;

- 消息中间件Broker,消息中间件Broker官方提供了很多备选方案,支持RabbitMQ、Redis、Amazon SQS、MongoDB、Memcached 等,官方推荐RabbitMQ。

- 任务执行单元Worker,Worker是任务执行单元,负责从消息队列中取出任务执行,它可以启动一个或者多个,也可以启动在不同的机器节点,这就是其实现分布式的核心。

- 结果存储Backend,Backend结果存储官方也提供了诸多的存储方式支持:RabbitMQ、 Redis、Memcached,SQLAlchemy, Django ORM、Apach

安装:

pip install celery实践案例

"""

异步任务执行文件:celery_task.py

消费者模型

"""

import celery

import time

# task.py

import os

os.environ.setdefault('FORKED_BY_MULTIPROCESSING', '1')

backend='redis://127.0.0.1:6379/1'

broker='redis://127.0.0.1:6379/2'

cel=celery.Celery('test',backend=backend,broker=broker)

@cel.task

def send_email(name):

print("向%s发送邮件..."%name)

time.sleep(5)

print("向%s发送邮件完成"%name)

return "ok"

@cel.task

def send_msg(name):

print("向%s发送短信..."%name)

time.sleep(5)

print("向%s发送短信完成"%name)

return "ok"

""""

执行任务文件: produce_task.py

生成者模型

"""

from celery_task import send_email,send_msg

result = send_email.delay("yuan") # 当执行delay函数时会自动调用消息中间件的任务执行队列,放到任务执行单元中

print(result.id)

result = send_msg.delay("alex")

print(result.id)先启动redis进程

使用特定命令下发指令执行celery任务:

(注意celery5.0之前的命令是不一样的:celery worker -A celery_task -l info)

先执行produce_task.py

返回ID:

fd27bc20-ccac-4855-9b3d-150708bad2a6

c07cb5b1-845a-44c4-963b-7ce3f92b98c8

检查celery的异步队列查看执行结果

注:当遇到以下情况

The above exception was the direct cause of the following exception:

Traceback (most recent call last):

File "D:\python3\lib\site-packages\billiard\pool.py", line 361, in workloop

result = (True, prepare_result(fun(*args, **kwargs)))

File "D:\python3\lib\site-packages\celery\app\trace.py", line 664, in fast_trace_task

tasks, accept, hostname = _loc

ValueError: not enough values to unpack (expected 3, got 0)

[2024-02-24 15:31:20,394: ERROR/MainProcess] Task handler raised error: ValueError('not enough values to unpack (expected 3, got 0)')解决方法:

在消费者模型中添加以下代码

import os os.environ.setdefault('FORKED_BY_MULTIPROCESSING', '1')

查看异步执行的结果:

"""

查看任务执行结果: result.py

"""

from celery.result import AsyncResult

from celery_task import cel

async_result=AsyncResult(id="fd27bc20-ccac-4855-9b3d-150708bad2a6", app=cel)

if async_result.successful():

result = async_result.get()

print(result)

# result.forget() # 将结果删除

elif async_result.failed():

print('执行失败')

elif async_result.status == 'PENDING':

print('任务等待中被执行')

elif async_result.status == 'RETRY':

print('任务异常后正在重试')

elif async_result.status == 'STARTED':

print('任务已经开始被执行')

# 运行结果是上面执行返回的结果:

ok celery多任务结构下异步执行:注意celery_tasks的celery名字是固定,不然会报错

# celery

from celery import Celery

cel = Celery('celery_demo',

broker='redis://127.0.0.1:6379/1',

backend='redis://127.0.0.1:6379/2',

# 包含以下两个任务文件,去相应的py文件中找任务,对多个任务做分类

include=['celery_tasks.task01',

'celery_tasks.task02'

])

# 时区

cel.conf.timezone = 'Asia/Shanghai'

# 是否使用UTC

cel.conf.enable_utc = False

# task01

import time

from .celery import cel

@cel.task

def send_email(res):

time.sleep(5)

return "完成向%s发送邮件任务"%res

# task02

import time

from .celery import cel

@cel.task

def send_msg(name):

time.sleep(5)

return "完成向%s发送短信任务"%name

# """"

执行任务文件: produce_task.py 和上面的celery_task保持在同一级目录

生成者模型

"""

from celery_tasks.task01 import send_email

from celery_tasks.task02 import send_msg

# 立即告知celery去执行test_celery任务,并传入一个参数

result = send_email.delay('yuan')

print(result.id)

result = send_msg.delay('yuan')

print(result.id)E:\desktop\my_drf\celerypro>celery -A celery_tasks worker -l info -P eventlet运行结果:

定时任务的配置:

# 更新produce_task 文件,增加定时任务

from celery_task import send_email

from datetime import datetime

# 方式一

# v1 = datetime(2020, 3, 11, 16, 19, 00)

# print(v1)

# v2 = datetime.utcfromtimestamp(v1.timestamp())

# print(v2)

# result = send_email.apply_async(args=["egon",], eta=v2) # 定时任务

# print(result.id)

# 方式二

ctime = datetime.now()

# 默认用utc时间

utc_ctime = datetime.utcfromtimestamp(ctime.timestamp())

from datetime import timedelta

time_delay = timedelta(seconds=10) # 当时时间10s后执行任务

task_time = utc_ctime + time_delay

# 使用apply_async并设定时间

result = send_email.apply_async(args=["egon"], eta=task_time)

print(result.id)

# 更新setting

cel.conf.beat_schedule = {

# 名字随意命名

'add-every-10-seconds': {

# 执行tasks1下的test_celery函数

'task': 'celery_tasks.task01.send_email',

# 每隔2秒执行一次

# 'schedule': 1.0,

# 'schedule': crontab(minute="*/1"),

'schedule': timedelta(seconds=6),

# 传递参数

'args': ('张三',)

},

# 'add-every-12-seconds': {

# 'task': 'celery_tasks.task01.send_email',

# 每年4月11号,8点42分执行

# 'schedule': crontab(minute=42, hour=8, day_of_month=11, month_of_year=4),

# 'args': ('张三',)

# },

} 运行结果:

根据上述配置每6s执行task01发送邮件任务

注意:

# 周期性执行任务单元,要注意先启动beat进程而后执行worker单元

E:\desktop\my_drf\celerypro>celery -A celery_tasks beat

E:\desktop\my_drf\celerypro>celery -A celery_tasks worker -l info -P eventlet

注意: 当打开beat后而若没有打开worker执行单元会导致beat进程不断向数据库中加入数据

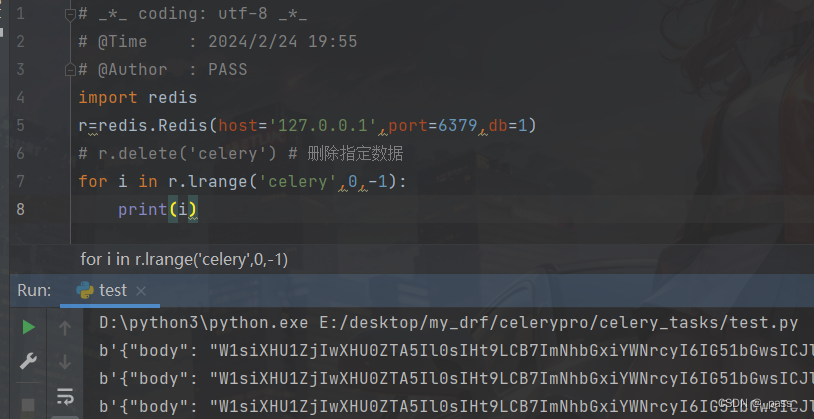

查看redis堆积的数据方法:cmd命令如下

python脚本实现:

celery结合django中集成的运用

# tasks

# celery的任务必须写在tasks.py的文件中,别的文件名称不识别!!!

from mycelery.main import app

import time

import logging

log = logging.getLogger("django")

@app.task # name表示设置任务的名称,如果不填写,则默认使用函数名做为任务名

def send_sms(mobile):

"""发送短信"""

print("向手机号%s发送短信成功!"%mobile)

time.sleep(5)

return "send_sms OK"

@app.task # name表示设置任务的名称,如果不填写,则默认使用函数名做为任务名

def send_sms2(mobile):

print("向手机号%s发送短信成功!" % mobile)

time.sleep(5)

return "send_sms2 OK"

# config

broker_url = 'redis://127.0.0.1:6379/15'

result_backend = 'redis://127.0.0.1:6379/14'

# main

# 主程序

import os

from celery import Celery

# 创建celery实例对象

app = Celery("sms")

# import os

os.environ.setdefault('FORKED_BY_MULTIPROCESSING', '1') # 注意: 默认配置要这样配置,下列的配置会找不到组件导致失败

# 把celery和django进行组合,识别和加载django的配置文件

# os.environ.setdefault('DJANGO_SETTINGS_MODULE', 'celerypro.settings.dev')

# os.environ.setdefault("DJANGO_SETTINGS_MODULE", "config.settings.local")

# 通过app对象加载配置

app.config_from_object("mycelery.config")

# 加载任务

# 参数必须必须是一个列表,里面的每一个任务都是任务的路径名称

# app.autodiscover_tasks(["任务1","任务2"])

app.autodiscover_tasks(["mycelery.sms",])

# view

from django.shortcuts import render,HttpResponse

from mycelery.sms.tasks import send_sms,send_sms2

from datetime import timedelta

from datetime import datetime

def test(request):

################################# 异步任务

# 1. 声明一个和celery一模一样的任务函数,但是我们可以导包来解决

send_sms.delay("110")

send_sms2.delay("119")

# send_sms.delay() # 如果调用的任务函数没有参数,则不需要填写任何内容

################################# 定时任务

ctime = datetime.now()

# 默认用utc时间

utc_ctime = datetime.utcfromtimestamp(ctime.timestamp())

time_delay = timedelta(seconds=3) # 3s 发送消息

task_time = utc_ctime + time_delay

result = send_sms.apply_async(["911", ], eta=task_time)

print(result.id)

return HttpResponse('ok')

启动Celery的命令

# 强烈建议切换目录到mycelery根目录下启动

# E:\desktop\my_drf\celerypro>celery -A mycelery.main worker --loglevel=info运行结果:

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?