基本概念:

-

ApacheHadoopYARN(YetAnotherResourceNegotiator,另一种资源协调者)是一种新的Hadoop资源管理器,它是一个通用资源管理系统,可为上层应用提供统一的资源管理和调度,它的引入为集群在利用率、资源统一管理和数据共享等方面带来了巨大好处。

-

YARN的基本思想是将JobTracker的两个主要功能(资源管理和作业调度/监控)分离,主要方法是创建一个全局的ResourceManager(RM)和若干个针对应用程序的ApplicationMaster(AM)。这里的应用程序是指传统的MapReduce作业或作业的DAG(有向无环图)。

-

YARN 分层结构的本质是 ResourceManager。这个实体控制整个集群并管理应用程序向基础计算资源的分配。ResourceManager 将各个资源部分(计算、内存、带宽等)精心安排给基础 NodeManager(YARN 的每节点代理)。ResourceManager 还与 ApplicationMaster 一起分配资源,与 NodeManager 一起启动和监视它们的基础应用程序。在此上下文中,ApplicationMaster 承担了以前的 TaskTracker 的一些角色,ResourceManager 承担了 JobTracker 的角色。

-

ApplicationMaster 管理一个在 YARN 内运行的应用程序的每个实例。ApplicationMaster 负责协调来自 ResourceManager 的资源,并通过 NodeManager 监视容器的执行和资源使用(CPU、内存等的资源分配)。请注意,尽管目前的资源更加传统(CPU 核心、内存),但未来会带来基于手头任务的新资源类型(比如图形处理单元或专用处理设备)。从 YARN 角度讲,ApplicationMaster 是用户代码,因此存在潜在的安全问题。YARN 假设 ApplicationMaster 存在错误或者甚至是恶意的,因此将它们当作无特权的代码对待。

-

NodeManager 管理一个 YARN 集群中的每个节点。NodeManager 提供针对集群中每个节点的服务,从监督对一个容器的终生管理到监视资源和跟踪节点健康。MRv1 通过插槽管理 Map 和 Reduce 任务的执行,而 NodeManager 管理抽象容器,这些容器代表着可供一个特定应用程序使用的针对每个节点的资源。YARN 继续使用 HDFS 层。它的主要 NameNode 用于元数据服务,而 DataNode 用于分散在一个集群中的复制存储服务。

-

要使用一个 YARN 集群,首先需要来自包含一个应用程序的客户的请求。ResourceManager 协商一个容器的必要资源,启动一个 ApplicationMaster 来表示已提交的应用程序。通过使用一个资源请求协议,ApplicationMaster 协商每个节点上供应用程序使用的资源容器。执行应用程序时,ApplicationMaster 监视容器直到完成。当应用程序完成时,ApplicationMaster 从 ResourceManager 注销其容器,执行周期就完成了。

-

yarn的优点

(1)大大减小了 JobTracker(也就是现在的 ResourceManager)的资源消耗,并且让监测每一个 Job 子任务 (tasks) 状态的程序分布式化了,更安全、更优美

(2)在新的 Yarn 中,ApplicationMaster 是一个可变更的部分,用户可以对不同的编程模型写自己的 AppMst,让更多类型的编程模型能够跑在 Hadoop 集群中,可以参考 hadoop Yarn 官方配置模板中的 mapred-site.xml 配置

(3)对于资源的表示以内存为单位 ( 在目前版本的 Yarn 中,没有考虑 cpu 的占用 ),比之前以剩余 slot 数目更合理。

(4)老的框架中,JobTracker 一个很大的负担就是监控 job 下的 tasks 的运行状况,现在,这个部分就扔给 ApplicationMaster 做了,而 ResourceManager 中有一个模块叫做 ApplicationsMasters( 注意不是 ApplicationMaster),它是监测 ApplicationMaster 的运行状况,如果出问题,会将其在其他机器上重启。

(5)Container 是 Yarn 为了将来作资源隔离而提出的一个框架。这一点应该借鉴了 Mesos 的工作,目前是一个框架,仅仅提供 java 虚拟机内存的隔离,hadoop 团队的设计思路应该后续能支持更多的资源调度和控制 , 既然资源表示成内存量,那就没有了之前的 map slot/reduce slot 分开造成集群资源闲置的尴尬情况。 -

YARN的核心思想:将JobTracker和TaskTacker进行分离它由下面几大构成组件:

- 一个全局的资源管理器 ResourceManager(RM是一个全局的资源管理器,负责整个系统的资源管理和分配。它主要由两个组件构成:调度器(Scheduler)和应用程序管理器(Applications Manager,ASM))

- ResourceManager的每个节点代理 NodeManager(NM是每个节点上的资源和任务管理器)

- 表示每个应用的 ApplicationMaster(用户提交的每个应用程序均包含一个AM,主要功能包括:与RM调度器协商以获取资源(用Container表示);将得到的任务进一步分配给内部的任务(资源的二次分配);与NM通信以启动/停止任务;监控所有任务运行状态,并在任务运行失败时重新为任务申请资源以重启任务)

- 每一个ApplicationMaster拥有多个Container在NodeManager上运行(Container是YARN中的资源抽象,它封装了某个节点上的多维度资源,如内存、CPU、磁盘、网络等,当AM向RM申请资源时,RM为AM返回的资源便是用Container表示。YARN会为每个任务分配一个Container,且该任务只能使用该Container中描述的资源。)

yarn集群管理器的配置过程

1.保证hadoop集群是正常的,每个节点jps查看一下

server1:

[hadoop@server1 hadoop]$ jps

3185 SecondaryNameNode

2997 NameNode

3318 Jps

server2:

[hadoop@server2 ~]$ jps

2421 DataNode

2453 Jps

server3:

[hadoop@server3 ~]$ jps

2468 Jps

2415 DataNode

server4:

[hadoop@server4 ~]$ jps

2476 Jps

2415 DataNode

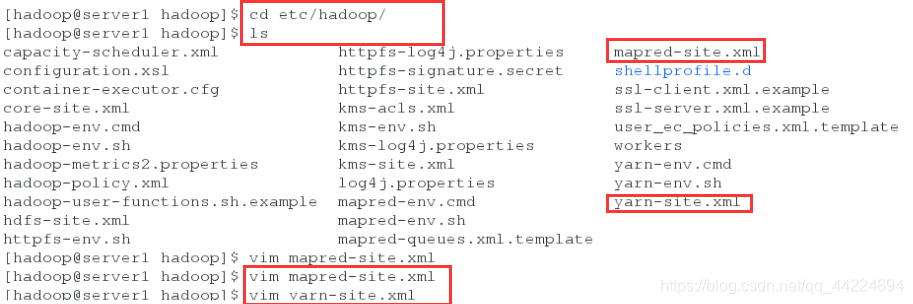

2.切换到/hadoop/hadoop/etc/hadoop目录,编辑配置文件

cd etc/hadoop/

[hadoop@server1 hadoop]$ cd etc/hadoop/

[hadoop@server1 hadoop]$ vim mapred-site.xml

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

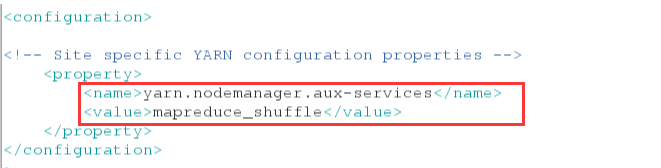

[hadoop@server1 hadoop]$ vim yarn-site.xml

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

[hadoop@server1 hadoop]$ pwd

/home/hadoop/hadoop/etc/hadoop

3.开启服务,每个节点jps查看

server1

[hadoop@server1 ~]$ cd hadoop

[hadoop@server1 hadoop]$ sbin/start-yarn.sh

Starting resourcemanager

Starting nodemanagers

[hadoop@server1 hadoop]$ jps

3185 SecondaryNameNode

2997 NameNode

3575 Jps

3455 ResourceManager

server2:

[hadoop@server2 ~]$ jps

12145 Jps

2421 DataNode

12078 NodeManager

server3:

[hadoop@server3 ~]$ jps

12073 NodeManager

12173 Jps

2415 DataNode

server4:

[hadoop@server4 ~]$ jps

2640 Jps

2540 NodeManager

2415 DataNode

配置文件中的内容:**

bin/hdfs --daemon start journalnode

<property>

<name>yarn.resourcemanager.ha.enabled</name>

<value>true</value>

</property>

<property>

<name>yarn.resourcemanager.cluster-id</name>

<value>RM_CLUSTER</value>

</property>

<property>

<name>yarn.resourcemanager.ha.rm-ids</name>

<value>rm1,rm2</value>

</property>

<property>

<name>yarn.resourcemanager.hostname.rm1</name>

<value>172.25.19.1</value>

</property>

<property>

<name>yarn.resourcemanager.hostname.rm2</name>

<value>172.25.19.5</value>

</property>

<property>

<name>yarn.resourcemanager.recovery.enabled</name>

<value>true</value>

</property>

<property>

<name>yarn.resourcemanager.store.class</name>

<value>org.apache.hadoop.yarn.server.resourcemanager.recovery.ZKRMStateStore<value>

</property>

<property>

<name>yarn.resourcemanager.zk-address</name>

<value>172.25.19.2:2181,172.25.19.3:2181,172.25.19.4:2181<value>

</property>

(未完待续~)

Apache Hadoop YARN是一种资源管理器,将JobTracker的资源管理和作业调度分离,形成ResourceManager、ApplicationMaster和NodeManager三层结构。ResourceManager全局管理集群资源,ApplicationMaster负责应用程序资源协调,NodeManager管理节点资源。YARN通过Container实现资源抽象,提高集群利用率,支持更多编程模型,并具备容错能力。YARN的配置和管理涉及多步骤,确保集群正常运行。

Apache Hadoop YARN是一种资源管理器,将JobTracker的资源管理和作业调度分离,形成ResourceManager、ApplicationMaster和NodeManager三层结构。ResourceManager全局管理集群资源,ApplicationMaster负责应用程序资源协调,NodeManager管理节点资源。YARN通过Container实现资源抽象,提高集群利用率,支持更多编程模型,并具备容错能力。YARN的配置和管理涉及多步骤,确保集群正常运行。

1351

1351

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?