1.问题

最近有一些很大csv文件需要处理,有的会有500万行以上,但是wps等都无法完全显示,并显示如下错误。

2. 解决方法

如果仅仅想做一些比如查询等比较简单的操作,可以使用 linux 中的 vim 软件打开

使用如下命令打开csv文件

vim 文件名称.csv3. 一些简单操作

3.1 显示行号

1. 确保您处于命令模式。您可以通过按 Escape (Esc) 键切换到命令模式。

2. 按“:”(冒号)键。Vim 的左下角应该有冒号字符。现在输入“set number”,或者您可以输入“set nu”(简称)并按“ Enter ”键。

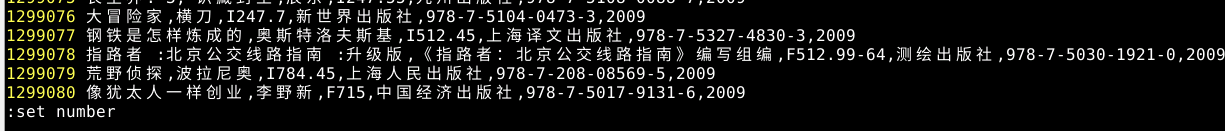

这样我们就可以看到数据在第几行

:set number

3.2 跳转行数

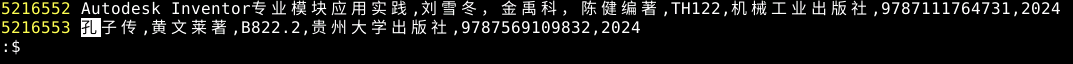

跳转到最后一行,这样就可以看到文件到底有多少行

:$

跳转到首行

:13.3 查找文本

| 快捷键 | 功能描述 |

| /abc | 从光标所在位置向前查找字符串 abc |

| /^abc | 查找以 abc 为行首的行 |

| /abc$ | 查找以 abc 为行尾的行 |

| ?abc | 从光标所在为主向后查找字符串 abc |

| n | 向同一方向重复上次的查找指令 |

| N | 向相反方向重复上次的查找指定 |

3.4 保存和退出文本

![]()

4.遇到的问题

有的文件可能含有中文会出现乱码,解决方法如下

先指定字符集的方式打开文件,一般来说指定GB2312或者GB18030。看下是否出现乱码,如果没有中文乱码,那么恭喜。

vi 文件名称 -c "e ++enc=GB2312"

vi 文件名称 -c "e ++enc=GB18030"然后将文件保存为utf-8(一般都是utf-8编码),如果要转换编码并且保存,记得使用 :w 命令。

文件内容...

~

~

:set fileencoding=utf-8参考文章以及更多vim操作参考:

1227

1227

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?