暂时无法在飞书文档外展示此内容

零、泛化性

-

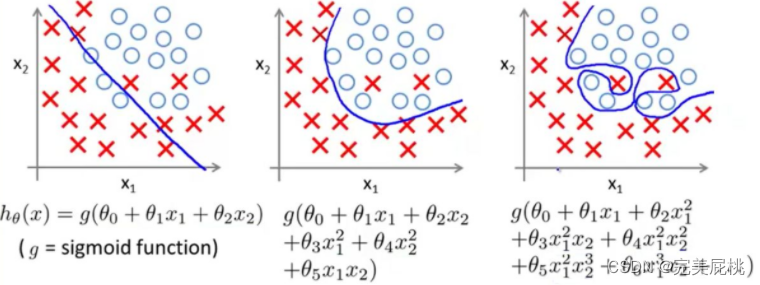

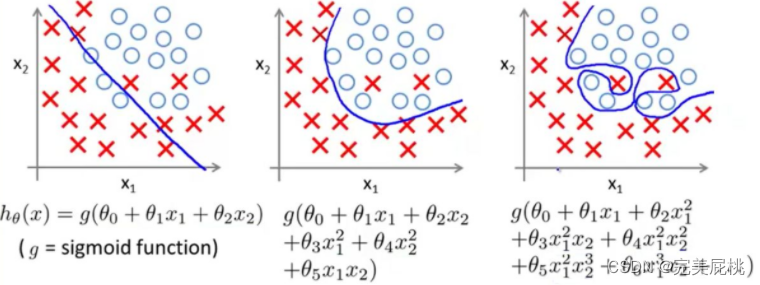

泛化性指模型经过训练后,应用到新数据并做出准确预测的能力。一个模型在训练数据上经常被训练得太好即过拟合,以致无法泛化。

深度学习模型过拟合的原因,不仅仅是数据原因:

-

模型复杂度过高:如果模型具有过多的参数或层次,它可以很容易地记住训练数据的细节,但却不能泛化到新的数据上。这会导致模型在测试数据上表现不佳。

暂时无法在飞书文档外展示此内容

泛化性指模型经过训练后,应用到新数据并做出准确预测的能力。一个模型在训练数据上经常被训练得太好即过拟合,以致无法泛化。

深度学习模型过拟合的原因,不仅仅是数据原因:

模型复杂度过高:如果模型具有过多的参数或层次,它可以很容易地记住训练数据的细节,但却不能泛化到新的数据上。这会导致模型在测试数据上表现不佳。

1329

1329

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?