🚀 优质资源分享 🚀

| 学习路线指引(点击解锁) | 知识定位 | 人群定位 |

|---|---|---|

| 🧡 Python实战微信订餐小程序 🧡 | 进阶级 | 本课程是python flask+微信小程序的完美结合,从项目搭建到腾讯云部署上线,打造一个全栈订餐系统。 |

| 💛Python量化交易实战💛 | 入门级 | 手把手带你打造一个易扩展、更安全、效率更高的量化交易系统 |

14 TEMPORAL GRAPH NETWORKS FOR DEEP LEARNING ON DYNAMIC GRAPHS

Abstract

提出了时间图网络(TGNs),一个通用的,有效的框架,在动态图上的深度学习表示为时序事件序列。由于记忆模块和基于图的操作的新颖组合,TGN在计算效率更高的同时,显著优于以前的方法。

Conclusion

本文介绍了连续时间动态图学习的通用框架TGN。我们在多个任务和数据集上获得了最先进的结果,同时比以前的方法更快。

详细的消融研究表明,记忆及其相关模块对存储长期信息的重要性,以及基于图的嵌入模块对生成最新节点嵌入的重要性。

Figure and table

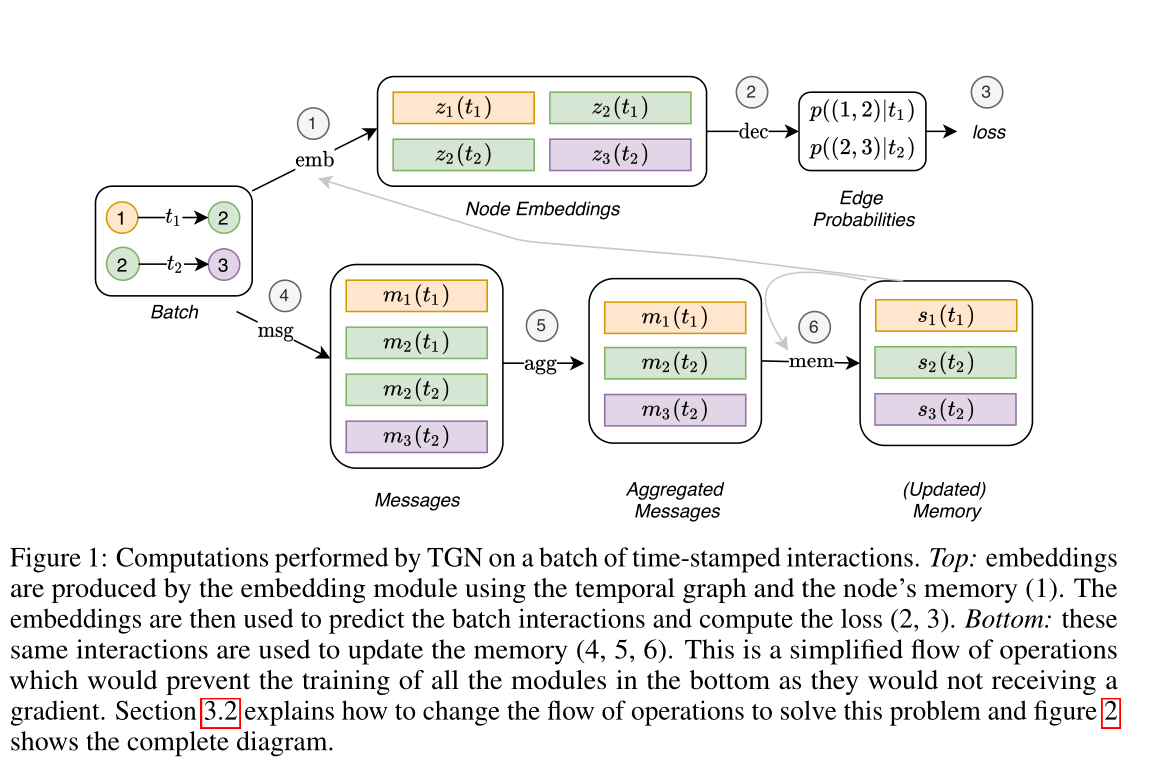

图1 由TGN对一批带时间戳的交互进行的计算。上方:嵌入由嵌入模块使用时间图和节点的记忆(1)产生。然后,嵌入用于预测批量交互和计算损失(2,3)。下方:这些相同的交互用于更新内存(4,5,6)。这是一个简化的操作流程,将防止下方所有模块的训练,因为它们不会接收到梯度。第3.2节解释了如何更改操作流程以解决此问题,图2显示了完整的关系图。

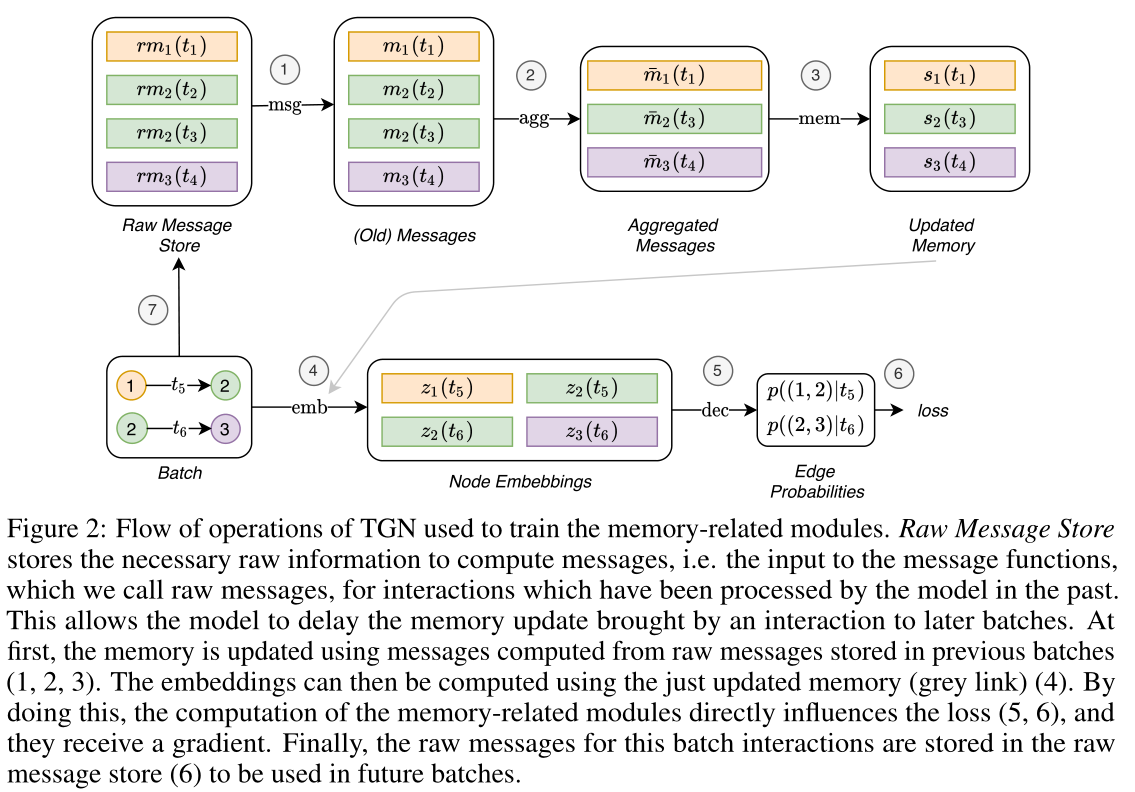

图2:TGN用于训练记忆相关模块的操作流程。原始消息存储(Raw Message Store)存储计算消息所需的原始信息,即消息函数的输入,我们称之为原始消息,用于模型过去处理过的交互。

这允许模型将交互带来的记忆更新延迟到以后的批处理中。首先,使用从前几批(1,2,3)中存储的原始消息计算出来的消息更新内存。然后,可以使用刚刚更新的记忆(灰色箭头)计算嵌入(4)。通过这样做,记忆相关模块的计算直接影响损失(5,6)。最后,用于此批处理交互的原始消息存储在原始消息存储(7)中,以便在未来的批处理中使用。

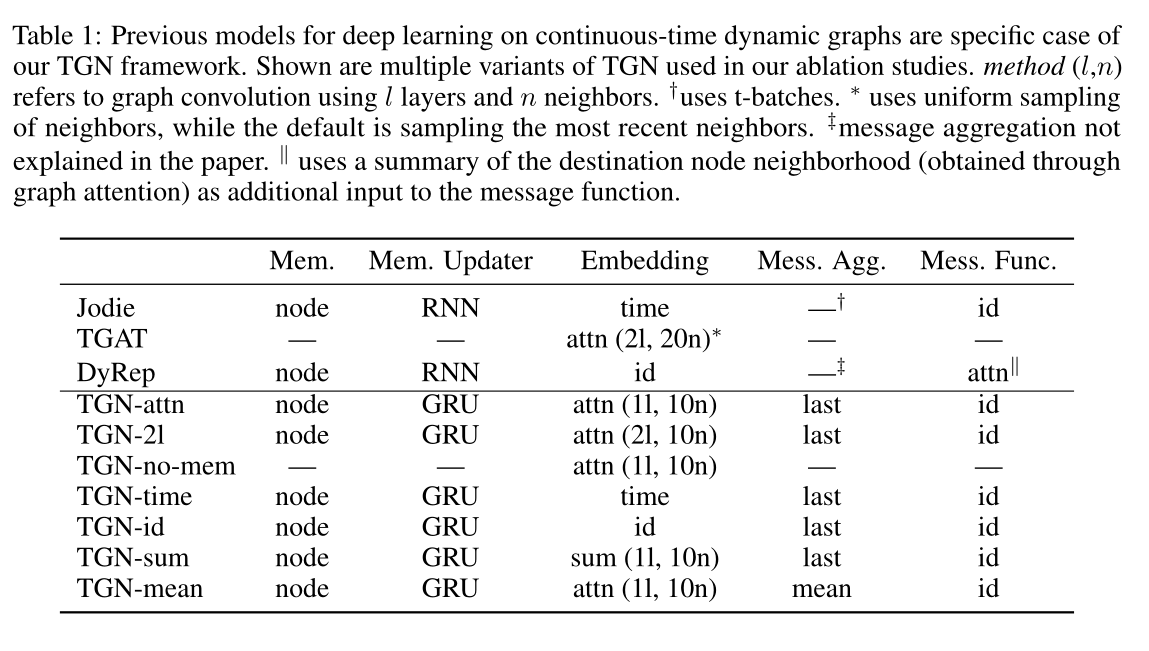

表1 以往的连续时间动态图深度学习模型都是TGN框架的具体案例。图中显示的是消融研究中使用的多种TGN变体。method(l,n)是指使用l层和n个邻居的图卷积。††使用t-batch。∗∗使用邻居的均匀抽样,而默认是抽样最近的邻居。‡‡表示本文中没有解释消息聚合。||||表示使用目标节点邻域的求和(通过图注意力获得)作为消息函数的附加输入。

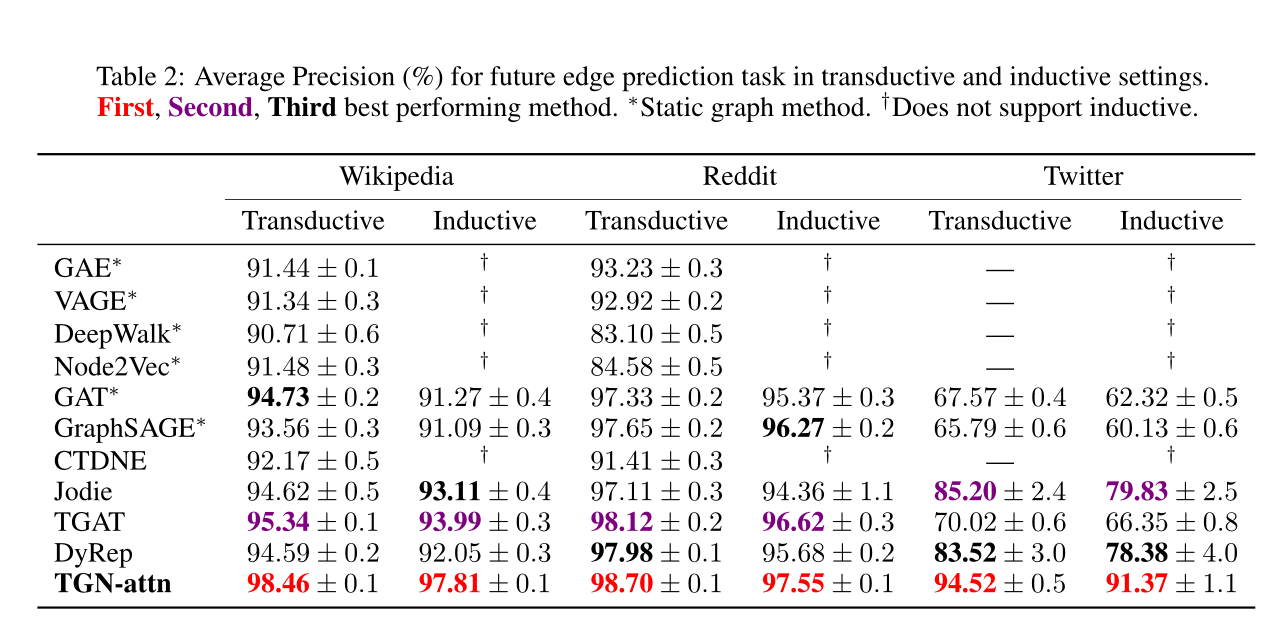

表2:在transductive和inductive设置下,未来边缘

本文提出了时间图网络(TGNs),一个用于动态图深度学习的高效框架,尤其适用于处理时序事件序列。TGN通过结合记忆模块和图操作,解决了效率问题并超越了现有方法。实验表明,TGN在多个任务和数据集上取得了最先进的结果,且运行速度更快。此外,研究还探讨了不同模块的重要性,特别是在存储长期信息和生成最新节点嵌入方面。

本文提出了时间图网络(TGNs),一个用于动态图深度学习的高效框架,尤其适用于处理时序事件序列。TGN通过结合记忆模块和图操作,解决了效率问题并超越了现有方法。实验表明,TGN在多个任务和数据集上取得了最先进的结果,且运行速度更快。此外,研究还探讨了不同模块的重要性,特别是在存储长期信息和生成最新节点嵌入方面。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5536

5536

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?