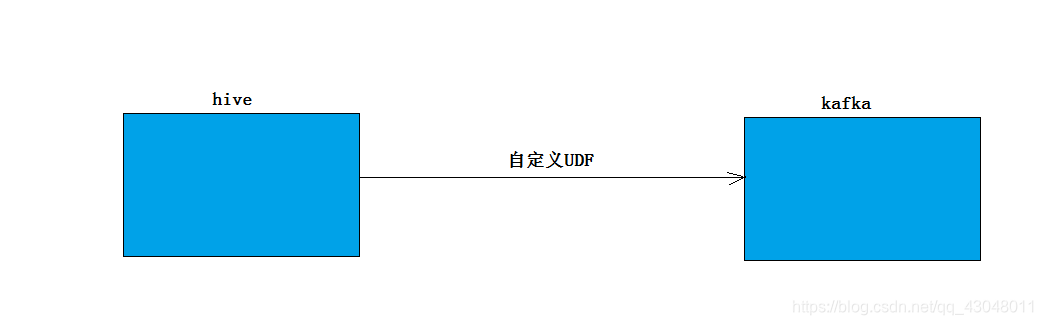

背景:数据存在hive中,现在需要将数据导入kafka中,为了减少中间环节,使用自定义UDF将hive数据导入到kafka中

- 问题:UDF时对一行的处理,批量导入就会涉及多行的问题,怎么将多行数据放到一个udf中?

- 解决思路:用collect_list函数将多行转成集合,在udf中循环遍历,发送到kafka

代码

package cn.kobold;

import org.apache.hadoop.hive.ql.exec.Description;

import org.apache.hadoop.hive.ql.exec.UDFArgumentException;

import org.apache.hadoop.hive.ql.metadata.HiveException;

import org.apache.hadoop.hive.ql.udf.generic.GenericUDF;

import org.apache.hadoop.hive.serde2.objectinspector.*;

import org.apache.hadoop.hive.serde2.objectinspector.ObjectInspector.Category;

import org.apache.hadoop.hive.serde2.objectinspector.primitive.PrimitiveObjectInspectorFactory;

import org.apache.hadoop.io.IntWritable;

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.Producer;

本文介绍了如何利用自定义UDF将Hive中的数据批量导入到Kafka。通过使用collect_list函数将多行数据转换为集合,并在UDF内部循环遍历发送到Kafka,减少了数据迁移的中间步骤。

本文介绍了如何利用自定义UDF将Hive中的数据批量导入到Kafka。通过使用collect_list函数将多行数据转换为集合,并在UDF内部循环遍历发送到Kafka,减少了数据迁移的中间步骤。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5万+

5万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?