初学Hadoop,学习过程遇到很多问题,也总结了解决办法!

很简单,有日志首先看日志,没日志的就要看配置了

今天遇到奇怪的事情,昨天搭建的伪分布式运行Hadoop平台,今天重新运行就出毛病了(datanode出现自动关闭)

查看datanode日志找出问题

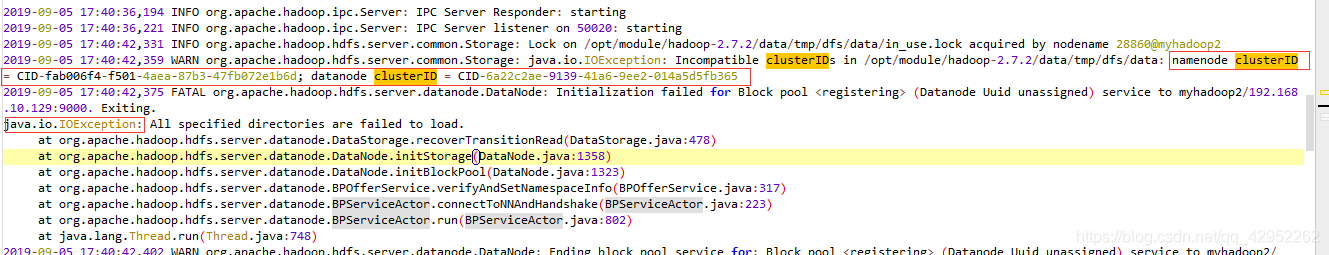

查看日志如下:

从日志上看,框起来的说明了问题

datanode的clusterID 和 namenode的clusterID 不匹配。

解决办法:

根据日志中的路径,cd /home/hadoop/tmp/dfs

能看到 data和name两个文件夹,

将name/current下的VERSION中的clusterID复制到data/current下的VERSION中,覆盖掉原来的clusterID

让两个保持一致

然后重启,启动后执行jps,查看进程

20449 NodeManager

19776 NameNode

21123 Jps

19918 DataNode

20305 ResourceManager

出现该问题的原因:在第一次格式化dfs后,启动并使用了hadoop,后来又重新执行了格式化命令(hdfs namenode -format),这时namenode的clusterID会重新生成,而datanode的clusterID 保持不变

初学者在Hadoop伪分布式环境中遇到datanode自动关闭的问题,通过检查日志发现datanode和namenode的clusterID不匹配。解决方法是同步两个节点的clusterID,保持一致,然后重启服务,问题得到解决。

初学者在Hadoop伪分布式环境中遇到datanode自动关闭的问题,通过检查日志发现datanode和namenode的clusterID不匹配。解决方法是同步两个节点的clusterID,保持一致,然后重启服务,问题得到解决。

1426

1426

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?