在开发java SparkStreaming的时候一定会遇到kafka偏移量管理的问题上,因为需要考虑到各式各样的容灾处理。如果我们采用kafka来自行处理kafka偏移量的话非常简单,因为kafka本身就有这个机制可以定时存储消费者分组的偏移量,但是这样会有重复消费的情况还有就是如果采用这种方式那么就是将kafka的offset全部交给kafka管理,本人在这里是不太推荐的,因为如果是要做大数据的情况下,那么kafka的的数据其实也是内存和磁盘存储的,如果数据量上来了,无疑也是对kafka集群的一种压力。因为我们项目在实际开发中的时候,遇到数据峰值很高的时候kafka集群的磁盘io是特别高的这样是非常不安全的。还有就是我们的计算任务也是不允许有重复计算这样操作出现,但是在项目初期可以存在。所以我们决定先使用spark本身的checkpoint来做偏移量管理,尽管这么做确实很多弊端,但是对于项目初期来说也是比较管用的,就是每次更新jar包非常麻烦。之后项目开始渐渐稳定下来了我们开始处理kafka的偏移量问题,接下来我将详细的介绍一下我们对于kafka偏移量的处理过程,这些内容呢对于新手开发我觉得是比较有用的,非常欢迎老鸟来进行批评和改正,开始内容:

对于使用redis存储的好处就是时效性较高而且他还有定时将数据持久化到本地磁盘的机制所以对于我们存储kafka偏移量来说非常合适,因为实时任务对于组件的实时性能有很高的要求,那么redis本身是内存式存储,而且提供给我们那么多的数据结构,非常灵活,而且redis处理百万级别的数据量来说也是没有问题的吗(这里我们用的是reids集群模式一个主两个从所以集群非常稳定)。

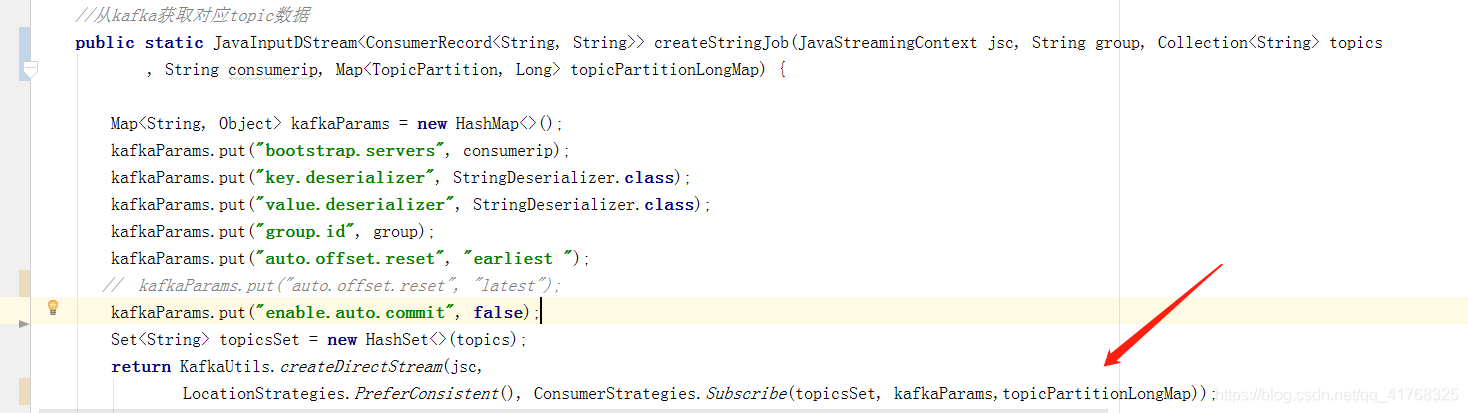

这里呢我们是使用java来编写的sparkstreaming任务,那么接下来我也是用java代码进行介绍。创建Dstream的初始化过程我不多讲了,因为这个东西上网一查一大片,而且这些也不是我们今天主要将的内容我就直接上图吧

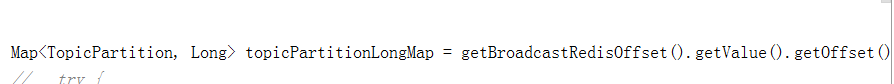

在上图我们可以看到我在创建Dstream的时候参数多放了一个topicPartitionLongMap 而且对于自动存储偏移量的默认值就行了修改变成flase因为我们将自己管理kafka偏移量。那个关于topicPartitionLongMap的参数是我们自己对于kafka便宜量的定义。这个参数怎么来的呢,别急我们慢慢来。

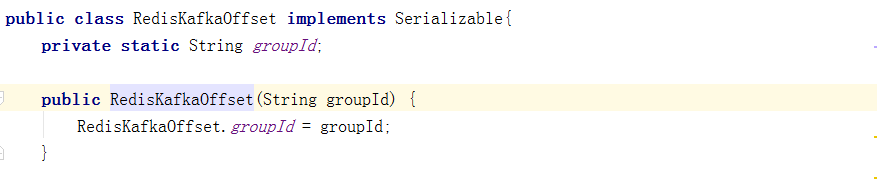

我这里使用spark的广播变量将存储kafka偏移量的redis广播出去,这样是一种对程序的优化,不用每个节点上都保存一份RedisKafkaOffset对象,直接上代码:

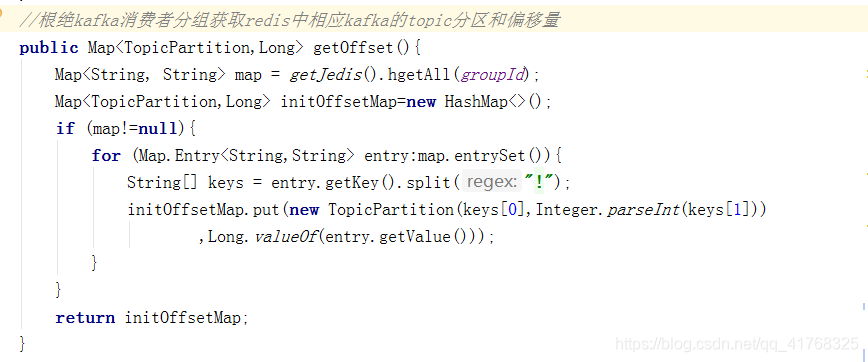

对于redis的链接和初始化我就不做过多的讲解,大家如果可以上网查找一下相关资料。大家看到我对key进行了按!切割了一下,这个是我在往redis提交kafka主题和分区的时候做的key值拼接,之后在更新redis偏移量的时候可以看到我提交的key是什么样子的大家就明白了,keys【0】是当前这个消费者分组消费过的topic,keys【1】是这个topic的分区,value值是这个消费者分组在这个topic的当前分区下的偏移量(offset),我们将一个个关于topic和topic分区的偏移量放进一个map集合。在之后我们初始化DStream的时候我们会用到这个参数来自定义当前的这个消费者需要消费的偏移量是多少。

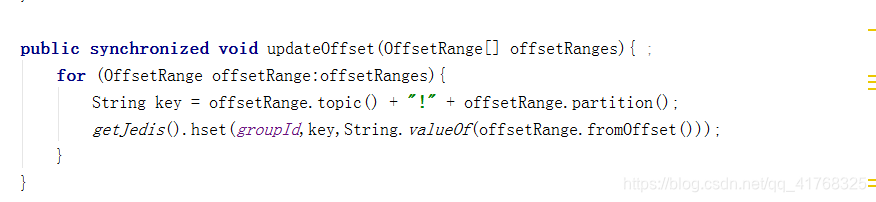

接下来就是向redis中更新offset的代码

大家看到了我在这个方法中传入了一个参数是OffsetRange数组,然后遍历这个数组每一个offsetRange都可以得到他的topic和对应的分区,这里我们传入redis的大key就是消费者分组,然后里面的小key就是我们上面说的用!来分割topic和分区,他的value值就是当前这组数据起始偏移量,spark任务是批次处理数据所以当我们获取到这批任务的开始的时候将起始下标更新到redis,offsetRange.fromOffset() 调用这个方法就是获取当前这个topic的这个分区中开始的偏移量 这个不难理解。

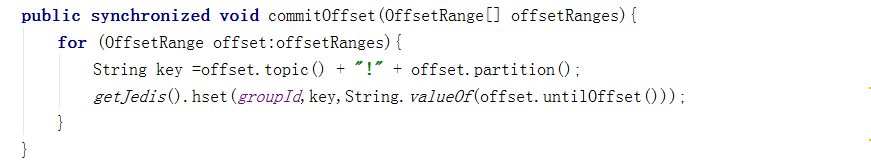

接下来就是向redis中提交处理完这一批次offset的代码

这里我们是将spark任务结束的这一批次offset提交到redis中进行保存,跟上面一样大key,小key的设置,这里的offset.untilOffset()这个方法就是获取这一批次结束的偏移量 这里也是不难理解

这里提一下OffsetRange是获取的哪个包下面: org.apache.spark.streaming.kafka010.OffsetRange

工具写好了,那么我们接下来开始使用这些方法:

当我们初始化kafka信息的时候我建议用auto.offset.reset->earliest 当我们第一次读取kafka消息的时候我们将从第一位下标开始读取数据。

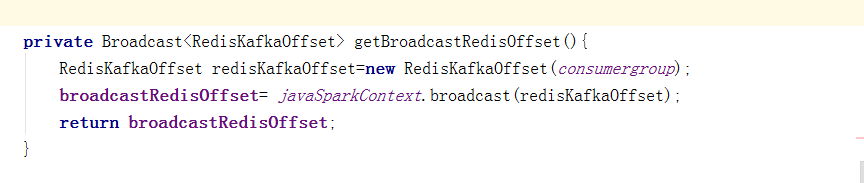

当spark任务初始化任务的时候将我们构建好的RedisKafkaOffset对象广播出去

然后将我们获取到的topicPartitionLongMap传进我们刚才说到的createStringJob方法里面。这样我们就构建好"JavaInputDStream" javaDstream流了。

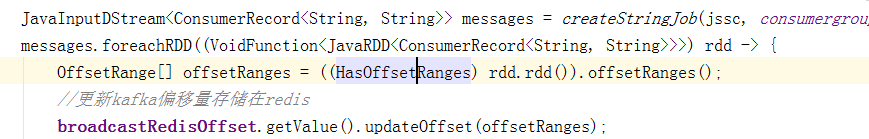

开始我们的spark代码:

当我们进行遍历rdd的时候一定要先把OffsetRange[] offsetRanges = ((HasOffsetRanges) rdd.rdd()).offsetRanges();这行代码放到第一行,然后就可以利用广播遍历进行offset的更新。

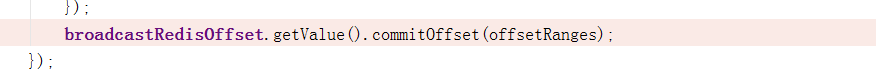

commitOffset这行代码一定是要在foreachRdd的最后执行

好了我们的利用redis对spark消费kafka进行更新kafka的offset这里就结束了,其实这个自己管理offset没有那么复杂的处理逻辑就是利用各个组件之间的api就可以操作,然后在本地和线上测试几下就能完全掌握

-------------------------------------------------------------------关于offset的存储其他方式--------------------------------------------------------------------

如果上网查找存储偏移量方法的时候大多会出现将偏移量存储在zk,hdfs,kafka等中间件,首先kafka刚刚我们已经说过了,现在我们将说说存在zk和hdfs上的问题,如果将offset存储在zk上面,spark程序频繁对zk进行写入操作,那么就会造成zk的io过高,一会的时间zk就会承受不住就是把这个访问关闭,而spark任务也会随之停止。这个问题也是我在开发过程遇到的,如果能用zk固然好,因为zk有一致和稳固的特性,偏移量如果能存在zk中其实是好的但是效率不高,所以就舍弃这种方法了,接下来我将展示spark与zk交互的代码,并带上注解:

别着急会在以后更新

5125

5125

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?