步骤:

1.下载维基百科中文语料

2.使用工具从压缩包中抽取正文文本

3.将繁体字转简体字

4.分词

5.训练模型

6.测试模型

1.下载维基百科中文语料

语料下载地址:https://dumps.wikimedia.org/zhwiki/

有不同时间段的下载地址,我们需要训练词向量,请选择包含articles.xml.bz2字段的链接(包含词条正文)。可以发现有不同大小的包,包越大训练的词向量越精确,训练时间也越长。下载完成后得到一个压缩包,先不要解压,后面用工具进行处理。

这是我下载的语料,161 MB。

这是我下载的语料,161 MB。

2.使用工具从压缩包中抽取正文文本

可以使用Gensim工具包中提供的wiki数据的抽取处理类WikiCorpus,或Wikipedia Extractor脚本文件。

这里使用Wikipedia Extractor从压缩包提取正文文本,Wikipedia Extractor是意大利人用 Python 写的一个维基百科抽取器,使用非常方便。

Wikipedia Extractor下载地址:https://blog.youkuaiyun.com/qq_41648012/article/details/105217726

将里面的代码复制到一个python文件中,命名为WikiExtractor.py

将压缩包zhwiki-20200101-pages-articles1.xml-p1p162886.bz2和抽取器WikiExtractor.py放在同一个文件夹中,使用cmd中cd定位到该文件夹后,使用一下命令提取正文文本:

python WikiExtractor.py -b 500M -o wiki_00 zhwiki-20200101-pages-articles1.xml-p1p162886.bz2

参数说明:

1.WikiExtractor.py里面存放Wikipedia Extractor代码;

2.-b 1000M表示的是以1000M为单位进行切分,有时候可能语料太大,我们可能需要切分成几个小的文件(默认),这里由于我需要处理的包只有161 MB,所以存入一个文件就行了,所以只需要设置的大小比161 MB大即可;

3.wiki_00:需要将提取的文件存放的路径;

4.zhwiki-20200101-pages-articles1.xml-p1p162886.bz2:需要进行提取的.bz2文件的路径;

打开wiki_00文件,发现语料繁体简体字混杂:

3.将繁体字转简体字

使用opencc工具将繁体字转简体字,在下面的链接选择合适的版本,点击下载后解压即可使用。

opencc下载地址:https://bintray.com/package/files/byvoid/opencc/OpenCC

我选择的是opencc-1.0.1-win64.7z版本。将wiki_00文件放入刚刚解压的opencc-1.0.1-win64文件夹中,使用cmd中cd定位到opencc-1.0.1-win64文件夹中,然后执行以下命令:

opencc -i wiki_00 -o zhwiki_jian_zh.txt -c t2s.json

发现多出来zhwiki_jian_zh.txt文件:

4.分词

这里使用jieba分词工具进行分词,执行如下代码:

import jieba.analyse

import codecs

#以写的方式打开原始的简体中文语料库

f=codecs.open('C:\\Users\\28612\\Desktop\\test\\zhwiki_jian_zh.txt','r',encoding="utf8")

#将分完词的语料写入到wiki_jian_zh_seg-189.5.txt文件中

target = codecs.open("C:\\Users\\28612\\Desktop\\test\\wiki_jian_zh_seg-189.5.txt", 'w',encoding="utf8")

print('open files')

line_num=1

line = f.readline()

#循环遍历每一行,并对这一行进行分词操作

#如果下一行没有内容的话,就会readline会返回-1,则while -1就会跳出循环

while line:

print('---- processing ', line_num, ' article----------------')

line_seg = " ".join(jieba.cut(line))

target.writelines(line_seg)

line_num = line_num + 1

line = f.readline()

#关闭两个文件流,并退出程序

f.close()

target.close()

exit()

得到分词文件wiki_jian_zh_seg-189.5.txt:

(可以看出有些英文字母和标点没有去除,有需要的可以去除)

5.训练模型

通过Gensim模块中的word2vec函数来训练语料:

import logging

import os.path

import sys

import multiprocessing

from gensim.models import Word2Vec

from gensim.models.word2vec import LineSentence

if __name__ == '__main__':

logger = logging.getLogger('my')

#1.format: 指定输出的格式和内容,format可以输出很多有用信息,

#%(asctime)s: 打印日志的时间

#%(levelname)s: 打印日志级别名称

#%(message)s: 打印日志信息

logging.basicConfig(format='%(asctime)s: %(levelname)s: %(message)s')

logging.root.setLevel(level=logging.INFO)

#打印这是一个通知日志

logger.info("running %s" % ' '.join(sys.argv))

# check and process input arguments

#inp:分好词的文本

#outp1:训练好的模型

#outp2:得到的词向量

inp='C:\\Users\\28612\\Desktop\\test\\wiki_jian_zh_seg-189.5.txt'

outp1='C:\\Users\\28612\\Desktop\\test\\wiki_zh_jian_text.model'

outp2='C:\\Users\\28612\\Desktop\\test\\wiki_zh_jian_text.vector'

'''

LineSentence(inp):格式简单:一句话=一行; 单词已经过预处理并被空格分隔。

size:是每个词的向量维度;

window:是词向量训练时的上下文扫描窗口大小,窗口为5就是考虑前5个词和后5个词;

min-count:设置最低频率,默认是5,如果一个词语在文档中出现的次数小于5,那么就会丢弃;

workers:是训练的进程数(需要更精准的解释,请指正),默认是当前运行机器的处理器核数。这些参数先记住就可以了。

sg ({0, 1}, optional) – 模型的训练算法: 1: skip-gram; 0: CBOW

alpha (float, optional) – 初始学习率

iter (int, optional) – 迭代次数,默认为5

'''

model = Word2Vec(LineSentence(inp), size=25, window=2, min_count=20, workers=multiprocessing.cpu_count())

model.save(outp1)

model.wv.save_word2vec_format(outp2, binary=False)

inp为分好词的语料;

outp1为训练好的模型存放的文件,需要使用模型时直接从outp1中读取;

outp2为训练好的模型以向量的形式存放在文件中;

代码中相关参数可以自己查资料调整,模型跑了一天一夜。。。

记得把这个改成从不,不然睡一觉起来发现程序没运行

记得把这个改成从不,不然睡一觉起来发现程序没运行

训练好后得到了如下两个文件:

wiki_zh_jian_text.vector:

wiki_zh_jian_text.model:

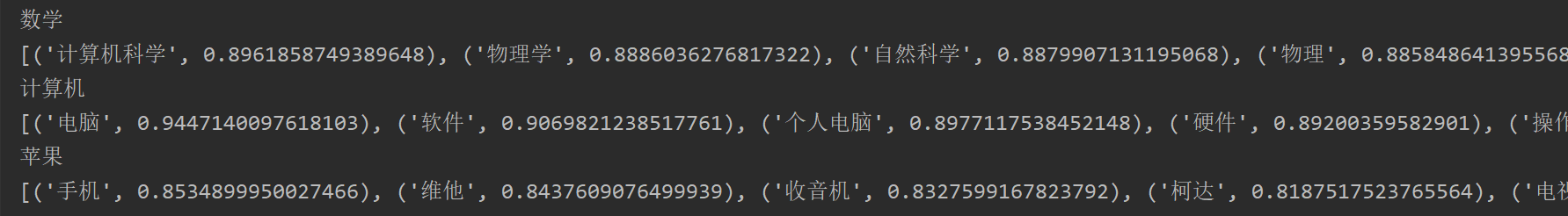

6.测试模型

from gensim.models import Word2Vec

en_wiki_word2vec_model = Word2Vec.load('C:\\Users\\28612\\Desktop\\test\\wiki_zh_jian_text.model')

testwords = ['数学','计算机','苹果']

for i in range(len(testwords)):

res = en_wiki_word2vec_model.most_similar(testwords[i])

print(testwords[i])

print(res)

运行结果:

参考:

维基百科简体中文语料的提取:https://zhuanlan.zhihu.com/p/39960476

使用Gensim模块训练词向量:https://zhuanlan.zhihu.com/p/40016964

438

438

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?