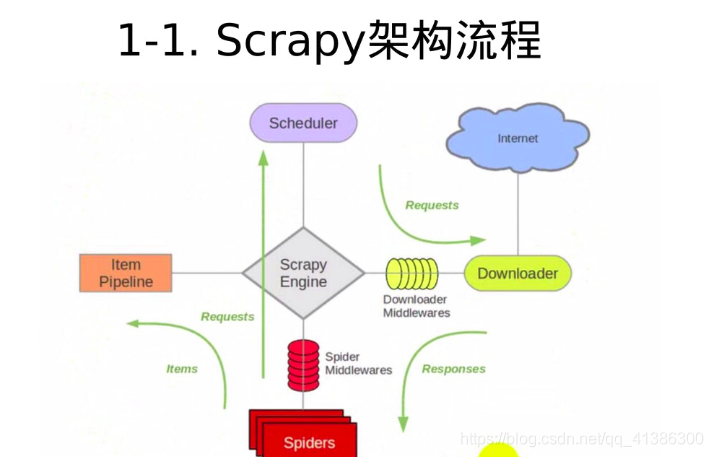

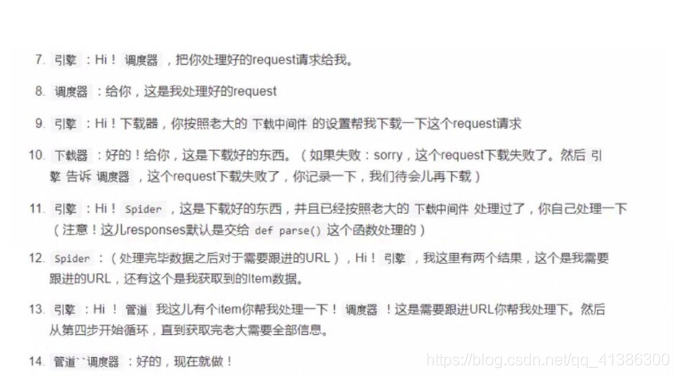

有助于理解的scrapy框架流程

-

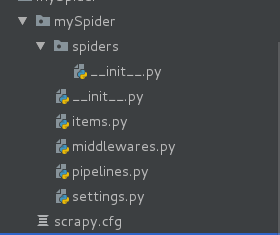

工程创建

scrapy startproject mySpider

创建之后的框架

tree

├── mySpider

│ ├── init.py

│ ├── items.py # 提取的数据信息

│ ├── middlewares.py # 中间键

│ ├── pipelines.py # 管道, 如何存储数据

│ ├── pycache

│ ├── settings.py # 设置信息

│ └── spiders # 爬虫(解析页面的信息)

│ ├── init.py

│ └── pycache

└── scrapy.cfg -

创建一个爬虫

cd mySpider

scrapy genspider mooc “www.imooc.com”

创建之后就会多出一个mooc.py的文件可以开始写我们的爬虫代码了

-

运行

写完代码之后就可以运行了,运行命令:

scrapy crawl mooc

代码案例

1. 首先在item.py里完善你要爬取的数据信息

这里我们爬取的数据是:课程名字,课程链接, 课程的图片url, 课程的名称, 学习人数, 课程描述

需要完善的代码如下:

import scrapy

class MyspiderItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

# 课程名字

title = scrapy.Field()

# 课程的url地址

url = scrapy.Field()

# 课程图片url地址

image_url = scrapy.Field()

# 课程的描述

introduction = scrapy.Field()

# 学习人数

student = scrapy.Field()

下面会说如何应用这些数据

2. 完善爬虫代码mooc.py文件

1.首先修改ia一下你要爬取的网页的url,如果需要修改的话

因为我要爬的是mooc的课程列表的课程信息,所以修改url为’http://www.imooc.com/course/list’

class MoocSpider(scrapy.Spider):

# name: 用于区别爬虫, 必须是唯一的;

name = 'mooc'

# 允许爬取的域名;其他网站的页面直接跳过;

allowed_domains = ['www.imooc.com']

# 也可写多个allowed_domains = ['www.imooc.com', 'img3.mukewang.com']

# 爬虫开启时第一个放入调度器的url地址;

start_urls = ['http://www.imooc.com/course/list']

def parse(self, response):

pass

- 写爬取的数据的代码

这里就要创建刚刚第一步完善的MyspiderItem对象

# 被调用时, 每个初始url完成下载后, 返回一个响应对象,

# 负责将响应的数据分析, 提取需要的数据items以及生成下一步需要处理的url地址请求;

def parse(self, response):

# 1). 实例化对象, MyspiderItem

from items import MyspiderItem

course = MyspiderItem()

# 分析响应的内容

# scrapy分析页面使用的是xpath语法

# 2). 获取每个课程的信息:

courseDetails = response.xpath('//div[@class="course-card-container"]')

for courseDetail in courseDetails:

# 课程的名称:

course['title'] = courseDetail.xpath('.//h3[@class="course-card-name"]/text()').extract()[0]

# 学习人数

course['student'] = courseDetail.xpath('.//span/text()').extract()[1]

# 课程描述:

course['introduction'] = courseDetail.xpath(".//p[@class='course-card-desc']/text()").extract()[0]

# 课程链接, 获取/learn/9 ====》 http://www.imooc.com/learn/9

course['url'] = "http://www.imooc.com" + courseDetail.xpath('.//a/@href').extract()[0]

# 课程的图片url:

course['image_url'] = 'http:' + courseDetail.xpath('.//img/@src').extract()[0]

yield course

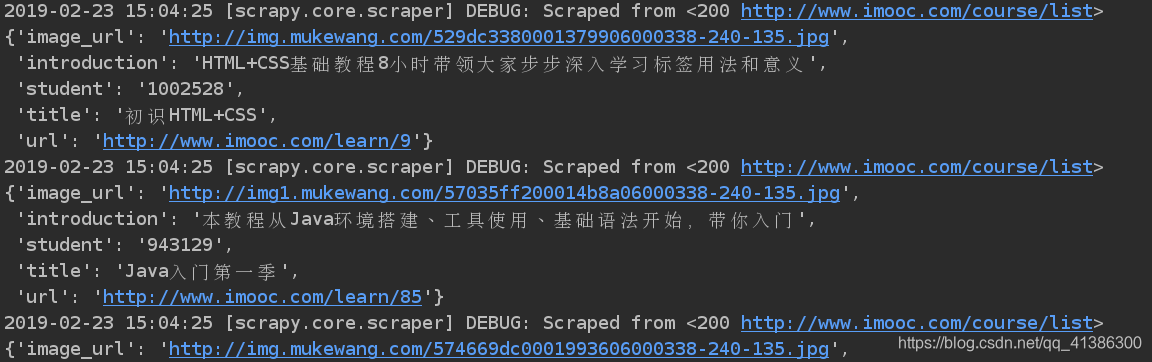

最基本的代码已经写完了,可以运行看一下爬取是否成功

执行命令scrapy crawl mooc

结果:

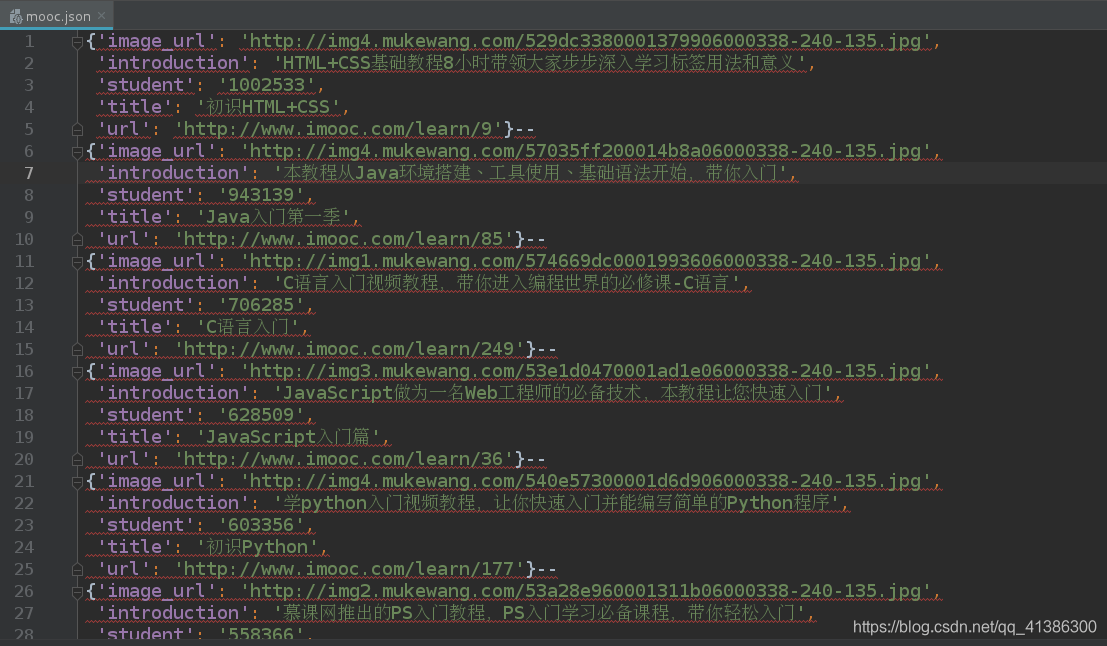

看到这些数据,说明我们爬取成功了

3. 保存这些数据:完善pipelines.py文件

首先先写成最简单的

class MyspiderPipeline(object):

def process_item(self, item, spider):

# 默认传过来的item是json格式

with open('mooc.json','a') as f:

f.write(str(item)+'--\n')

# 一定要加, 返回给调度器;

return item

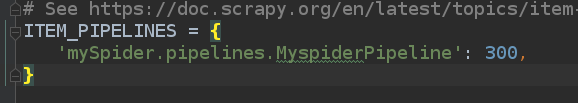

修改配置文件settings.py中下图的三行注释去掉

运行结果:

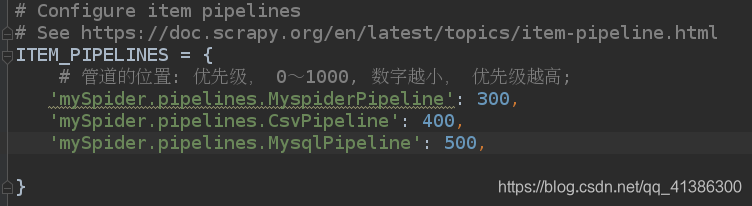

下面是写了三种,分别是保存在csv,json,数据库中的写法,你可以只写一种,或者写你自己想保存的方式,

也可几种都写,但是要修改配置文件settings.py修改他们的优先级( 0~1000, 数字越小, 优先级越高)

保存在json文件中

class MyspiderPipeline(object):

"""将爬取的信息保存为Json格式"""

def __init__(self):

# 这样写就不会每次保存的时候覆盖上一次了

self.f = open('mooc.json', 'w')

def process_item(self, item, spider):

# 默认传过来的item是json格式

import json

# 读取item中的数据, 并转成json格式;

line = json.dumps(dict(item), ensure_ascii=False, indent=4)

self.f.write(line + '\n')

# 一定要加, 返回给调度器;

return item

def open_spider(self, spider):

"""开启爬虫时执行的函数"""

pass

def close_spider(self, spider):

"""当爬虫全部爬取结束的时候执行的函数"""

self.f.close()

保存在csv

class CsvPipeline(object):

"""将爬取的信息保存为csv格式"""

def __init__(self):

self.f = open('mooc.csv', 'w')

def process_item(self, item, spider):

self.f.write(str(item)+'\n')

# item = dict(item)

# self.f.write("{0}:{1}:{1}\n".format(item['title'], item['student'], item['url']))

# 一定要加, 返回给调度为器;

return item

def open_spider(self, spider):

"""开启爬虫时执行的函数"""

pass

def close_spider(self, spider):

"""当爬虫全部爬取结束的时候执行的函数"""

self.f.close()

保存在数据库

import pymysql

class MysqlPipeline(object):

"""

将爬取的信息保存到数据库中

1. 创建mooc数据库

"""

def __init__(self):

super(MysqlPipeline, self).__init__()

self.conn = pymysql.connect(

host='localhost',

user='root',

password='123456',#自己的

db='Mooc',

charset='utf8',

)

self.cursor = self.conn.cursor()

def process_item(self, item, spider):

# item是一个对象,

item = dict(item)

info = (item['title'], item['url'], item['image_url'], item['introduction'], item['student'])

insert_sqli = "insert into moocinfo values('%s', '%s', '%s', '%s', '%s'); " %(info)

self.cursor.execute(insert_sqli)

self.conn.commit()

return item

def open_spider(self, spider):

"""开启爬虫时执行的函数"""

create_sqli = "create table if not exists moocinfo (title varchar(50), url varchar(200), image_url varchar(200), introduction varchar(500), student int)"

self.cursor.execute(create_sqli)

def close_spider(self, spider):

"""当爬虫全部爬取结束的时候执行的函数"""

self.cursor.close()

self.conn.close()

修改配置文件settings.py中他们的优先级如下图

可以自己运行查看结果,这里就不再赘述

4. 爬取多页

到目前为止,现在爬取的只是第一页,但是我们要爬取的是很多页

所以我们要继续完善mooc.py跟进url

#接上面的mooc.py代码

yield course #上面的,从下面开始是跟进url的代码

# url跟进, 获取下一页是否有链接;href

url = response.xpath('.//a[contains(text(), "下一页")]/@href')[0].extract()

if url:

# 构建新的url

page = "http://www.imooc.com" + url

yield scrapy.Request(page, callback=self.parse)# 回调parse函数,相当于递归

5. 下载图片

scrapy里已经写好了下载图片的类ImagesPipeline类

所以,继续完善pipelines.py文件,如果需要下载图片的话

class ImagePipeline(ImagesPipeline):

def get_media_requests(self, item, info):

# 返回一个request请求, 包含图片的url地址

yield scrapy.Request(item['image_url'])

# 当下载请求完成后执行的函数/方法

def item_completed(self, results, item, info):

# 获取下载的地址

image_path = [x['path'] for ok,x in results if ok]

if not image_path:

raise Exception("不包含图片")

else:

return item

6. 根据爬到的url继续爬取页面

和上面的爬取多页跟进uml方法一致,回调的函数不一样,上面是类似递归,而这里不能是递归,需再写一个爬取新页面的函数

例:爬取自己博客列表的每一条博客的内容

分析:

- 首先要爬取博客列表(‘https://blog.youkuaiyun.com/qq_41386300’)的每一条博客的链接,才能爬取每一条博客的内容

- 根据爬到的url爬取博客内容

class CsdnSpider(scrapy.Spider):

name = 'csdn'

allowed_domains = ['youkuaiyun.com']

start_urls = [

'https://blog.youkuaiyun.com/qq_41386300',

#也可写多个,爬多个页面

# 'https://blog.youkuaiyun.com/gf_lvah',

]

def parse(self, response):

boxs = response.xpath('//div[@class="article-item-box csdn-tracking-statistics"]')

for box in boxs:

# 将item对象实例化在for循环里面, 否则每次会覆盖之前item的信息;

item = csdnItem()

item['title'] = box.xpath('./h4/a/text()')[1].extract().strip()

item['url'] = box.xpath('./h4/a/@href')[0].extract()

yield scrapy.Request(item['url'], meta={'item': item}, callback=self.parse_article)#回调爬取博客内容的函数

for page in range(2, 3):# 只爬前两页

url = "https://blog.youkuaiyun.com/gf_lvah/article/list/%s" %(page)

yield scrapy.Request(url, callback=self.parse)

def parse_article(self, response):

item = response.request.meta['item']

content = response.xpath('//div[@id="article_content"]').extract()[0]

item['content'] = content

yield item

7. 反爬虫策略

-

设置DOWNLOAD_DELAY = 3,

设置下载的等待时间;每下载一个页面, 等待xxx秒。在settings.py中取消DOWNLOAD_DELAY = 3的注释

-

禁止cookie信息;

Disable cookies (enabled by default)

去掉配置文件中下面这行的注释,True或False自己修改COOKIES_ENABLED = False

-

设置用户代理

去掉配置文件中下面这行的注释,并修改USER_AGENT = ‘Mozilla/5.0 (X11; Linux x86_64; rv:45.0) Gecko/20100101 Firefox/45.0’

前3条都是修改配置文件,下面两个是修改middlewares.py文件

- 设置User-Agent的中间键

class UserAgentMiddleware(object):

def __init__(self):

self.user_agent = [

#多写几个

'Mozilla/5.0 (X11; Linux x86_64; rv:45.0) Gecko/20100101 Firefox/45.0',

"Mozilla/5.0 (Windows NT 6.0) AppleWebKit/536.5 "

]

def process_request(self, request, spider):

ua = random.choice(self.user_agent)

if ua:

# 此行仅为了测试, 真实场景不要打印, 会影响爬虫的效率

# print("当前使用的用户代理: %s" %(ua))

request.headers.setdefault('User-Agent', ua)

- 设置代理IP的中间键

class ProxiesMiddleware(object):

def __init__(self):

self.proxies = [

#多写几个,从西刺代理ip找

'http://116.209.54.221:9999',

"https://111.177.183.212:9999"

]

def process_request(self, request, spider):

"""当发起请求"""

proxy = random.choice(self.proxies)

if proxy:

# 此行仅为了测试, 真实场景不要打印, 会影响爬虫的效率

# print("当前使用的代理IP: %s" %(proxy))

request.meta['proxy'] = proxy

6 . 第六种方法

class DoubanSpider(scrapy.Spider):

name = 'douban'

allowed_domains = ['movie.douban.com/']

start_urls = ['https://movie.douban.com/top250']

headers={

'User-Agent':"Mozilla/5.0 (iPad; CPU OS 5_0 like Mac OS X) AppleWebKit/534.46 (KHTML, like Gecko) Version/5.1 Mobile/9A334 Safari/7534.48.3"

}

def start_requests(self):

yield Request(self.start_urls[0],headers=self.headers)

def parse(self, response):

pass

8. 调试

本文深入解析Scrapy框架的创建、配置与运行流程,包括项目结构、爬虫开发、数据提取、存储策略及反爬虫技巧。通过实战案例,如多页爬取、图片下载和数据库存储,展示Scrapy的强大功能。

本文深入解析Scrapy框架的创建、配置与运行流程,包括项目结构、爬虫开发、数据提取、存储策略及反爬虫技巧。通过实战案例,如多页爬取、图片下载和数据库存储,展示Scrapy的强大功能。

4015

4015

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?