今天爬取数据结果内存占用率太高,然后说是去重机制的问题,然后使用布隆过滤器解决了这个问题,顺便写一篇博客来记录布隆过滤器。

-

什么是布隆过滤器

如果想判断一个元素是不是在一个集合里,一般想到的是将所有元素保存起来,然后通过比较确定。链表,树等等数据结构都是这种思路. 但是随着集合中元素的增加,我们需要的存储空间越来越大,检索速度也越来越慢。不过世界上还有一种叫作散列表(又叫哈希表,Hash table)的数据结构。它可以通过一个Hash函数将一个元素映射成一个位阵列(Bit Array)中的一个点。这样一来,我们只要看看这个点是不是 1 就知道可以集合中有没有它了。这就是布隆过滤器的基本思想。

Hash面临的问题就是冲突。假设 Hash 函数是良好的,如果我们的位阵列长度为 m 个点,那么如果我们想将冲突率降低到例如 1%, 这个散列表就只能容纳 m/100 个元素。显然这就不叫空间有效了(Space-efficient)。解决方法也简单,就是使用多个 Hash,如果它们有一个说元素不在集合中,那肯定就不在。如果它们都说在,虽然也有一定可能性它们在说谎,不过直觉上判断这种事情的概率是比较低的。布隆过滤器一般使用在亿级别的数据爬虫中,所以,如果你的爬虫只爬取了先少量数据,可以步选择布隆过滤器。 -

布隆过滤器的优点和缺点

优点:相比于其它的数据结构,布隆过滤器在空间和时间方面都有巨大的优势。布隆过滤器存储空间和插入/查询时间都是常数。另外, Hash 函数相互之间没有关系,方便由硬件并行实现。布隆过滤器不需要存储元素本身,在某些对保密要求非常严格的场合有优势。布隆过滤器占用内存极少,比scrapy-redis自带去重机制要节省极大的内存空间。

缺点:但是布隆过滤器的缺点和优点一样明显。误算率(False Positive)是其中之一(误算率小的可以忽略不计)。随着存入的元素数量增加,误算率随之增加。但是如果元素数量太少,则使用散列表足矣。 -

使用布隆过滤器

第一步,安装mmh3这个python模块,但是pip安装的时候会出错,希望哪位大佬能解决这个问题并告诉博主一下解决方法,博主自己用的是python3.6.4 64位的,所以只能提供3.6.4 64位的安装文件,下面附上链接:

https://pan.baidu.com/s/1MCIlNSGcoD-EIFDPDRY5CQ

提取码: jfb2

第二步,下载布隆过滤器的py文件,附上百度网盘及github的下载地址

百度网盘地址:

链接: https://pan.baidu.com/s/1UmWc2JuoCTgtNQepWMrsiA 提取码: mjbx

github地址:

https://github.com/liyaopinner/BloomFilter_imooc

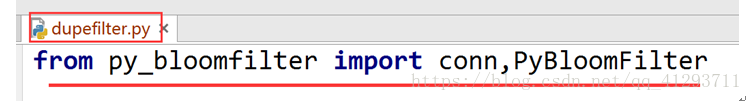

第三步,3、将py_bloomfilter.py集成到scrapy-redis的dupefilter.py过滤器中

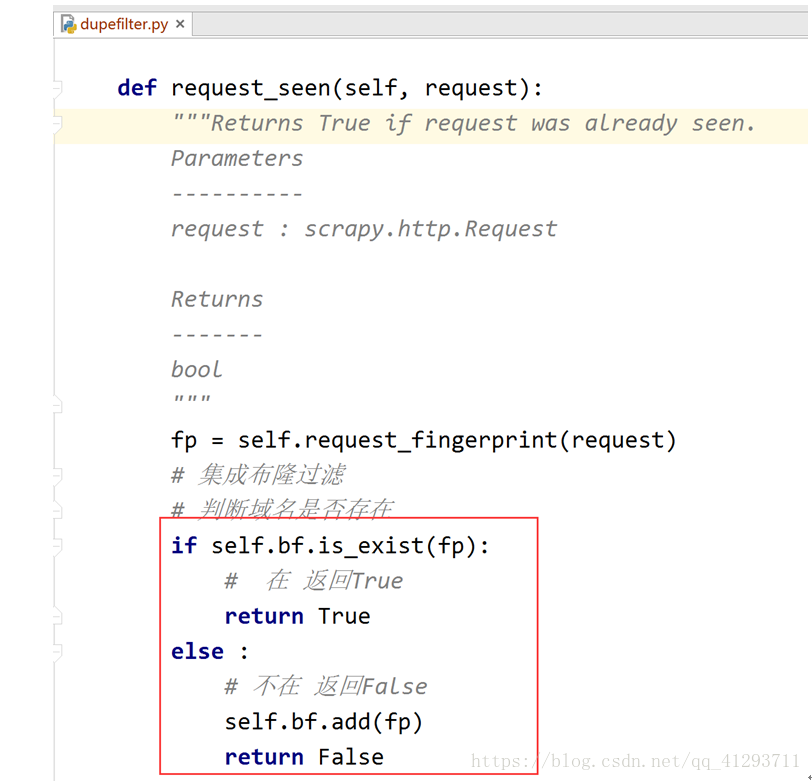

第四步,在request_seen函数中添加如下代码:

最后一步,按照分布式爬虫运行即可。

本文介绍布隆过滤器原理及其在爬虫数据去重中的应用,对比传统数据结构,布隆过滤器在空间和时间效率上有显著优势,尤其适合处理大规模数据集。文章详细解释了布隆过滤器的工作机制,包括如何通过多个哈希函数减少误报率,以及如何在Scrapy框架中集成布隆过滤器进行高效去重。

本文介绍布隆过滤器原理及其在爬虫数据去重中的应用,对比传统数据结构,布隆过滤器在空间和时间效率上有显著优势,尤其适合处理大规模数据集。文章详细解释了布隆过滤器的工作机制,包括如何通过多个哈希函数减少误报率,以及如何在Scrapy框架中集成布隆过滤器进行高效去重。

468

468

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?