[论文笔记]ACL-2021-Improving Named Entity Recognition by External Context Retrieving and Cooperative Learning

作者利用外部上下文检索和合作学习改进命名实体识别

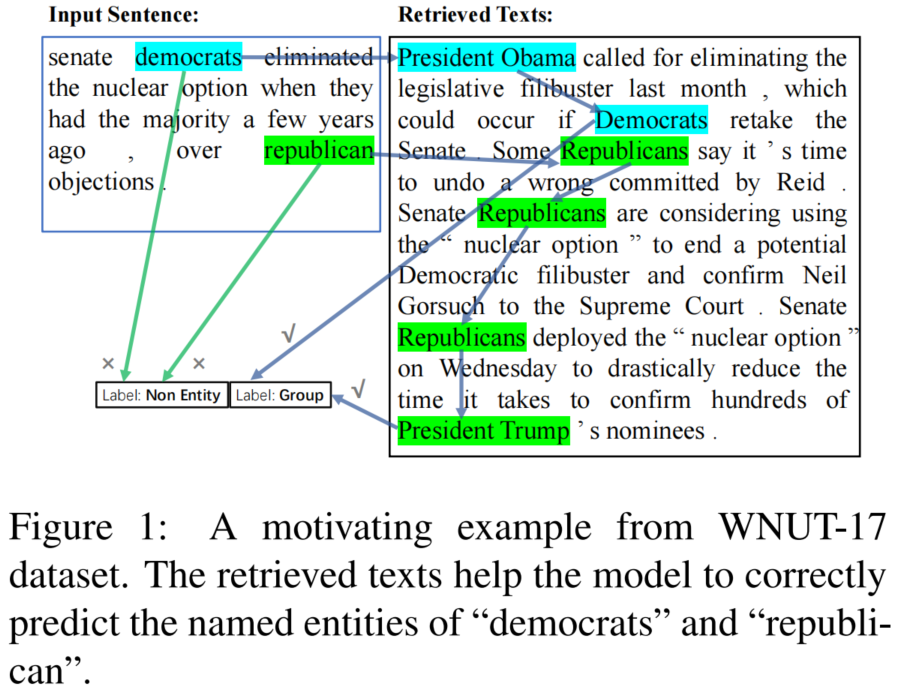

命名实体识别(NER)的最新进展表明,利用文档级的文本信息可以提升实体识别效果,但在很多应用场景下并没有可用文档的信息。

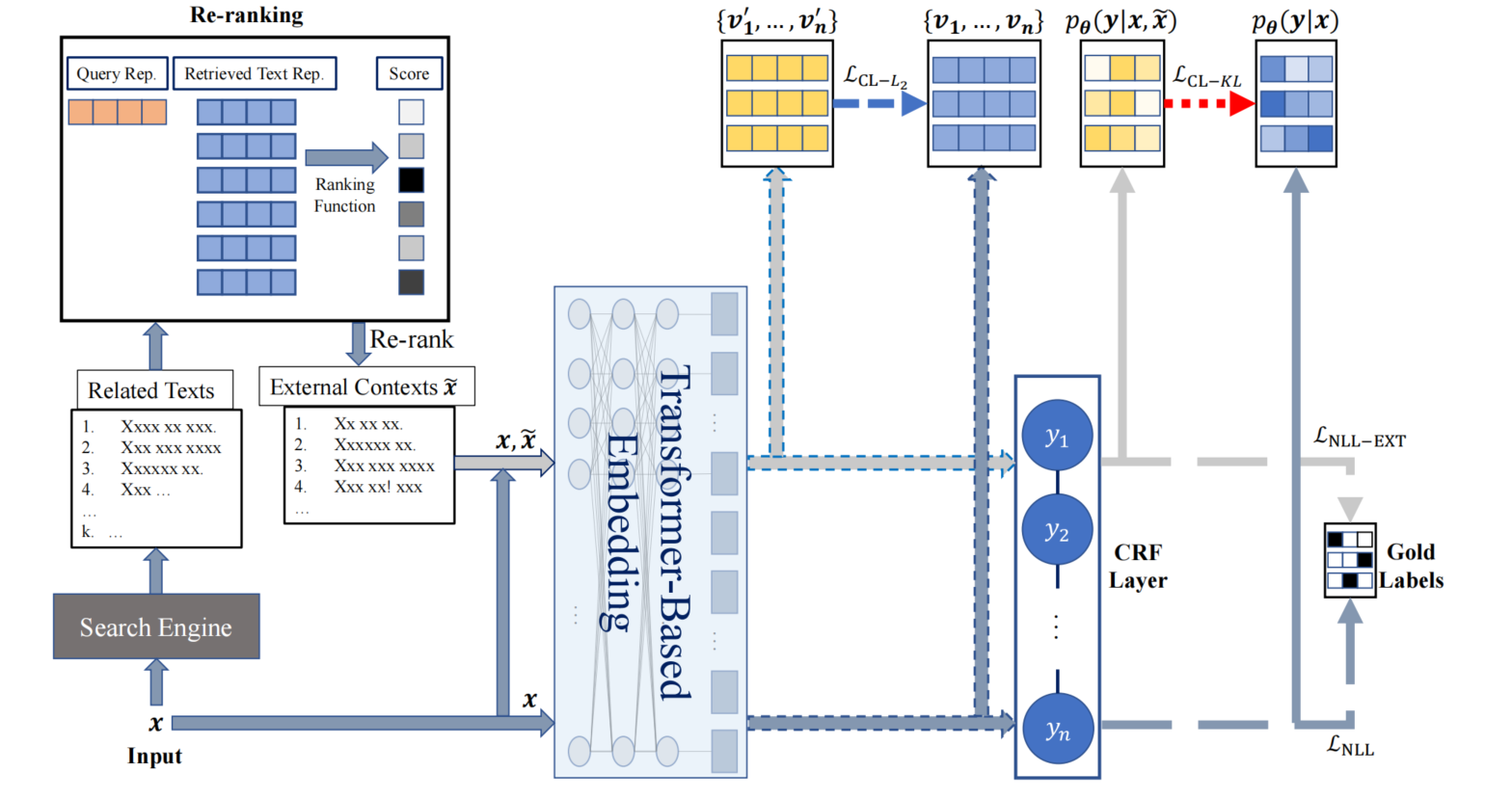

针对此问题,作者提出利用搜索引擎检索和选择一组语义相关的文本,以原始句子作为查询,来查找句子的外部上下文,接着使用Re-ranking模块对检索到的外部文本进行排序,筛选出topk个文本作为额外的文本,原始文本作为一种输入视图,原始文本拼接筛选出的额外文本作为另一种视图放入BERT模型中,利用合作学习以鼓励两个输入视图产生相似上下文表示或输出标签分布,可以显著提高性能

有博客提到:“最后连同原始文本一起输入Encoder模型进行多任务学习,包括NER学习和样本分布学习,从而提高NER识别效果。” ,那么多任务是指,使用同一BERT模型共享参数吗

实验表明,作者的方法可以在5个领域的8个NER数据集上实现最新的性能。

方法

思路

-

把一个n-tokens句子 x = { x 1 , ⋯ , x n } \boldsymbol{x}=\left\{x_{1}, \cdots, x_{n}\right\} x={ x1,⋯,xn}当做查询句,送进Google搜索引擎

-

返回前k个相关的文本 { x ^ 1 , ⋯ , x ^ k } \left\{\hat{\boldsymbol{x}}_{1}, \cdots, \hat{\boldsymbol{x}}_{k}\right\} { x^1,⋯,x^k},送进

Re-Ranking模型 -

按照输入句子和检索文本相关性进行重新排名,返回F1分数前 l l l名的文本连结的结果 x ~ = [ s e p − t o k e n ; x ^ 1 ; ⋯ ; x ^ l ] \tilde{\boldsymbol{x}}=\left[sep _{-}\right.token \left.; \hat{\boldsymbol{x}}_{1} ; \cdots ; \hat{\boldsymbol{x}}_{l}\right] x~=[sep−token;x^1;⋯;x^l]

-

将 [ x ~ ; x ] [\tilde{\boldsymbol{x}};\boldsymbol{x}] [x~;x]和 [ x ] [\boldsymbol{x}] [x]视为两种不同视图,送进一个基于Transformer的预训练的上下文语境模型(如BERT)中,以获得Token表示

{ v 1 ′ , ⋯ , v n ′ , ⋯ } = embed ( [ x ; x ~ ] ) , \left\{\boldsymbol{v}_{1}^{\prime}, \cdots, \boldsymbol{v}_{n}^{\prime}, \cdots\right\}=\operatorname{embed}([\boldsymbol{x} ; \tilde{\boldsymbol{x}}]), { v1′,⋯,vn′,⋯}=embed([x;x~]), { v 1 , ⋯ , v n } = embed ( [ x ] ) \left\{\boldsymbol{v}_{1}, \cdots, \boldsymbol{v}_{n}\right\}=\operatorname{embed}([\boldsymbol{x} ]) { v1,⋯,vn}=embed([x]) -

**[可选]**对两个视图输获得的Token表示使用L2正则化,强制使得两个视图的token表示相似

L C L − L 2 ( θ ) = ∑ i = 1 n ∥ v i ′ − v i ∥ 2 2 \mathcal{L}_{\mathrm{CL}-L_{2}}(\theta)=\sum_{i=1}^{n}\left\|\boldsymbol{v}_{i}^{\prime}-\boldsymbol{v}_{i}\right\|_{2}^{2} LCL−L2(θ)=i=1∑n

本文介绍了一种通过结合外部上下文检索和合作学习改进命名实体识别的方法。作者利用搜索引擎获取相关语境,通过BERT模型处理不同输入视图,通过合作学习约束两个视图的表征和预测一致性,从而在多个NER数据集上取得最新性能。

本文介绍了一种通过结合外部上下文检索和合作学习改进命名实体识别的方法。作者利用搜索引擎获取相关语境,通过BERT模型处理不同输入视图,通过合作学习约束两个视图的表征和预测一致性,从而在多个NER数据集上取得最新性能。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

899

899

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?