TextRNN+attention

attention机制

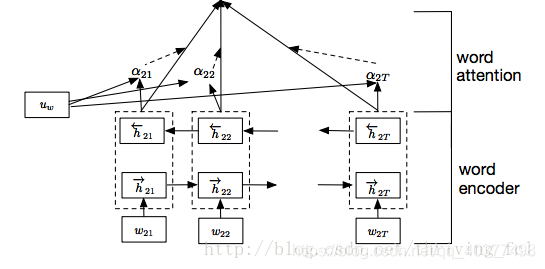

在文本分类任务中引入注意力机制,可以更好地提升模型效果,增加模型的可解释性。

在不利用attention时,文本序列中每个单词对分类任务的贡献程度是相同,然而现实是,分类任务上总会存在一些无用词,因此,引入attention可以很好衡量每个单词对分类任务的贡献程度。

α t \alpha_t αt为每个单词经线性注意力后的权重值。

代码

# coding:utf-8

import torch.nn.functional as f

from models.BasicModule import *

class RNNAttention(BasicModule):

def __init__(self

本文探讨了在文本分类任务中使用注意力机制的重要性,指出它能提升模型效果并增强可解释性。通过注意力机制,可以量化每个单词对分类任务的贡献,过滤掉无关词汇。

本文探讨了在文本分类任务中使用注意力机制的重要性,指出它能提升模型效果并增强可解释性。通过注意力机制,可以量化每个单词对分类任务的贡献,过滤掉无关词汇。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3111

3111

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?