利用 Jupyter Notebook 一步步运行 pandas 库的关键函数

在机器学习领域,pandas 库的使用是每个人都绕不过去的障碍,如何使用好 pandas ,关键是要理解文件IO、数据存储结构、滑窗对象以及 pandas 关键函数之间的关系。作为只少量接触过 pandas 的小白,我对于 pandas 库 库函数的学习和理解过程或许可以对大家有所帮助。下面废话不多说,一起进入 pandas 库的世界。(以下内容主要参考 joyfulpandas,强烈推荐,基础且高效!)

目录

利用 Jupyter Notebook 一步步运行 pandas 库的关键函数

参考内容:

一、文件的读取和写入

1. 数据读取

我们现在有如下形式的 .csv .txt .xlsx 文件,三个文件内存储的数据内容相同:

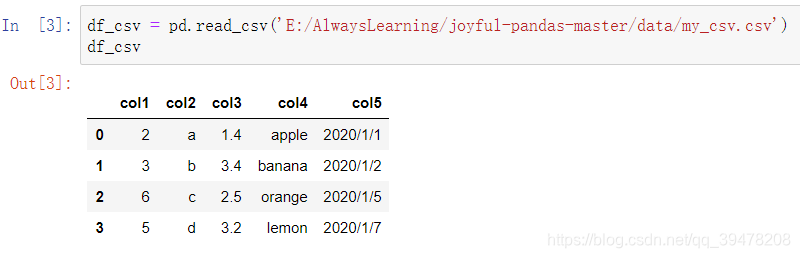

我们试试,利用 pandas 如何一步读取:

import numpy as np

import pandas as pd

df_csv = pd.read_csv('../data/my_csv.csv')

df_txt = pd.read_table('../data/my_table.txt')

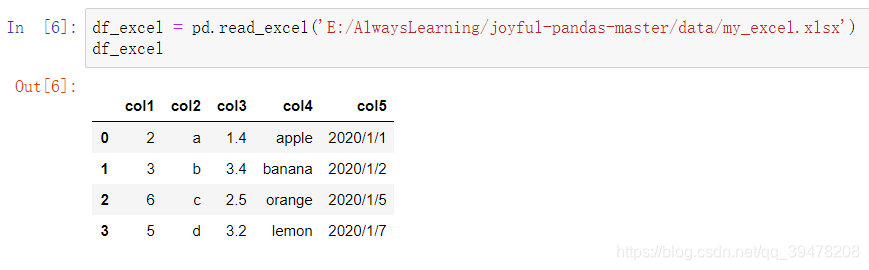

df_excel = pd.read_excel('../data/my_excel.xlsx')读入之后,分别显示如下:

真的就是原封不动的就读取过来。此外,还有一些常用的公共参数:

header = None表示第一行不作为列名;index_col表示把某一列或几列作为索引;usecols表示读取列的集合,默认读取所有的列;parse_dates表示需要转化为时间的列;nrows表示读取的数据行数。

这5个常用参数在上述的三个文件读取函数里都可以使用。具体的运行结果如下:

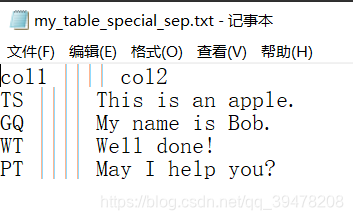

在读取 txt 文件时,经常遇到分隔符非空格的情况,read_table 有一个分割参数 sep,它使得用户可以自定义分割符号,进行 txt 数据的读取(或者其它文件的读取)。例如,下面的读取的表以||||为分割:

pd.read_table('../data/my_table_special_sep.txt', sep=' \|\|\|\| ', engine='python')

在使用 read_table 的时候需要注意,参数 sep 中使用的是正则表达式,因此需要对 | 进行转义变成 \|,否则无法读取到正确的结果。

2. 数据写入

一般在数据写入中,最常用的操作是把 index 设置为 False,特别当索引没有特殊意义的时候,这样的行为能把索引在保存的时候去除。

df_csv.to_csv('../data/my_csv_saved.csv', index=False)

df_excel.to_excel('../data/my_excel_saved.xlsx', index=False)

df_txt.to_csv('../data/my_txt_saved.txt', sep='\t', index=False)pandas 中没有定义 to_table 函数,但是 to_csv 可以保存为 txt 文件,并且允许自定义分隔符,常用制表符 \t 分割。

二、基本数据结构

1. Series

主要用来存储一维数值,由四个部分组成,分别为序列的值 data、索引 index、存储类型 dtype、序列的名字 name。其中,索引也可以指定它的名字。

s = pd.Series(data = [100, 'a', {'dic1':5}],

index = pd.Index(['id1', 20, 'third'], name='my_idx'),

dtype = 'object',

name = 'my_name')

object代表了一种混合类型,正如上面的例子中存储了整数、字符串以及Python的字典数据结构。此外,目前pandas把纯字符串序列也默认认为是一种object类型的序列,但它也可以用string类型存储

对于 Series 中的值,都可以通过 . 的方式来获取。

利用 .shape 可以获取序列的长度。

利用 '[index_item]' 可以单独取出索引的值。

2. DataFrame

DataFrame在Series的基础上增加了列索引,一个数据框可以由二维的data与行列索引来构造。

data = [[1, 'a', 1.2], [2, 'b', 2.2], [3, 'c', 3.2]]

df = pd.DataFrame(data = data,

index = ['row_%d'%i for i in range(3)],

columns=['col_0', 'col_1', 'col_2'])

但一般而言,更多的时候会采用从列索引名到数据的映射来构造数据框,同时再加上行索引:

由于这种映射关系,在DataFrame中可以用[col_name]与[col_list]来取出相应的列与由多个列组成的表,结果分别为Series和DataFrame:

通过.T可以把DataFrame进行转置:

三、常用基本函数

为了进行举例说明,在接下来的部分和其余章节都将会使用一份 learn_pandas.csv 的虚拟数据集,它记录了四所学校学生的体测个人信息(清北复交,我浙三本没牌面x),数据示意如下:

咱们先读取进来,瞅瞅列号:

df = pd.read_csv('../data/learn_pandas.csv')

上述列名依次代表学校、年级、姓名、性别、身高、体重、是否为转系生、体测场次、测试时间、1000米成绩,假设只需使用其中的前七列。

df = df[df.columns[:7]]1. 汇总函数

head, tail函数分别表示返回表或者序列的前n行和后n行,其中n默认为5:

df.head(2)

df.tail(3)

info, describe分别返回表的信息概况和表中数值列对应的主要统计量 :

2. 特征统计函数

在Series和DataFrame上定义了许多统计函数,最常见的是sum, mean, median, var, std, max, min。例如,选出身高和体重列进行演示:

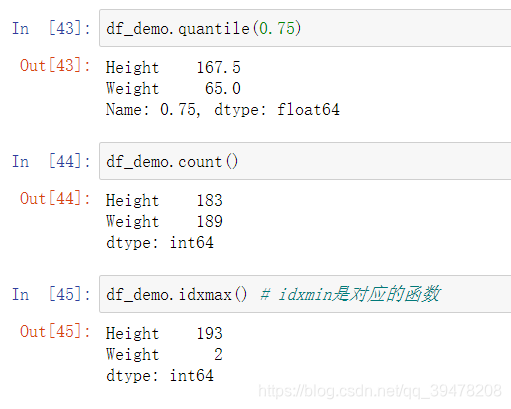

此外,需要介绍的是quantile, count, idxmax这三个函数,它们分别返回的是分位数、非缺失值个数、最大值对应的索引:

上面这些所有的函数,由于操作后返回的是标量,所以又称为聚合函数,它们有一个公共参数axis,默认为0代表逐列聚合,如果设置为1则表示逐行聚合:

3. 唯一值函数

对序列使用unique和nunique可以分别得到其唯一值组成的列表和唯一值的个数:

value_counts可以得到唯一值和其对应出现的频数:

如果想要观察多个列组合的唯一值,可以使用drop_duplicates。其中的关键参数是keep,默认值first表示每个组合保留第一次出现的所在行,last表示保留最后一次出现的所在行,False表示把所有重复组合所在的行剔除。

此外,duplicated和drop_duplicates的功能类似,但前者返回了是否为唯一值的布尔列表,其keep参数与后者一致。其返回的序列,把重复元素设为True,否则为False。 drop_duplicates等价于把duplicated为True的对应行剔除。

4. 替换函数

一般而言,替换操作是针对某一个列进行的,因此下面的例子都以Series举例。pandas中的替换函数可以归纳为三类:映射替换、逻辑替换、数值替换。此处介绍 replace,映射替换的用法。

在replace中,可以通过字典构造,或者传入两个列表来进行替换:

另外,replace还有一种特殊的方向替换,指定method参数为ffill则为用前面一个最近的未被替换的值进行替换,bfill则使用后面最近的未被替换的值进行替换。从下面的例子可以看到,它们的结果是不同的:

逻辑替换包括了where和mask,这两个函数是完全对称的:where函数在传入条件为False的对应行进行替换,而mask在传入条件为True的对应行进行替换,当不指定替换值时,替换为缺失值。

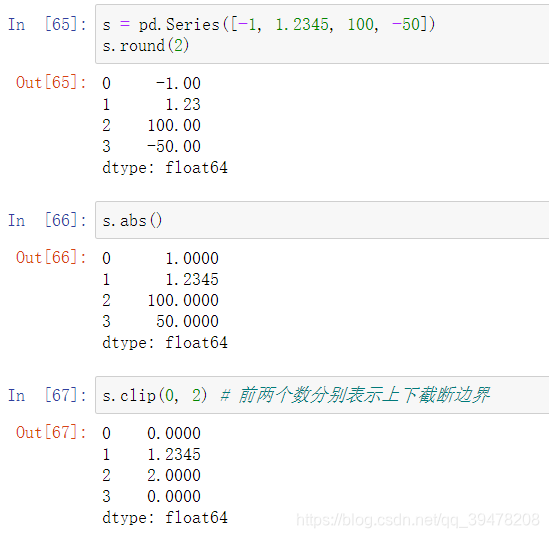

数值替换包含了round, abs, clip方法,它们分别表示按照给定精度四舍五入、取绝对值和截断:

5. 排序函数

排序共有两种方式,其一为值排序,其二为索引排序,对应的函数是sort_values和sort_index。

为了演示排序函数,下面先利用set_index方法把 年级 和 姓名 两列作为索引:

对身高进行排序,默认参数 ascending=True 为升序:

在排序中,经常遇到多列排序的问题,比如在体重相同的情况下,对身高进行排序,并且保持身高降序排列,体重升序排列:

索引排序的用法和值排序完全一致,只不过元素的值在索引中,此时需要指定索引层的名字或者层号,用参数level表示。另外,需要注意的是字符串的排列顺序由字母顺序决定。

6. apply 方法

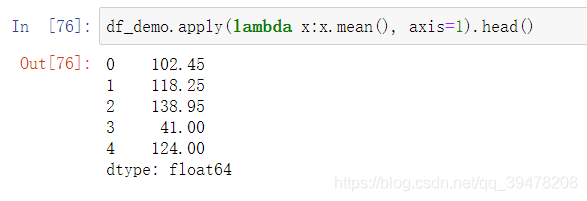

apply方法常用于DataFrame的行迭代或者列迭代,它的axis含义与第2小节中的统计聚合函数一致,apply的参数往往是一个以序列为输入的函数。例如对于.mean(),使用apply可以如下地写出:

同样的,可以利用lambda表达式使得书写简洁,这里的x就指代被调用的df_demo表中逐个输入的序列:

若指定axis=1,那么每次传入函数的就是行元素组成的Series,其结果与之前的逐行均值结果一致。

得益于传入自定义函数的处理,

apply的自由度很高,但这是以性能为代价的。一般而言,使用pandas的内置函数处理和apply来处理同一个任务,其速度会相差较多,因此只有在确实存在自定义需求的情境下才考虑使用apply。

四、窗口对象

pandas中有3类窗口,分别是滑动窗口rolling、扩张窗口expanding以及指数加权窗口ewm。

1. 滑窗对象

要使用滑窗函数,就必须先要对一个序列使用.rolling得到滑窗对象,其最重要的参数为窗口大小window。

在得到了滑窗对象后,能够使用相应的聚合函数进行计算,需要注意的是窗口包含当前行所在的元素,例如在第四个位置进行均值运算时,应当计算(2+3+4)/3,而不是(1+2+3)/3:

对于滑动相关系数 corr 或滑动协方差 cov 的计算,可以如下写出:

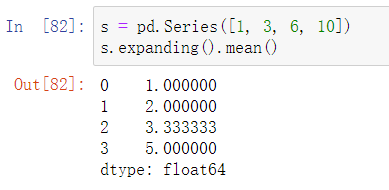

2. 扩张窗口

扩张窗口又称累计窗口,可以理解为一个动态长度的窗口,其窗口的大小就是从序列开始处到具体操作的对应位置,其使用的聚合函数会作用于这些逐步扩张的窗口上。具体地说,设序列为a1, a2, a3, a4,则其每个位置对应的窗口即[a1]、[a1, a2]、[a1, a2, a3]、[a1, a2, a3, a4]。

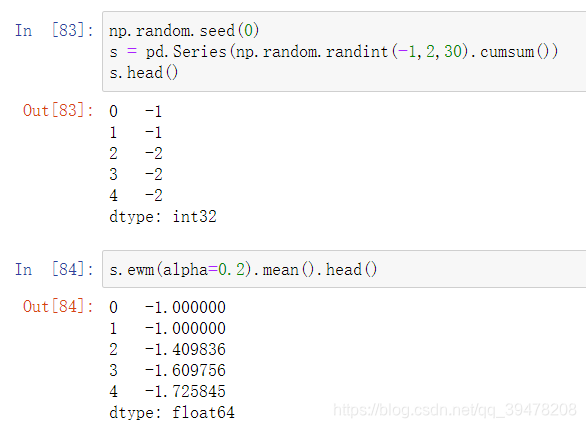

3. 指数加权窗口

在扩张窗口中,用户可以使用各类函数进行历史的累计指标统计,但这些内置的统计函数往往把窗口中的所有元素赋予了同样的权重。事实上,可以给出不同的权重来赋给窗口中的元素,指数加权窗口就是这样一种特殊的扩张窗口。其中,最重要的参数是 alpha,它决定了默认情况下的窗口权重为 ,其中 𝑖 = t 表示当前元素,𝑖 = 0 表示序列的第一个元素。从权重公式可以看出,离开当前值越远则权重越小,若记原序列为𝑥,更新后的当前元素为𝑦𝑡,此时通过加权公式归一化后可知:

对于Series而言,可以用ewm对象如下计算指数平滑后的序列:

结尾

Pandas 是一个强大的分析结构化数据的工具集;它的使用基础是Numpy(提供高性能的矩阵运算);用于数据挖掘和数据分析,同时也提供数据清洗功能。我相信如果要系统的灵活使用 Pandas 看我上面的介绍是远远不够的,真正做到灵活使用需要大量的实战!

本文介绍了Pandas库的基础使用方法,覆盖文件读写、数据结构、常用函数等内容,并通过实例展示了如何利用Jupyter Notebook进行数据分析。

本文介绍了Pandas库的基础使用方法,覆盖文件读写、数据结构、常用函数等内容,并通过实例展示了如何利用Jupyter Notebook进行数据分析。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?