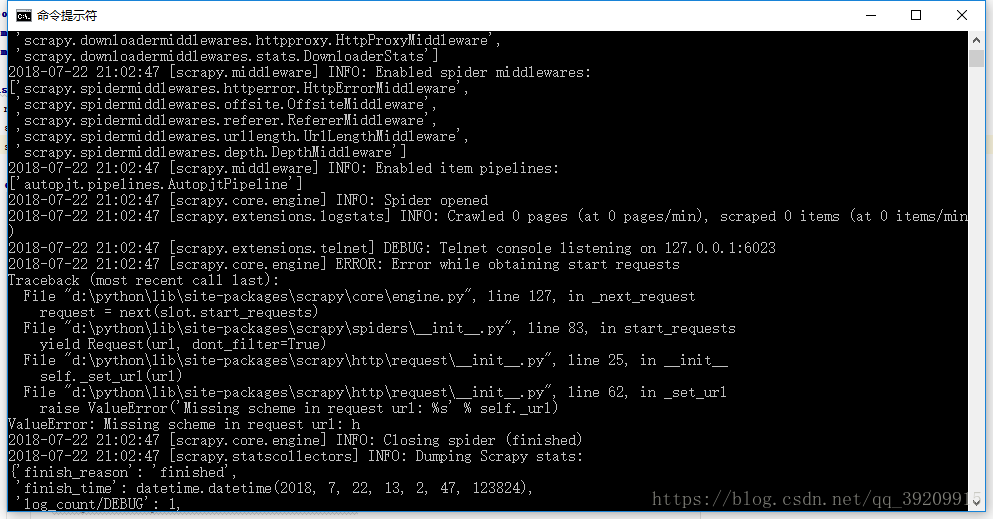

初级小白在写scrapy爬虫是遇到了,一个关于valueError的问题:

前期在网上找了跟多的资料,结果都是说关于一下几种解决方案:

--按提示是Request队列安排错误

--有些说法是pywin32包没有安装到对应版本

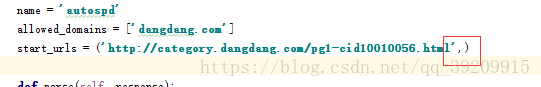

其实归根结底的来说如果不是pywin32没有安装或者版本的错误的话,一般是start_url的问题,它应该是列表而不是元组,而关于列表,当列表中只有一个元素时最后的“,”一定不能省略,加上它才能避免问题。

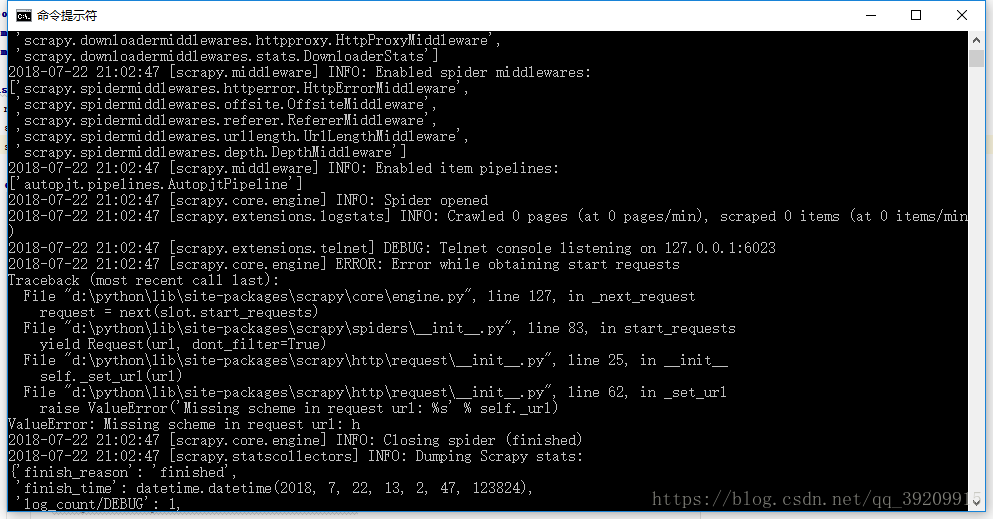

初级小白在写scrapy爬虫是遇到了,一个关于valueError的问题:

前期在网上找了跟多的资料,结果都是说关于一下几种解决方案:

--按提示是Request队列安排错误

--有些说法是pywin32包没有安装到对应版本

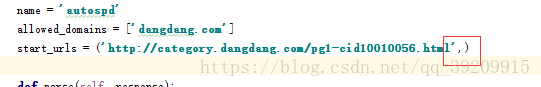

其实归根结底的来说如果不是pywin32没有安装或者版本的错误的话,一般是start_url的问题,它应该是列表而不是元组,而关于列表,当列表中只有一个元素时最后的“,”一定不能省略,加上它才能避免问题。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?