深度神经网络

1、基本概念

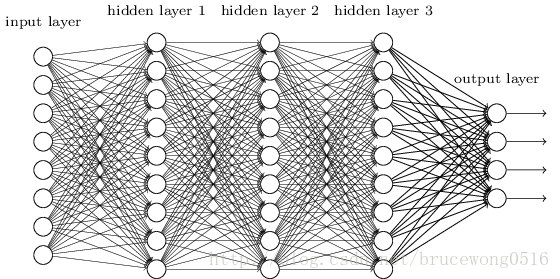

DNN(Deep Neural Network)神经网络模型又叫全连接神经网络,是基本的深度学习框架。与RNN循环神经网络、CNN卷积神经网络的区别就是DNN特指全连接的神经元结构,并不包含卷积单元或是时间上的关联。

2、DNN发展历程

1)神经网络技术起源于上世纪五、六十年代,当时叫感知机(perception),拥有输入层、输出层和一个隐含层。但单层感知机并不能解决较复杂的函数,比如“异或”操作。直到上世纪八十年代,多层感知机的提出,克服了这个问题。

2006年,Hinton利用预训练方法缓解了局部最优解问题,将隐含层推动到了7层,神经网络真正意义上有了“深度”,由此揭开了深度学习的热潮。

多层感知机

2)梳理DNN的构造进行理解

首先是神经元的运算逻辑,一定是线性内核和非线性激活相结合,所以神经元的算法是非线性的。因此DNN神经元的计算内核为X*W+b,以softmax函数(二元分类中使用Sigmoid函数)为非线性核的构造方式。同理,RNN的核采用RNN运算内核,CNN采用卷积运算内核。

逻辑分类可以视为一层DNN神经网络,计算内核为X*W+b,以softmax函数(二元分类中使用Sigmoid函数)为非线性核的构造方式。像逻辑分类这种,线性运算单元设计为权重相乘的,并且层与层之间的神经元全部相连的神经网络就是全连接神经网络,即DNN。

进一步增加隐层,,容纳更多的神经元,来增强模型的能力。比起浅层模型在特征工程和模型工程的各种尝试,神经网络通过更多的神经元直接增强模型的能力。

整个含隐层的DNN的算法流程就是:

X ——W1*X1+b1 ——Relu——W2*X2+b2 ——softmax——y

3、代码实现

待续............................

本文深入探讨深度神经网络(DNN)的基本概念和发展历程,从单层感知机到多层感知机,再到2006年Hinton提出的预训练方法,使DNN真正具备深度。文章详细介绍了DNN的构造,包括神经元的运算逻辑和算法流程,对比了DNN与RNN、CNN的不同之处。

本文深入探讨深度神经网络(DNN)的基本概念和发展历程,从单层感知机到多层感知机,再到2006年Hinton提出的预训练方法,使DNN真正具备深度。文章详细介绍了DNN的构造,包括神经元的运算逻辑和算法流程,对比了DNN与RNN、CNN的不同之处。

7722

7722

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?