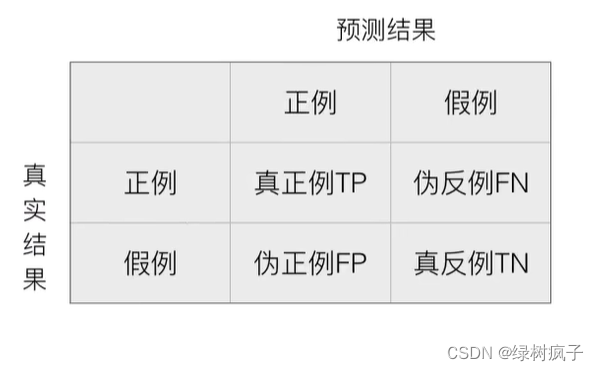

1混淆矩阵

在分类任务下,预测结果与正确标记之间存在四种不同的组合,构成混淆矩阵(适用于多分类)

TP = True Possitive

FN = False Negative

2精确率(Precision)与召回率(Recall)

- 精确率:预测结果为正例样本中真实为正例的比例

- 召回率:真实为正例的样本中预测结果为正例的比例(查得全,对正样本的区分能力)

还有其他的评估标准,F1-score,反映了模型的稳健型。

3分类评估报告API

- sklearn.metrics.classification_report(y_true,y_pred,labels=[],target_names=None )

- y_true:真实目标值

- y_pred:估计器预测目标值

- labels:指定类别对应的数字

- target_names:目标类别名称

- return:每个类别精确率与召回率

假设这样一个情况,如果99个样本癌症,1个样本非癌症,不管怎样我全都预测正例(默认癌症为正例),准确率就为99%但是这样效果并不好,这就是样本不均衡下的评估问题

准确率:99%

召回率:99/99 = 100%

精确率:99%

F1-score:2*99%*100%/ 199% = 99.497%

问题:如何衡量样本不均衡下的评估?

答:ROC曲线与AUC指标

本文讨论了在多分类任务中的混淆矩阵、精确率、召回率以及F1-score等评估指标。特别强调了在样本严重不均衡情况下,仅依赖准确率可能产生误导,提出使用ROC曲线和AUC指标来更全面地衡量模型性能。

本文讨论了在多分类任务中的混淆矩阵、精确率、召回率以及F1-score等评估指标。特别强调了在样本严重不均衡情况下,仅依赖准确率可能产生误导,提出使用ROC曲线和AUC指标来更全面地衡量模型性能。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?