CNN里面最重要的构建单元就是卷积层。神经元在第一个卷积层不是连接输入图片的每一个像素,只是连接它们的感受野的像素,以此类推,第二个卷积层的每一个神经元仅连接位于第一个卷积层的一个小方块的神经元,即局部连接。CNN里的卷积层对输入进行特征抽取、归纳、整理,这也是CNN比只有全连接层FC的DNN准确率要高的一个原因。

下面举个小栗子解释一下卷积如何手动计算的!

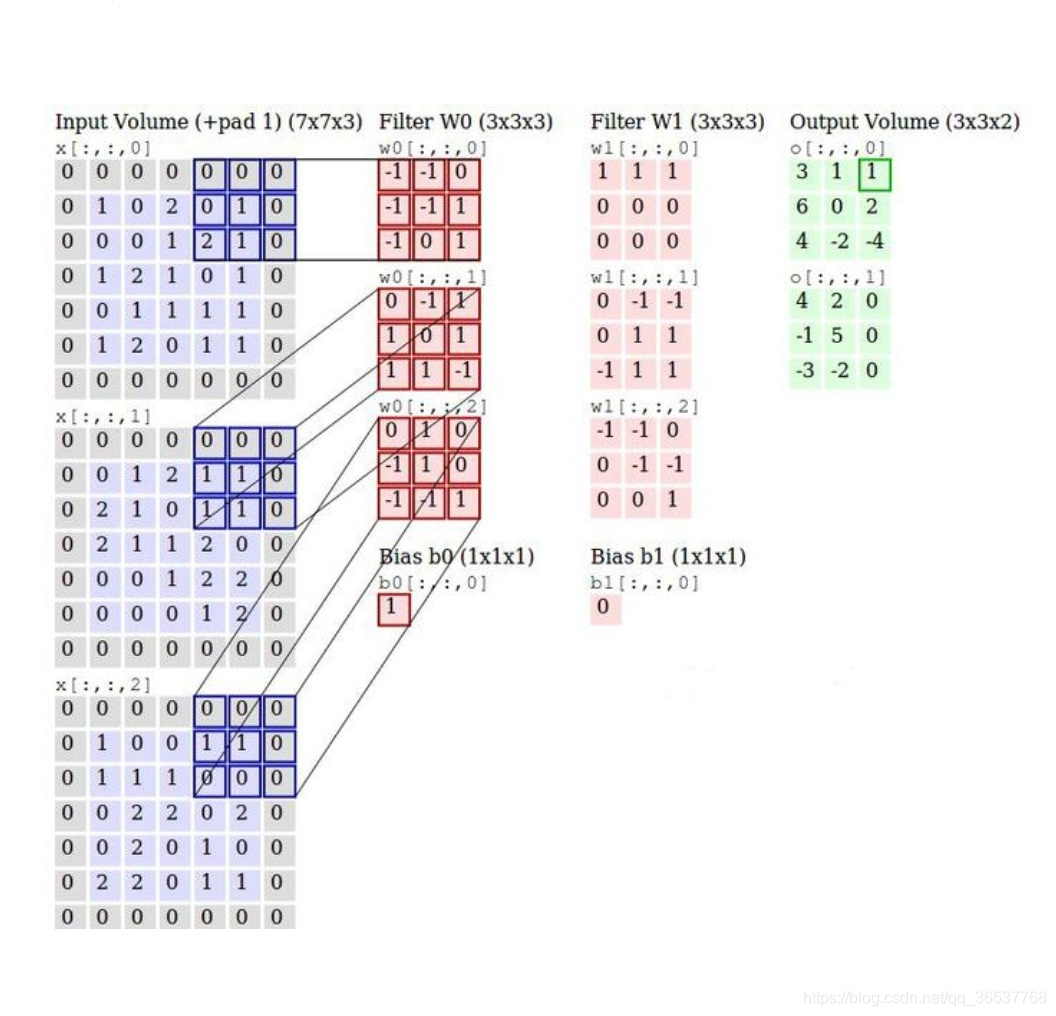

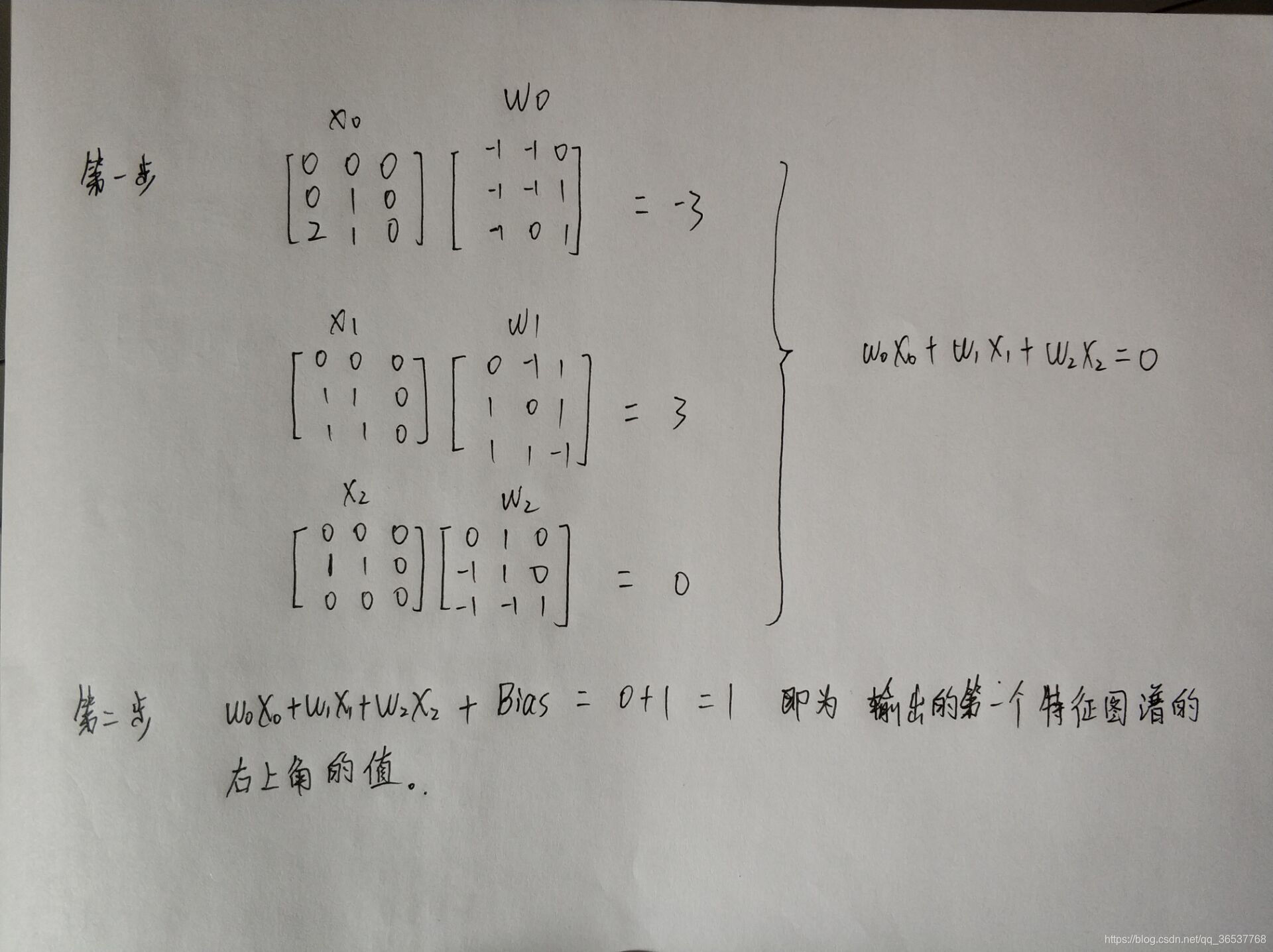

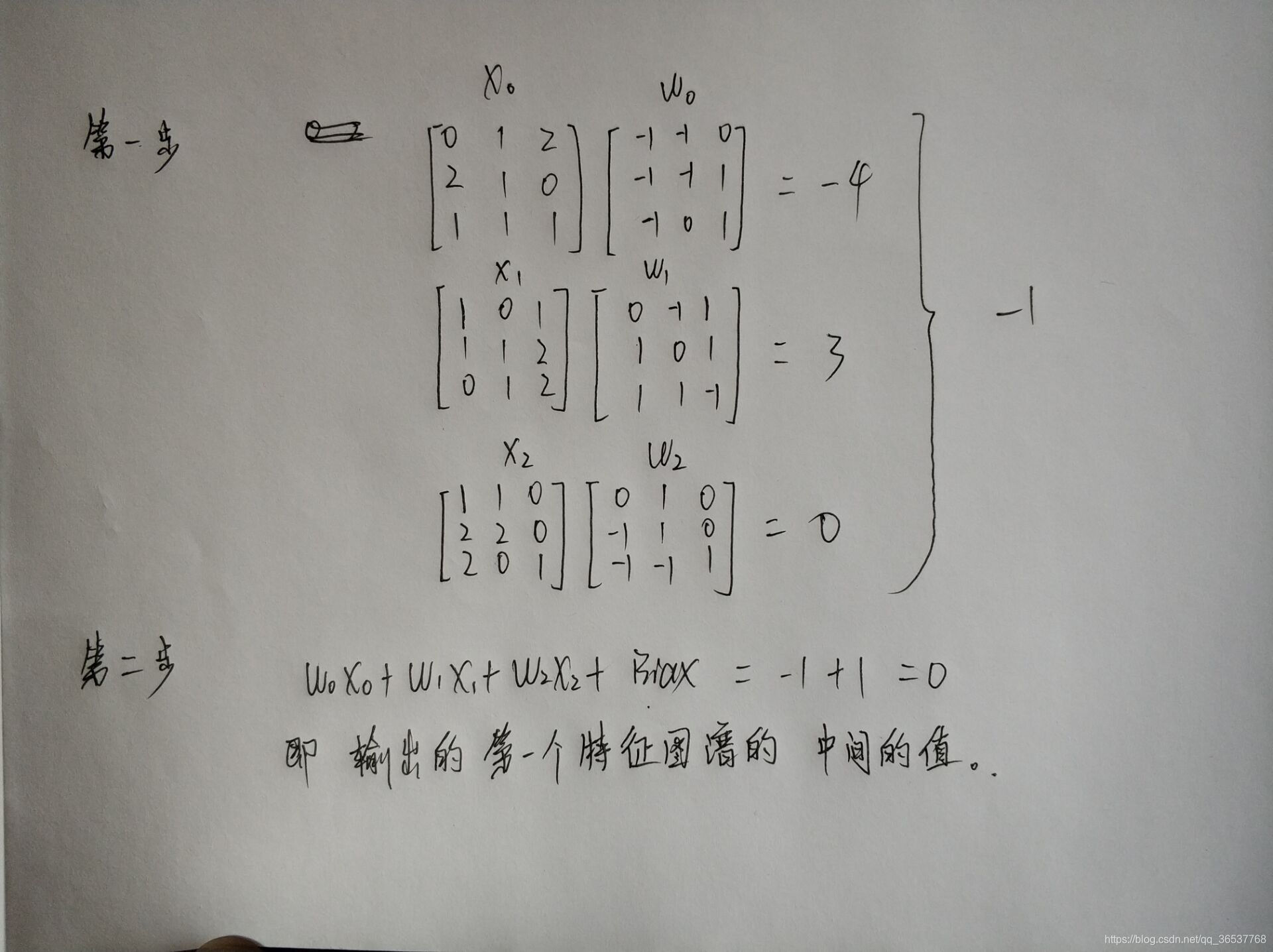

首先注意两点:卷积核大小以及步幅。本例中步幅为2,两个卷积核皆为3 * 3 * 3(三行三列三通道)。输入为三通道图像,经过两个卷积操作得到两个特征图。

以上为两个手写计算得到的两个值。说白了就是wx+b的计算。注意步幅!

本文深入解析了CNN中的卷积层工作原理,重点介绍了局部连接特性及卷积计算过程,通过实例演示了卷积核与步幅对特征提取的影响。

本文深入解析了CNN中的卷积层工作原理,重点介绍了局部连接特性及卷积计算过程,通过实例演示了卷积核与步幅对特征提取的影响。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?