code tensorflow

Non-local 由三个部分组成:

U-Net、Residual Blocks、Global Aggregation Block

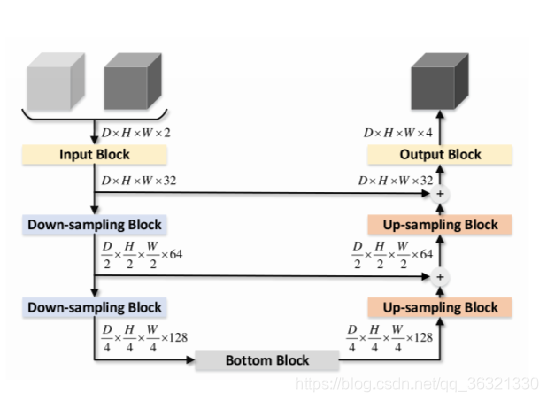

U-Net

作者将原始u-net的concatenation -> sum的原因:

- 求和不会增加特征图的数量,因此会减少下一层中可训练参数的数量。

- 具有求和的skip connection可以被视为远程残差连接,可以促进模型的训练。

最后生成概率分割图

Residual Blocks

已知:U-Net中的skip connection 相当于 远程残差连接

2017 paper:在U-Net中增加短距离的残差连接可以提高性能

但是,之前的研究没有将残差连接用在上采样模块和下采样模块之中,基于此,提出了 global aggregation block

下面是作者提出的用于non-local U-Net中的四个残差块

(a)常规残差块。 该块用作输入块。 输出块由该块+步长为1的1x1x1的卷积构成。此外,在跳跃连接求和之后,我们插入一个这样的块。

(b)是下采样残差块。 将此块用作下采样块。

(c)说明了我们的底部模块。 残差连接应用了我们提出的全局聚合块。

(d)上采样残差块,(b)中的下采样块相似,恒等残差连接被步长为2的3×3×3反卷积代替,另一个分支是上采样全局聚合块。 使用此块作为上采样块.

Global Aggregation Block

实现全局信息融合:输出特征图的每个位置都应取决于输入特征图的所有位置。 (与卷积和反卷积等局部操作相反),可以通过self-attention来聚合(aggregation)图像特征图的全局信息。

本文深入探讨Non-local U-Net架构,包括U-Net、ResidualBlocks与GlobalAggregationBlock三大组件。解析U-Net中concatenation到sum转换的原因,及如何通过残差连接提升模型训练效率。详细阐述四种残差块设计与全局信息融合机制。

本文深入探讨Non-local U-Net架构,包括U-Net、ResidualBlocks与GlobalAggregationBlock三大组件。解析U-Net中concatenation到sum转换的原因,及如何通过残差连接提升模型训练效率。详细阐述四种残差块设计与全局信息融合机制。

971

971

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?