1、使用windows访问集群时,需要装utils

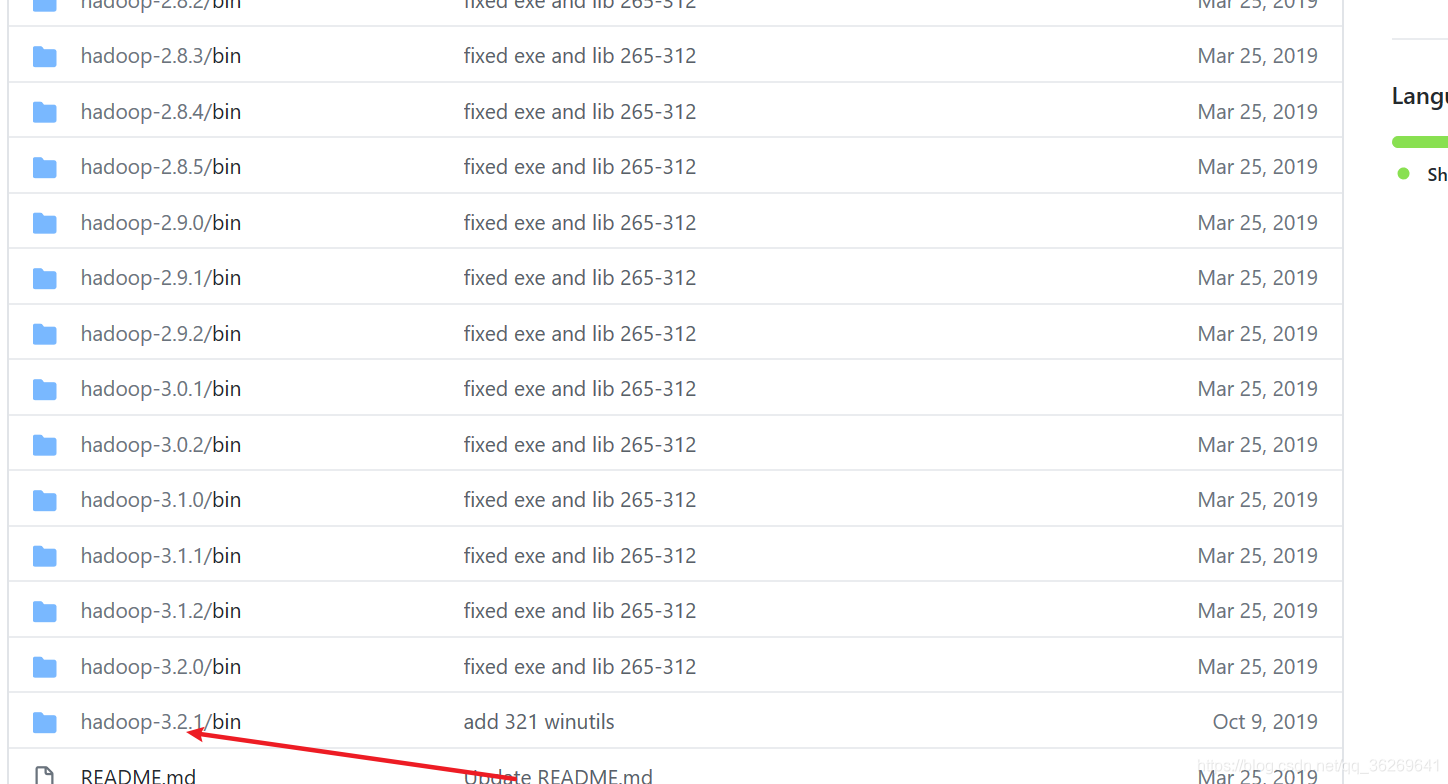

位置:直接下载 https://github.com/cdarlint/winutils 找到对应版本,并在windows环境变量中新建:HADOOP_HOME

2、 Error creating transactional connection factory

其它配置请参见之前的一篇配置文章:

spark02: 围绕Spark3.0.1为主Hadoop3.2、Mysql、Hbase2.3.3、Hive3.1.2、ZooKeeper3.5.5、Flume、Kafka、Redis搭建

错误很多,大致是找不到hive元数据

由于spark访问hive时是使用thrift这个远程RPC框架,但之前的配置方式中并没有为thrift配置为相应的主机地址,及其它相关信息,主要从以下几个方面去找到hive-site.xml中的配置

1、是否启用thrift,默认是false,要改为true

2、绑定的主机:band.host 默认是没有配的,改为:0.0.0.0

3、访问的用户:默认没配,要改为root

4、访问的密码:默认没配,要改为root

以下是hive-site.xml

<configuration>

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://linux01.pub:3306/hive

在Windows环境下,通过Spark访问Hadoop集群的Hive时遇到Error creating transactional connection factory错误。解决方案包括:安装winutils并设置HADOOP_HOME环境变量;检查并修改Hive-site.xml配置,确保thrift服务启用,绑定所有IP地址,配置正确的用户名和密码;确保Hiveserver2和metastore服务已启动。

在Windows环境下,通过Spark访问Hadoop集群的Hive时遇到Error creating transactional connection factory错误。解决方案包括:安装winutils并设置HADOOP_HOME环境变量;检查并修改Hive-site.xml配置,确保thrift服务启用,绑定所有IP地址,配置正确的用户名和密码;确保Hiveserver2和metastore服务已启动。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?