本次记录使用requests+Beautiful+pymysql的方法将大学排名的数据存入本地MySQL数据库。

这是一篇学习性文章,希望能够分享在学习过程中遇到的坑与学到的新技术,试图用最简单的话来阐述我所记录的Python爬虫笔记。

#一、爬取结果

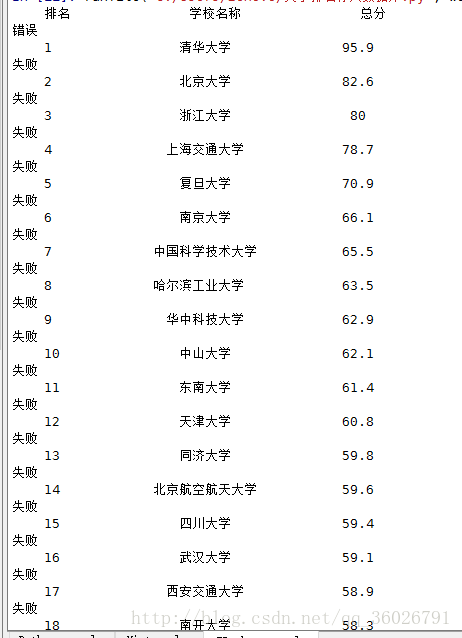

存储于MySQL数据库结果如下:

爬取结果在屏幕中打印如下:

至于每行中间为什么会有错误与失败的字眼,稍后会进行解释。

#二、项目需求分析

在最好大学网站上将大学排名,大学名称以及评分爬取下来存至本地数据库。网站地址如下:

http://www.zuihaodaxue.cn/zuihaodaxuepaiming2016.html

此项目可解析为三个子问题:1、利用requests库爬取网站所有内容

2、利用Beautifulsoup解析网站,提取需要

的内容。

3、 将提取的内容打印出来并存入数据库。

因此定义四个函数:1、getHTMLtest( )

2、fillUnivList( )

3、printUnivList( )

4、main( )

#三、实际代码解剖

打开Spyder,导入所需库:

import requests

from bs4 import BeautifulSoup

import bs4

import pymysql

##主函数编写:

def main():

uinfo = []

url = 'http://www.zuihaodaxue.cn/zuihaodaxuepaiming2016.html'

html = getHTMLText(url)

fillUnivList(uinfo, html)

printUnivList(uinfo, 50) # 50 univs

main()

##getHTMLtest( )函数编写:

def getHTMLText(url):

try:

r = requests.get(url, timeout=30)

r.raise_for_status()

r.encoding = r.apparent_encoding

return r.text

except:

return ""

此处采用requests库中get函数将url中的内容全部抓取,此外还设置了timeout=30 参数,是为了不然网站查询是爬虫正在访问。 r.raise_for_status()可检查爬取是否成功,一般状态码为200则为爬取成功。r.encoding = r.apparent_encoding 修改备用编码规则以防止出现乱码。注意:此处使用了try…except的结构,这是为了让你的代码更加安全可靠,不会因为这段代码出现问题而导致整个程序运行失败。

##fillUnivList( )函数编写:

def fillUnivList(ulist, html):

soup = BeautifulSoup(html, "html.parser")

for tr in soup.find('tbody').children:

if isinstance(tr, bs4.element.Tag):

tds = tr('td')

ulist.append([tds[0].string, tds[1].string, tds[3].string])

此处使用Beautifulsoup库将爬取得内容进行解析。用find的方法找到所有的‘tbody’在使用.children的方法找到它的儿子标签。if isinstance(tr, bs4.element.Tag) 此行代码是为了判断‘tbody’的儿子标签是否为tr,注意需要格外导入bs4库进行判断。之后将内容写入ulist列表。

##printUnivList( )函数编写:

def printUnivList(ulist, num):

tplt = "{0:^10}\t{1:{3}^10}\t{2:^10}"

print(tplt.format("排名","学校名称","总分",chr(12288)))

conn = pymysql.connect(host = 'localhost',port = 3306,user = 'root',

passwd = 'yourpasswd',db = 'university',charset = 'utf8')

cur = conn.cursor()

sqlc = '''

create table DXPM(

id int(11) not null auto_increment primary key,

name varchar(255) not null,

score float not null)DEFAULT CHARSET=utf8;

'''

try:

cur.execute(sqlc)

conn.commit()

print("成功")

except:

print("错误")

for i in range(num):

u=ulist[i]

print(tplt.format(u[0],u[1],u[2],chr(12288)))

sqla = '''

insert into DXPM(id,name,score)

values(%s,%s,%s);

'''

try:

cur.execute(sqla,(u[0],u[1],u[2]))

conn.commit()

print("成功")

except:

print("失败")

conn.commit()

cur.close()

conn.close()

此段为核心代码,首先将排名,学校名称,分数进行格式化输出。使用以下代码连接你的数据库,passwd换成你自己的mysql密码。

conn = pymysql.connect(host = 'localhost',port = 3306,user = 'root',

passwd = 'yourpasswd',db = 'university',charset = 'utf8')

之后创建游标并创建表,具体文章可参见:http://blog.youkuaiyun.com/eastmount/article/details/52156383

·····································································································································

此处代码作用是为了使之前创建的数据库表成功录入数据库,并且将数据写入数据库,若成功写入打印成功,否则打印错误。由于之前笔者已经运行过此程序,也就是说本地数据库中已经存在表与数据,所以之前的结果图才会打印‘错误‘。最后记得将游标与数据库关闭.

try:

cur.execute(sqlc)

conn.commit()

print("成功")

except:

print("错误")

for i in range(num):

u=ulist[i]

print(tplt.format(u[0],u[1],u[2],chr(12288)))

sqla = '''

insert into DXPM(id,name,score)

values(%s,%s,%s);

'''

try:

cur.execute(sqla,(u[0],u[1],u[2]))

conn.commit()

print("成功")

except:

print("失败")

conn.commit()

cur.close()

conn.close()

#四、源代码

# -*- coding: utf-8 -*-

"""

Created on Fri Jul 28 14:11:44 2017

"""

import requests

from bs4 import BeautifulSoup

import bs4

import pymysql

def getHTMLText(url):

try:

r = requests.get(url, timeout=30)

r.raise_for_status()

r.encoding = r.apparent_encoding

return r.text

except:

return ""

def fillUnivList(ulist, html):

soup = BeautifulSoup(html, "html.parser")

for tr in soup.find('tbody').children:

if isinstance(tr, bs4.element.Tag):

tds = tr('td')

ulist.append([tds[0].string, tds[1].string, tds[3].string])

def printUnivList(ulist, num):

tplt = "{0:^10}\t{1:{3}^10}\t{2:^10}"

print(tplt.format("排名","学校名称","总分",chr(12288)))

conn = pymysql.connect(host = 'localhost',port = 3306,user = 'root',

passwd = 'yourpasswd',db = 'university',charset = 'utf8')

cur = conn.cursor()

sqlc = '''

create table DXPM(

id int(11) not null auto_increment primary key,

name varchar(255) not null,

score float not null)DEFAULT CHARSET=utf8;

'''

try:

cur.execute(sqlc)

conn.commit()

print("成功")

except:

print("错误")

for i in range(num):

u=ulist[i]

print(tplt.format(u[0],u[1],u[2],chr(12288)))

sqla = '''

insert into DXPM(id,name,score)

values(%s,%s,%s);

'''

try:

cur.execute(sqla,(u[0],u[1],u[2]))

conn.commit()

print("成功")

except:

print("失败")

conn.commit()

cur.close()

conn.close()

最后希望本文能对你有所帮助(其实是对我自己有所帮助啦~),希望可以共同进步。

后续我会继续更新爬虫系列专题,文章都是作者学习过程中随笔而记,不喜勿喷啊。

本文介绍如何使用Python的requests和BeautifulSoup库从网站爬取大学排名数据,并通过pymysql库将数据存储到MySQL数据库中。

本文介绍如何使用Python的requests和BeautifulSoup库从网站爬取大学排名数据,并通过pymysql库将数据存储到MySQL数据库中。

1114

1114

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?