感谢沐神教我深度学习🙏

损失为什么要平均?

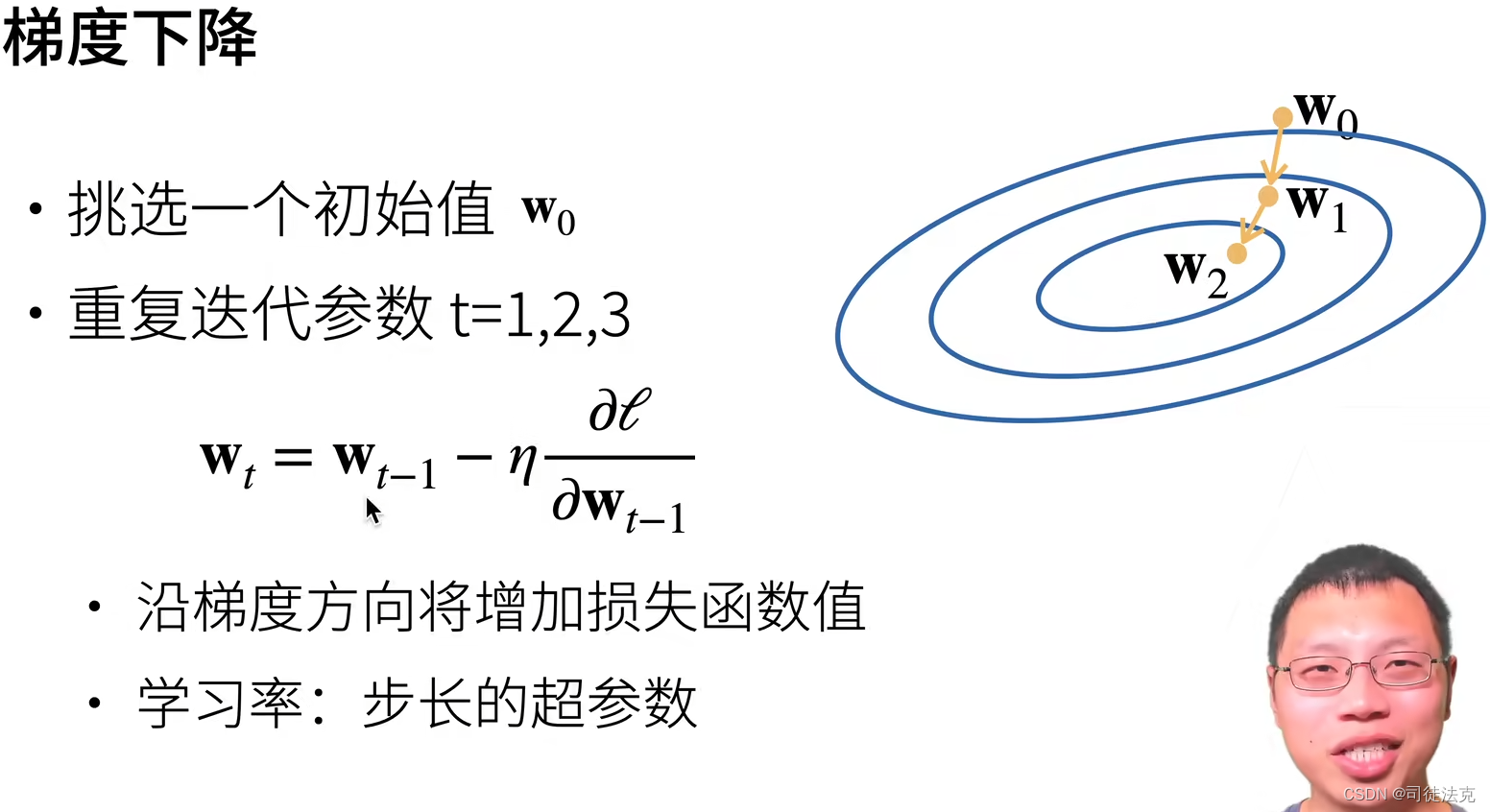

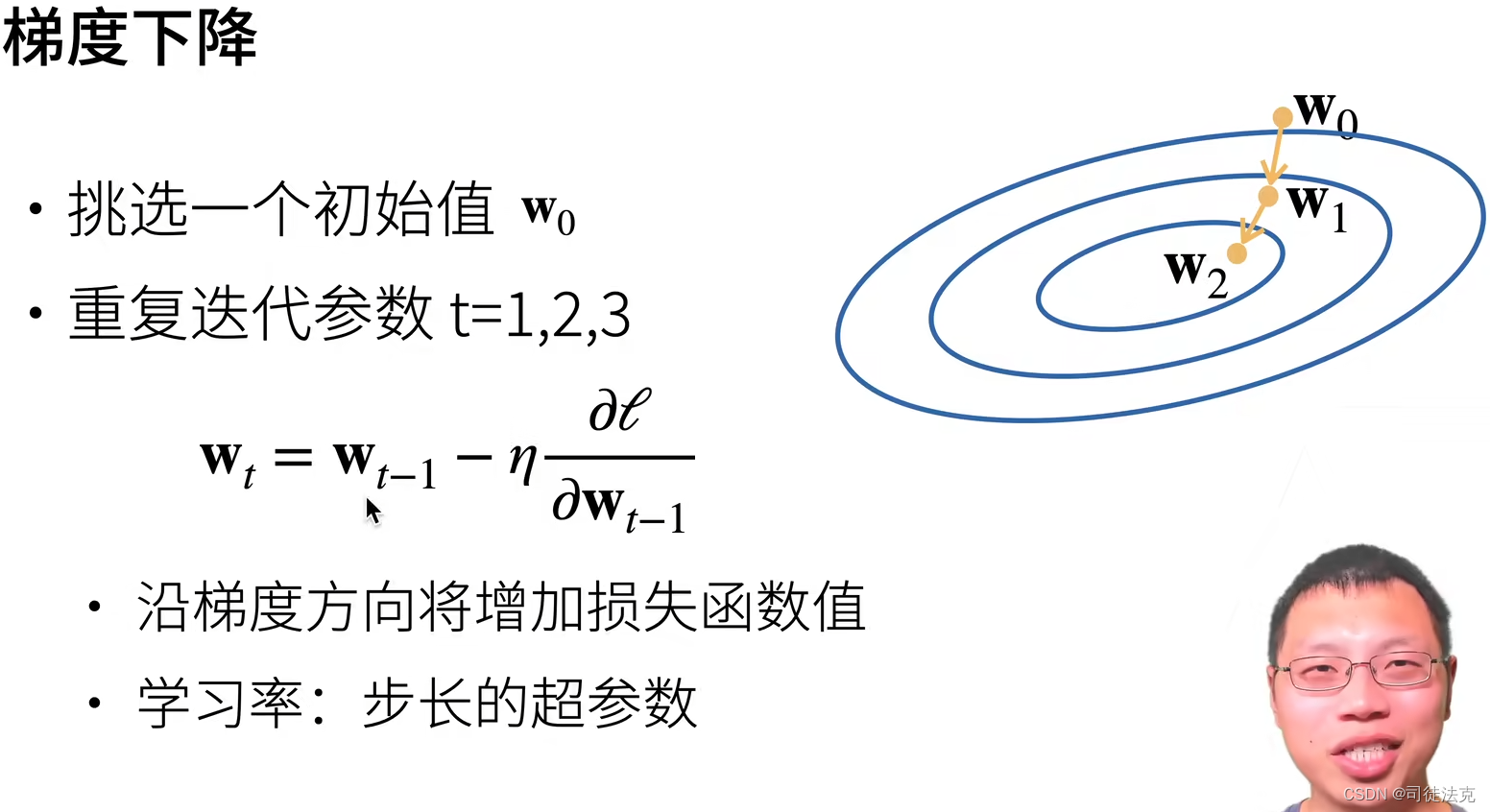

平均即除以batch_size,若不除,则批越大梯度越大,梯度下降的步长就越大。除以batch_size可使梯度与批大小无关。也可以不在损失函数中除,将学习率lr除以batch_size也一样。参照下面公式(图片来自@跟李沐学AI 的动手学深度学习)

批大小对训练的影响

批越小越好。随机梯度下降的随机会带来噪音,批越小,则噪音越大,对于神经网络来说,噪音是好事,可以抑制过拟合

感谢沐神教我深度学习🙏

平均即除以batch_size,若不除,则批越大梯度越大,梯度下降的步长就越大。除以batch_size可使梯度与批大小无关。也可以不在损失函数中除,将学习率lr除以batch_size也一样。参照下面公式(图片来自@跟李沐学AI 的动手学深度学习)

批越小越好。随机梯度下降的随机会带来噪音,批越小,则噪音越大,对于神经网络来说,噪音是好事,可以抑制过拟合

737

737

474

474

197

197

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?