spark-on-k8s 介绍

摘要

最近一段时间都在做与spark相关的项目,主要是与最近今年比较火的隐私计算相结合,主要是在机密计算领域使用spark做大数据分析、SQL等业务,从中也了解到了一些spark的知识,现在做一个简单的总结,主要关注spark on k8s模式。

需要先从大数据开始讲起,大数据应用是指运行在大数据处理框架之上,对大数据进行分布处理的应用,典型的框架如:Hadoop MapReduce、Spark、Flink、Hive等等,可以应用于日志挖掘、SQL查询、机器学习等等。

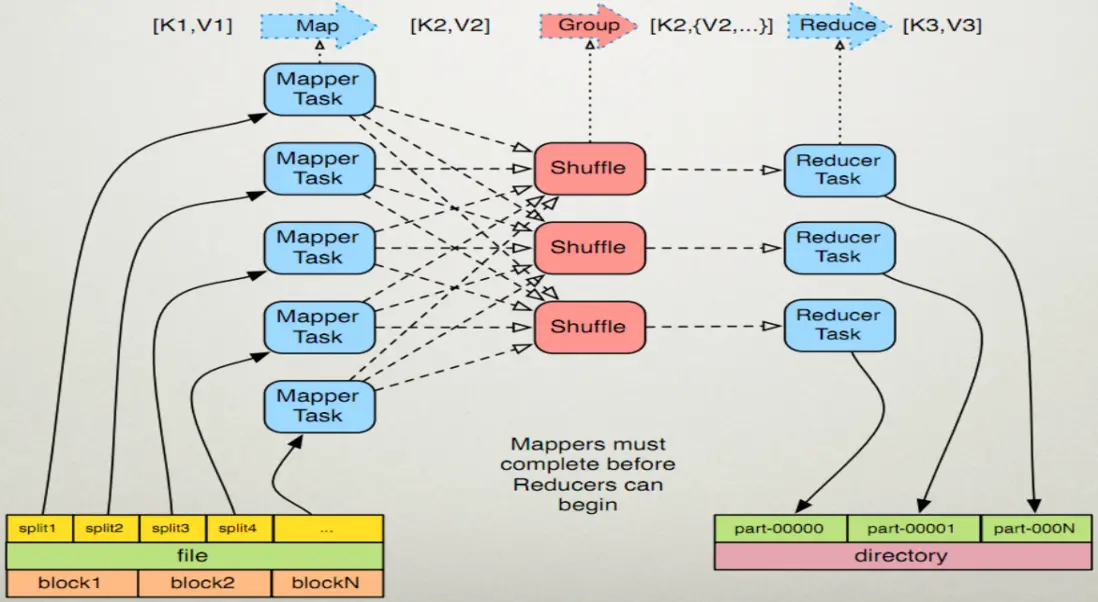

处理大数据需要借助MapReduce编程模型,典型的大数据框架也是基于该编程模型实现的,该模型可以将大型数据处理任务分解成很多单个的、可以在服务器集群中并行执行的任务,而这些任务的计算结果可以合并在一起来计算最终的结果。

MapReduce

主要包含两个基本的数据转换操作:map过程和reduce过程。

map:

map操作会将集合中的元素从一种形式转化成另一种形式,在这种情况下,输入的键值对会被转换成零到多个键值对输出。

reduce:

某个键的所有键值对都会被分发到同一个reduce操作中,确切的说,这个键和这个键所对应的所有值都会被传递给同一个Reducer。reduce过程的目的是将值的集合转换成一个值(例如求和或者求平均),或者转换成另一个集合。这个Reducer最终会产生一个键值对。

下面这张图很清晰的展示了MapReduce的过程:

举个例子,我们要数图书馆中的所有书。你数1号书架,我数2号书架。这就是“Map”。我们人越多,数书就更快。现在我们到一起,把所有人的统计数加在一起。这就是“Reduce”。简单来说,Map就是“分”而Reduce就是“合” 。

主要包含: (input) ->map-> ->combine-> ->reduce-> (output)

然后我们结合spark理解一下上面的过程,spark中有数据分区partition的概念,对应图中的输入。每个partition对应一个task,也就是图中的Mapper Task,执行Map操作。如果spark集群中的worker数量越多,每个worker分配的CPU核心数越多,则同一时间并发执行的Mapper Task越多,这样可以提升整体任务执行的效率。

Map操作结束后,需要将Map的结果按key相同进行合并,这就是spark中的shuffle阶段,在spark日志中我们可以明显的观察到这些阶段:

2024-10-22 01:46:33,399 INFO org.apache.spark.scheduler.TaskSetManager - Starting task 752.0 in stage 3.0 (TID 756) (10.244.2.48, executor 4, partition 752, PROCESS_LOCAL, 4930 bytes) taskResourceAssignments Map()

2024-10-22 01:46:33,399 INFO org.apache.spark.scheduler.TaskSetManager - Finished task 744.0 in stage 3.0 (TID 748) in 3102 ms on 10.244.2.48 (executor 4) (744/755)

2024-10-22 01:46:33,635 INFO org.apache.spark.scheduler.TaskSetManager - Starting task 753.0 in stage 3.0 (TID 757) (10.244.2.47, executor 2, partition 753, PROCESS_LOCAL, 4930 bytes) taskResourceAssignments Map()

2024-10-22 01:46:33,636 INFO org.apache.spark.scheduler.TaskSetManager - Finished task 743.0 in stage 3.0 (TID 747) in 3485 ms on 10.244.2.47 (executor 2) (745/755)

2024-10-22 01:46:34,033 INFO org.apache.spark.scheduler.TaskSetManager - Starting task 754.0 in stage 3.0 (TID 758) (10.244.1.18, executor 9, partition 754, PROCESS_LOCAL, 4930 bytes) taskResourceAssignments Map()

2024-10-22 01:46:34,033 INFO org.apache.spark.scheduler.TaskSetManager - Finished task 745.0 in stage 3.0 (TID 749) in 3544 ms on 10.244.1.18 (executor 9) (746/755)

2024-10-22 01:46:34,358 INFO org.apache.spark.scheduler.TaskSetManager - Starting task 0.0 in stage 4.0 (TID 759) (10.244.3.180, executor 1, partition 0, PROCESS_LOCAL, 4944 bytes) taskResourceAssignments Map()

2024-10-22 01:46:34,358 INFO org.apache.spark.scheduler.TaskSetManager - Finished task 746.0 in stage 3.0 (TID 750) in 3324 ms on 10.244.3.180 (executor 1) (747/755)

2024-10-22 01:46:34,383 INFO org.apache.spark.storage.BlockManagerInfo - Added broadcast_6_piece0 in memory on 10.244.3.180:41365 (size: 16.5 KiB, free: 2.1 GiB)

2024-10-22 01:46:35,749 INFO org.apache.spark.scheduler.TaskSetManager - Finished task 747.0 in stage 3.0 (TID 751) in 3268 ms on 10.244.2.49 (executor 7) (748/755)

2024-10-22 01:46:35,828 INFO org.apache.spark.scheduler.TaskSetManager - Finished task 748.0 in stage 3.0 (TID 752) in 3327 ms on 10.244.1.16 (executor 3) (749/755)

2024-10-22 01:46:36,035 INFO org.apache.spark.scheduler.TaskSetManager - Finished task 749.0 in stage 3.0 (TID 753) in 3471 ms on 10.244.3.181 (executor 5) (750/755)

2024-10-22 01:46:36,480 INFO org.apache.spark.scheduler.TaskSetManager - Finished task 750.0 in stage 3.0 (TID 754) in 3544 ms on 10.244.1.17 (executor 6) (751/755)

2024-10-22 01:46:36,800 INFO org.apache.spark.scheduler.TaskSetManager - Finished task 0.0 in stage 4.0 (TID 759) in 2485 ms on 10.244.3.180 (executor 1) (1/1)

2024-10-22 01:46:36,843 INFO org.apache.spark.scheduler.TaskSchedulerImpl - Removed TaskSet 4.0, whose tasks have all completed, from pool

2024-10-22 01:46:36,834 INFO org.apache.spark.scheduler.DAGScheduler - ShuffleMapStage 4 (count at NativeMethodAccessorImpl.java:0) finished in 323.208 s

2024-10-22 01:46:36,825 INFO org.apache.spark.scheduler.DAGScheduler - looking for newly runnable stages

2024-10-22 01:46:36,803 INFO org.apache.spark.scheduler.DAGScheduler - running: Set(ShuffleMapStage 3)

2024-10-22 01:46:36,814 INFO org.apache.spark.scheduler.DAGScheduler - waiting: Set(ShuffleMapStage 5, ResultStage 6)

2024-10-22 01:46:36,837 INFO org.apache.spark.scheduler.DAGScheduler - failed: Set()

2024-10-22 01:46:36,903 INFO org.apache.spark.scheduler.TaskSetManager

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

165

165

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?