一、 安装hadoop

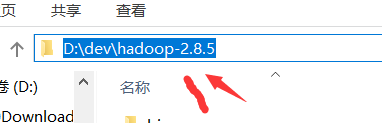

1.1下载hadoop2.8.5.tar.gz ,并解压到你想要的目录下,我放在D:\dev\hadoop-2.8.5

二、配置hadoop环境变量

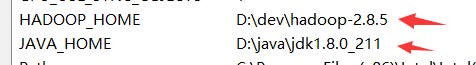

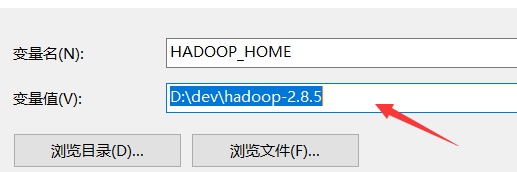

2.1 windows环境变量配置

右键单击我的电脑 –>属性 –>高级环境变量配置 –>高级选项卡 –>环境变量 –> 单击新建HADOOP_HOME,如下图

2.2接着编辑环境变量path,将hadoop的bin目录加入到后面;

三、修改hadoop配置文件

3.1编辑“D:\dev\hadoop-2.8.5\etc\hadoop”下的core-site.xml文件,将下列文本粘贴进去,并保存;

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>/D:/dev/hadoop-2.8.5/workplace/tmp</value>

</property>

<property>

<name>dfs.name.dir</name>

<value>/D:/dev/hadoop-2.8.5/workplace/name</value>

</property>

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

3.2 编辑“D:\dev\hadoop-2.8.5\etc\hadoop”目录下的mapred-site.xml(没有就将mapred-site.xml.template重命名为mapred-site.xml)文件,粘贴一下内容并保存

onfiguration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapred.job.tracker</name>

<value>hdfs://localhost:9001</value>

</property>

</configuration>

3.3编辑“D:\dev\hadoop-2.8.5\etc\hadoop”目录下的hdfs-site.xml文件,粘贴以下内容并保存。请自行创建data目录,在这里我是在HADOOP_HOME目录下创建了workplace/data目录;

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

<property>

<name>dfs.data.dir</name>

<value>/D:/dev/hadoop-2.8.5/workplace/data</value>

</property>

</configuration>

3.4编辑“D:\dev\hadoop-2.8.5\etc\hadoop”目录下的yarn-site.xml文件,粘贴以下内容并保存;

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

</configuration>

3.5编辑“D:\dev\hadoop-2.5.2\etc\hadoop”目录下的hadoop-env.cmd文件,将JAVA_HOME用 @rem注释掉,编辑为JAVA_HOME的路径,然后保存

@rem The java implementation to use. Required.

@rem set JAVA_HOME=%JAVA_HOME%

set JAVA_HOME=D:\java\jdk1.8.0_211

四、替换文件

下载到的hadooponwindows-master.zip,解压,将bin目录(包含以下.dll和.exe文件)文件替换原来hadoop目录下的bin目录;

五、运行环境

1.运行cmd窗口,执行“hdfs namenode -format”;

2.运行cmd窗口,切换到hadoop的sbin目录,执行“start-all.cmd”,它将会启动以下进程。

六,接下来上传测试,操作HDFS

根据你core-site.xml的配置,接下来你就可以通过:hdfs://localhost:9000来对hdfs进行操作了

创建输入目录

hadoop fs -mkdir hdfs://localhost:9000/user/

hadoop fs -mkdir hdfs://localhost:9000/user/wcinput

上传数据到目录

例子:

hadoop fs -put D:\樱花.txt hdfs://localhost:9000/user/input

hadoop fs -put D:\test.txt hdfs://localhost:9000/user/input

hadoop fs -put D:\3390.txt hdfs://localhost:9000/user/input

hadoop fs -put D:\出师表.txt hdfs://localhost:9000/user/input

3查看文件

hadoop fs -ls hdfs://localhost:9000/user/input

hadoop fs -ls hdfs://localhost:9000/user/wcinput

4在游览器查看上传的文件

本文详细介绍了在Windows 10环境下安装Hadoop 2.8.5的步骤,包括下载解压、配置环境变量、修改配置文件、替换必要文件以及运行和测试HDFS的过程。

本文详细介绍了在Windows 10环境下安装Hadoop 2.8.5的步骤,包括下载解压、配置环境变量、修改配置文件、替换必要文件以及运行和测试HDFS的过程。

878

878

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?