写在前面:

01,纯粹个人学习之用,不做任何商用。如有侵权,联系我删除。

02,个人能力有限,仅供参考,欢迎讨论,共同成长。

一. 论文信息

《PARE: Part Attention Regressor for 3D Human Body Estimation》

论文地址:https://arxiv.org/pdf/2104.08527.pdf

代码地址:https://github.com/mkocabas/PARE

二. 内容简介

论文研究内容:3D人体检测

论文作者相关:德国马普所大佬

论文创新点和架构:xdm自己研究

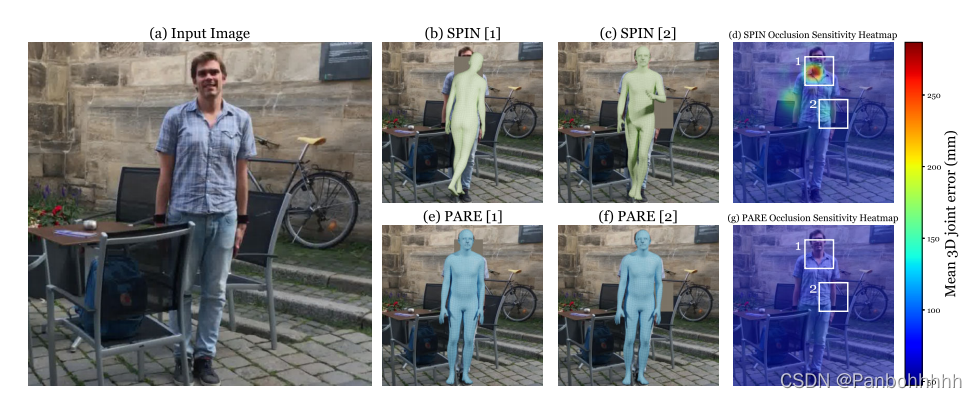

针对遮挡敏感性可视化模型, 使用了优化直接回归方法,论文中提到,首先以端到端的方式回归三维身体参数,学习每个身体部位的注意力权重,然后为了识别或者补全遮挡部分,论文中利用可见部分的像素对其图像特征,来补全图像,达到识别的效果。

细节我就不分析了,简单来说我也是看了论文效果图,给几个大家看看。

左边是原图,右边是效果图,通过对比可以得到,对于遮挡部分的补全,还是与实际逻辑吻合度比较高的。

三. 代码实现,推理自己的demo

需要具备炼丹成员的基础水准。

比如安装环境下载对应的包等等,简单来说。

第一步

git clone https://github.com/mkocabas/PARE.git在自己服务器上面先下载代码。

第二步

下载训练好的模型,

这里我把训练好的模型和数据放在网盘,叫我雷锋

链接:https://pan.baidu.com/s/1_z-Ycqaf6PMrGSwkTQMQ0A

提取码:ndiy

在目录下代码分布如下:

data/

├── body_models

│ └── smpl

├── dataset_extras

├── dataset_folders

│ ├── 3doh

│ └── 3dpw

└── pare

└── checkpoints

大家可以对照我的看一下。

然后执行命令

cd /PARE

python scripts/demo.py --vid_file data/sample_video.mp4 --output_folder logs/demo 就可以了。

完美,交差。

可以拿去给老师或者小伙伴们看看了。

END

-----------------------------------------------------------------------------------------------

声明:本文章仅供个人学习之用,由于作者能力有限,相关观点和信息仅供参考。

如有侵权请联系。

欢迎各位读者老爷提问和交流。

我们的目标是星辰大海!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?