卷积神经网络中的卷积核数目的探讨

转自我的知乎文章: https://zhuanlan.zhihu.com/p/666163655

今天来探讨一个卷积神经网络中卷积核数目的问题。

提出问题:

卷积神经网络广泛应用在计算机视觉(cv)领域。

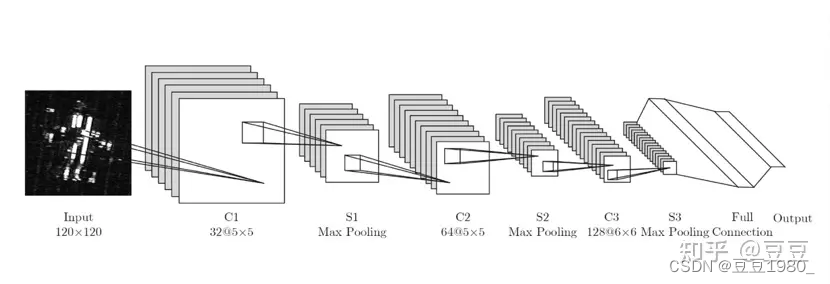

一般来说,一个经典的卷积神经网络架构如下:

随着层数的加深,特征图越来越小,对于原始图像的处理范围(感受野)越来越大,(如C1到C3所示),这个特点大家一般都会注意到。

但是另外一个特点,随着层数的加深,大体上卷积核的数量(卷积结果通道数)会越来越多,(仍然如C1到C3所示)一般人都会忽略掉。今天讨论的就是这个问题。

以alexnet为例,我们分别来看一下各卷积层卷积核的数量:

第一卷积层:96个卷积核

第二卷积层:256个卷积核

第三卷积层:384个卷积核

第四卷积层:384个卷积核

第五卷积层:256个卷积核

可以看到,从第一卷积层到第四卷积层,卷积核的数目从96增加到了384.(当然,最后一层又下降了。但不影响大体趋势)

那么问题来了?为什么会这样?为什么随着层数加深,卷积核数目越来越多?不变行不行?越来越少行不行?

我们来从卷积网络可视化的角度,从直觉上来解释一下。

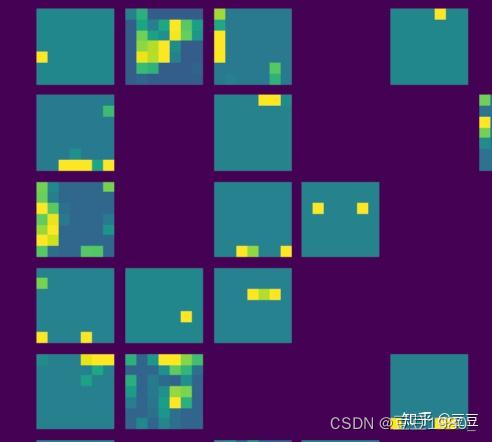

正如很多文档里描述的那样,把一个卷积网络各层的卷积核可视化之后,大体上都是类似这样:

低层的卷积核捕获到的是一些纹理、边缘等简单的几何信息:

越往高层,卷积核捕获到的是简单几何信息的组合信息:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

206

206

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?