目录

概述:

看下原文的描述,我英语比较差,只能看个大概意思,贴出原文,怕翻译错误。

文档地址

Getting Started with Distributed Data Parallel — PyTorch Tutorials 1.13.1+cu117 documentation

多机多卡:

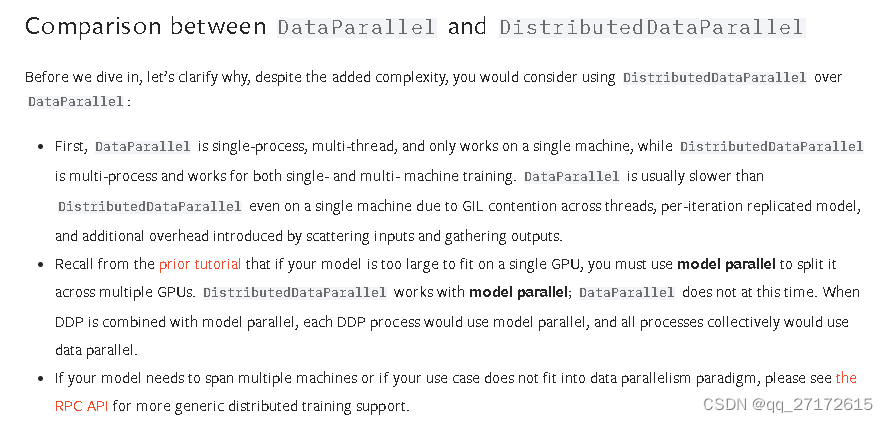

这里告诉我们为什么要使用ddp,它更快。

进程组初始化:

告诉我们必须设置进程组属性。

def setup(rank, world_size):

os.environ['MASTER_ADDR'] = 'localhost'

os.environ['MASTER_PORT'] = '12355'

# initialize the process group

dist.init_process_group("gloo", rank=rank, world_size=world_size)master_addr 很显然是主机地址, port是自己指定的。

它给的文档链接:

Writing Distributed Applications with PyTorch — PyTorch Tutorials 1.13.1+cu117 documentation

给出了多种不同的分布式策略。

点到点:

rank:是全局进程数, t0是数据。启动四个进程,将进程号为0的数据发送到 3号进程。

if __name__ == "__main__":

size = 2

processes = []

mp

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

8968

8968

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?