公司服务器到期想换个账号重新配置,服务器进行镜像迁移。

镜像迁移还是比较好的 这样的话环境什么的都不用配置了重新解析下 ip就行。

服务器供应商(Ucloud 网址:https://www.ucloud.cn/)

一、旧服务器创建镜像

创建镜像步骤: (创建镜像的时候服务器必须关机)

1.创建完镜像提交工单给服务商。

二、迁移到新的 Ucloud 新账号

1.和服务商售后技术联系。(提供新账号)

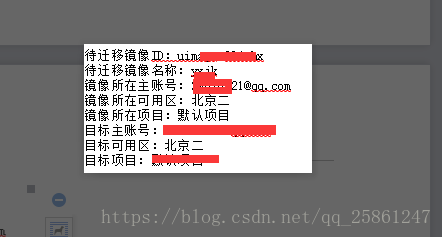

2.服务商迁移镜像到新的账号下面。

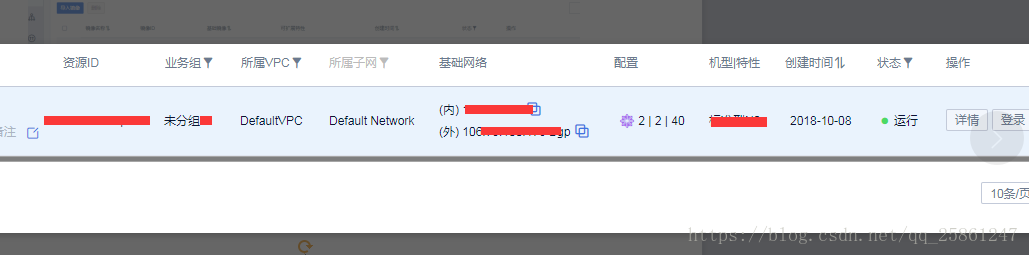

- 从镜像创建主机。(购买)

- 查看自己的新的服务器。

我们看下防火墙设置(主要是配置业务端口)

我们看下这个列表防火墙默认列表

- 非web服务器推荐

- Web服务器推荐

这两个端口不能进行修改和编辑。我们的业务需求肯定不只这些端口。因此我们自己创建一个防火墙设置端口,设置时候把默认的添加进来就行。

自己设置添加的端口下图:(根据业务需要配置端口就行)

三、域名解析

1.换了新服务器,ip地址肯定改变了 然后把我们新的IP地址解析到新的域名上面。

2.万网域名解析绑定。

本文详细介绍如何在Ucloud上进行服务器迁移,包括创建镜像、迁移到新账号、从镜像创建主机及配置防火墙的过程。同时,指导更换服务器后的域名解析步骤。

本文详细介绍如何在Ucloud上进行服务器迁移,包括创建镜像、迁移到新账号、从镜像创建主机及配置防火墙的过程。同时,指导更换服务器后的域名解析步骤。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?