线性回归于逻辑回归面试题

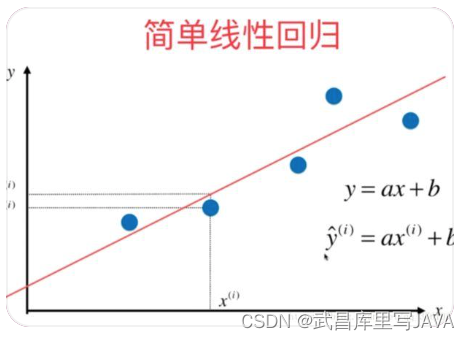

1. 简单介绍一下线性回归。

**线性回归(Linear Regression)是利用称为线性回归方程的最小平方函数对一个或多个自变量和因变量之间关系进行建模的一种回归分析。**这种函数是一个或多个称为回归系数的模型参数的线性组合。只有一个自变量的情况称为简单回归,大于一个自变量情况的叫做多元回归。

- 线性:两个变量之间的关系是一次函数关系的——图象是直线,叫做线性。

- 非线性:两个变量之间的关系不是一次函数关系的——图象不是直线,叫做非线性。

- 回归:人们在测量事物的时候因为客观条件所限,求得的都是测量值,而不是事物真实的值,为了能够得到真实值,无限次的进行测量,最后通过这些测量数据计算回归到真实值,这就是回归的由来。

线性回归就是利用的样本$D=(\mathrm{x}_i, \mathrm{y}_i)

,,, \mathrm{i}=1,2,3 \ldots \mathrm{N}, \mathrm{x}_i是特征数据,可能是一个,也可能是多个,通过有监督的学习,学习到由是特征数据,可能是一个,也可能是多个,通过有监督的学习,学习到由是特征数据,可能是一个,也可能是多个,通过有监督的学习,学习到由x到到到y的映射的映射的映射h,利用该映射关系对未知的数据进行预估,因为,利用该映射关系对未知的数据进行预估,因为,利用该映射关系对未知的数据进行预估,因为y$为连续值,所以是回归问题。

2. 线性回归的假设函数是什么形式?

线性回归的假设函数(θ0\theta_{0}θ0表示截距项,$ x_{0} = 1$,方便矩阵表达):

f(x)=θ0x0+θ1x1+θ2x2…+θnxn=θTX f(x)=\theta_{0} x_{0}+\theta_{1} x_{1}+\theta_{2} x_{2} \ldots+\theta_{n} x_{n} = \theta ^TX f(x)=θ0x0+θ1x1+θ2x2…+θnxn=θTX

其中θ,X\theta,Xθ,X都是列向量

3. 线性回归的损失函数是什么形式?

一般使用最小二乘法,真实值yiy_{i}yi,预测值hθ(x)h_θ(x)hθ(x),则误差平方为(yi−hθ(xi))2\left(y_{i}-h_{\theta}\left(x_{i}\right)\right)^{2}(yi−hθ(xi))2找到合适的参数,使得误差平方和最小

MSE:J(θ0,θ1)=12m∑i=1m(yi−hθ(xi))2 MSE: J\left(\theta_{0}, \theta_{1}\right)=\frac{1}{2 m} \sum_{i=1}^{m}\left(y_{i}-h_{\theta}\left(x_{i}\right)\right)^{2} MSE:J(θ0,θ1)=2m1i=1∑m(yi−hθ(xi))2

其中共有mmm个样本点,乘以1/2是为了方便计算。

4. 简述岭回归与Lasso回归以及使用场景。

-

目的:

-

解决线性回归出现的过拟合的请况。

-

解决在通过正规方程方法求解θ\thetaθ的过程中出现的XTXX^TXXTX不可逆的请况。

-

-

本质:

- 约束(限制)要优化的参数

这两种回归均通过在损失函数中引入正则化项来达到目的:

线性回归的损失函数:

J(θ)=12m∑i=1m(hθ(x(i))−y(i))2 J(\theta)=\frac{1}{2 m} \sum_{i=1}^{m}\left(h_{\theta}\left(x^{(i)}\right)-y^{(i)}\right)^{2} J(θ)=2m1i=1∑m(hθ

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?