-

形如:“ Error:(1, 8) Demo is already defined as object Demo ”问题

解决方法:File--Project Structures--Project Settings--Modules--*your project*--Sources--Sources

将自己所建工程底下的*src*文件夹取消*Sources*标记,仅将*scala*文件夹标记为*Sources*

- 在InterlliJ Idea中打入*import*后无智能提示(找不到相应的JAR包)

比如在IDE中输入“import org.apache.spark.SparkContext” 发现没有任何提示,更加高级的RDD操作算子更是无法显示,此时需要导入项目的依赖。

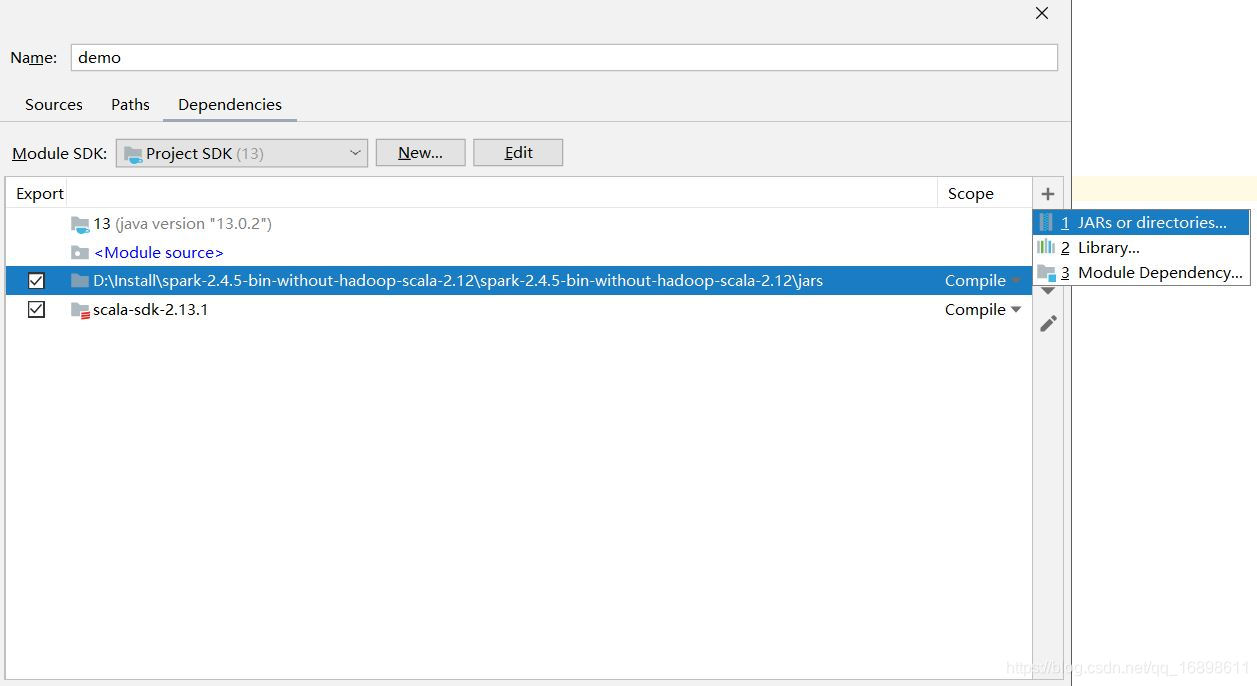

解决方法:File--Project Structures--Project Settings--Modules--*your project*--Sources--Dependencies

点击右侧的 “+” 号,选择 *1 JARs or directories*,根据自己下载到本地的*spark-2.4.5-bin-hadoop*包,具体到*jars*级目录,添加即可。

- 如何在本地打包scala程序生成JAR包

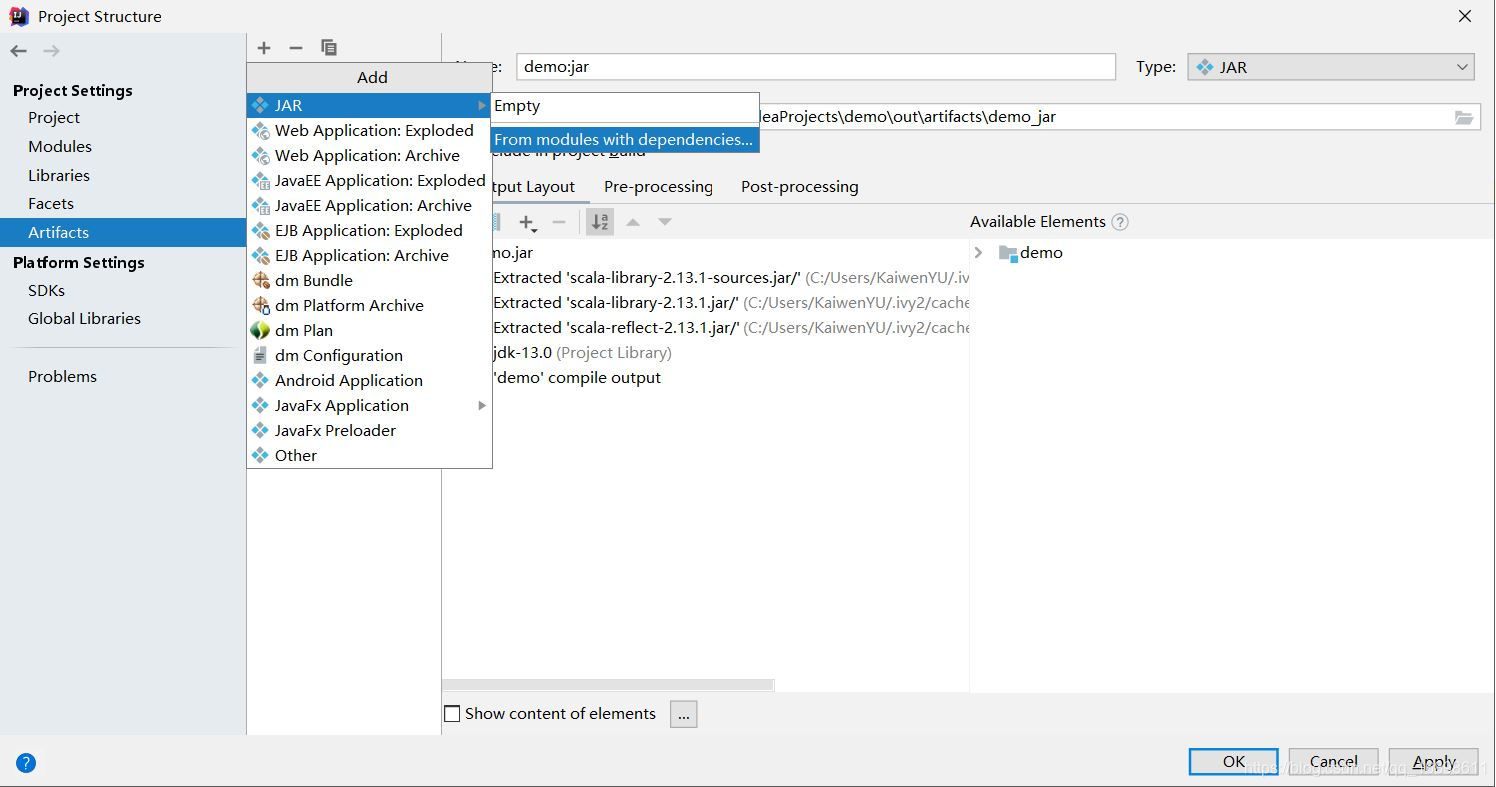

File--Project Structures--Project Settings--Artifacts--*点击+号*--*选择JAR*--“From modules with dependencies”

出现选择框之后,“Main Class”选择推荐值,选择OK。

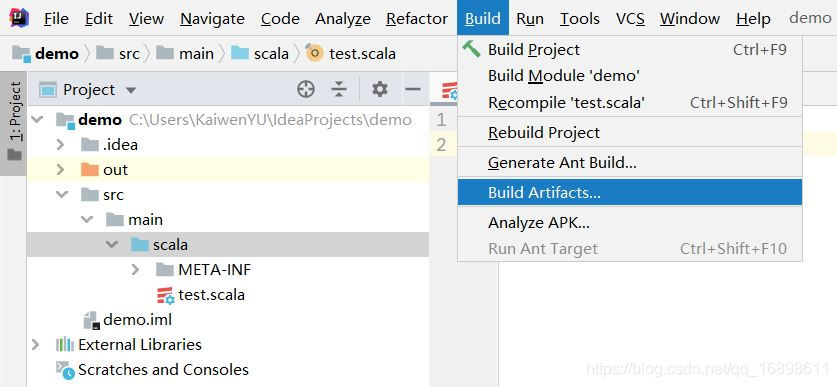

然后选择工具栏的*Build*--*Build Artifacts*便会自动将*.jar*文件生成在project的*out/artifacts/*目录下。

将JAR包上传到服务器集群上,通过spark-submit命令即可运行scala程序。

本文介绍了在使用IntelliJ IDEA进行Scala编程时遇到的两个问题及其解决方案:一是解决编译错误'Error:(1, 8) ... already defined as object... ',方法是调整模块的Sources标记;二是当IDE中无智能提示或找不到JAR包时,通过添加项目依赖来导入所需库。此外,还详细讲解了如何在IntelliJ IDEA中打包Scala程序生成JAR文件,并将其上传到服务器集群通过spark-submit运行。"

85067968,8033554,MySQL数据库误删恢复教程,"['数据库管理', 'MySQL恢复', '数据备份']

本文介绍了在使用IntelliJ IDEA进行Scala编程时遇到的两个问题及其解决方案:一是解决编译错误'Error:(1, 8) ... already defined as object... ',方法是调整模块的Sources标记;二是当IDE中无智能提示或找不到JAR包时,通过添加项目依赖来导入所需库。此外,还详细讲解了如何在IntelliJ IDEA中打包Scala程序生成JAR文件,并将其上传到服务器集群通过spark-submit运行。"

85067968,8033554,MySQL数据库误删恢复教程,"['数据库管理', 'MySQL恢复', '数据备份']

1402

1402

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?