Deepseek+Ollama 本地部署Deepseek

1 概述

DeepSeek是中国一家专注通用人工智能(AGI)研发的科技公司,基于自主研发的大模型核心技术,提供智能对话助手(如深度求索)、开放平台API接口及企业级解决方案,涵盖智能客服、数据分析、内容生成等场景应用。

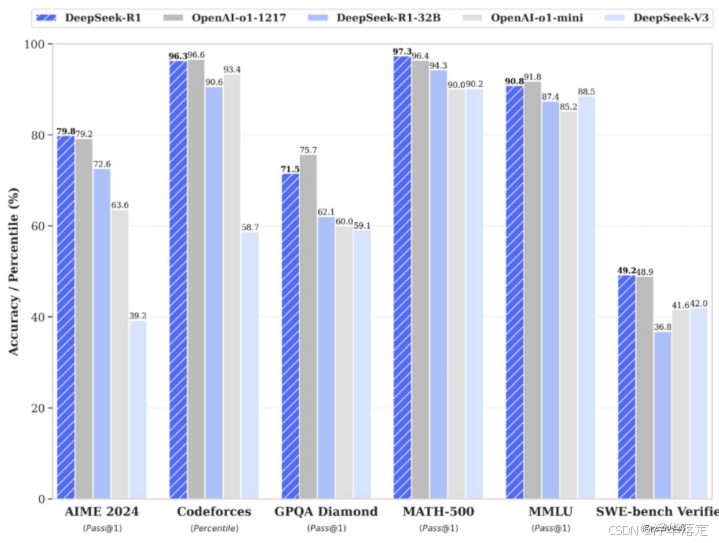

性能对齐OpenAI-o1正式版

DeepSeek-R1在后训练阶段大规模使用了强化学习技术,在仅有极少标注数据的情况下,极大提升了模型推理能力在数学、代码、自然语言推理等任务上,性能比肩OpenAI o1正式版。

原文链接:https://blog.youkuaiyun.com/weixin_66401877/article/details/145504773

DeepSeek是由中国的深度求索公司开发的一系列人工智能模型,以其高效的性能和低成本的训练而受到关注。以下是其主要介绍:

技术特点

- 混合专家架构(MoE):DeepSeek-V3采用MoE架构,总参数达6710亿,但每个输入只激活370亿参数,通过动态冗余策略,在推理和训练过程中保持最佳的负载平衡,大大降低了计算成本,同时保持高性能。

- 多头潜在注意力(MLA):引入多头潜在注意力机制,通过低秩联合压缩机制,将Key-Value矩阵压缩为低维潜在向量,显著减少内存占用。

- 无辅助损失负载均衡:采用无辅助损失负载均衡策略,最小化因鼓励负载均衡而导致的性能下降。

- 多Token预测(MTP):采用多Token预测目标,证明其对模型性能有益,并可用于推理加速。

- FP8混合精度训练:设计了FP8混合精度训练框架,首次验证了在极大规模模型上进行FP8训练的可行性和有效性。

- 知识蒸馏:DeepSeek-R1通过知识蒸馏,将长链推理(CoT)模型的推理能力蒸馏到标准LLM中,显著提升了推理性能。

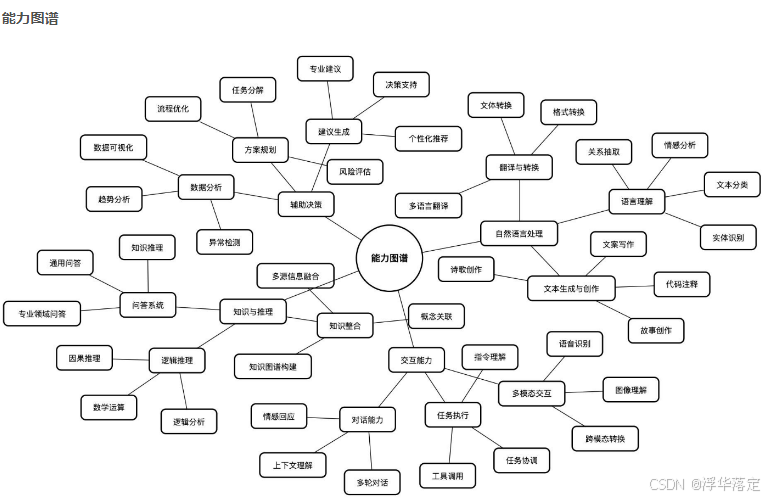

Deepseek功能

DeepSeek直接面向用户或者支持开发者,提供智能对话、文本生成、语义理解、计算推理、代码生成补全等应用场景,支持联网搜索与深度思考模式,同时支持文件上传,能够扫描读取各类文件及图片中的文字内容。

2 安装Ollama

2.1 下载Ollama

登录Ollama官网下载Ollama安装包

GitHub:https://github.com/ollama/ollama?tab=readme-ov-file

下载后双击安装

2.2 安装Ollama

Windows下安装Ollama很简单,双击运行安装文件即可,此处不赘述。

打开终端,输入ollama,出现下图所示代表安装成功

注意:

windows 的安装默认不支持修改程序安装目录,

默认安装后的目录:C:\Users\username\AppData\Local\Programs\Ollama

默认安装的模型目录:C:\Users\username\ .ollama

默认的配置文件目录:C:\Users\username\AppData\Local\Ollama

2.3 配置Ollama的模型路径

由于Ollama的模型默认会在C盘用户文件夹下的.ollama/models文件夹中,可以配置环境变量OLLAMA_MODELS,设置为指定的路径:

2.4 下载llama3模型

llama3目前主要有8B和70B两个模型,分别代表80亿和700亿个训练参数。

8B模型一般16GB内存就可以跑的很流畅,70B模型则至少需要64GB内存,有CPU就可以跑,当然有GPU更好。

这里我安装的是8B的模型。

打开终端,输入命令:ollama run llama3默认安装8B模型,也可以使用ollama run llama3:8b来指定相应的模型,安装成功会有如下提示:

提问题,发现该模型给了不太靠谱的回复。

当然也可以写代码

至此,llama3本地部署已完成。

注意1:

在没有互联网的环境下部署,可以将下载好的Ollama安装包复制到此环境安装,然后将下载好的模型复制到相应路径就可以在无互联网的环境下使用。

注意2:

由于llama3对中文的支持并不是很好,需要中文的可以使用GitHub上开源的这个llama3中文微调模型https://github.com/LlamaFamily/Llama-Chinese

启动ollama

3 部署Deepseek-r1

部署deepseek-r1模型

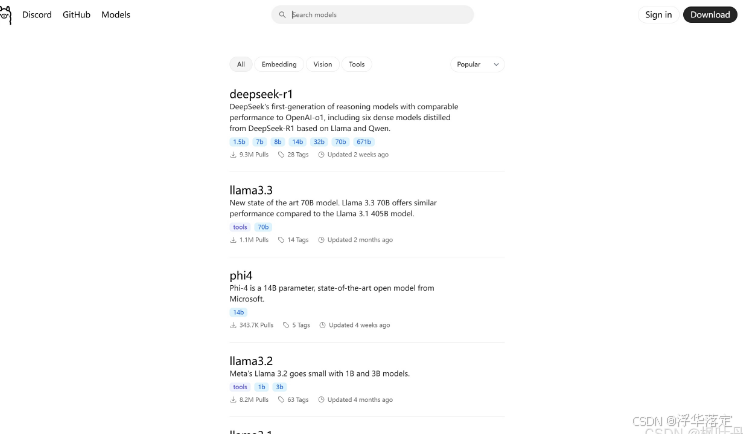

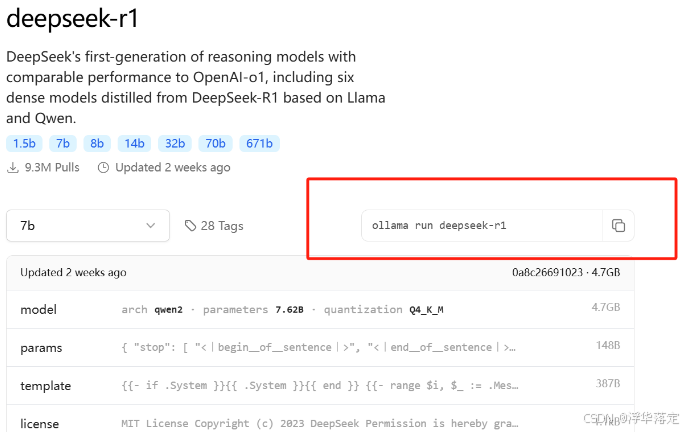

回到ollama官网点击左上角的Models进入如下界面。并选择第一个deepseek-r1,点击进入

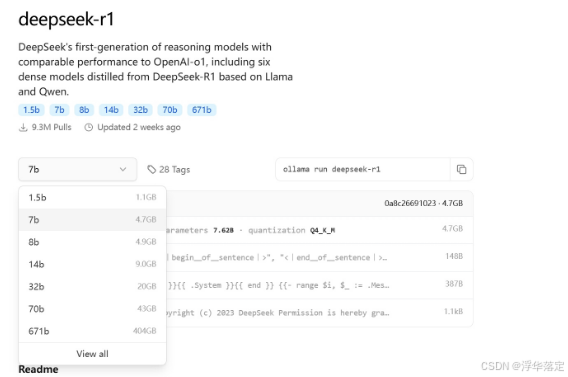

选择适合自己电脑配置的版本

选择好后,复制对应版本后的命令

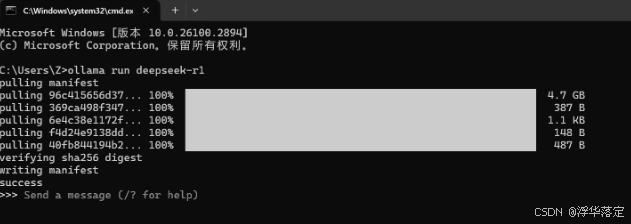

win+R输入cmd调出命令行进入到命令模式,输入命令

如果觉得下载速度慢,可以Ctrl+C先退出这个命令,然后再输入命令重新进行下载,还是会接着上次的下载进度继续下载,速度会稍微快一些。

下载完成后会出现success,接下来就可以进行对话了

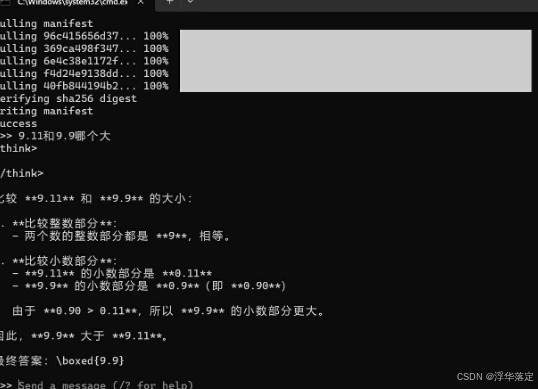

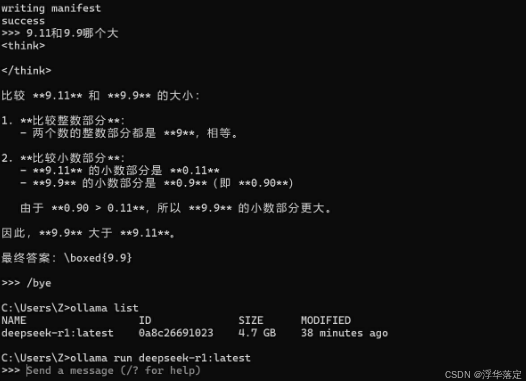

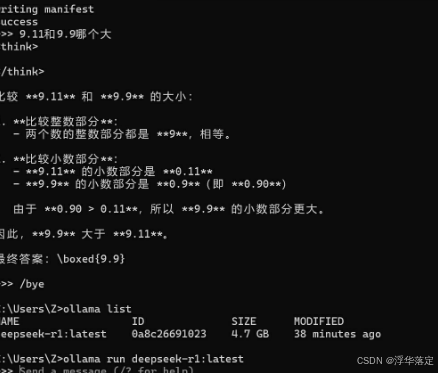

问一个AI经常会出错的问题:9.11和9.9哪个大

可以看到,会给出思考过程以及最终结论。

输入命令/bye可以退出对话

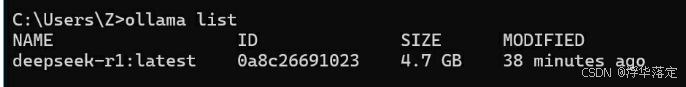

输入命令ollama list可以查看下载好的模型

输入ollama run + 对应的模型就可以进入对话

这里输入ollama run deepseek-r1:latest可以发现再一次进入对话。

这样本地部署deepseek就算完成啦

14万+

14万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?