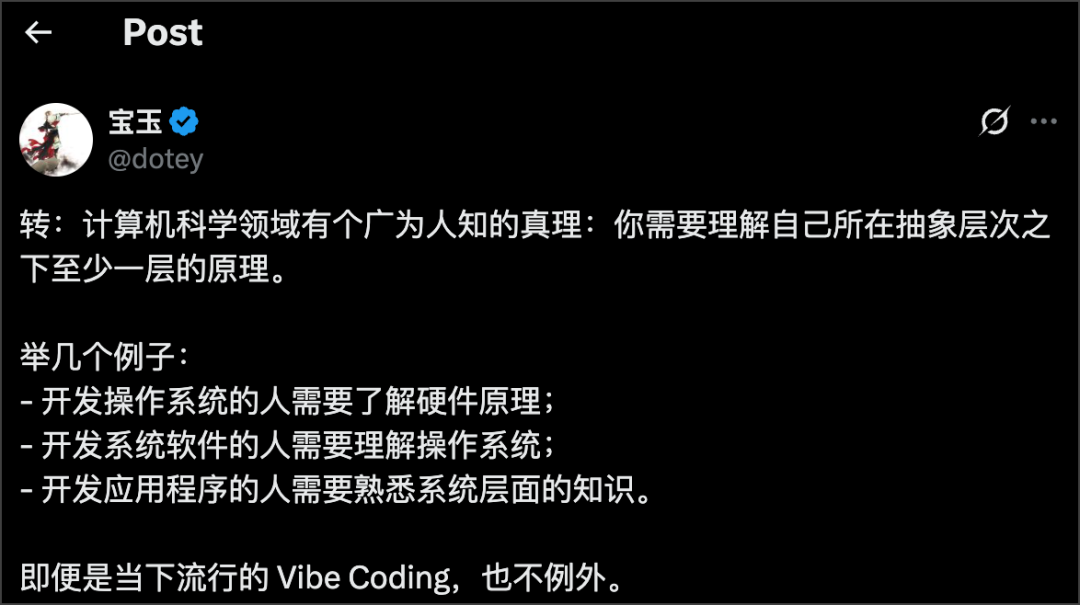

看到宝玉老师转载的这段话,想到作为 Gopher 的我们。

说句扎心的大实话,咱们很多所谓的“后端开发”,本质上干的是“API调用和业务逻辑翻译”的活儿。

老板给你个需求,你用 Gin 搭个 Web 框架,用 GORM 调一下数据库,往 Kafka 里丢个消息,然后用 Docker 打包扔到 K8s 上。一套操作行云流水,需求完成了,测试通过了,好像也没什么问题。

直到有一天,你碰到了硬茬子:

服务突然出现周期性卡顿,每次几十到几百毫秒,监控上啥也看不出来,最后查了两天,发现是内存里某个大对象频繁拷贝,把垃圾回收(GC)给逼急了。

一个接口在线上环境的性能,死活达不到压测时的一半。你把代码逻辑优化到不能再优化,最后发现是 K8s 的 CPU limit 设得太低,调度器把你的进程反复挂起和恢复。

你写的并发程序,在本地跑得飞快,一上生产环境就出各种诡异的 data race(数据竞争)。你加了一堆锁,性能又掉回了单线程时代。

发现没?这些问题的根源,压根儿就不在你写的那些 if/else 或者 for 循环里。它们藏在你调用的那些函数、那些工具的“下面”那层。

你对“下面”一无所知,所以你解决问题,就只能靠猜、靠搜、靠拜菩萨。

捅破那层“窗户纸”:你的技术到底在哪一层?

想从一个“能干活”的程序员,变成一个“能解决难题”的专家,没啥捷径,就是得往下走,去理解你所依赖的东西。计算机科学的体系,说白了就是这么几层:

应用层: 你写的业务代码。

系统软件层: 你用的数据库(MySQL)、缓存(Redis)、容器(Docker)、消息队列(Kafka)。

操作系统层: 你代码跑在上面的那个东西,大概率是 Linux。

硬件层: CPU、内存条、硬盘、网卡。

“你需要理解自己所在抽象层次之下至少一层的原理”,这句话不是什么名人名言,而是血泪教训。对咱们 Golang 后端来说,就是要搞懂你的代码和“系统软件/操作系统”这两层是怎么打交道的。

硬核干货:一个Golang后端应该“往下”懂些什么?

别嫌烦,这些东西才是你涨薪的核心竞争力。

第一部分:解剖Go本身——别把它当黑盒

Go 语言本身就是你最贴身的“下一层”。Go 团队给你打包了非常强大的运行时(Runtime),你得把它拆开看。

Goroutine 调度模型: 天天说 Go 并发牛,牛在哪?你得去看懂 G-M-P 模型。

G (Goroutine): 就是你写的

go func(),它只是个待执行的任务。M (Machine): 代表操作系统的线程。

P (Processor): 调度器,负责把 G 扔到 M 上去执行。

你要搞懂: 为什么

GOMAXPROCS这个环境变量能影响性能?一个 Goroutine 如果执行了阻塞的系统调用(比如文件读写),调度器是怎么把 P 和其他 G “偷走”,交给别的 M 去运行的?理解了这个,你才能写出真正高效的并发程序,而不是一堆“看起来并发”的代码。

内存分配和垃圾回收(GC):

你要搞懂: 什么是栈(Stack)和堆(Heap)?Go 的编译器如何做逃逸分析,决定一个变量是放在开销极低的栈上,还是扔到需要 GC 清理的堆上?你代码里那些不经意的大对象、频繁的

append,是怎么一步步把堆内存撑爆,导致 GC 像个老妈子一样频繁出来打扫卫生(而且一打扫你就得停下所有活儿)的。

第二部分:看透你脚下的平台——操作系统和系统软件

你的 Go 程序,最终是跑在 Linux 上的,跟一堆工具打交道。

操作系统这层“纸”必须捅破:

网络IO模型: 你用 Gin 写的 Web 服务,为什么能同时处理成千上万的连接?因为它底层用了操作系统的 **

epoll**(在 Linux 上)。Go 的网络库(netpoller)就是基于它,用极少的线程,管理海量的网络连接。你不懂epoll,你就无法真正理解异步非阻塞的精髓。系统调用(Syscall): 你每一次读写文件、收发网络包,程序都会从“用户态”切换到“内核态”,让操作系统老大哥帮你干脏活累活。这个切换是有成本的!理解了这一点,你才会明白为什么有时候一次性读一个大文件,比零敲碎打地读一万次小文件要快得多。

Page Cache(页缓存): 你以为你读写的是硬盘?其实大部分时候你操作的都是内存里的 Page Cache。理解这个OS级别的缓存,能让你明白为什么第一次读文件很慢,后面就飞快,以及数据库的性能调优跟它有什么关系。

你依赖的那些“外部势力”:

数据库: 别再只会

SELECT *了。你必须学会用EXPLAIN去分析你的 SQL 查询计划。要知道为什么加个索引就能让查询快几百倍,它的底层是 B+ 树。要知道什么是事务隔离级别,为什么在高并发下会出现脏读、幻读,以及你的数据库是怎么用 MVCC(多版本并发控制)来尽量避免加锁的。容器(Docker/K8s): K8s 把你的程序干掉,日志里只留下一句

OOMKilled,你不能两手一摊。你得知道 Cgroups 是如何限制你进程的CPU和内存的,requests和limits的区别是什么,以及为什么一个不合理的limit设置,会让你的程序性能变得极其诡异。

“那我需要懂硬件吗?”——别用战术上的勤奋,掩盖战略上的懒惰

总有人喜欢抬杠:“那按你这么说,我是不是得把CPU的指令集都背下来?”

别钻牛角尖。让你先往下看一两层,是因为这是解决你 99% 问题的最高效路径。

你现在暂时不需要深入硬件,是基于几个现实:

分工: Go 编译器和操作系统内核的开发者,就是干“硬件翻译”的活的。他们已经把硬件的复杂性最大程度地屏蔽了。你得先相信他们的专业性。

投入产出比(ROI): 你花一天搞懂了数据库索引,服务性能可能翻倍。你花一个月研究 CPU 缓存行,性能可能提升 3%。哪个划算?

环境决定: 在云时代,硬件对你来说是个黑盒,你连你代码跑在哪颗 CPU 上都不知道。关心云厂商提供的虚拟化规格,比关心物理硬件本身更实际。

先把地基打牢,再去想挖地下室的事。

总结

停止做一个只会“调用”的程序员。

把你的每一次线上事故,都当成一次深入“下一层”的探险机会。

当你能从一串 GC 日志里,反推出代码的内存问题;当你看到一个慢查询,脑子里能浮现出它的 B+ 树查找路径;当你排查线上问题,能熟练地在应用、容器、系统这几个层面来回切换视角时——

那时候,所谓的“瓶颈”自然就消失了。而你,也早已不是那个只会写业务逻辑的你了。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?