一句话让我运行了一晚上!

很气!

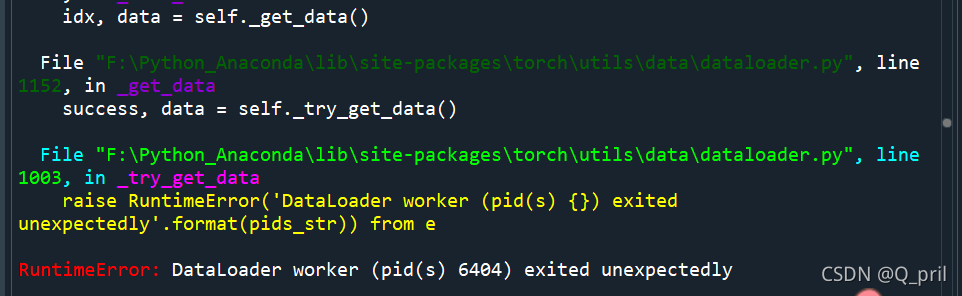

报错如图,通过各种百度&优快云,终于解决了!

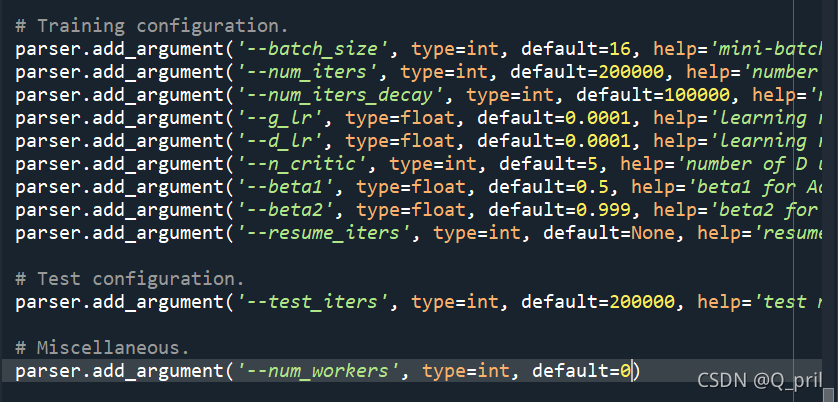

走了很多弯路,问题的关键不是batch_size,而是num_size

有份回答说Windows系统下要将num_size设置为0,我觉得不能以偏概全,因为我队友Windows系统下num_size为1,也正常运行了;

但对于我这个情况确实要把num_size改为0,之后就可以正常运行啦

这边有一份详细解答和分析,记录一下~

Pytorch中Dataloader踩坑:RuntimeError: DataLoader worker (pid(s) 6700, 10620) exited unexpectedly

博客作者分享了在使用Pytorch时遇到Dataloader运行错误的经历,经过一晚上的排查,发现错误并非由batch_size引起,而是num_size。解决方案是将num_size设为0,但指出这不适用于所有Windows系统。文中还提供了详细的解答链接,以帮助遇到类似问题的开发者。

博客作者分享了在使用Pytorch时遇到Dataloader运行错误的经历,经过一晚上的排查,发现错误并非由batch_size引起,而是num_size。解决方案是将num_size设为0,但指出这不适用于所有Windows系统。文中还提供了详细的解答链接,以帮助遇到类似问题的开发者。

1782

1782

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?