文章目录

前言

本文目的:根据本人的习惯与理解,用最简洁的表述,介绍爬虫的定义、组成部分、爬取流程,并讲解示例代码。

基础

爬虫的定义:定向抓取互联网内容(大部分为网页)、并进行自动化数据处理的程序。主要用于对松散的海量信息进行收集和结构化处理,为数据分析和挖掘提供原材料。

今日t条就是一只巨大的“爬虫”。

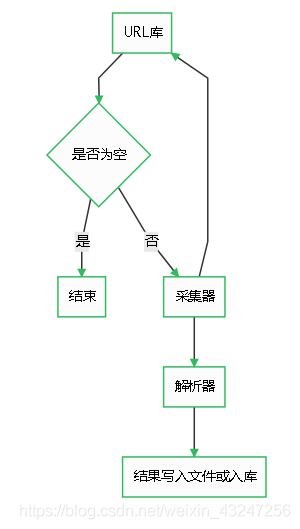

爬虫由URL库、采集器、解析器组成。

流程

如果待爬取的url库不为空,采集器会自动爬取相关内容,并将结果给到解析器,解析器提取目标内容后进行写入文件或入库等操作。

代码

第一步:写一个采集器

如下是一个比较简单的采集器函数。需要用到requests库。

首先,构造一个http的header,里面有浏览器和操作系统等信息。如果没有这个伪造的header,可能会被目标网站的WAF等防护设备识别为机器代码并干掉。

然后,用requests库的get方法获取url内容。如果http响应代码是200 ok,说明页面访问正常,将该函数返回值设置为文本形式的html代码内容。

如果响应代码不是200 ok,说明页面不能正常访问,将函数返回值设置为特殊字符串或代码。

import requests

def get\_page(url):

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/75.0.3770.142 Safari/537.36'}

response = requests.get(url, headers= headers)

if response.status\_code == 200:

return response.text

else:

return 'GET HTML ERROR !'

第二步:解析器

解析器的作用是对采集器返回的html代码进行过滤筛选,提取需要的内容。

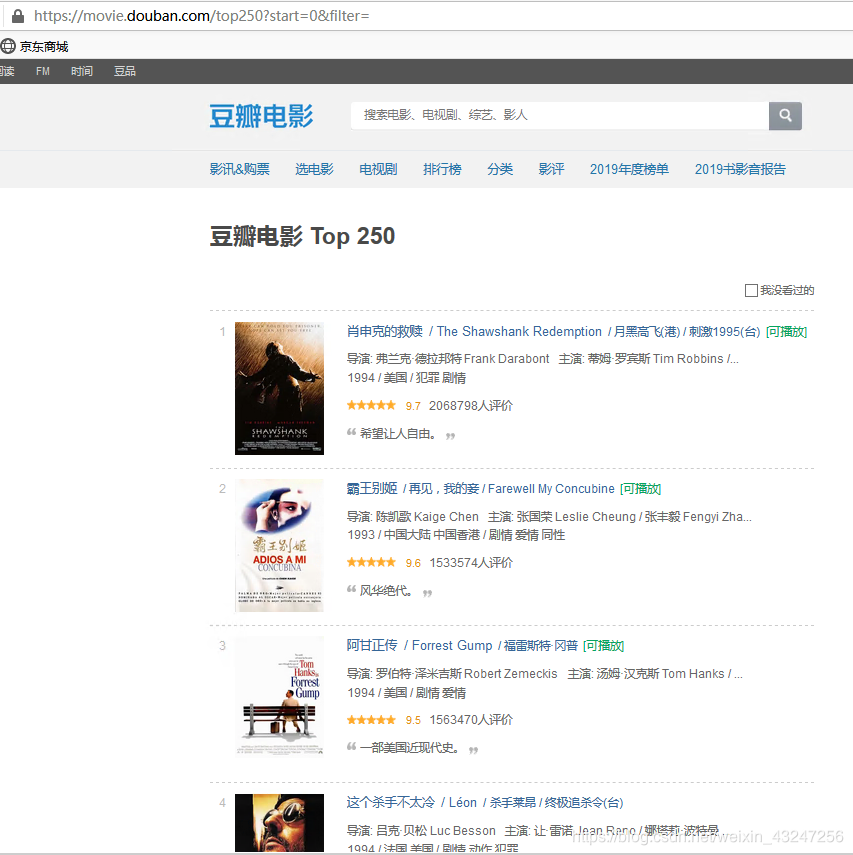

作为一个14年忠实用户,当然要用豆瓣举个栗子 _

我们计划爬取豆瓣排名TOP250电影的8个参数:排名、电影url链接、电影名称、导演、上映年份、国家、影片类型、评分。整理成字典并写入文本文件。

待爬取的页面如下,每个页面包括25部电影,共计10个页面。

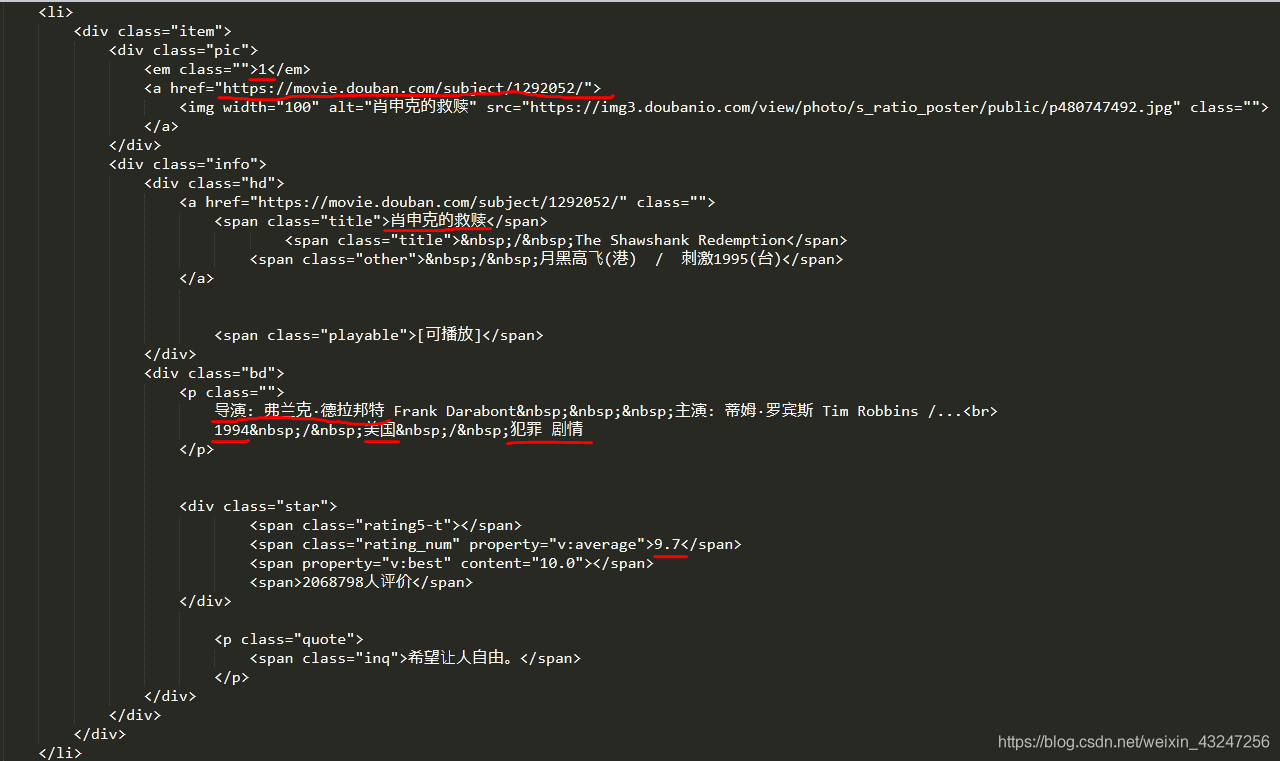

在这里,必须要表扬豆瓣的前端工程师们,html标签排版非常工整具有层次,非常便于信息提取。

下面是“肖申克的救赎”所对应的html代码:(需要提取的8个参数用红线标注)

根据上面的html编写解析器函数,提取8个字段。该函数返回值是一个可迭代的序列。

我个人喜欢用re(正则表达式)提取内容。8个(.*?)分别对应需要提取的字段。

import re

def parse\_page(html):

pattern = re.compile('<em class="">(.\*?)</em>.\*?<a href="(.\*?)" rel="external nofollow" rel="external nofollow" >.\*?<span class="title">(.\*?)</span>.\*?<div class="bd">.\*?<p class="">(.\*?) .\*?<br>(.\*?) / (.\*?) / (.\*?)</p>.\*?<span class="rating\_num".\*?"v:average">(.\*?)</span>' , re.S)

items = re.findall(pattern , html)

for item in items:

yield {

'rank': item\[0\],

'href': item\[1\],

'name': item\[2\],

'director': item\[3\].strip()\[4:\],

'year': item\[4\].strip(),

'country': item\[5\].strip(),

'style': item\[6\].strip(),

'score': item\[7\].strip()

}

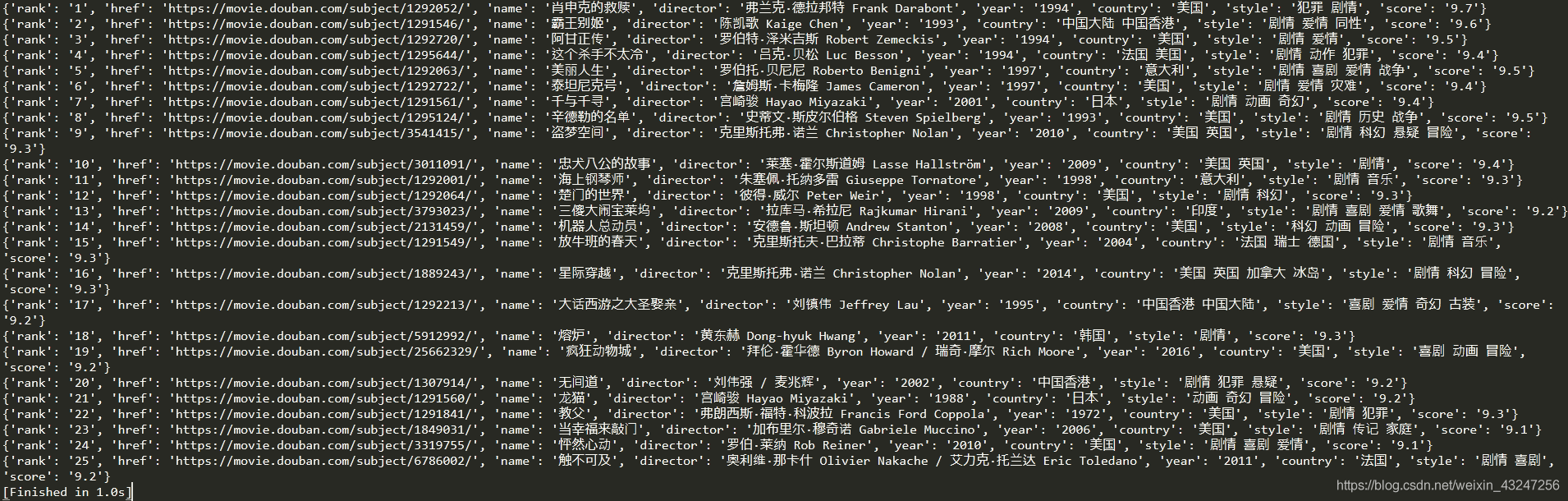

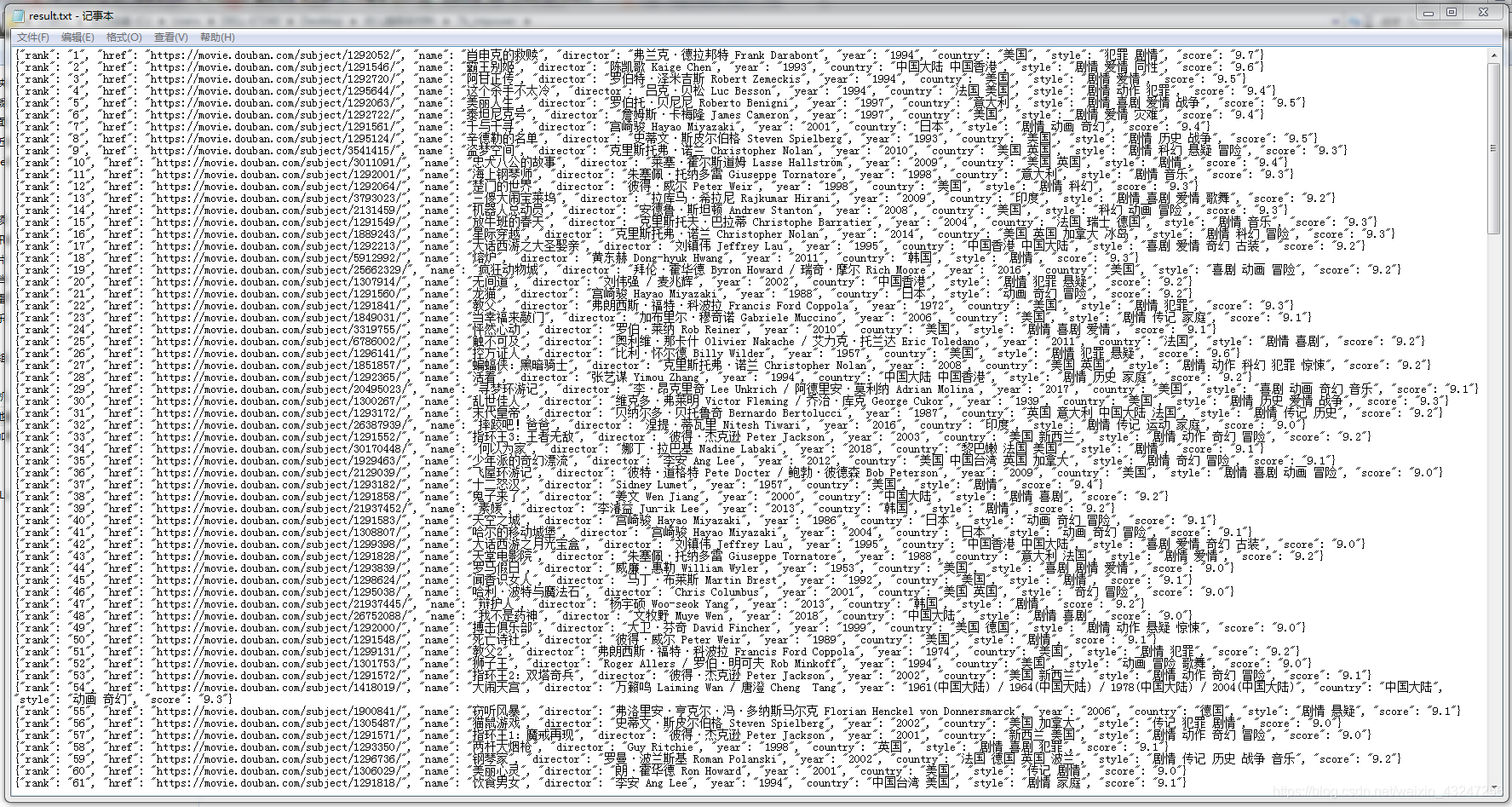

提取后的内容如下:

整理成完整的代码:(暂不考虑容错)

import requests

import re

import json

def get\_page(url):

#采集器函数

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/75.0.3770.142 Safari/537.36'}

response = requests.get(url, headers= headers)

if response.status\_code == 200:

return response.text

else:

return 'GET HTML ERROR ! '

def parse\_page(html):

#解析器函数

pattern = re.compile('<em class="">(.\*?)</em>.\*?<a href="(.\*?)" rel="external nofollow" rel="external nofollow" >.\*?<span class="title">(.\*?)</span>.\*?<div class="bd">.\*?<p class="">(.\*?) .\*?<br>(.\*?) / (.\*?) / (.\*?)</p>.\*?<span class="rating\_num".\*?"v:average">(.\*?)</span>' , re.S)

items = re.findall(pattern , html)

for item in items:

yield {

'rank': item\[0\],

'href': item\[1\],

'name': item\[2\],

'director': item\[3\].strip()\[4:\],

'year': item\[4\].strip(),

'country': item\[5\].strip(),

'style': item\[6\].strip(),

'score': item\[7\].strip()

}

def write\_to\_file(content):

#写入文件函数

with open('result.txt' , 'a' , encoding = 'utf-8') as file:

file.write(json.dumps(content , ensure\_ascii = False) + '\\n')

if \_\_name\_\_== "\_\_main\_\_":

# 主程序

for i in range(10):

url= 'https://movie.douban.com/top250?start='+ str(i\*25)+ '&filter'

for res in parse\_page(get\_page(url)):

write\_to\_file(res)

非常简洁,非常符合python简单、高效的特点。

说明:

需要掌握待爬取url的规律,才能利用for循环等操作自动化处理。

前25部影片的url是https://movie.douban.com/top250?start=0&filter,第26-50部影片url是https://movie.douban.com/top250?start=25&filter。规律就在start参数,将start依次设置为0、25、50、75。。。225,就能获取所有页面的链接。parse_page函数的返回值是一个可迭代序列,可以理解为字典的集合。运行完成后,会在程序同目录生成result.txt文件。内容如下:

关于Python技术储备

学好 Python 不论是就业还是做副业赚钱都不错,但要学会 Python 还是要有一个学习规划。最后大家分享一份全套的 Python 学习资料,给那些想学习 Python 的小伙伴们一点帮助!

👉优快云大礼包:《Python入门资料&实战源码&安装工具】免费领取(安全链接,放心点击)

一、Python所有方向的学习路线

Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

二、Python基础学习视频

② 路线对应学习视频

还有很多适合0基础入门的学习视频,有了这些视频,轻轻松松上手Python~在这里插入图片描述

③练习题

每节视频课后,都有对应的练习题哦,可以检验学习成果哈哈!

因篇幅有限,仅展示部分资料

三、精品Python学习书籍

当我学到一定基础,有自己的理解能力的时候,会去阅读一些前辈整理的书籍或者手写的笔记资料,这些笔记详细记载了他们对一些技术点的理解,这些理解是比较独到,可以学到不一样的思路。

四、Python工具包+项目源码合集

①Python工具包

学习Python常用的开发软件都在这里了!每个都有详细的安装教程,保证你可以安装成功哦!

②Python实战案例

光学理论是没用的,要学会跟着一起敲代码,动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。100+实战案例源码等你来拿!

③Python小游戏源码

如果觉得上面的实战案例有点枯燥,可以试试自己用Python编写小游戏,让你的学习过程中增添一点趣味!

五、面试资料

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

六、Python兼职渠道

而且学会Python以后,还可以在各大兼职平台接单赚钱,各种兼职渠道+兼职注意事项+如何和客户沟通,我都整理成文档了。

这份完整版的Python全套学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

Python爬虫入门:定义、代码示例与学习资源,

Python爬虫入门:定义、代码示例与学习资源,

本文介绍了Python爬虫的基本概念,包括爬虫的组成部分和工作流程,提供了使用requests库的简单示例。同时,给出了Python学习路线、视频教程、书籍推荐、工具包与实战项目等内容,以及面试准备和兼职机会。

本文介绍了Python爬虫的基本概念,包括爬虫的组成部分和工作流程,提供了使用requests库的简单示例。同时,给出了Python学习路线、视频教程、书籍推荐、工具包与实战项目等内容,以及面试准备和兼职机会。

71万+

71万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?