一、基本概念

1.贝尔曼公式

推导过程:

第一项:

第二项:

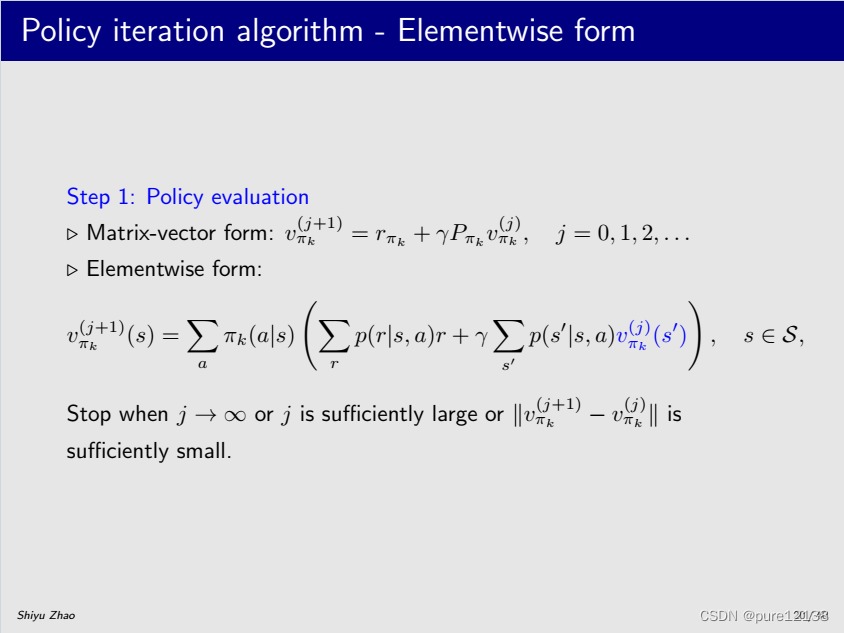

elementwise form

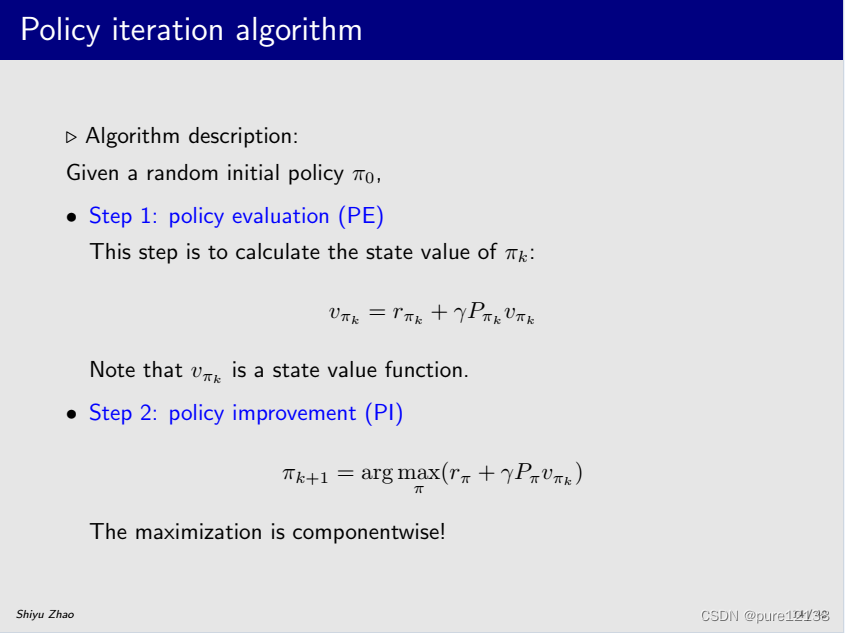

matrix-vector form

2.贝尔曼最优公式

elementwise form

matrix-vector form

Solution:使用Value iteration

3.State value

定义:

elementwise form

Solution:使用贝尔曼公式

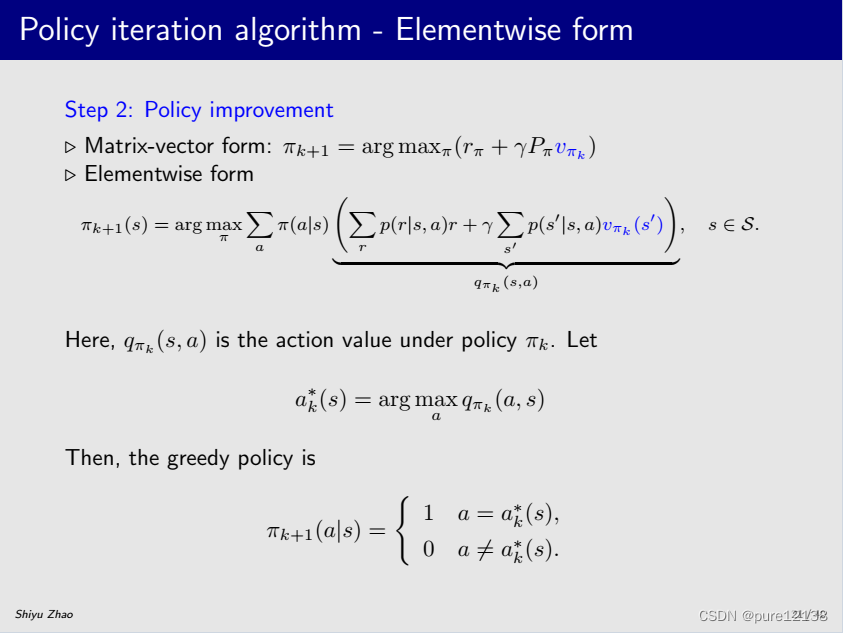

4.Action value

定义:

根据下面公式

即

得到

elementwise form

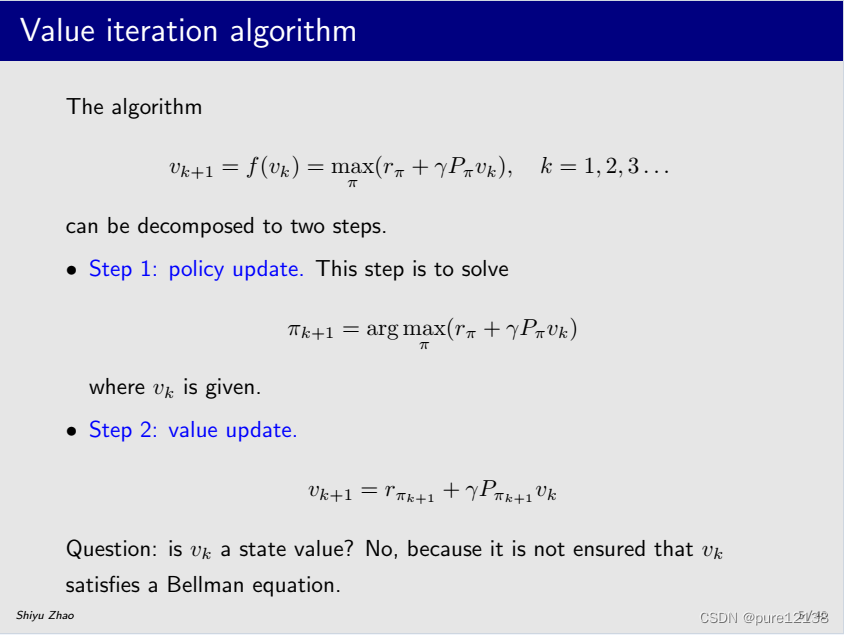

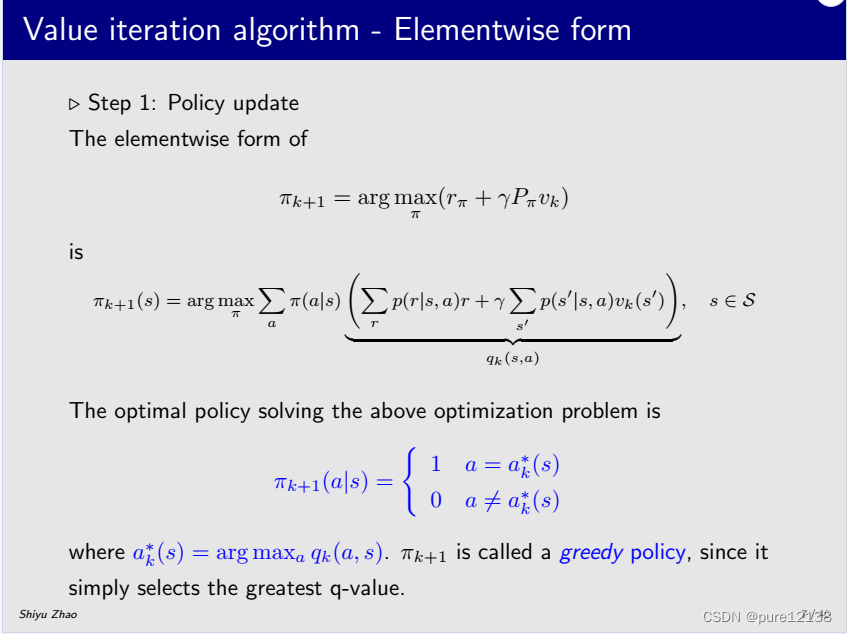

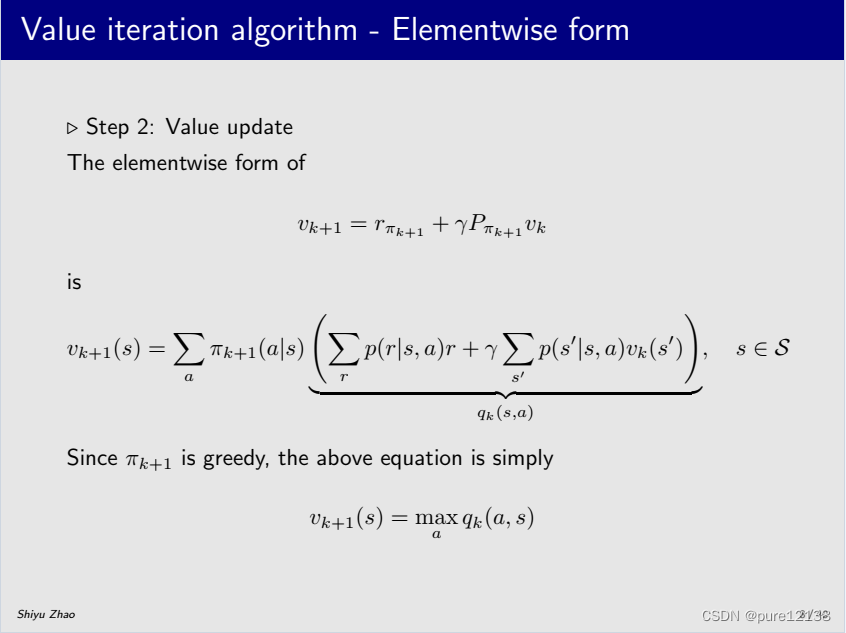

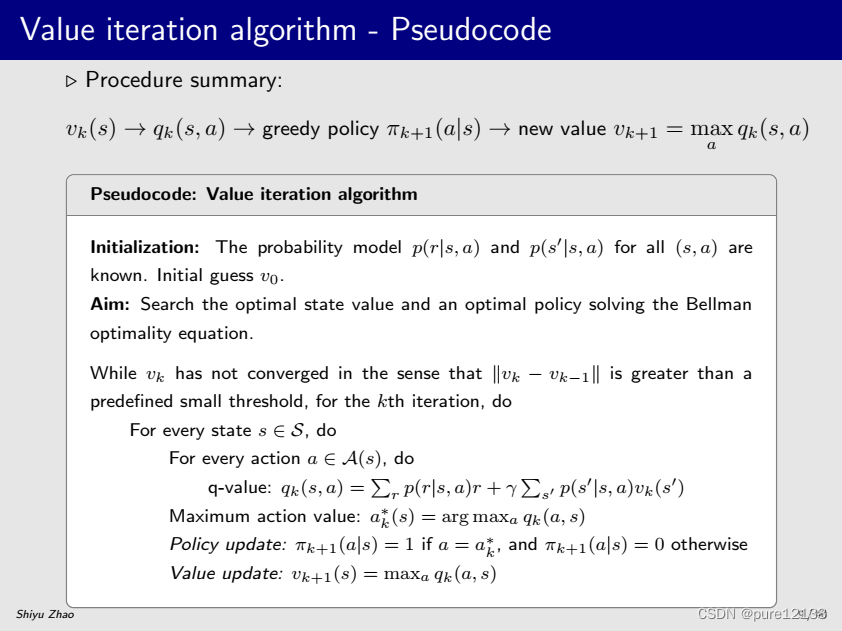

5.Value iteration

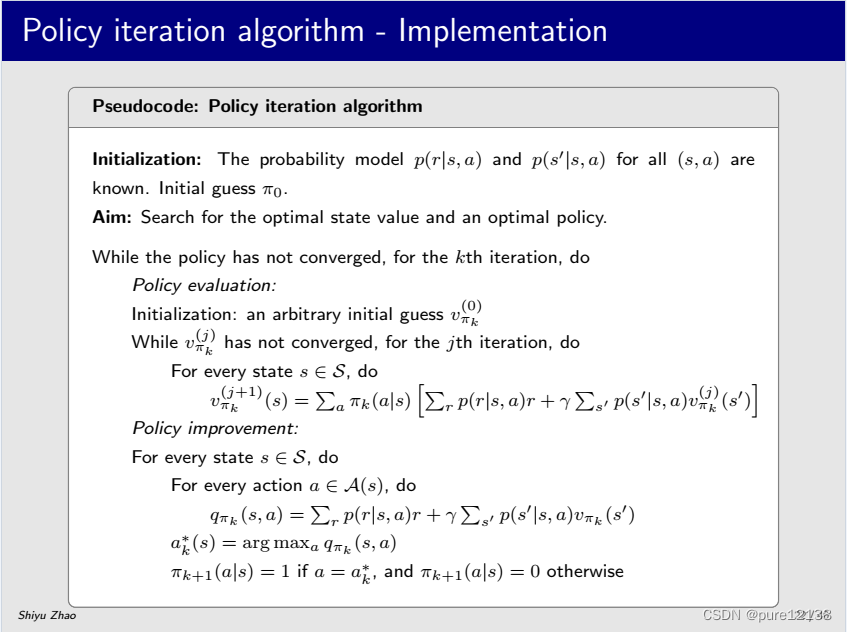

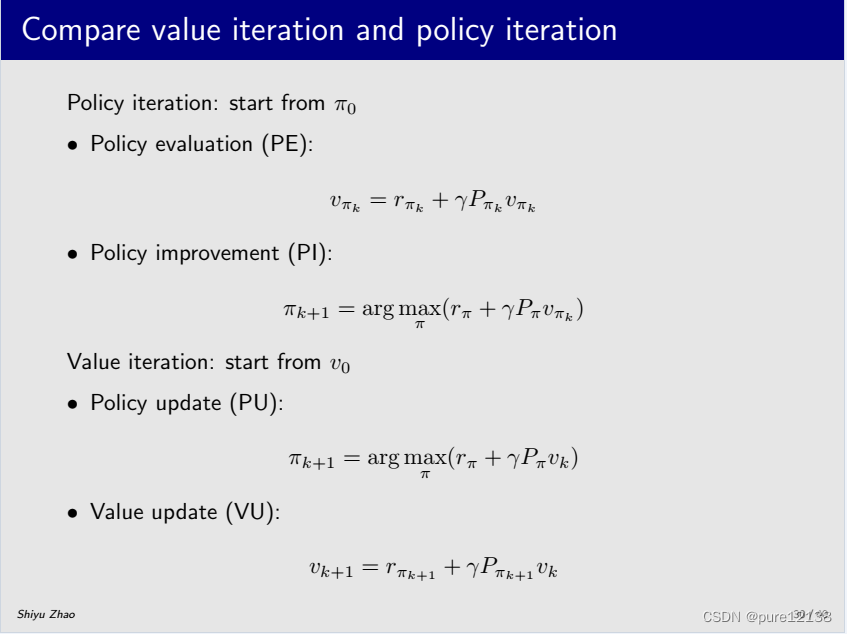

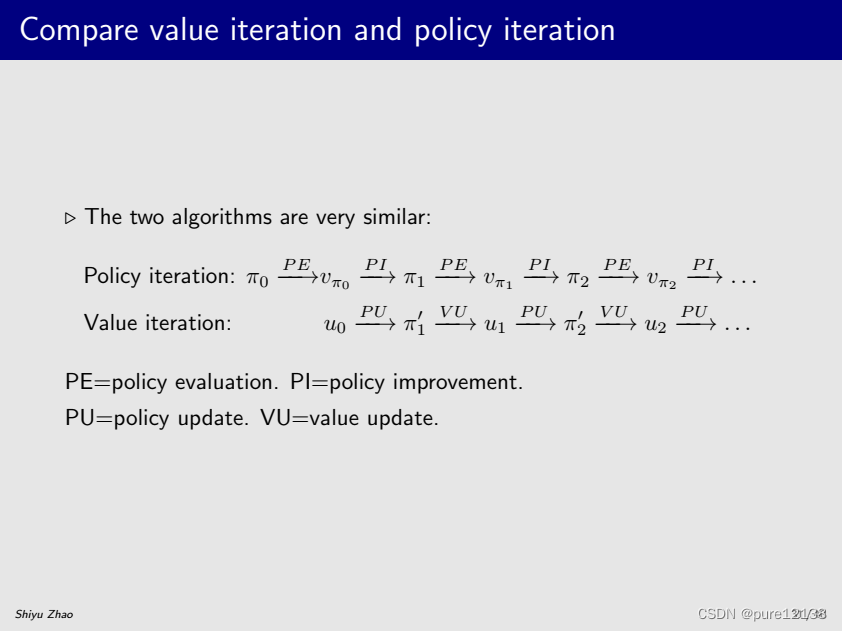

6.Policy iteration

7.Policy iteration & Value iteration

二、蒙特卡洛(Monte Carlo Learning)

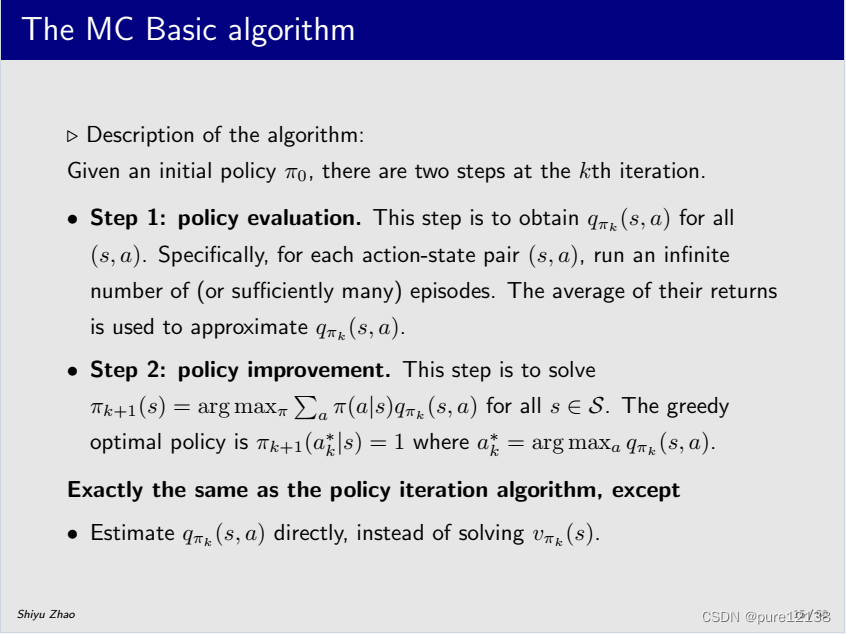

1.The MC Basic algorithm(model-free)

注:可以看到,第二步和Policy iteration是一样的,唯一不同是在第一步时,Policy iteration是通过一个初始的策略求出State value再求出Action value,而MC是直接根据初始策略利用数据求出Action value。

文章详细介绍了强化学习中的核心概念,包括贝尔曼公式及其在状态值和动作值上的应用,价值迭代和策略迭代算法,以及蒙特卡洛学习的基本算法。特别指出,蒙特卡洛学习的模型自由特性使其直接从经验数据中估计动作值,而不同于策略迭代先计算状态值。

文章详细介绍了强化学习中的核心概念,包括贝尔曼公式及其在状态值和动作值上的应用,价值迭代和策略迭代算法,以及蒙特卡洛学习的基本算法。特别指出,蒙特卡洛学习的模型自由特性使其直接从经验数据中估计动作值,而不同于策略迭代先计算状态值。

970

970

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?