使用场景

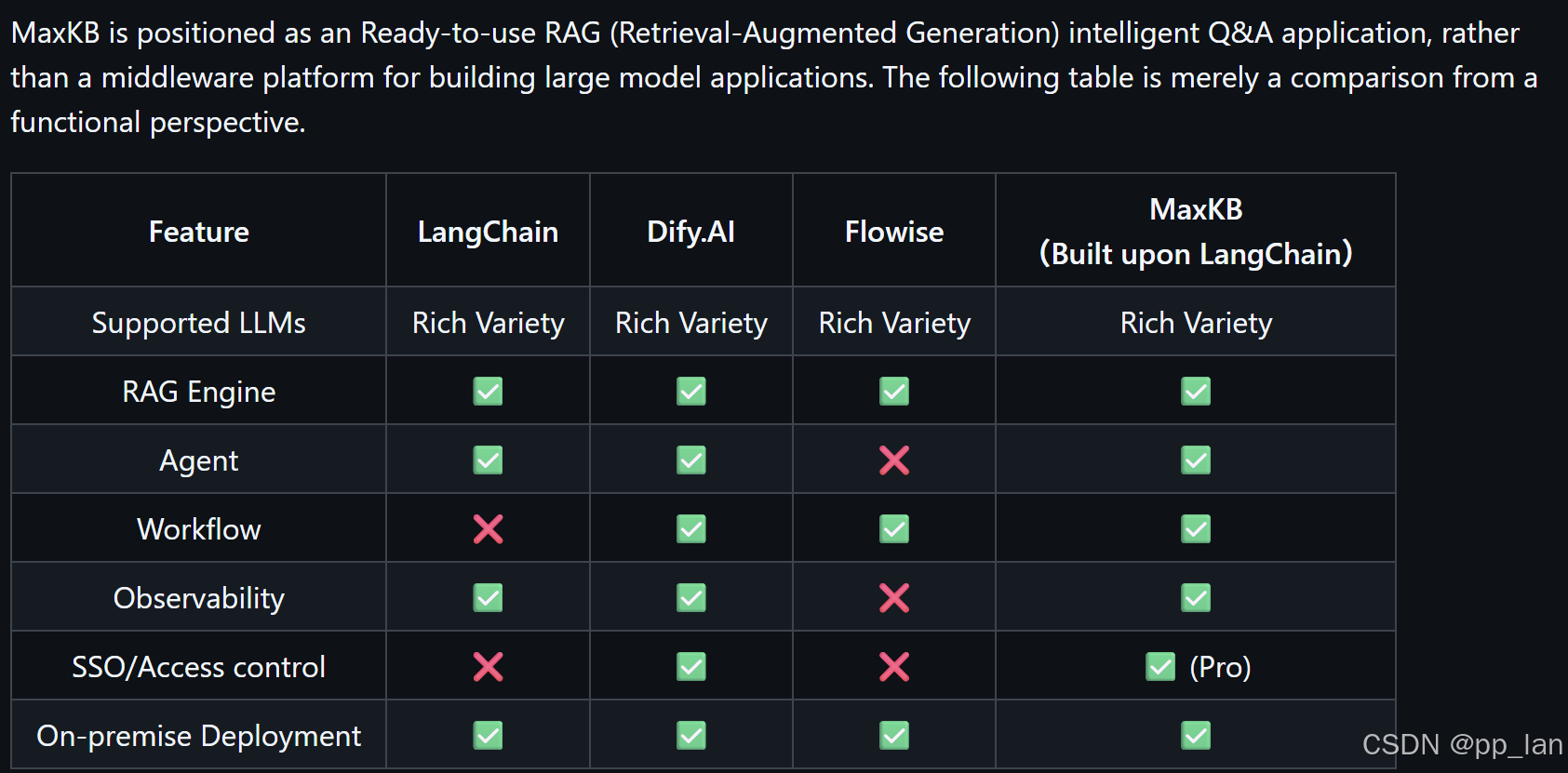

类似dify,但是部署使用更为轻便。

github主页:

https://github.com/1Panel-dev/MaxKB

部署

docker部署

# 拉取镜像

docker pull 1panel/maxkb

# 启动

docker run -d --name=maxkb --restart=always -p 8080:8080 -v ~/.maxkb:/var/lib/postgresql/data -v ~/.python-packages:/opt/maxkb/app/sandbox/python-packages 1panel/maxkb离线部署

本文使用docker部署,离线部署请直接官方安装手册:离线安装 - MaxKB 文档

验证

http://localhost:8080

默认用户名及密码

- username: admin

- password: MaxKB@123..

模型配置

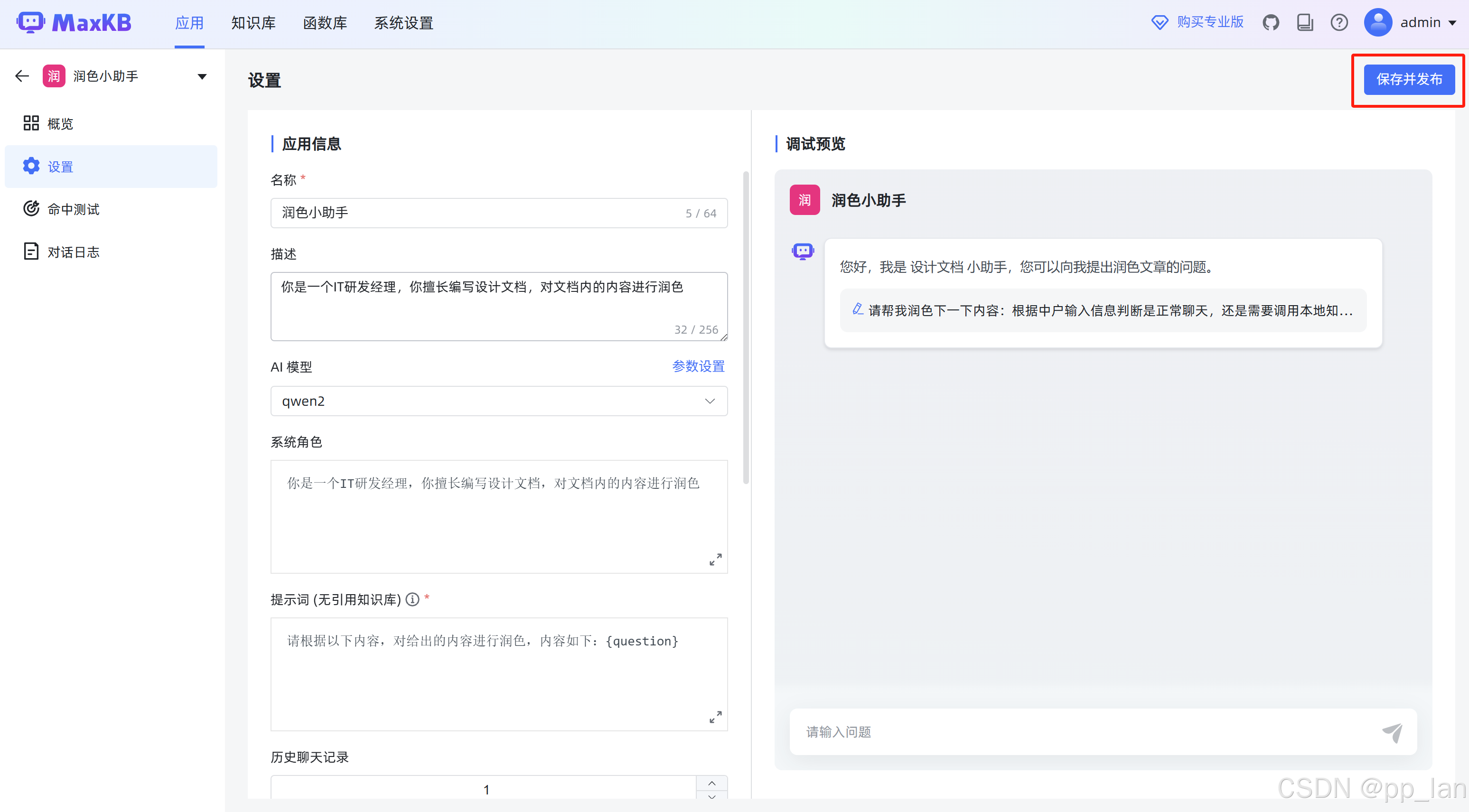

创建应用

应用

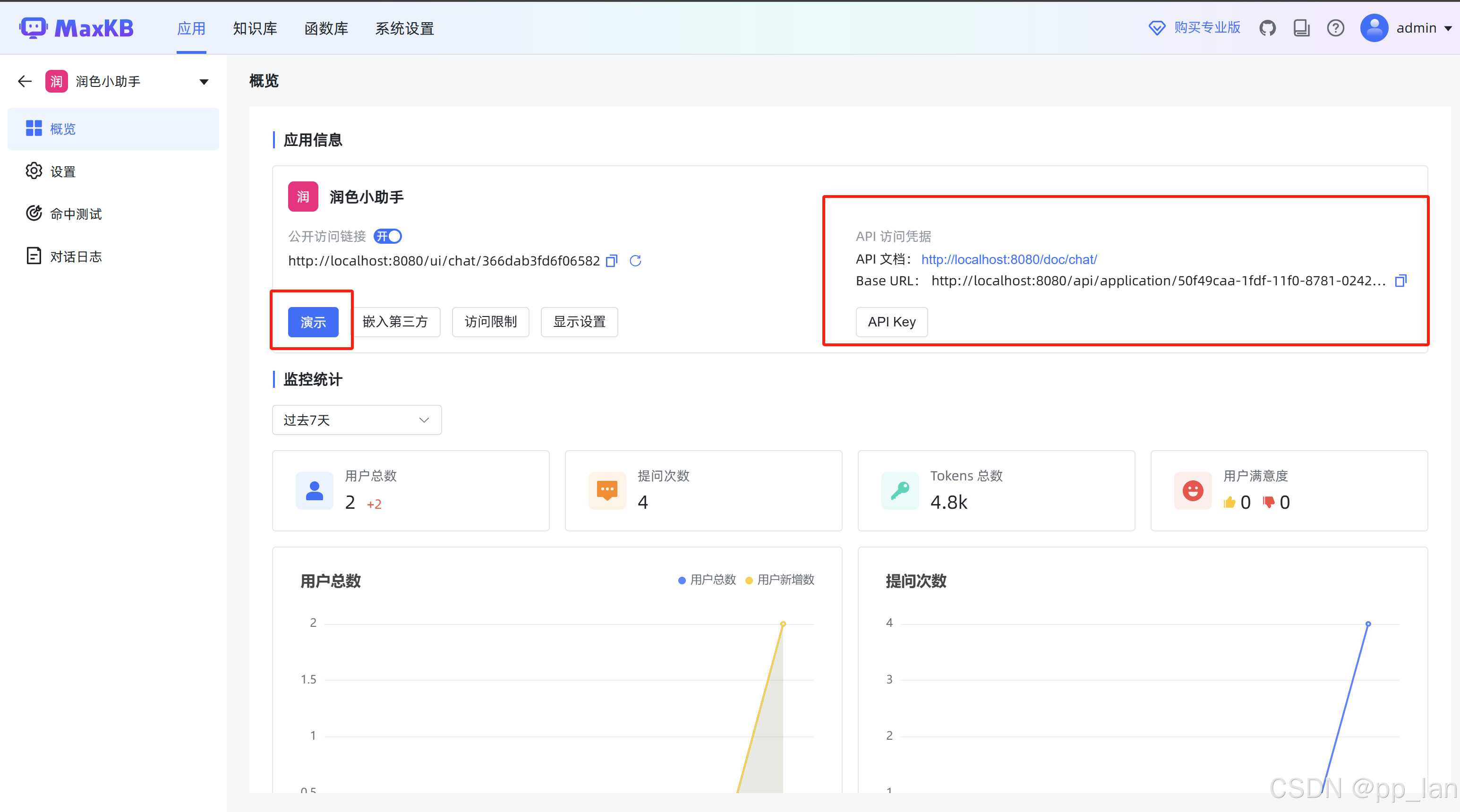

直接使用

API调用

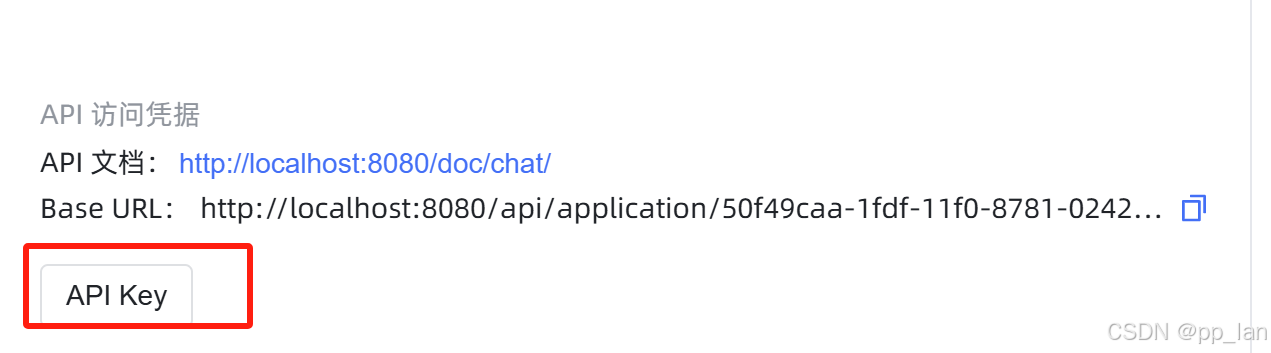

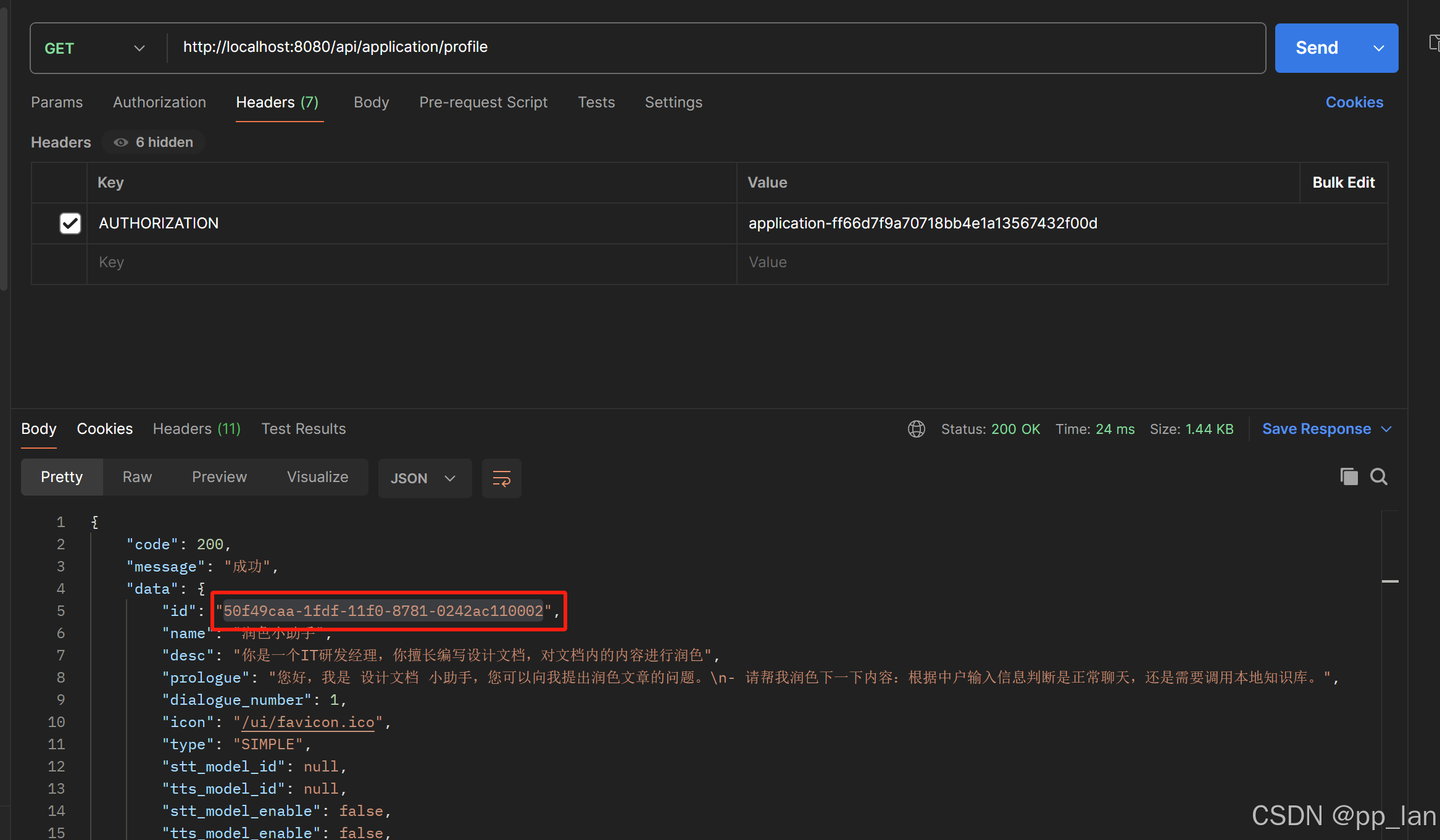

添加API Key

授权应用id

http://localhost:8080/api/application/profile

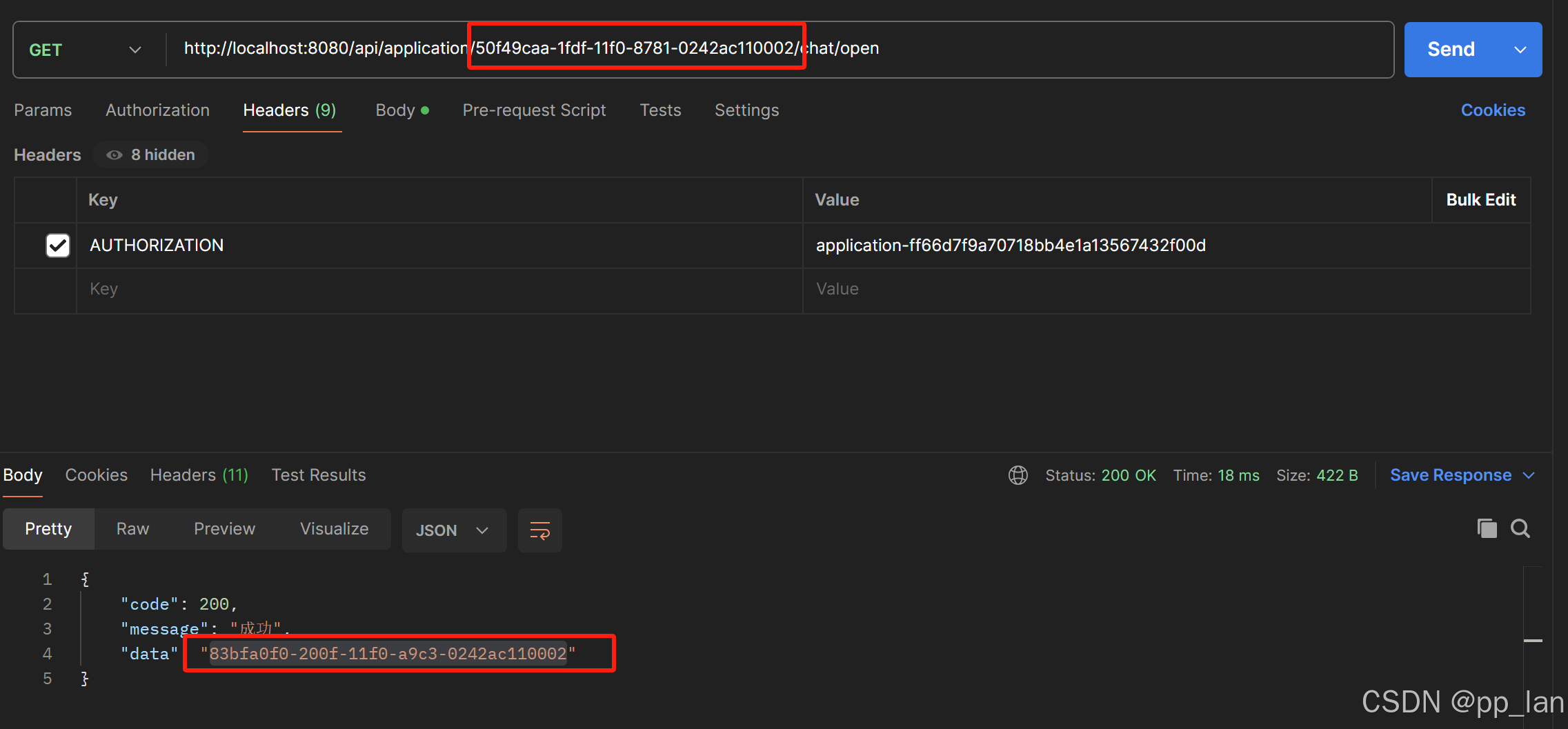

获取会话ID

填入上一步获取的应用ID,填入url中,获取会话ID

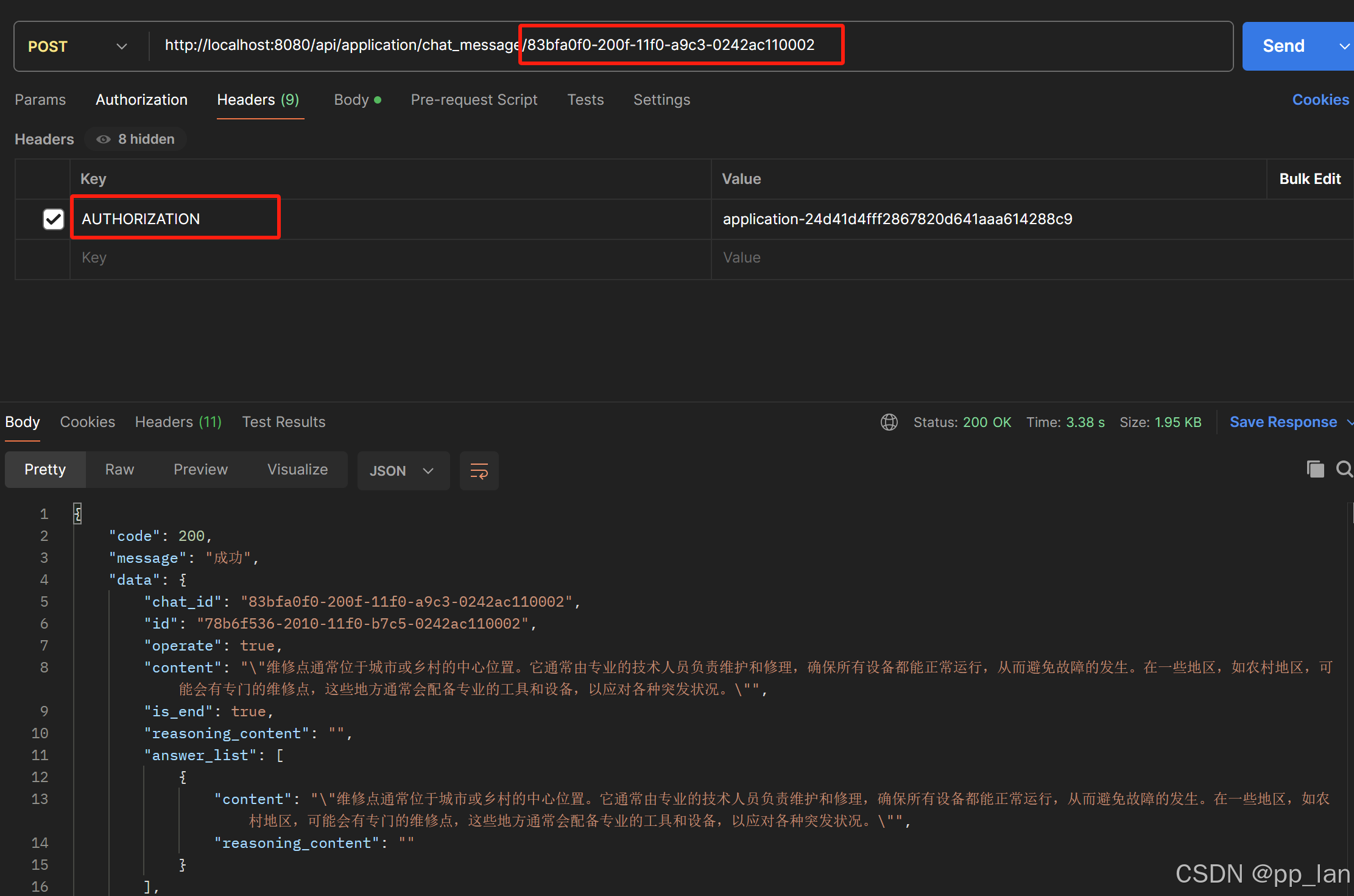

接口调用

1623

1623

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?