一、引言

前一篇博文使用单隐层的全连接神经网络,并结合一些神经网络的优化策略,如指数衰减学习率、正则化、Relu激活函数和Adam优化算法等,用包含100个隐层神经元的神经网络实现了MNIST数据集上手写数字识别98%的准确率。但是全连接神经网络也是有局限的,即使使用很深的网络、很多的隐层结点、很大的迭代轮数,也很难在MNIST数据集上得到99%以上的准确率。不过,卷积神经网络的出现解决了这一问题,最终可以达到99%以上的准确率,满足了一些高精度识别系统的需求。

二、卷积神经网络的基本原理

2.1 卷积操作

图像中的每一个像素点和周围的像素点是紧密联系的,但和太远的像素点就不一定有什么关联了,这就是人的视觉感受野的概念,每一个感受野只接受一小块区域的信号。这一小块区域的像素是互相关联的,每一个神经元不需要接收全部的像素点的信息,只需要接收局部的像素点作为输入,而后将这些神经元收到的局部信息综合起来就可以得到全局的信息。

图像的卷积操作就是指从图像的左上角开始,利用一个卷积模板在图像上滑动,在每一个位置将图像像素点上的像素灰度值与对应的卷积核上的数值相乘,并将所有相乘后的结果求和作为卷积核中心像素对应的卷积结果值,按照此步骤在图像的所有位置完成滑动得到卷积结果的过程。这个卷积模板在卷积神经网络中通常叫做卷积核,或滤波器,下图所示为一个图像卷积操作部分过程的示意图,图中采用3*3的卷积核对5*5大小的图片进行卷积操作。

图像卷积操作可以表示为![]() ,其中:

,其中:

![]()

其中,![]() 为待卷积图像的矩阵,

为待卷积图像的矩阵,![]() 为卷积核函数,

为卷积核函数,![]() 为图像卷积操作的输出图像。在深度学习中,输入的图像矩阵和输出的结果矩阵都称作特征图。

为图像卷积操作的输出图像。在深度学习中,输入的图像矩阵和输出的结果矩阵都称作特征图。

2.2 池化操作

在通过卷积层获得了二维特征图之后,通常情况下特征图的尺寸仍然很大,如果直接用这些特征送给分类器进行分类,那么在计算量上将会面临很大的考验,另外也有可能出现过拟合问题,因此不方便直接用这些特征图做分类。池化操作就是为了解决这样的问题而设计的技术,它在特征图矩阵上对不同位置的特征进行聚合统计,浓缩特征。

池化操作的示意图如上图所示。常用的池化操作有两种,一种是平均池化,平均池化操作的输出是池化核对应范围内输入特征图中特征的均值;另一种是最大池化,最大池化操作的输出是池化核对应范围内输入特征图中特征的最大值。可以看出池化操作是一种特殊的图像卷积操作。

进行池化操作能显著改善卷积神经网络的效果,这主要是由于特征浓缩,特征图维度降低,卷积神经网络经常出现的过拟合现象也会相应减轻的缘故。此于,由于浓缩了一定范围内特征信息,池化操作还有增强卷积神经网络中小范围内平移不变性的作用。

2.3 卷积层

一般的卷积神经网络由多个卷积层构成,每个卷积层中通常会进行如下几个操作。

- 图像通过多个不同的卷积核的滤波,并加偏置(bias),提取出局部特征,每一个卷积核会映射出一个新的2D图像。

- 将前面的卷积核的滤波输出结果进行非线性的激活函数的处理,目前一般用ReLU函数。

- 对激活函数的结果再进行池化操作(即降采样,比如2*2的图片降为1*1的图片),目前一般是使用最大池化,保留最显著的特征,并提升模型的畸变容忍能力。

注意,一个卷积层中一般有多个不同的卷积核,因为每个卷积核只能提取一种图片特征,可以增加卷积核的数量多提取一些特征。每一个卷积核对应一个滤波后映射出的新图像,同一个新图像中的每一个像素都来自完全相同的卷积核,这就是卷积核的权值共享。共享卷积核的权值参数的目的很简单,降低模型复杂度,减轻过拟合并降低计算量。

卷积层需要训练的权值数量只和卷积核的大小以及卷积核的数量有关,我们可以使用非常少的参数处理任意大小的图片。每一个卷积层提取的特征,在后面的层中都会抽象组合成更高阶的特征。

2.4 卷积神经网络

卷积神经网络和多层感知器网络的不同之处在于,卷积神经网络包含了若干个卷积层和池化层构成的特征抽取器,可以有效地减少参数数量,大大简化模型的复杂度,从而减少过拟合的风险。同时赋予了卷积神经网络对平移和轻度变形的容忍性,提高了模型的泛化能力。

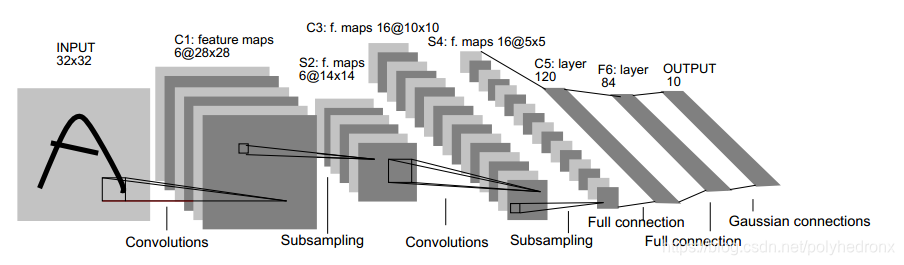

著名的LeNet5的结构如下图所示,包含了三个卷积层,一个全连接层和一个高斯连接层。一般来说,针对不同数据集、不同大小的输入图片可以根据需要合理地设计不同的卷积神经网络,来应对不同的实际问题。

三、用于手写数字识别问题的卷积神经网络的设计

手写数字识别问题较简单,因此采用两个卷积层和一个全连接层构建一个简单的卷积神经网络。

3.1 主要TensorFlow函数释义

(1)tf.nn.conv2d

给定4维的输入和滤波器Tensor,计算2维卷积。

tf.nn.conv2d(

input,

filter=None,

strides=None,

padding=None,

use_cudnn_on_gpu=True,

data_format='NHWC',

dilations=[1, 1, 1, 1],

name=None,

filters=None

)- input:

指需要做

本文介绍了如何使用TensorFlow构建卷积神经网络(CNN)来实现手写数字识别,详细讲解了卷积操作、池化操作、卷积层的工作原理,并展示了设计CNN识别MNIST数据集手写数字的步骤,最终达到了99.2%的准确率。

本文介绍了如何使用TensorFlow构建卷积神经网络(CNN)来实现手写数字识别,详细讲解了卷积操作、池化操作、卷积层的工作原理,并展示了设计CNN识别MNIST数据集手写数字的步骤,最终达到了99.2%的准确率。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

12

12

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?