背景

baichuan-7B 是由百川智能开发的一个开源可商用的大规模预训练语言模型。

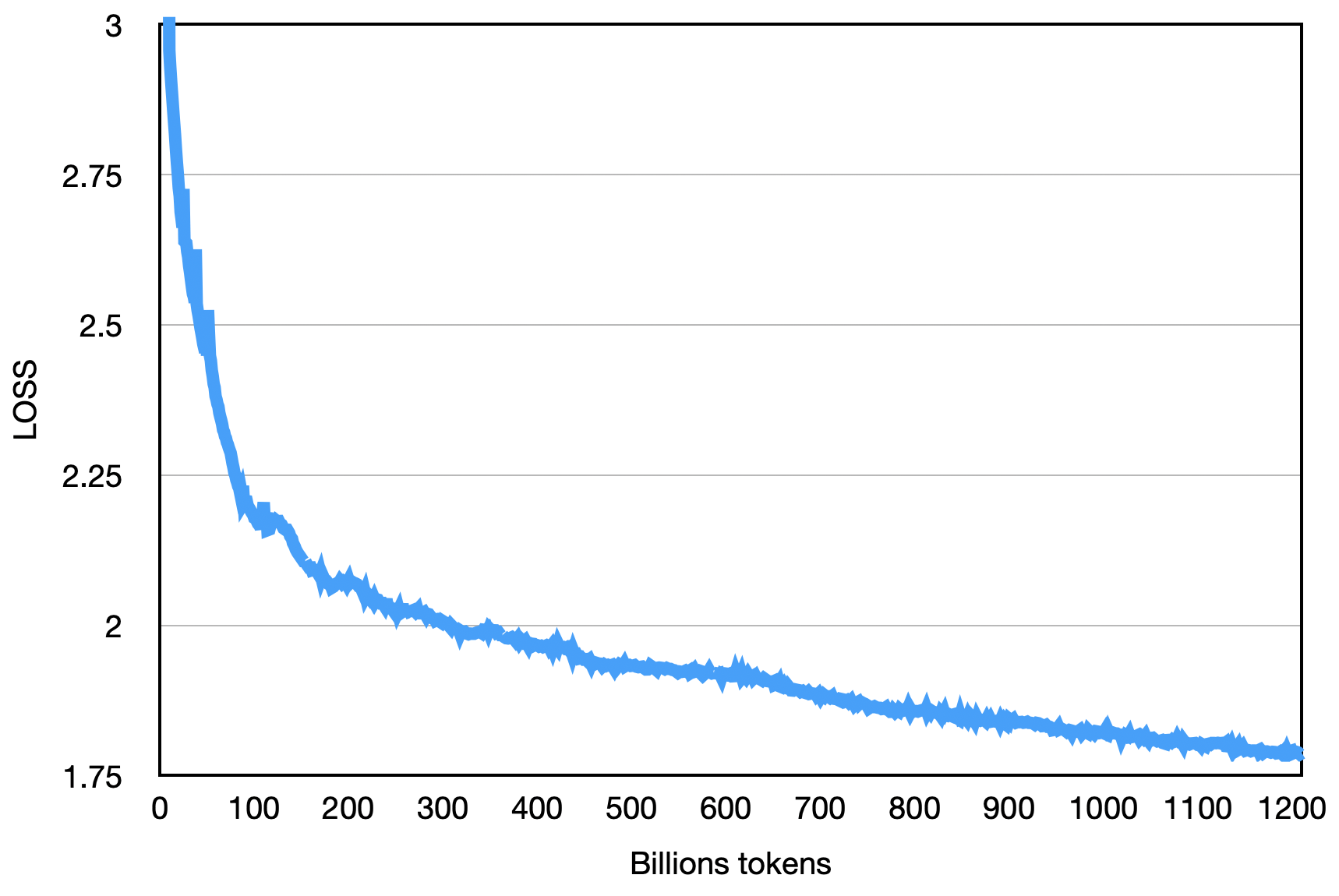

基于 Transformer 结构,在大约1.2万亿 tokens 上训练的70亿参数模型,支持中英双语,上下文窗口长度为4096。

在标准的中文和英文权威 benchmark(C-EVAL/MMLU)上均取得了同参数规模下的最好效果。

baichuan-7B的优点

- 在同尺寸模型中baichuan-7B达到了目前SOTA的水平。

- baichuan-7B使用自有的中英文双语语料进行训练,在中文上进行优化,在C-Eval达到SOTA水平。

- 不同于LLaMA完全禁止商业使用,baichuan-7B使用更宽松的开源协议,允许用于商业目的。

数据收集

- 原始数据包括开源的中英文数据和自行抓取的中文互联网数据,以及部分高质量知识性数据。

- 参考相关数据工作,频率和质量是数据处理环节重点考虑的两个维度。 我们基于启发式规则和质量模型打分,对原始数据集进行篇章和句子粒度的过滤。在全量数据上,利用局部敏感哈希方法,对篇章和句子粒度做滤重。

模型结构

整体模型基于标准的 Transformer 结构,采用了和 LLaMA 一样的模型设计。

-

位置编码:rotary-embedding

是现阶段被大多模型采用的位置编码方案,具有更好的外延效果。虽然训练过程中最大长度为4096,但是实际测试中模型可以很好的扩展到 5000 tokens 上,如下图:

-

激活层:SwiGLU, Feedforward 变化为(8/3)倍的隐含层大小,即11008。

-

Layer-Normalization: 基于 RMSNorm 的 Pre-Normalization。

预训练

采用 DeepSpeed 框架进行训练,在原本的LLaMA框架上进行诸多修改以提升训练时的吞吐,具体包括:

- 算子优化技术:采用更高效算子,如 Flash-attention,NVIDIA apex 的 RMSNorm 等。

- 算子切分技术:将部分计算算子进行切分,减小内存峰值。

- 混合精度技术:降低在不损失模型精度的情况下加速计算过程。

- 训练容灾技术:训练平台和训练框架联合优化,IaaS + PaaS 实现分钟级的故障定位和任务恢复。

- 通信优化技术,具体包括:

- 采用拓扑感知的集合通信算法,避免网络拥塞问题,提高通信效率。

- 根据卡数自适应设置 bucket size,提高带宽利用率。

- 根据模型和集群环境,调优通信原语的触发时机,从而将计算和通信重叠。

基于上述的几个优化技术,在千卡A800机器上达到了7B模型182Tflops的吞吐,GPU峰值算力利用率高达58.3% 。

最终的loss如下图:

</

</

baichuan-7B是由百川智能开发的70亿参数预训练语言模型,支持中英双语,达到同尺寸模型中的最优效果。使用自有中英文数据训练,优化中文性能,在C-Eval取得SOTA。模型基于Transformer,应用多种优化技术提升训练效率,允许商业使用。

baichuan-7B是由百川智能开发的70亿参数预训练语言模型,支持中英双语,达到同尺寸模型中的最优效果。使用自有中英文数据训练,优化中文性能,在C-Eval取得SOTA。模型基于Transformer,应用多种优化技术提升训练效率,允许商业使用。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

102

102

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?