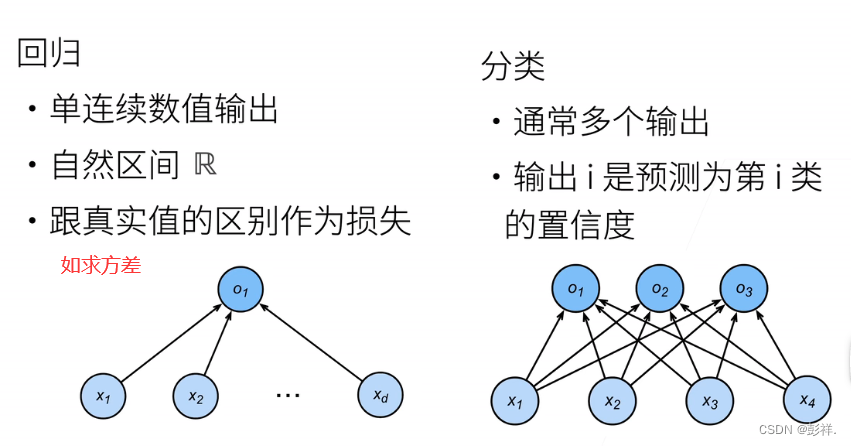

回归与分类的差别,回归是解决一个连续问题,估计一个连续值,如房价预测

而分类则是解决一个离散问题

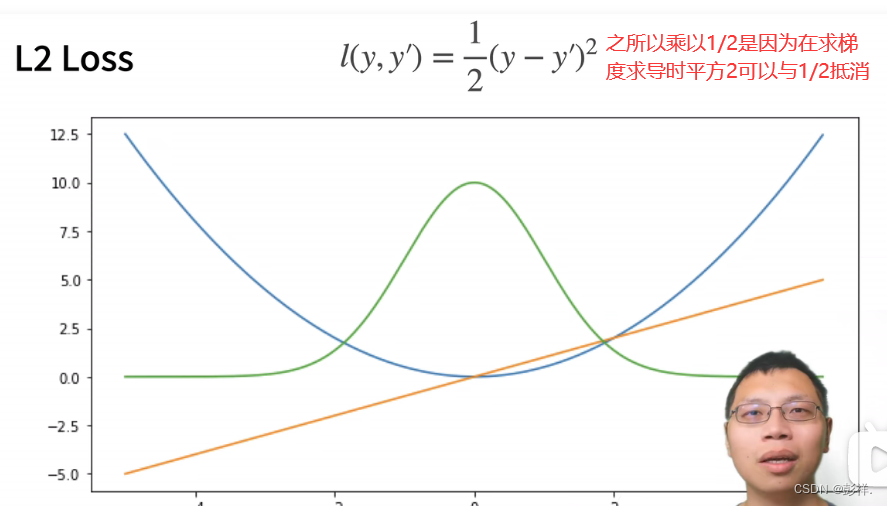

常见的损失函数

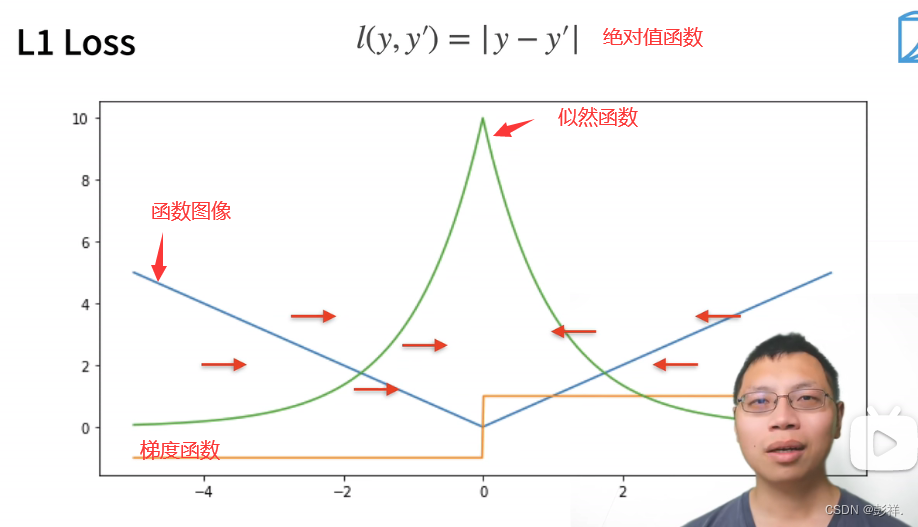

该函数作为损失函数可看到在临近导数为0时,即y与y’接近时,其变化(参数更新)幅度越小,这有可能导致我们的参数更新太剧烈,因此我们也可以采用下面这种绝对值函数作为我们的损失函数的方法

绝对值函数的梯度一直为常数,即变化是稳定的,但他也有缺点,即它在0处不可导,因此在0处取值波动大

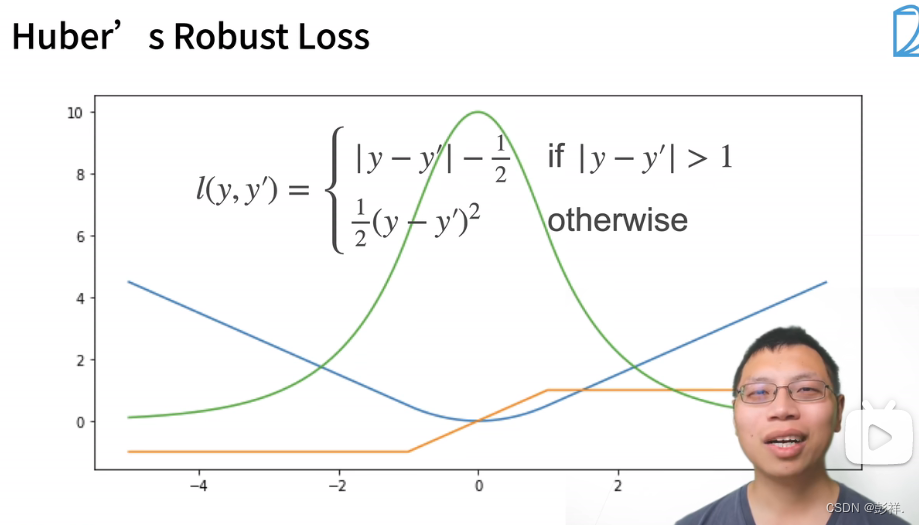

这种是吸取了上面两者损失函数的优缺点后改进的函数

图片分类数据集

import torch

from d2l import torch as d2l#一些实现好的函数

import torchvision

from torch.utils import data

from torchvision import transforms#对数据进行操作的摸具

d2l.use_svg_display()#使用svg展示图片。清晰度高一些

# 通过ToTensor实例将图像数据从PIL类型变换成32位浮点数格式,

# 并除以255使得所有像素的数值均在0到1之间

#数据集并不大,几百M,直接读入内存即可

trans = transforms.ToTensor()#将图片转换为tensor

mnist_train = torchvision.datasets.FashionMNIST(

root="./data",#下载目录

train=True, #表面拿到的是训练集

transform=trans,#表面拿到的是转换为tensor的数据而不是一堆图片

download=True#默认网上下载,若已下载完成则无需指定

)

mnist_test = torchvision.datasets.FashionMNIST(

root="./data", train=False, transform=trans, download=True)

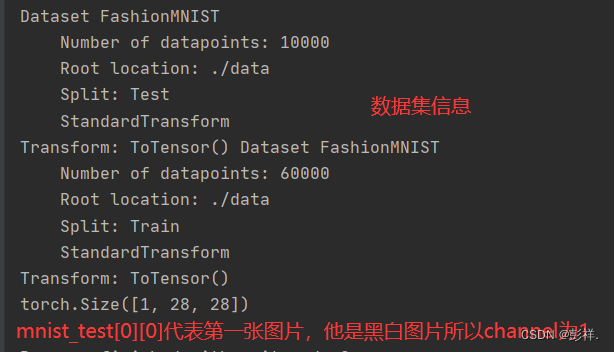

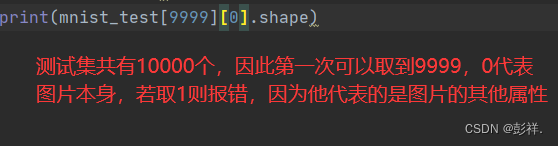

print(mnist_test,mnist_train)

#Fashion-MNIST中包含的10个类别,分别为t-shirt(T恤)、trouser(裤子)、pullover(套衫)、dress(连衣裙)

# 、coat(外套)、sandal(凉鞋)、shirt(衬衫)、sneaker(运动鞋)、bag(包)和ankle boot(短靴)。 以下函数用于在数字标签索引及其文本名称之间进行转换。

def get_fashion_mnist_labels(labels): #@save

"""返回Fashion-MNIST数据集的文本标签"""

text_labels = ['t-shirt', 'trouser', 'pullover', 'dress', 'coat',

'sandal', 'shirt', 'sneaker', 'bag', 'ankle boot']

return [text_labels[int(i)] for i in labels]

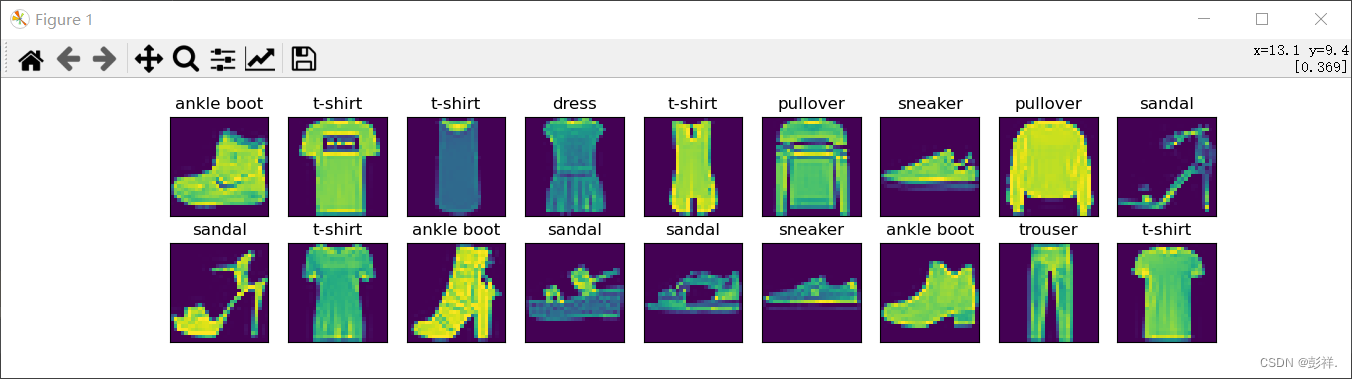

#创建一个函数来可视化这些样本

def show_images(imgs, num_rows, num_cols, titles=None, scale=1.5): #@save

"""绘制图像列表"""

figsize = (num_cols * scale, num_rows * scale)

_, axes = d2l.plt.subplots(num_rows, num_cols, figsize=figsize)

axes = axes.flatten()

for i, (ax, img) in enumerate(zip(axes, imgs)):

if torch.is_tensor(img):

# 图片张量

ax.imshow(img.numpy())

else:

# PIL图片

ax.imshow(img)

ax.axes.get_xaxis().set_visible(False)

ax.axes.get_yaxis().set_visible(False)

if titles:

ax.set_title(titles[i])

return axes

如果要展示这些图片还需要引入PIL

from matplotlib import pyplot as plt

X, y = next(iter(data.DataLoader(mnist_train, batch_size=18)))

plt.axes=show_images(X.reshape(18, 28, 28), 2, 9, titles=get_fashion_mnist_labels(y))

plt.show()

读取小批量

为了使我们在读取训练集和测试集时更容易,我们使用内置的数据迭代器,而不是从零开始创建。 回顾一下,在每次迭代中,数据加载器每次都会读取一小批量数据,大小为batch_size。 通过内置数据迭代器,我们可以随机打乱了所有样本,从而无偏见地读取小批量。

batch_size = 256

def get_dataloader_workers(): #@save,根据我们的cpu的进程数来确定,我的进程最大支持到4

"""使用4个进程来读取数据"""

return 2

train_iter = data.DataLoader(mnist_train, batch_size, shuffle=True,

num_workers=get_dataloader_workers())

timer = d2l.Timer()

for X, y in train_iter:

continue

print(f'{

timer.stop():.2f} sec')

将上面的所有代码进行封装以复用

def load_data_fashion_mnist(batch_size

这段代码展示了如何使用PyTorch加载Fashion-MNIST数据集,实现softmax回归并进行训练。首先,定义了数据加载器,然后实现了softmax函数、交叉熵损失函数和准确率计算。接下来,定义了网络结构、初始化模型参数,并进行了训练。最后,对模型进行了测试和预测。

这段代码展示了如何使用PyTorch加载Fashion-MNIST数据集,实现softmax回归并进行训练。首先,定义了数据加载器,然后实现了softmax函数、交叉熵损失函数和准确率计算。接下来,定义了网络结构、初始化模型参数,并进行了训练。最后,对模型进行了测试和预测。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

966

966

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?