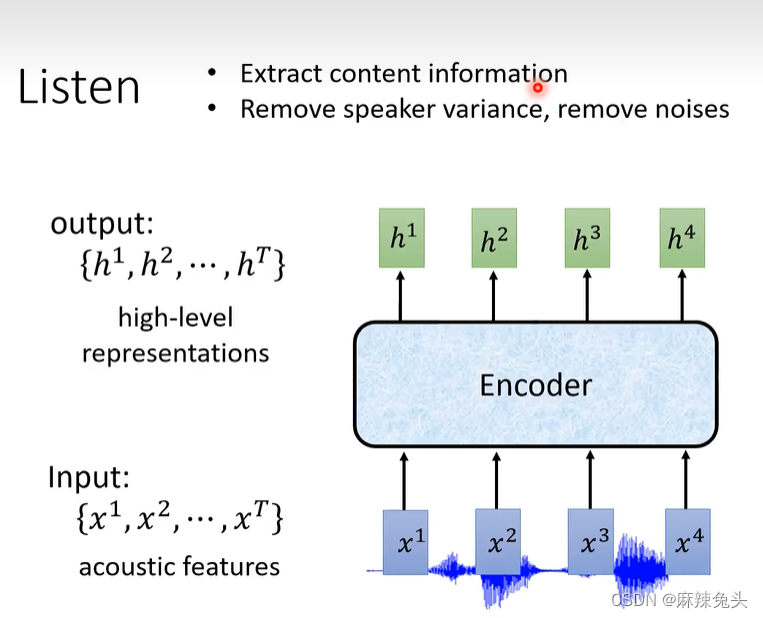

Listen

Encoder目标:

移除语者之间的差异,去掉noises,提取出与语音辨识的相关信息

输入长度(T)和输出长度一样

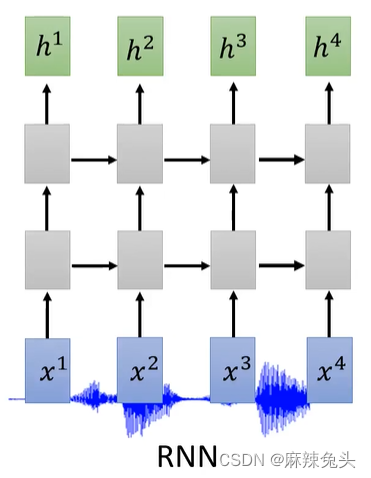

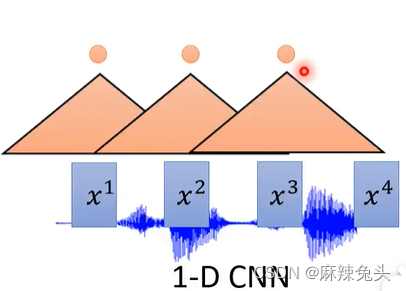

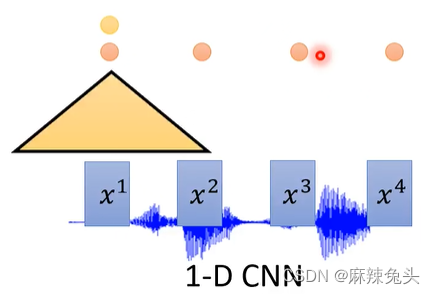

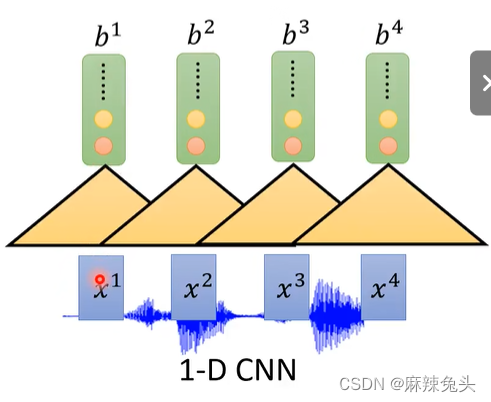

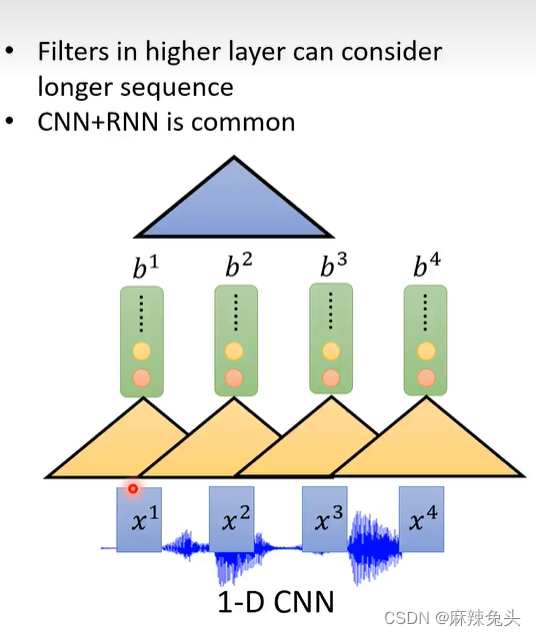

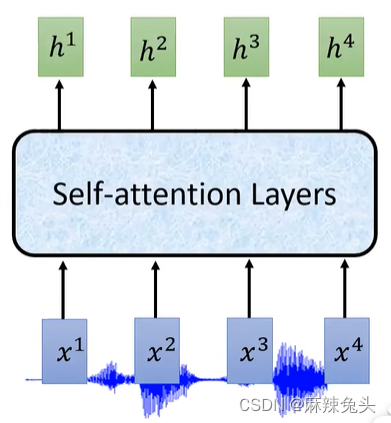

encoder有很多做法:

CNN见文章:CNN-卷积神经网络

self-attention见文章self-attention

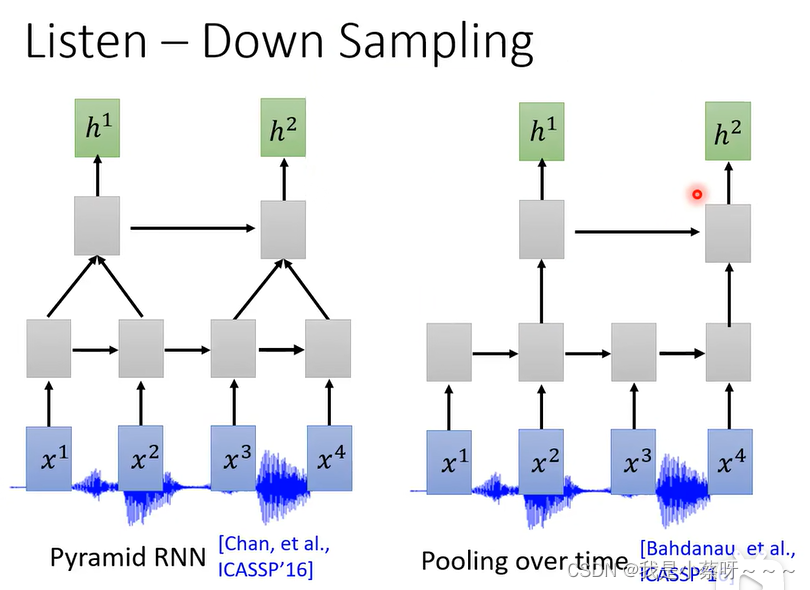

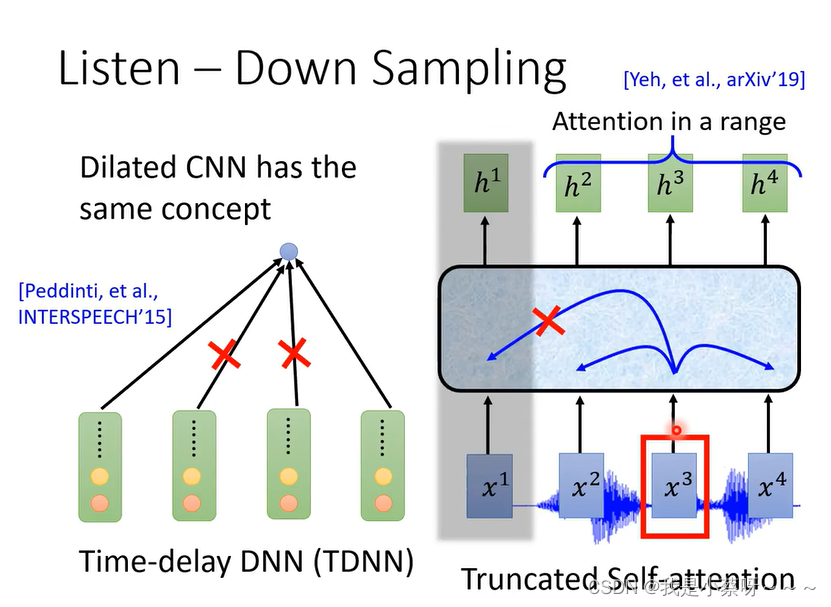

相邻之间差异不是很大,为了节省计算量,让你的训练更有效率,通常会采用down sampling

Pyramid RNN将两个结合,然后送到下一层。Pooling over time则是两个中取一个送到下一层。

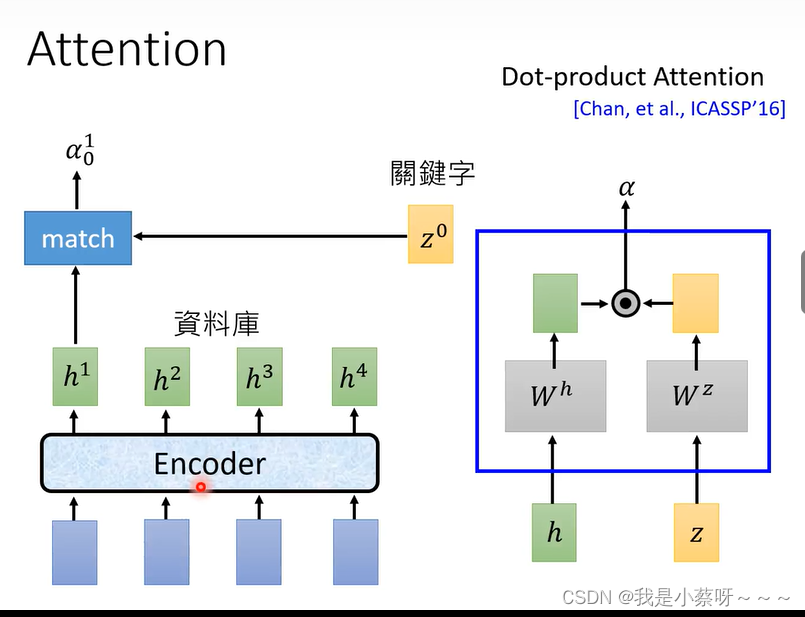

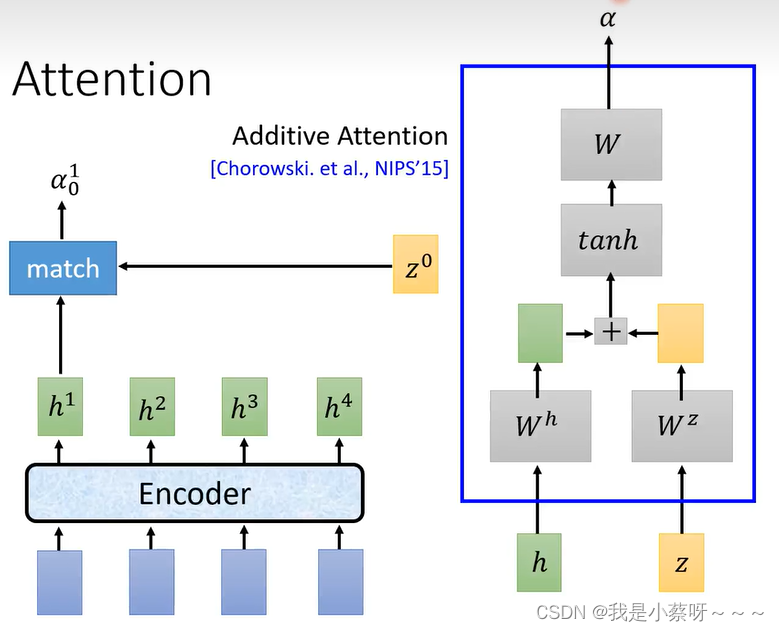

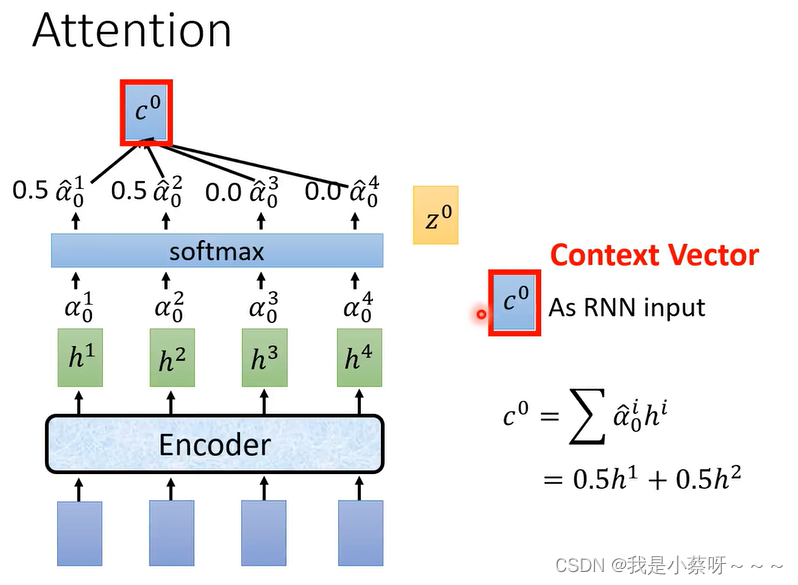

Attention

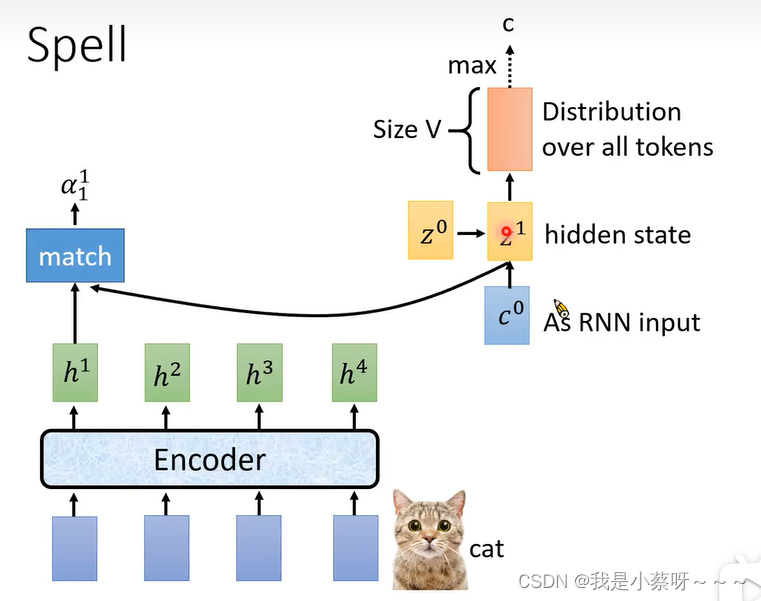

match这个function可以自己定义,常用的是dot-product attention,作用是计算h1(Key)和z0(Query)的相似度。

还有一种additive attention

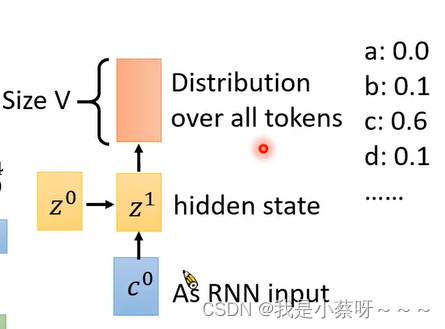

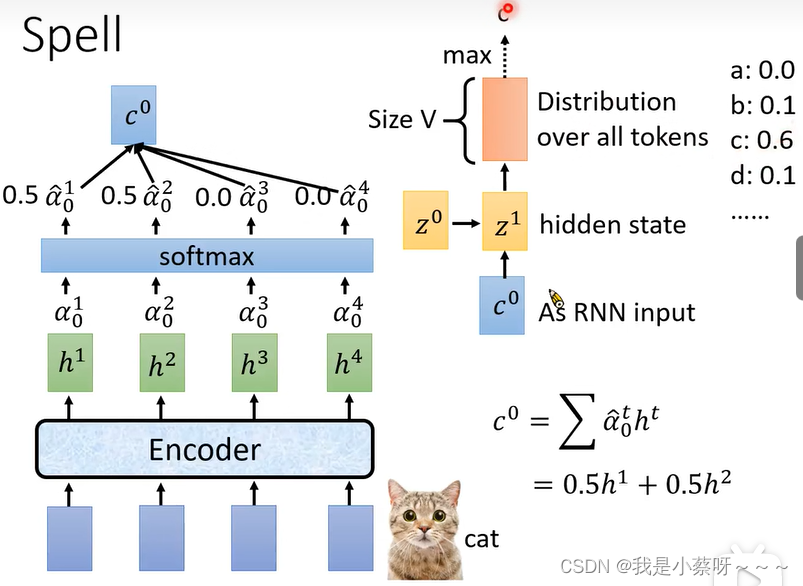

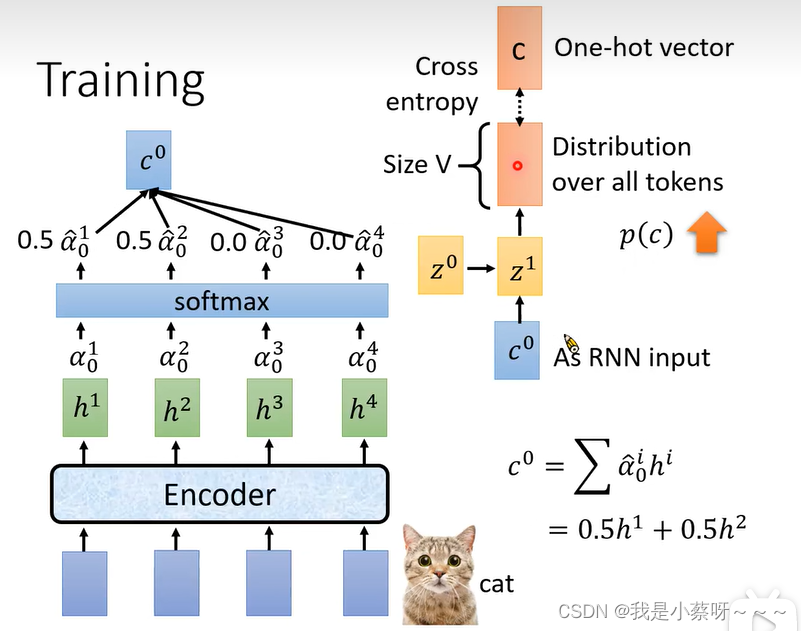

c0(在文献上常常被成为Context Vector)会被当做decoder即RNN input

distribution(是通过softmax的)会给每一个token一个概率值

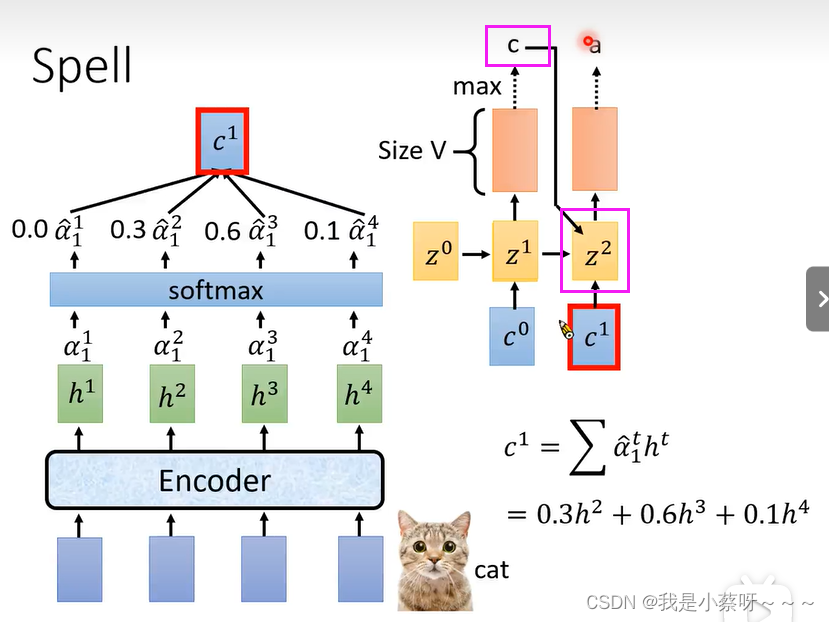

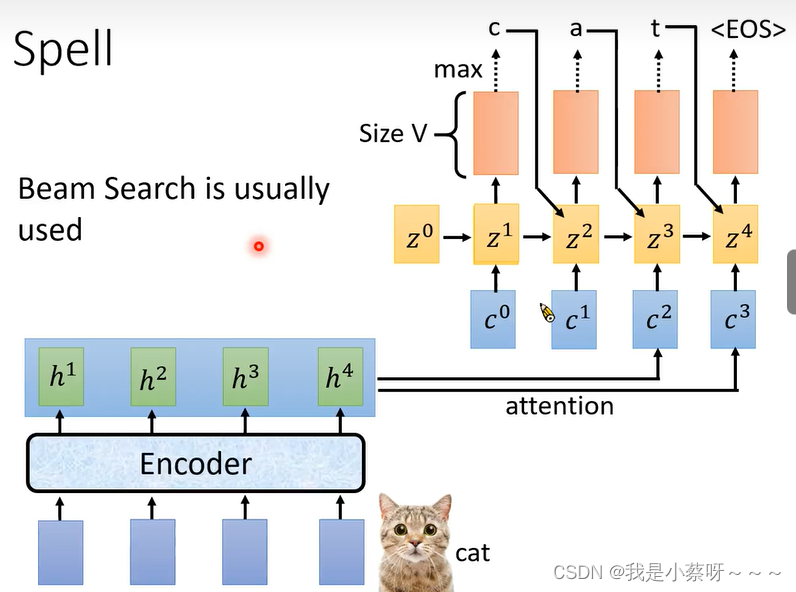

Spell

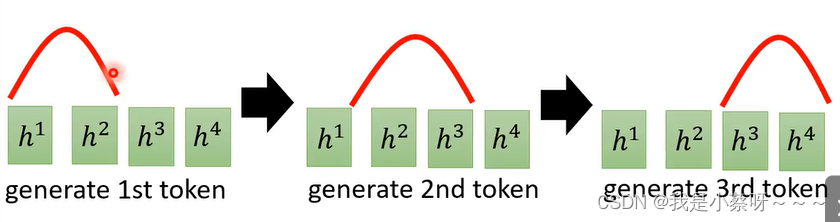

假设输入的一段声音讯号是cat,则model先后的需要输出c——a——t

先输出c

输出c后,用z1再次计算新的阿尔法的值

注意:a是由上一层的c和z2共同得到

EOS 代表辨识结束

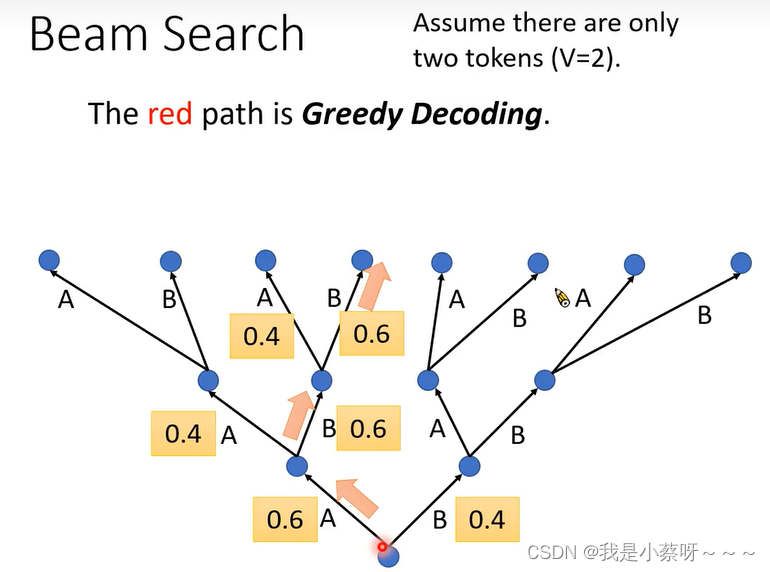

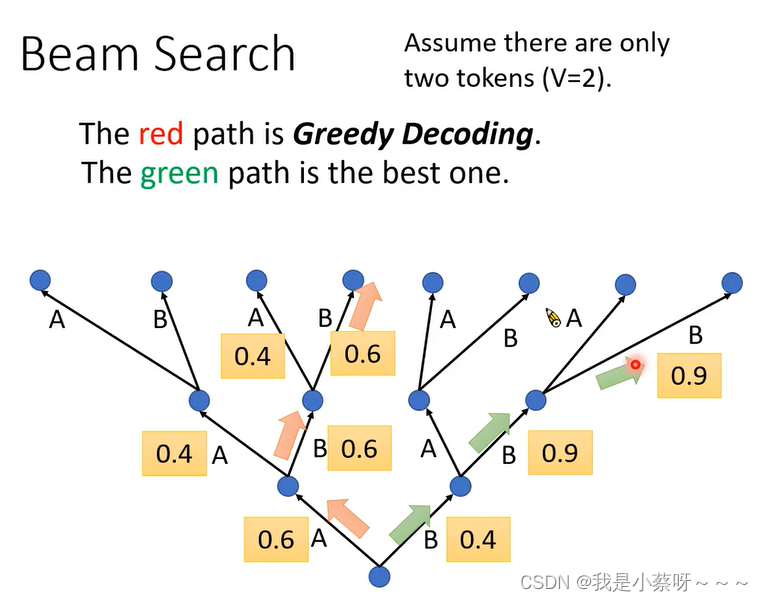

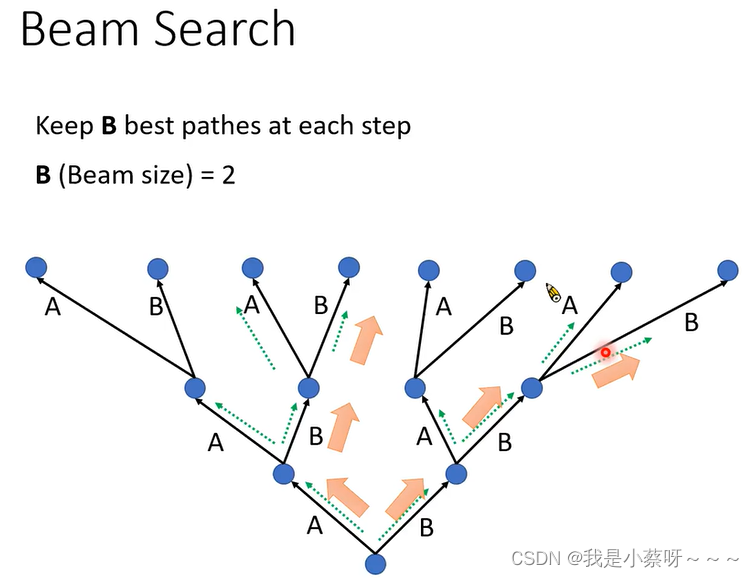

Beam Search

red path:每一次都选择概率最大的路径

Greedy Decoding不见得能找到几率最大的那个

解决上述问题的方法:Beam Search,每次都保留B个最好的路径。Beam size的大小需要自己去考量的。

Training

输入是cat,我们希望Cross entropy越小越好,换言之p©越大越好

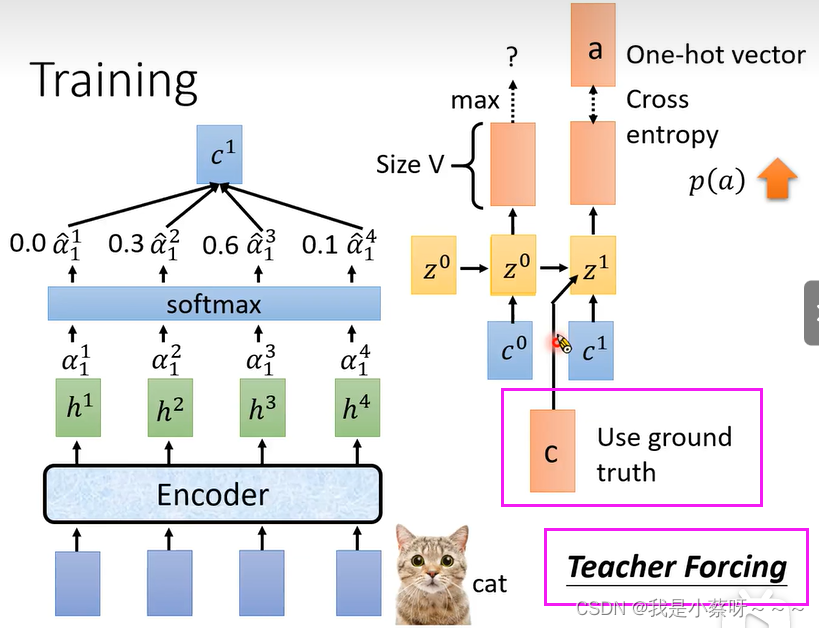

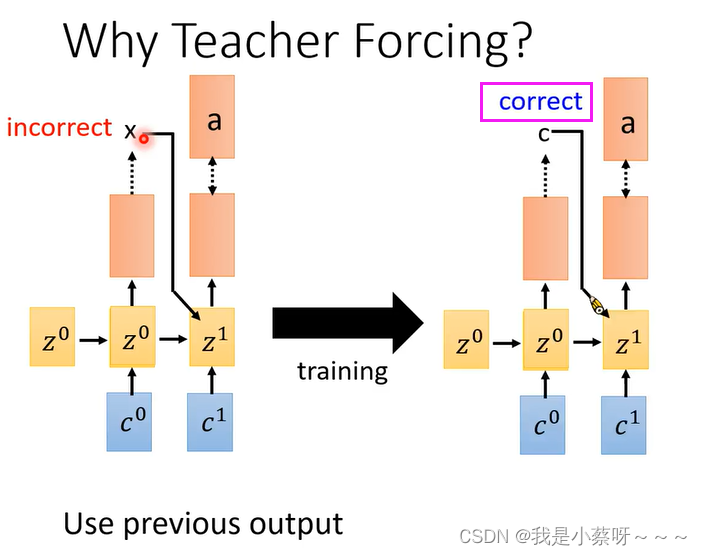

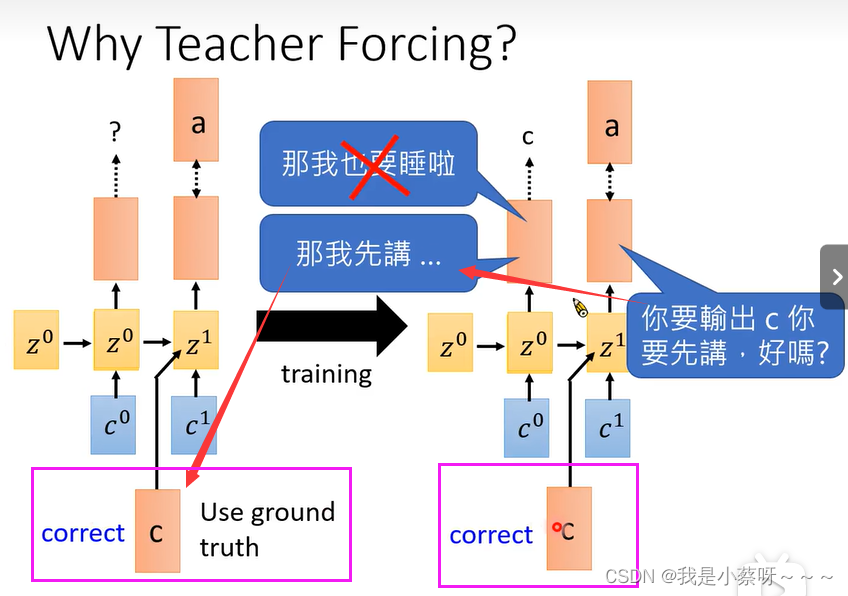

Why Teacher Forcing?

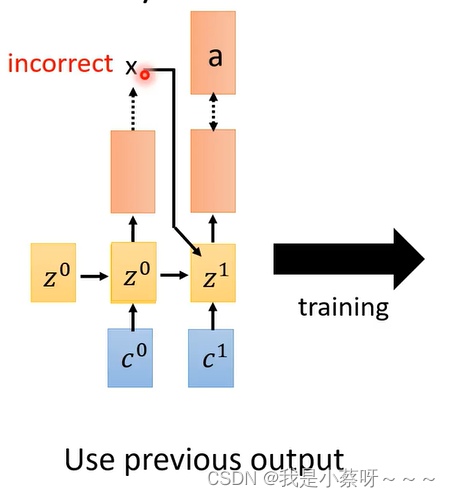

如果前面的输出是错误的

经过一连串的training后,Model变厉害了,得到了正确的输出

不管前面输出什么只专注训练c——>a这件事

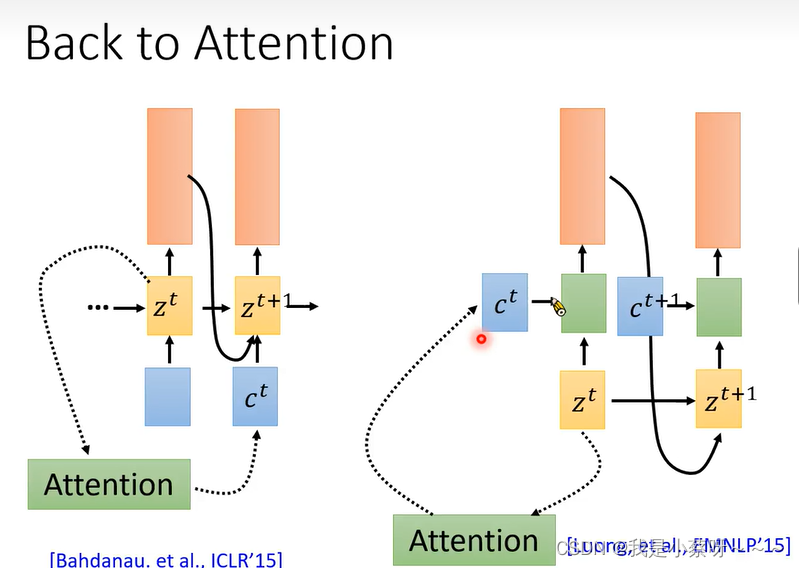

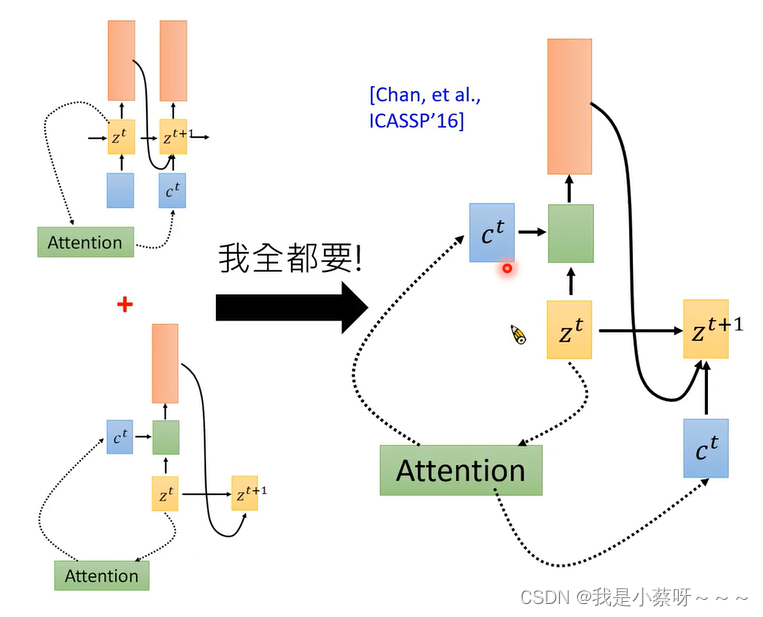

Back to Attention

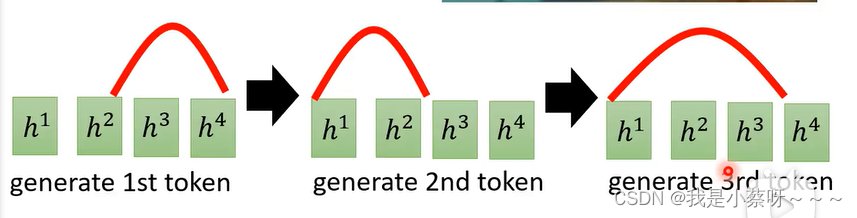

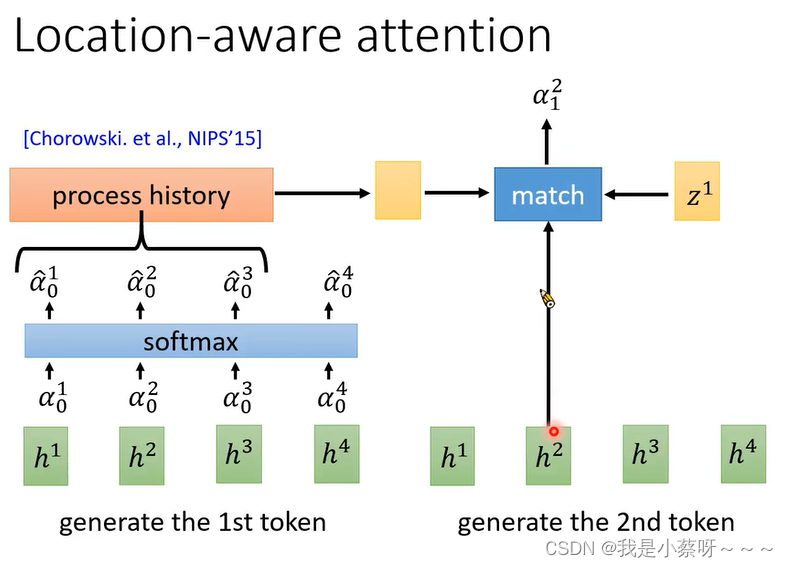

在语音识别上我们希望阿尔法是由左向右

而不是阿尔法乱跳

所以第一篇用LAS做语音辨识的作者加了一个机制:

Location-aware attention

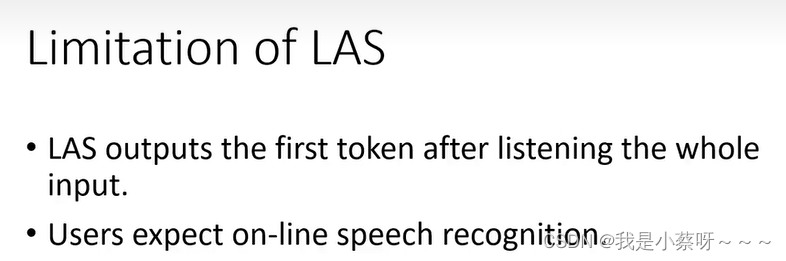

Limitation of LAS

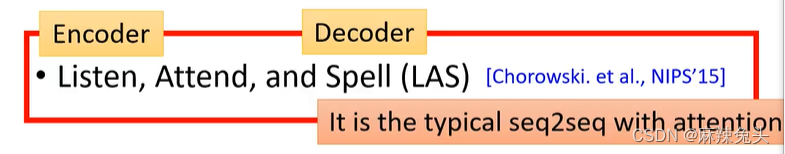

本文深入探讨了语音识别中的关键技术,包括Encoder的作用——去除语者差异和噪音,提取相关信息;Attention机制,如dot-product attention用于计算序列相似度;以及解码策略,如Beam Search解决Greedy Decoding的局限性。此外,还介绍了训练过程中的Teacher Forcing策略和Location-aware attention机制,以优化模型性能。最后,讨论了Listen, Attend and Spell (LAS)模型的限制。

本文深入探讨了语音识别中的关键技术,包括Encoder的作用——去除语者差异和噪音,提取相关信息;Attention机制,如dot-product attention用于计算序列相似度;以及解码策略,如Beam Search解决Greedy Decoding的局限性。此外,还介绍了训练过程中的Teacher Forcing策略和Location-aware attention机制,以优化模型性能。最后,讨论了Listen, Attend and Spell (LAS)模型的限制。

4021

4021

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?