公众号每天更新5条大模型问题及解决方案

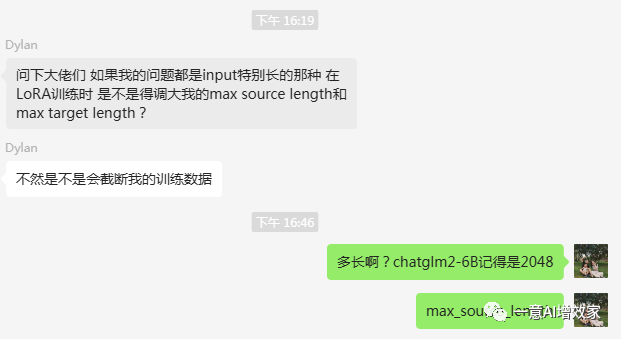

今天,在【NLP学习群】中,一位同学问如果我的问题都是input特别长的那种 在LoRA训练时 是不是得调大我的max source length和max target length?不然是不是会截断训练数据?

01 信息分析:

在微调LoRA时,遇到特别长的输入文本,确实需要调大max source length和max target length。

这两个参数分别控制输入对话历史的最大长度和生成回复的最大长度。通过增加这些参数,让模型有足够的上下文信息,以保证回复连贯性和理解用户问题。但是要注意,增加这些参数也会增加计算成本和内存需求,所以要在资源充足的情况下慎重选择。调整这些参数时,可以逐步增加并评估生成结果和性能,找到适合的平衡点。简而言之,调大max source length和max target length,让LoRA在处理长文本时表现更好!

至此!问题解决!

因为设备、目标不同,如果你的问题还没解决,可以公众号后台回复“问答3000条”进群,有更多同学帮你,也可以点公众号里的有偿1对1!

一意AI增效家

文章讲述了在使用LoRA处理长输入文本时,如何调整maxsourcelength和maxtargetlength参数以提高模型性能。同时介绍了在一意AI公众号中获取高质量数据集、报错解决、运算加速和微调教程等服务的价值。

文章讲述了在使用LoRA处理长输入文本时,如何调整maxsourcelength和maxtargetlength参数以提高模型性能。同时介绍了在一意AI公众号中获取高质量数据集、报错解决、运算加速和微调教程等服务的价值。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1923

1923

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?