1、KNN简介

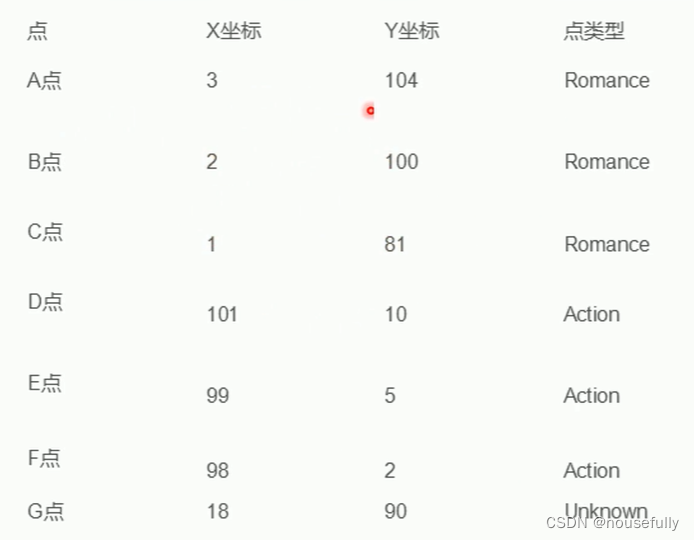

举个例子:

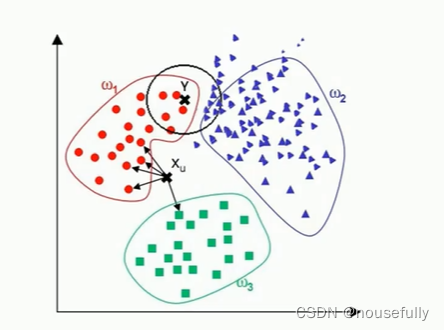

● 为了判断未知实例的类别,以所有已知类别的实例作为参照选择参数K

● 计算未知实例与所有已知实例的距离

● 选择最近K个已知实例

● 根据少数服从多数的投票法则(majority-voting) ,让未知实例归类为K个最邻近样本中最多数的类别

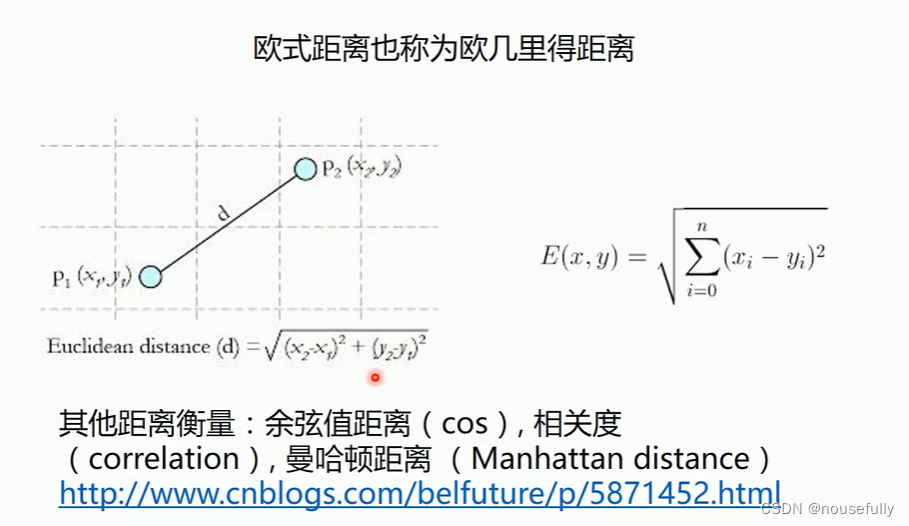

计算距离-欧式距离

算法缺点

●算法复杂度较高(需要比较所有已知实例与要分类的实例)

●当其样本分布不平衡时,比如其中一类样本过大(实例数量过多)占主导的时候,新的未知实例容易被归类为这个主导样本,因为这类样本实例的数量过大,但这个新的未知实例实际并没有接近目标样本

2、Knn算法实现-电影分类

import matplotlib.pyplot as plt

import numpy as np

import operator

# 已知分类的数据

x1 = np.array([3,2,1])

y1 = np.array([104,100,81])

x2 = np.array([101,99,98])

y2 = np.array([10,5,2])

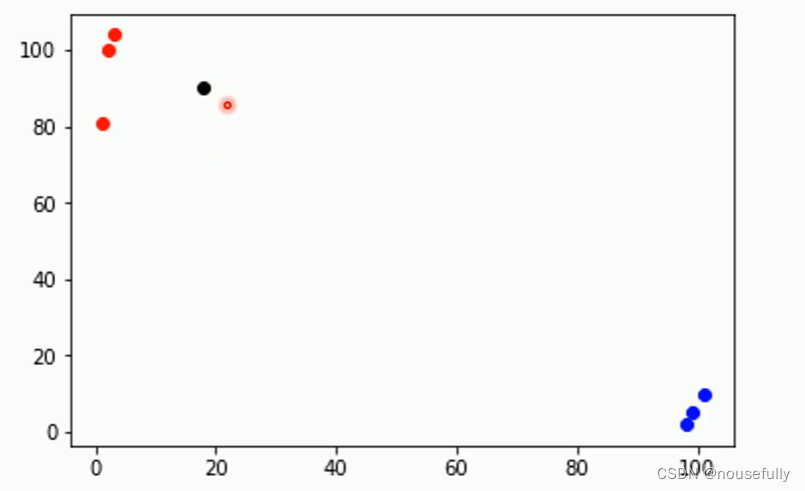

scatter1 = plt.scatter(x1,y1,c='r')

scatter2 = plt.scatter(x2,y2,c='b')

# 未知数据

x = np.array([18])

y = np.array([90])

scatter3 = plt.scatter(x,y,c='k')

#画图例

plt.legend(handles=[scatter1,scatter2,scatter3],labels=['labelA','labelB','X'],loc='best')

plt.show()

#%%

# 已知分类的数据

x_data = np.array([[3,104],

[2,100],

[1,81],

[101,10],

[99,5],

[81,2]])

y_data = np.array(['A','A','A','B','B','B'])

x_test = np.array([18,90])

#%%

# 计算样本数量

x_data_size = x_data.shape[0]

x_data_size

#%%

# 复制x_test

np.tile(x_test, (x_data_size,1))

#%%

# 计算x_test与每一个样本的差值

diffMat = np.tile(x_test, (x_data_size,1)) - x_data

diffMat

#%%

# 计算差值的平方

sqDiffMat = diffMat**2

sqDiffMat

#%%

# 求和

sqDistances = sqDiffMat.sum(axis=1)

sqDistances

#%%

# 开方

distances = sqDistances**0.5

distances

#%%

# 从小到大排序

sortedDistances = distances.argsort()

sortedDistances

#%%

classCount = {}

# 设置k

k = 5

for i in range(k):

# 获取标签

votelabel = y_data[sortedDistances[i]]

# 统计标签数量

classCount[votelabel] = classCount.get(votelabel,0) + 1

#%%

classCount

#%%

# 根据operator.itemgetter(1)-第1个值对classCount排序,然后再取倒序

sortedClassCount = sorted(classCount.items(),key=operator.itemgetter(1), reverse=True)

sortedClassCount

#%%

# 获取数量最多的标签

knnclass = sortedClassCount[0][0]

knnclass

3、KNN实现-对燕尾花分类

# 导入算法包以及数据集

import numpy as np

from sklearn import datasets

from sklearn.model_selection import train_test_split

from sklearn.metrics import classification_report,confusion_matrix

import operator

import random

#%%

def knn(x_test, x_data, y_data, k):

# 计算样本数量

x_data_size = x_data.shape[0]

# 复制x_test

np.tile(x_test, (x_data_size,1))

# 计算x_test与每一个样本的差值

diffMat = np.tile(x_test, (x_data_size,1)) - x_data

# 计算差值的平方

sqDiffMat = diffMat**2

# 求和

sqDistances = sqDiffMat.sum(axis=1)

# 开方

distances = sqDistances**0.5

# 从小到大排序

sortedDistances = distances.argsort()

classCount = {}

for i in range(k):

# 获取标签

votelabel = y_data[sortedDistances[i]]

# 统计标签数量

classCount[votelabel] = classCount.get(votelabel,0) + 1

# 根据operator.itemgetter(1)-第1个值对classCount排序,然后再取倒序

sortedClassCount = sorted(classCount.items(),key=operator.itemgetter(1), reverse=True)

# 获取数量最多的标签

return sortedClassCount[0][0]

#%%

# 载入数据

iris = datasets.load_iris()

# x_train,x_test,y_train,y_test = train_test_split(iris.data, iris.target, test_size=0.2) #分割数据0.2为测试数据,0.8为训练数据

#打乱数据

data_size = iris.data.shape[0]

index = [i for i in range(data_size)]

random.shuffle(index)

iris.data = iris.data[index]

iris.target = iris.target[index]

#切分数据集

test_size = 40

x_train = iris.data[test_size:]

x_test = iris.data[:test_size]

y_train = iris.target[test_size:]

y_test = iris.target[:test_size]

predictions = []

for i in range(x_test.shape[0]):

predictions.append(knn(x_test[i], x_train, y_train, 5))

print(classification_report(y_test, predictions))

#%%

print(confusion_matrix(y_test,predictions))

8067

8067

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?