一、DifyAI介绍

DifyAI是一个开源的大语言模型(LLM)应用开发平台,它的核心理念是让AI应用开发变得简单而强大。无论你是资深开发者还是AI新手,都能通过直观的界面快速构建出功能完善的AI应用。

为什么选择DifyAI?

传统AI应用开发的痛点:

-

需要深度理解各种AI模型API

-

复杂的提示词工程和调优

-

难以整合多种AI能力

-

缺乏可视化的开发工具

DifyAI的解决方案:

-

🎨 可视化工作流 - 拖拽式构建AI处理流程

-

🔌 模型无关性 - 支持OpenAI、Anthropic、本地模型等

-

📚 内置RAG能力 - 轻松构建知识库问答系统

-

🛠 丰富的工具集 - 从提示词IDE到性能监控

二、快速体验

第一步:Docker Compose部署

# 克隆项目

git clone https://github.com/langgenius/dify.git

cd dify/docker

# 配置环境

cp .env.example .env

# 一键启动所有服务

docker-compose up -d

# 等待服务启动完成,访问 http://localhost

第二步:账号注册与模型配置

-

访问平台:打开浏览器,访问

http://localhost,初始会自动跳转到install页面 -

注册登录:填写邮箱、账户名和密码完成注册、登录

-

配置模型:

-

-

右上角账户头像进入"设置" → "模型供应商"

-

添加API密钥配置对应模型

-

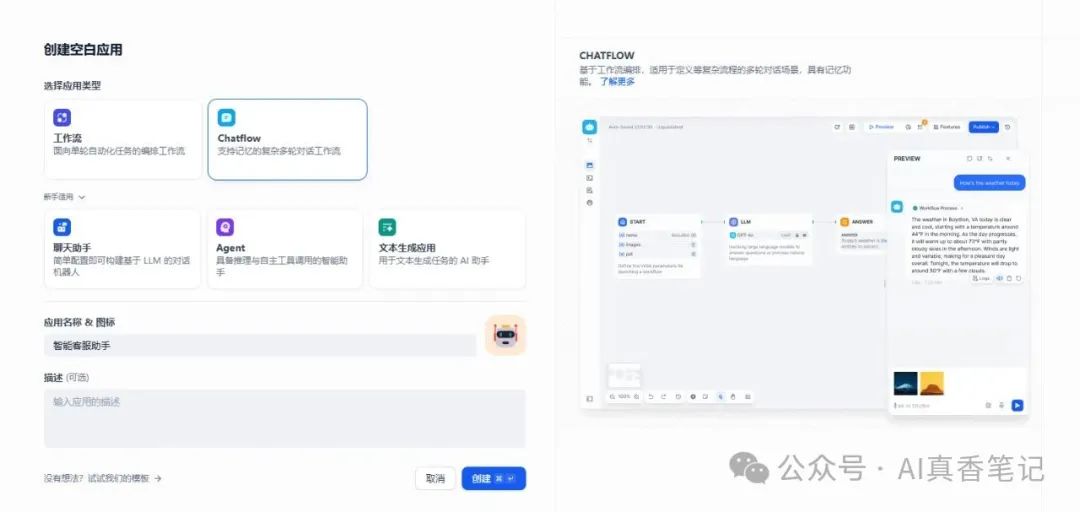

第三步:创建你的第一个AI应用

🤖 智能客服助手

让我们创建一个简单的客服助手:

1. 创建应用

-

点击"创建应用"

-

选择"Chatflow"应用类型

-

输入应用名称:智能客服

2. 选择模型并设计提示词

点击LLM节点进行大模型设置,模型选择接口已启用的模型,系统提示词如下:

你是一个专业的客服助手,具备以下特点:

- 友好、耐心、专业

- 能够理解用户问题并提供准确回答

- 如果不确定答案,会诚实说明并建议用户联系人工客服

请始终保持礼貌和乐于助人的态度。

3. 测试对话

-

在右侧预览区域输入:"你好,我想了解你们的服务"

-

观察AI助手的回复效果

📚 知识库问答

前面创建了一个简单的对话流程应用,实际业务中智能客服一定是需要基于企业内部知识进行参考回答的。现在我们优化上述应用,先创建知识库然后在应用中使用知识库:

1. 创建知识库

-

进入"知识库"页面

-

点击"创建知识库"

-

上传PDF、Word或文本文件等

2. 添加知识库节点

-

在智能客服助手应用中新增知识检索节点

-

调整LLM节点配置,修改系统提示词配置

-

测试预览效果

三、核心功能一览

工作流引擎

通过可视化界面构建复杂的AI处理流程:

-

LLM节点:大语言模型调用

-

知识检索节点:RAG检索

-

条件判断节点:流程控制

-

工具调用节点:外部API集成

插件式配置

-

工具插件开发

-

模型插件开发

-

Agent策略插件开发

-

扩展插件开发

RAG检索增强支持

DifyAI内置强大的RAG(Retrieval-Augmented Generation)能力:

-

多格式文档支持:PDF、Word、TXT、Markdown等

-

智能文档解析:自动提取文本、保留结构信息

-

向量化存储:支持多种向量数据库(Pinecone、Qdrant、Weaviate等)

-

语义检索:基于向量相似度的智能检索

-

混合检索:结合关键词和语义检索,提升准确率

-

重排序优化:对检索结果进行相关性重新排序

-

上下文管理:智能控制上下文长度,避免token溢出

多模型支持

DifyAI支持市面上主流的AI模型:

|

Provider |

LLM |

Text Embedding |

Rerank |

Speech to text |

TTS |

|---|---|---|---|---|---|

|

OpenAI |

✔️(🛠️)(👓) |

✔️ |

✔️ |

✔️ | |

|

Anthropic |

✔️(🛠️) | ||||

|

Azure OpenAI |

✔️(🛠️)(👓) |

✔️ |

✔️ |

✔️ | |

|

Gemini |

✔️ | ||||

|

Google Cloud |

✔️(👓) |

✔️ | |||

|

Nvidia API Catalog |

✔️ |

✔️ |

✔️ | ||

|

Nvidia NIM |

✔️ | ||||

|

Nvidia Triton Inference Server |

✔️ | ||||

|

AWS Bedrock |

✔️ |

✔️ | |||

|

OpenRouter |

✔️ | ||||

|

Cohere |

✔️ |

✔️ |

✔️ | ||

|

together.ai |

✔️ | ||||

|

Ollama |

✔️ |

✔️ | |||

|

Mistral AI |

✔️ | ||||

|

groqcloud |

✔️ | ||||

|

Replicate |

✔️ |

✔️ | |||

|

Hugging Face |

✔️ |

✔️ | |||

|

Xorbits inference |

✔️ |

✔️ |

✔️ |

✔️ |

✔️ |

|

智谱 |

✔️(🛠️)(👓) |

✔️ | |||

|

百川 |

✔️ |

✔️ | |||

|

讯飞星火 |

✔️ | ||||

|

Minimax |

✔️(🛠️) |

✔️ | |||

|

通义千问 |

✔️ |

✔️ |

✔️ | ||

|

文心一言 |

✔️ |

✔️ | |||

|

月之暗面 |

✔️(🛠️) | ||||

|

Tencent Cloud |

✔️ | ||||

|

阶跃星辰 |

✔️ | ||||

|

火山引擎 |

✔️ |

✔️ | |||

|

零一万物 |

✔️ | ||||

|

360 智脑 |

✔️ | ||||

|

Azure AI Studio |

✔️ |

✔️ | |||

|

deepseek |

✔️(🛠️) | ||||

|

腾讯混元 |

✔️ | ||||

|

SILICONFLOW |

✔️ |

✔️ | |||

|

Jina AI |

✔️ |

✔️ | |||

|

ChatGLM |

✔️ | ||||

|

Xinference |

✔️(🛠️)(👓) |

✔️ |

✔️ | ||

|

OpenLLM |

✔️ |

✔️ | |||

|

LocalAI |

✔️ |

✔️ |

✔️ |

✔️ | |

|

OpenAI API-Compatible |

✔️ |

✔️ |

✔️ | ||

|

PerfXCloud |

✔️ |

✔️ | |||

|

Lepton AI |

✔️ | ||||

|

novita.ai |

✔️ | ||||

|

Amazon Sagemaker |

✔️ |

✔️ |

✔️ | ||

|

Text Embedding Inference |

✔️ |

✔️ | |||

|

GPUStack |

✔️(🔧️)(👓) |

✔️ |

✔️ |

✔️ |

✔️ |

四、技术架构简介

DifyAI核心技术栈:

前端: Next.js + TypeScript + Tailwind CSS

后端: Python + Flask + SQLAlchemy + Celery

数据库: PostgreSQL + Redis + 向量数据库

部署: Docker + Docker Compose

架构优势:

-

🏗 微服务设计:各组件职责清晰,易于扩展

-

🔄 异步处理:长时间任务不阻塞用户界面

-

📊 多数据源:支持关系型、缓存、向量等多种存储

-

🐳 容器化部署:环境一致性,便于运维

五、应用场景

1. 智能客服系统

-

功能:24/7在线答疑、问题分类、人工转接

-

技术实现:RAG + 工作流 + 外部API集成

-

效果:响应速度提升80%,人工客服工作量减少60%

2. 文档智能助手

-

功能:文档问答、内容摘要、信息提取

-

技术实现:向量检索 + 文档解析 + 重排序

-

效果:文档查找效率提升5倍,信息准确率95%+

3. 编程助手

-

功能:代码生成、bug分析、技术问答

-

技术实现:代码专用模型 + 上下文理解

-

效果:开发效率提升30%,代码质量显著改善

平台集成能力很强,有技术团队的企业可以深入实现非常多的内部业务。

结语

DifyAI平台降低了AI应用开发的门槛,让更多开发者能够快速构建智能应用。不管是C端客户还是B端客户,DifyAI都是一个值得尝试的平台(想商业化的务必关注其开源协议)。 在下篇文章中,我们将继续探讨DifyAI的架构设计,敬请期待!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?